NCCL后端

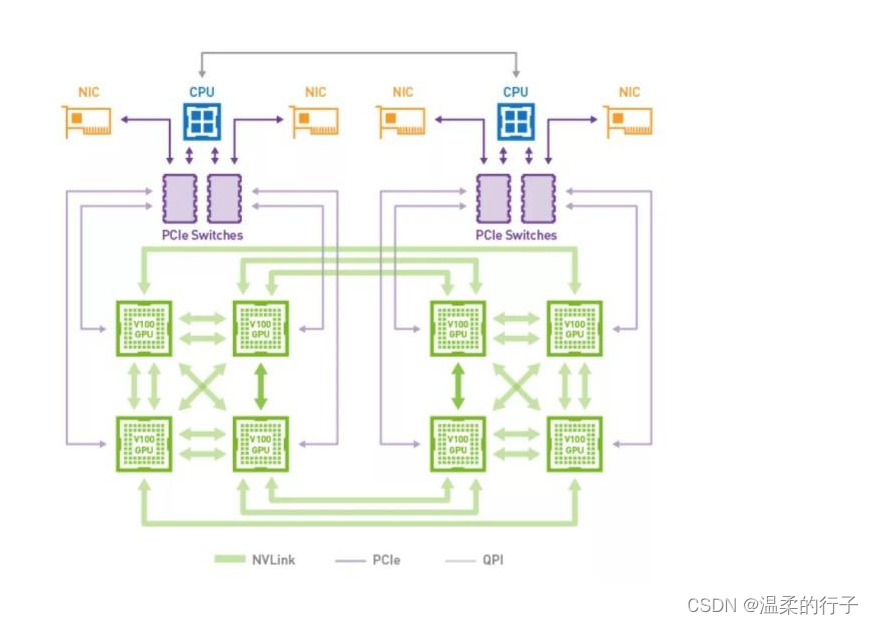

"NCCL" 代表 "NVIDIA Collective Communications Library","NVIDIA 集体通信库",它是一种由 NVIDIA 开发的用于高性能计算的通信库。NCCL 专门设计用于加速 GPU 群集之间的通信,以便在并行计算和深度学习等领域中提供更好的性能。

NCCL 主要用于以下方面:

-

分布式深度学习:在分布式深度学习训练中,多个 GPU 或多台机器上的 GPU 需要相互通信以协同进行模型训练。NCCL 提供了高效的通信机制,使得在这些环境中进行模型参数的梯度更新变得更加高效。

-

高性能计算:NCCL 也在高性能计算中有广泛的应用,特别是在需要在 GPU 集群上执行大规模并行计算任务时。

-

科学计算:科学计算领域也经常使用 NCCL 来加速计算任务,特别是需要在多个 GPU 之间共享数据和协同计算的任务。

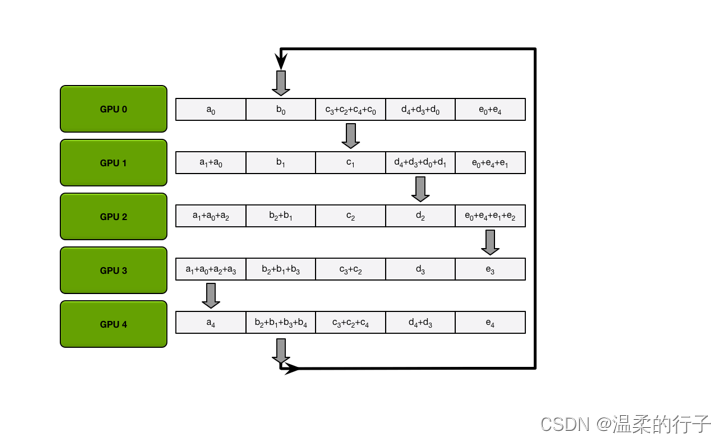

NCCL 提供了一组高效的通信原语,包括点对点通信、归约操作、广播操作等,以便在 GPU 集群上实现高性能的并行计算。它通常与 NVIDIA GPU 和 GPU 加速的计算框架(如 TensorFlow、PyTorch 等)一起使用,以加速分布式计算任务。

在深度学习框架中,可以选择使用 NCCL 作为后端以优化多 GPU 训练过程,以提高训练速度和效率。例如,可以在 PyTorch 中设置 NCCL 为后端,以充分利用 NVIDIA GPU 群集中的计算资源