linux版:TensorRT安装教程

首先安装cuda和cudnn

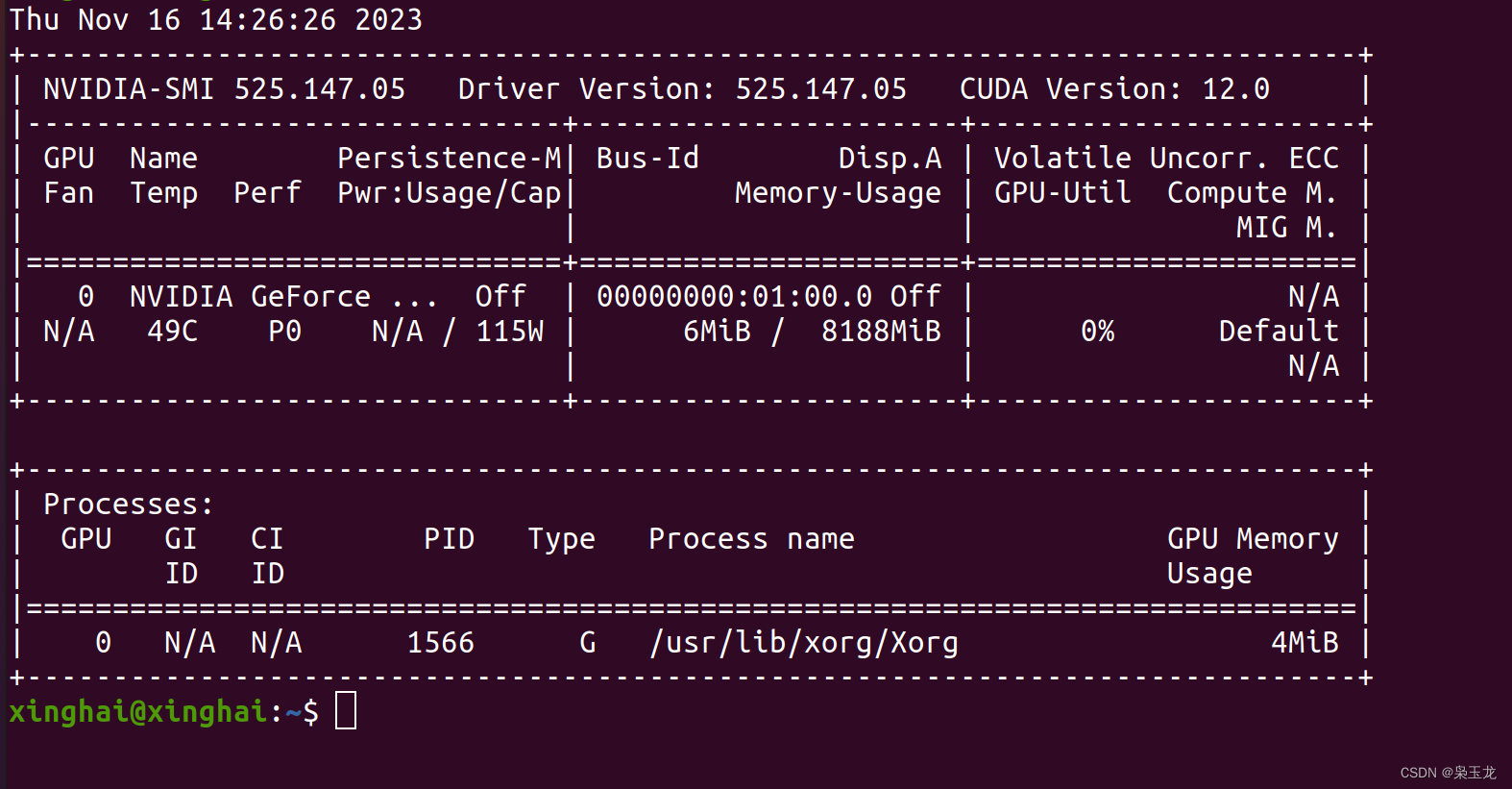

查看安装的cuda版本

nvidia-smi

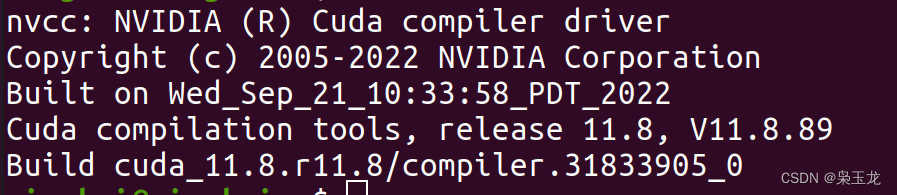

查看cuda电脑的版本,我的是11.8版本的

nvcc -V

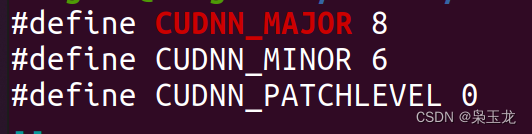

查看cudnn版本,在cuda/cuda118/include路径下

cat cudnn_version.h | grep CUDNN_MAJOR -A 2

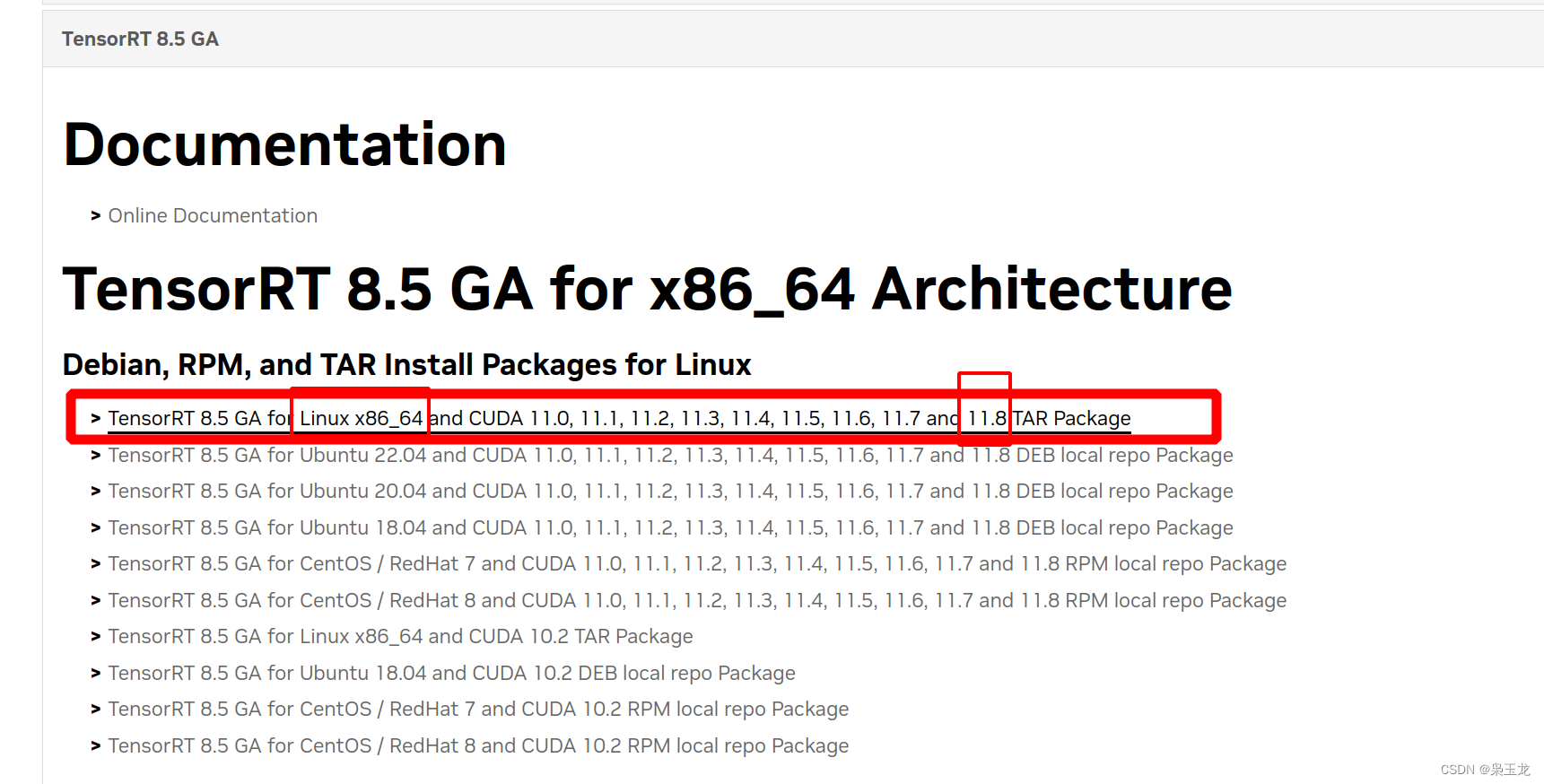

下载TensorRT8.5 GA

下载地址:https://developer.nvidia.com/nvidia-tensorrt-8x-download

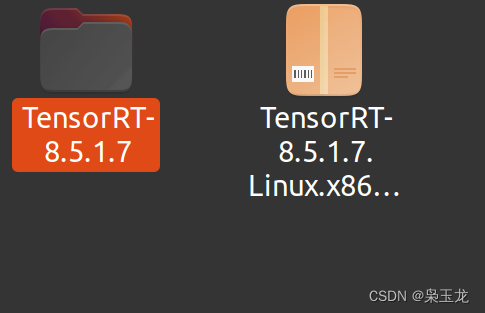

进行解压

配置环境变量

# 配置环境变量

sudo gedit ~/.bashrc #复制到最后面

export PATH=$PATH:/TensorRT/TensorRT-8.5.1.7/bin

export LD_LIBRARY_PATH=/TensorRT/TensorRT-8.5.1.7/lib:$LD_LIBRARY_PATH

# 保存后刷新环境变量

source ~/.bashrc

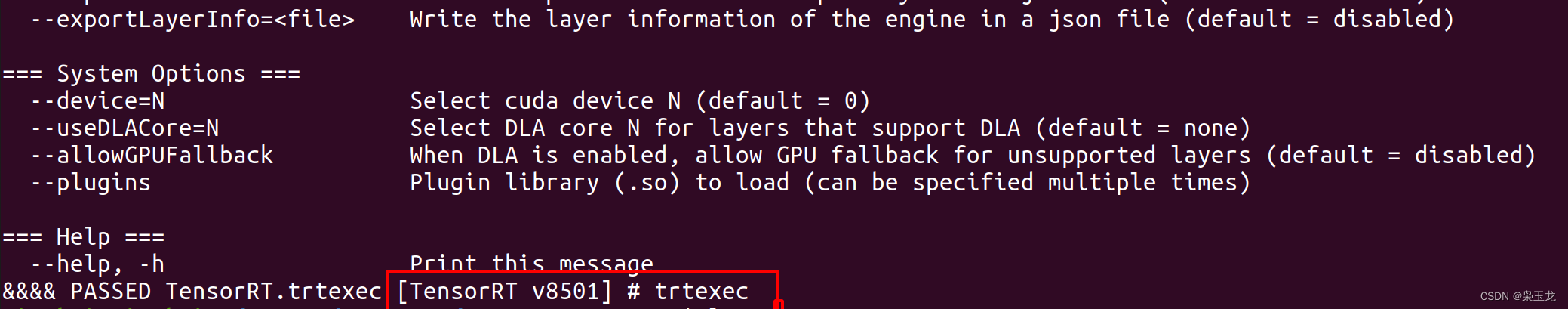

查看是否配置成功,我配置的是8.5.1版本

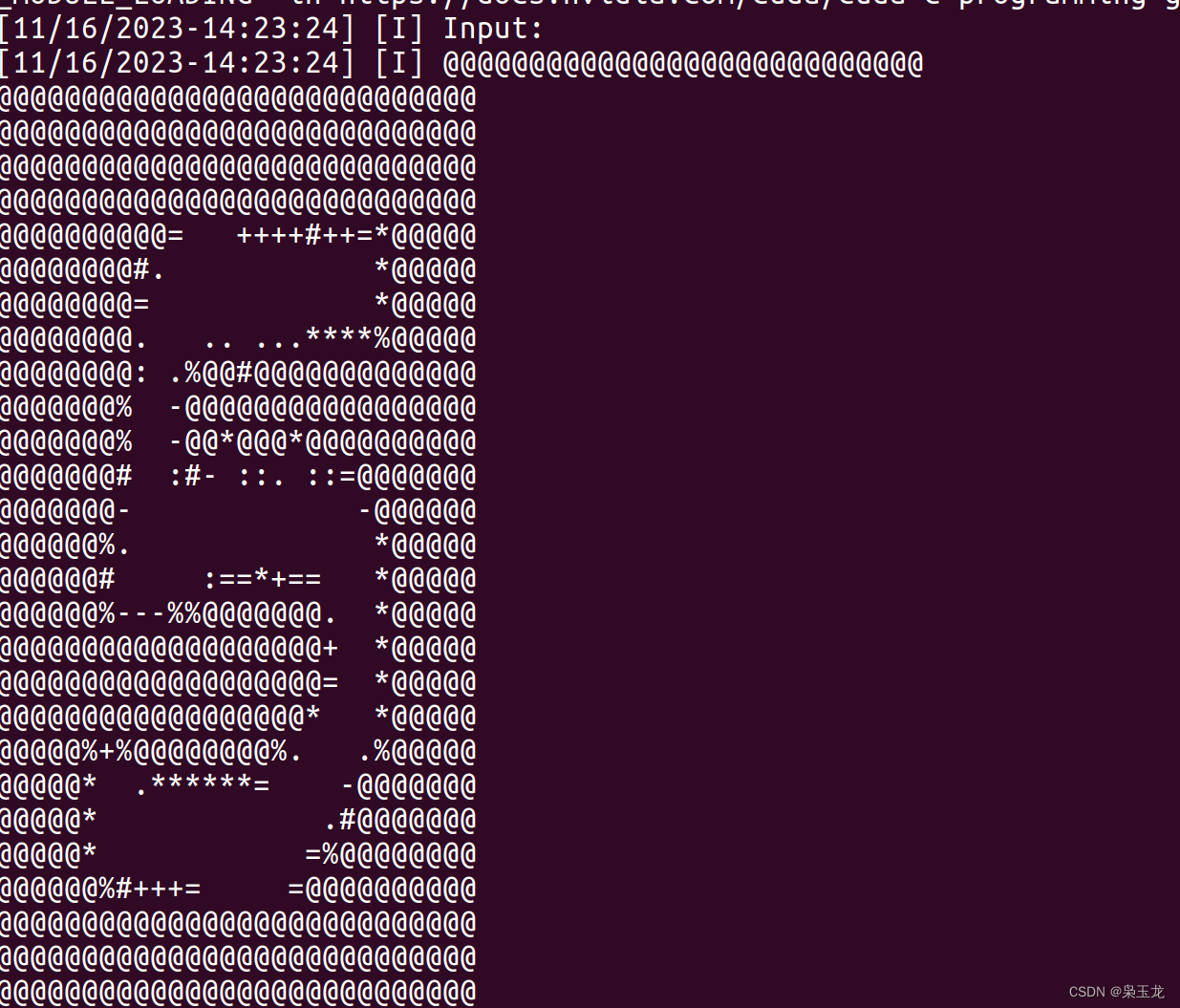

trtexec

进行编译

进入这个文件目录下

cd samples/sampleOnnxMNIST

进行编译命令

sudo make -j16

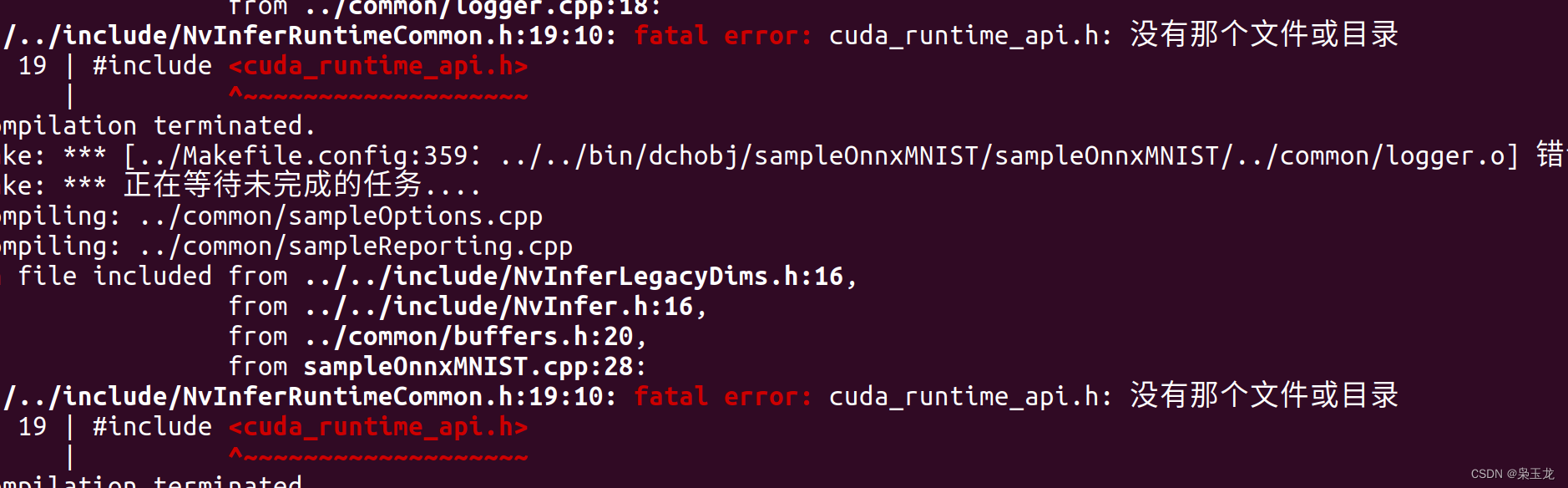

报错:NvInferRuntimeCommon.h:19:10: fatal error: cuda_runtime_api.h: 没有那个文件或目录等

查看有没有cuda的链接,没有看到cuda的链接就是没有配置cuda软连接

cd /usr/local/

ls -l

配置软连接

sudo ln -s /cuda/cuda118 /usr/local/cuda

在进行编译

cd TensorRT/TensorRT-8.5.1.7/samples/sampleOnnxMNIST

sudo make -j16

查看是否成功

cd TensorRT/TensorRT-8.5.1.7/bin

sample_onnx_mnist