一、环境搭建

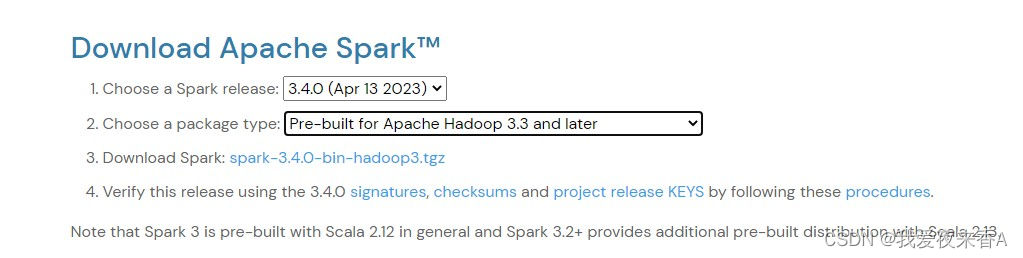

1、spark安装包,官网地址,我下的是如下版本

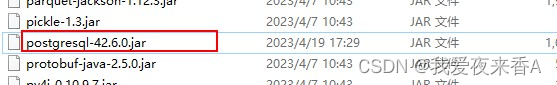

2、postgreSql数据库jdbc驱动,官网地址,我下的是如下版本

3、java版本1.8;scala版本2.12.15

4、spark安装包解压到任意目录,把postgreSql的jdbc驱动jar包放在spark的jars目录下

5、创建maven项目,把maven项目的Modules的Dependencies指定的到spark解压后的jars目录

6、此时你的External Libraries应该多了很多jar包,如下所示,如果没有,就是有问题了