免费部署开源大模型

参考:【大模型-第一篇】在阿里云上部署ChatGLM3-CSDN博客

1、在阿里云上申请注册及登录并完成认证

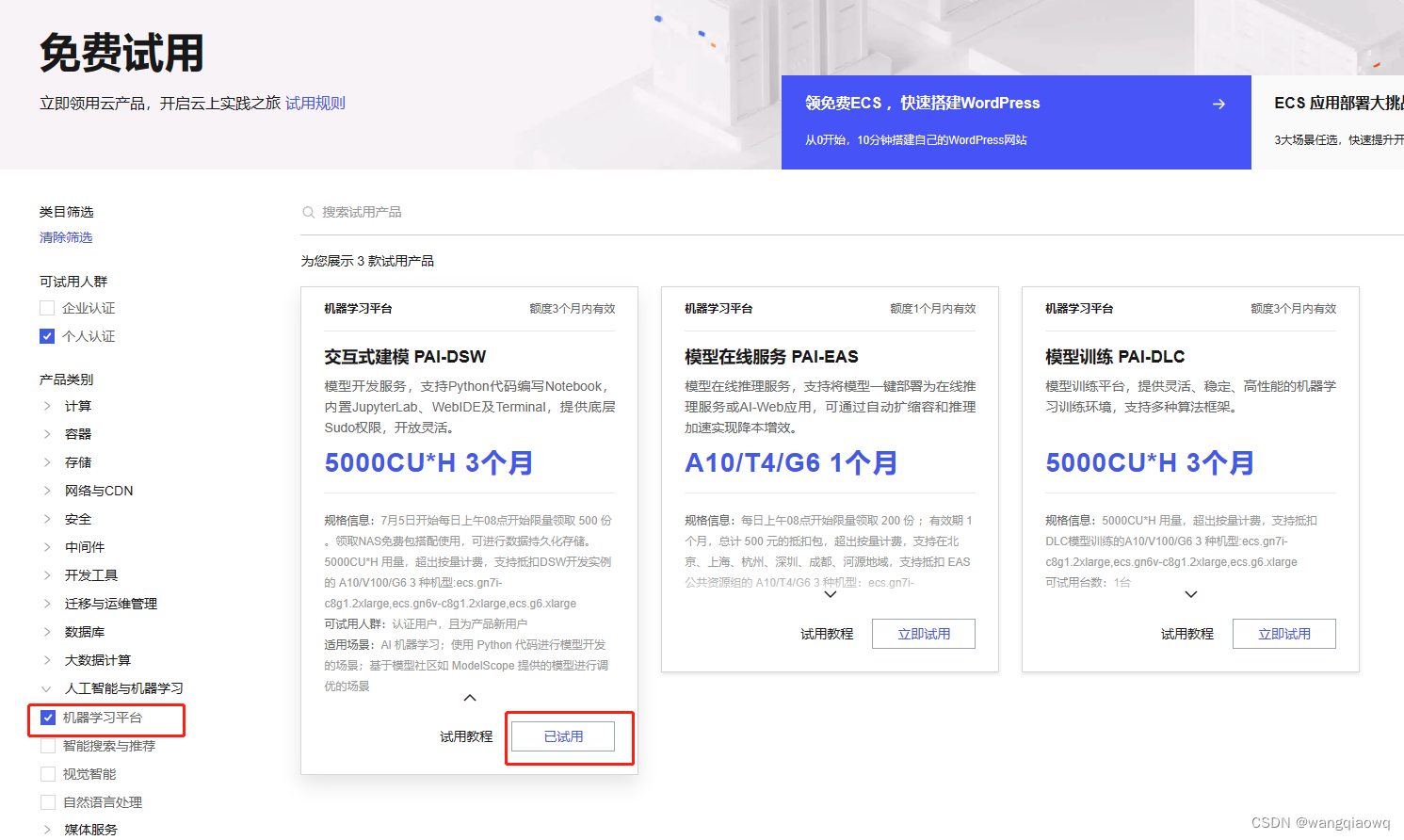

2、登录阿里云 免费试用 页面 https://free.aliyun.com/?product=1395&crowd=personal

3、 选择试用产品:

选择 立即试用

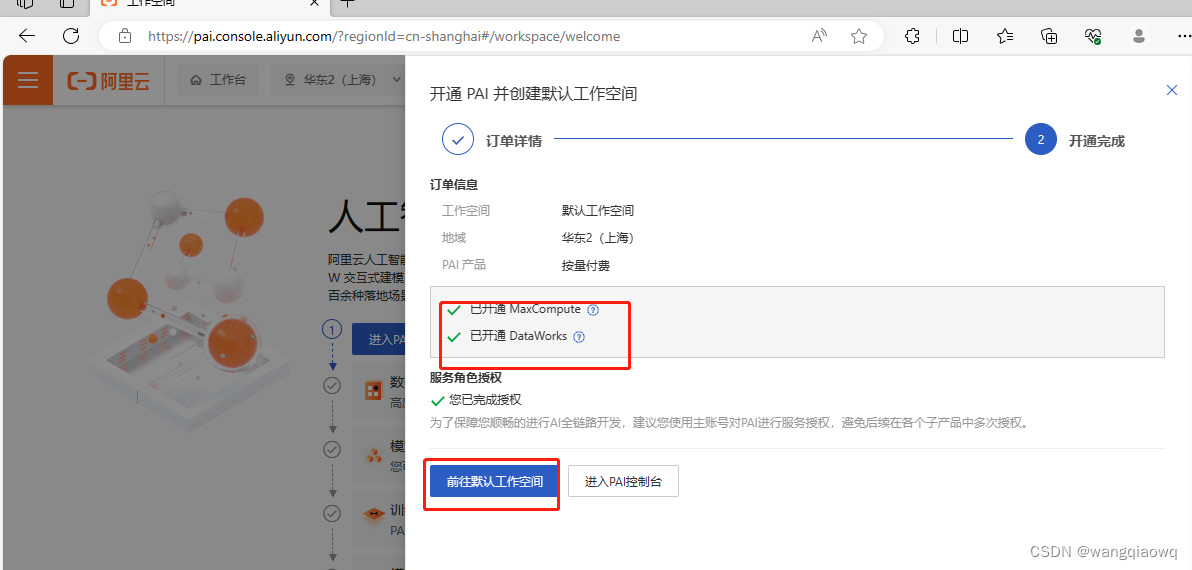

进入工作空间 宣交互式建模(DSW)

输入实例名称,就叫它 550W 吧~,GPU 选择 A10 或者 V100 都行,这俩是支持资源包抵扣的,其他的不支持,这里注意!V100 性能更好,但我们测试使用没必要,就选 A10 就行,A10 显卡每小时消耗6.991计算时,如果不关机持续使用大概可以使用30天。

我打开的时候只有V100 了 支持资源包抵扣

没选数据集 进入选择镜像

选择创建实例 点击下一步 耐心等待实例创建。

二、部署GLM3

部署GLM3,包括其它类似的开源大模型,步骤都是差不多的,毕竟这些高校/大厂都帮大家封装好了,所以并没有特别繁琐的步骤。

在我看来,主要就是三步:1、环境搭建;2、git下载GLM3(如果要本地化部署,还要下载模型);3、修改路径并启用

1、环境搭建

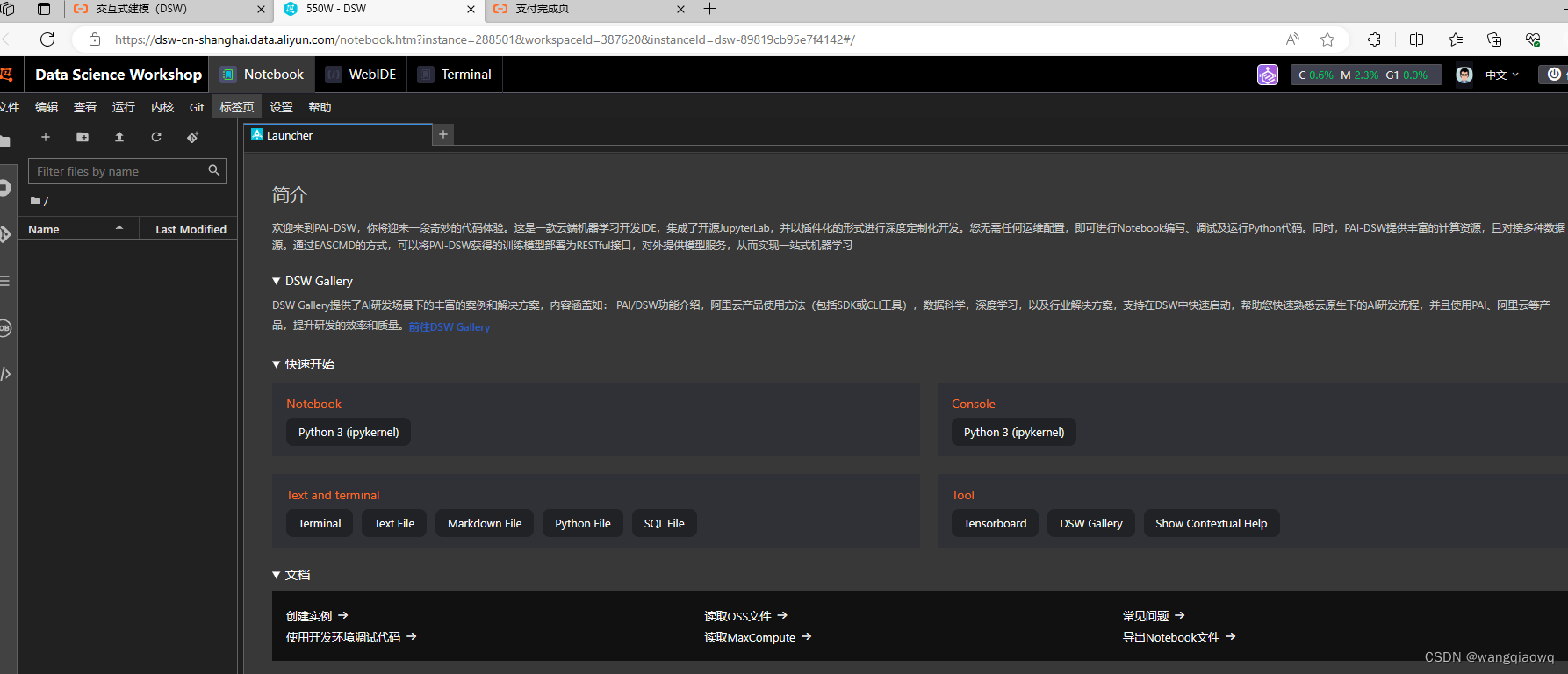

因为使用的是阿里云的PAI,默认已经帮我们配置好了环境变量、网络,装好了python甚至pytorch、tensorflow等等,点击打开后进入

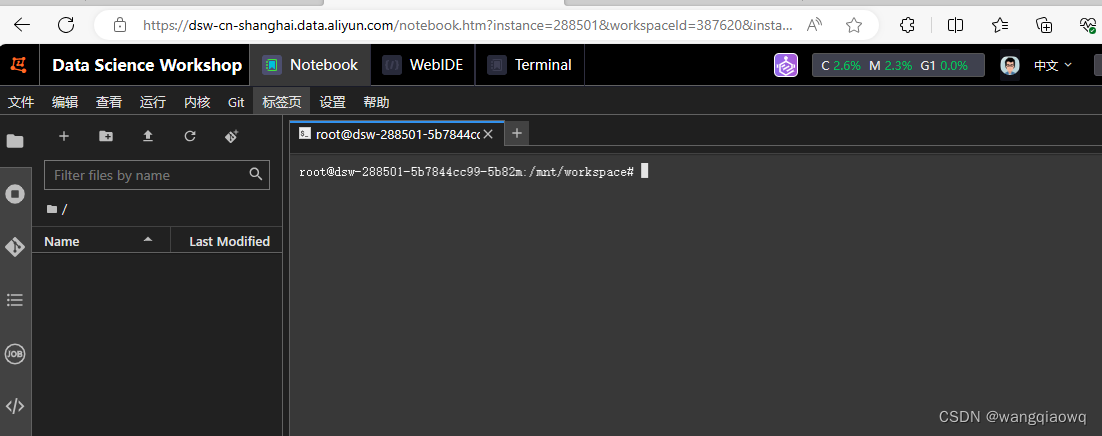

点击 terminal进入:

2、git下载GLM3

2.1 git clone下载GLM3仓库

2.1.1首先git clone下载GLM3仓库,并切换到这个文件夹下

git clone https://github.com/THUDM/ChatGLM3

- Transformers是一个自然语言处理(NLP)模型,由Google提出并广泛应用于各种NLP任务中,如机器翻译、文本分类、问答系统等。Transformers模型采用了一种称为“自注意力机制”(self-attention mechanism)的技术,可以有效地处理长序列的输入数据,并且并行计算能力强,因此在大规模数据集上训练效果优异。

- TransFlow则是一种基于流(flow)的编程模型和执行引擎,旨在简化分布式数据流应用程序的开发和部署。TransFlow通过将数据流编程模型和流处理引擎相结合,提供了一种高效、灵活和易用的方式来处理大规模数据流。

2.1.2 然后使用 pip 安装依赖:

v