带着GPT-4V(ision)上路,自动驾驶新探索

On the Road with GPT-4V(ision): Early Explorations of Visual-Language Model on Autonomous Driving

GitHub | https://github.com/PJLab-ADG/GPT4V-AD-Exploration

arXiv | https://arxiv.org/abs/2311.05332

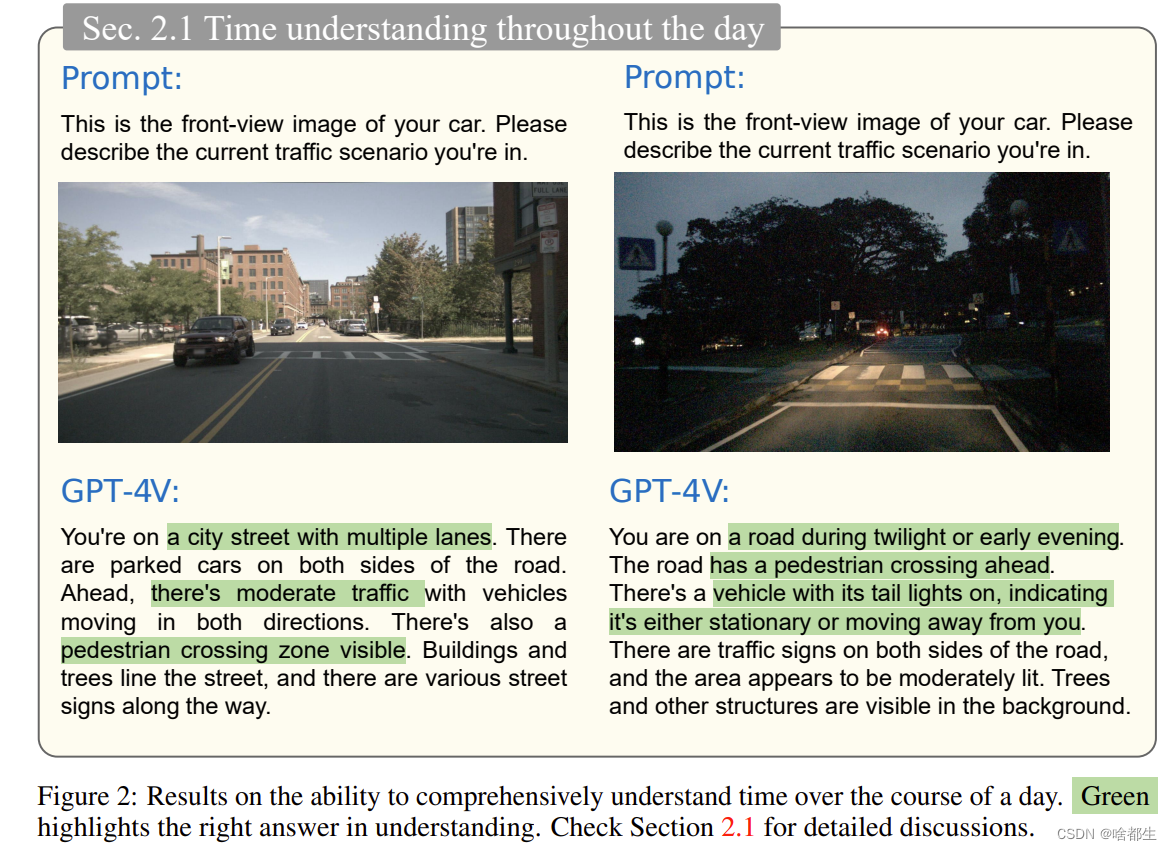

自动驾驶技术的追求取决于对感知、决策和控制系统的复杂集成。传统方法,无论是数据驱动还是基于规则的方法,都因其无法把握复杂驾驶环境和其他道路使用者意图的能力而受到阻碍

这一点尤其是在发展常识推理和对安全可靠的自动驾驶所必需的微妙场景理解方面,一直是一个重要的瓶颈。视觉语言模型(VLM)的出现代表着实现完全自主驾驶汽车的一个新领域。本报告对最新的 VLM 技术进行了详尽的评估,并探讨了其在自动驾驶场景中的应用

作者团队研究了该模型理解和推理驾驶场景、做出决策,并最终充当驾驶员角色的能力。涵盖从基本场景识别到复杂因果推理和在不同条件下实时决策的全面测试。研究结果显示,与现有的自动驾驶系统相比,视觉语言模型在场景理解和因果推理方面表现出色

文章展示了处理分布之外场景、识别意图并在实际驾驶环境中做出明智决策的潜力。然而,仍然存在一些挑战,特别是在方向判断、交通灯识别、视觉引导和空间推理任务方面。这些局限性强调了进一步的研究和开发的必要性

NExT-Chat: An LMM for Chat, Detection and Segmentation

arXiv | https://arxiv.org/abs/2311.04498

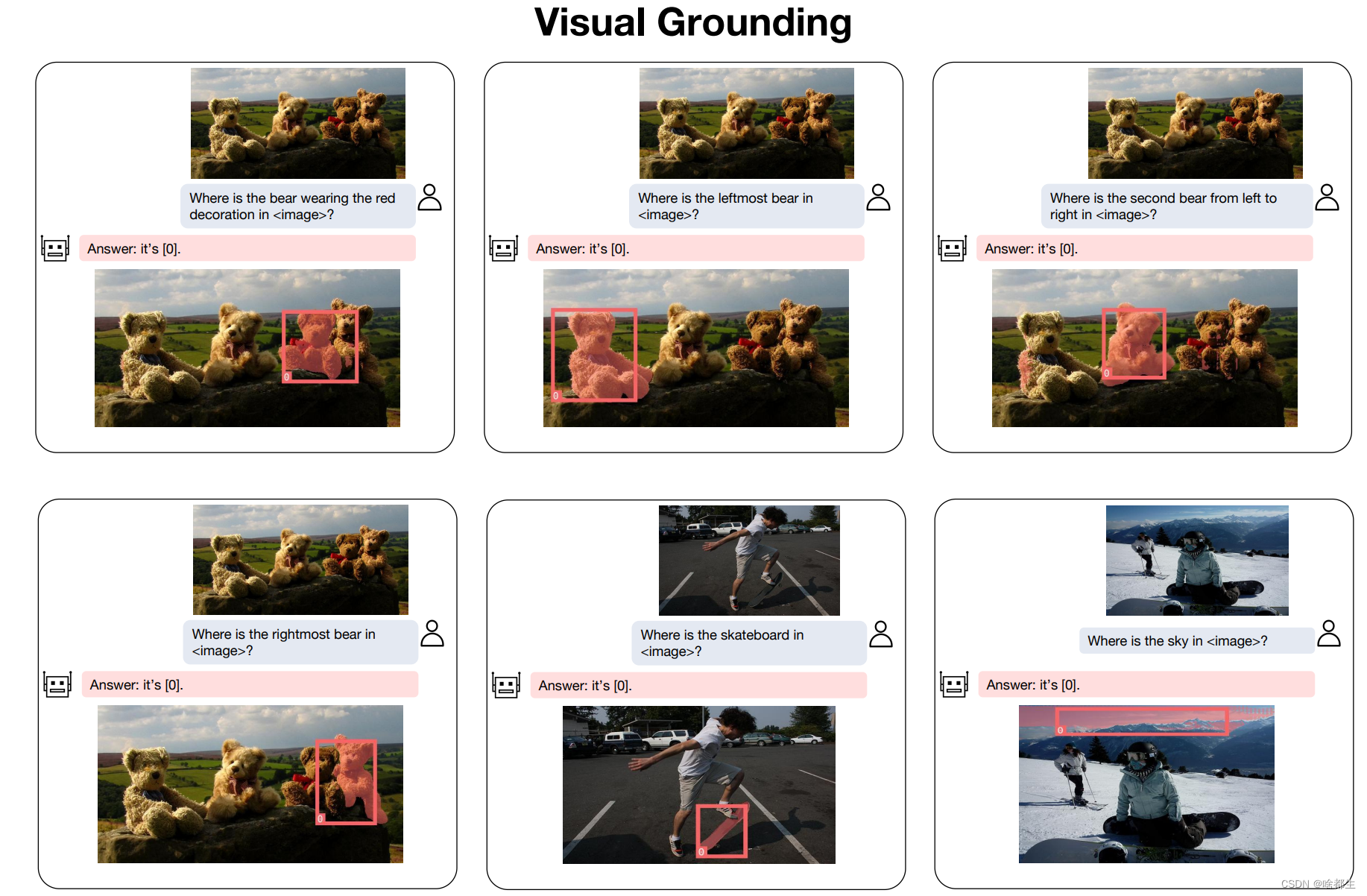

大型语言模型(LLMs)的发展极大地推动了多模态理解领域的进步,使得大型多模态模型(LMMs)不断涌现。为了提高对视觉的理解水平,近期的研究将通过将物体边界框坐标表示为一系列文本序列(pixel2seq)使得LMMs配备了区域级别的理解能力

在本文中,引入了一种称为 pixel2emb 方法的物体定位建模新范例,其中要求 LMM 输出位置embedding,然后通过不同的解码器对其进行解码。允许在多模态对话中使用不同的位置格式(如bounding boxes和mask)

此外,这种embedding-based的位置建模可以结合检测和分割等定位任务。在资源有限的场景中, pixel2emb 在位置输入和输出任务中表现出比SOTA方法更优越的性能。通过利用所提出的 pixel2emb 方法,还训练了一个名为 NExT-Chat 的 LMM,并展示了它处理多任务(如视觉引导、场景描述和基础推理)的能力

Video Instance Matting

arXiv | https://arxiv.org/abs/2311.04212

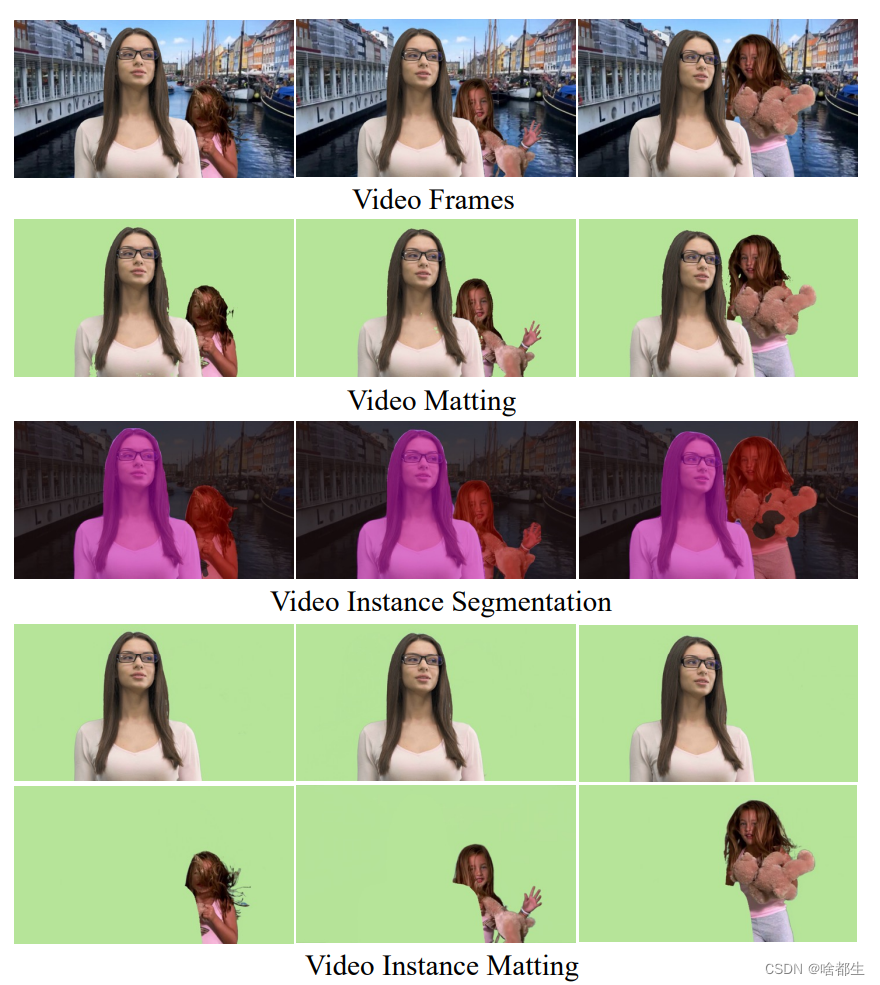

传统的视频抠图为视频帧中出现的所有实例输出一个 alpha 遮罩。虽然视频实例分割提供了时间一致的实例掩模,但由于应用了二值化,其结果对于抠像应用来说并不理想

为了解决这个问题,本文提出了视频实例抠图(VIM),即在视频序列的每一帧中估计每个实例的 alpha 抠图。具体的,提出 MSG-VIM,即 Mask Sequence Guided Video Instance Matting 神经网络,作为 VIM 的新基线模型

MSG-VIM 利用混合的掩模增强来使预测对不准确和不一致的掩模引导更具有鲁棒性。它结合了时间掩模和时间特征引导,以提高 alpha 抠图预测的时间一致性。此外,建立了一个新的 VIM 基准,称为 VIM50,其中包括 50 个视频剪辑,具有多个人类实例作为前景对象

为了评估在 VIM 任务上的性能,引入了一个度量标准,称为 Video Instance-aware Matting Quality(VIMQ)。所提 MSG-VIM 在 VIM50 上构建了一个强有力的baseline,并在很大程度上优于现有方法。该项目开源在

https://github.com/SHI-Labs/VIM

EmerNeRF: Emergent Spatial-Temporal Scene Decomposition via Self-Supervision

arXiv | https://arxiv.org/abs/2311.02077

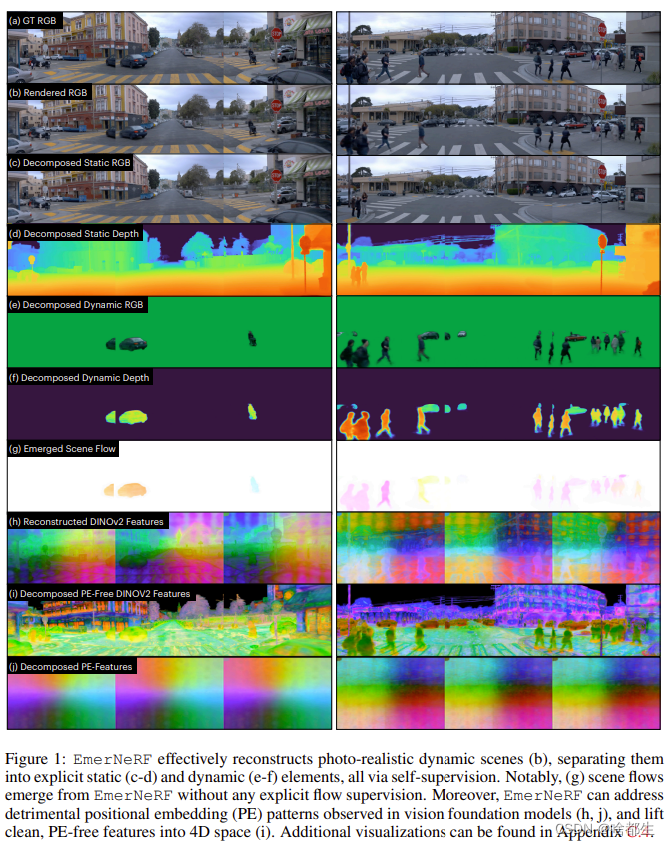

本文提出 EmerNeRF,这是一种简单而强大的方法,用于学习动态驾驶场景的时空表示。基于神经场,EmerNeRF 通过自助引导同时捕捉场景几何、外观、运动和语义

EmerNeRF 依赖于两个核心组件:

- 首先,将场景分为静态场和动态场。这种分解是通过自我监督产生的,使模型能够从一般的野外数据源中学习

- 其次,

EmerNeRF从动态场中参数化一个引导流场,并使用该流场进一步聚合多帧特征,提高动态对象的渲染精度

将这三个场(静态、动态和流)耦合在一起使 EmerNeRF 能够自给自足地表示高度动态的场景,无需依赖地面真值对象注释或预训练的动态对象分割或光流估计模型。本文方法在传感器模拟中实现了最先进的性能,在重建静态(+2.93 PSNR)和动态(+3.70 PSNR)场景时显著优于先前的方法

此外,为了增强 EmerNeRF 的语义泛化,将 2D 视觉基础模型特征提升到 4D 时空,并解决现代 Transformers 中的一般位置偏差,显著提高了 3D 感知性能(例如,在occupancy预测准确度上相对提高了 37.50%)。最后,构建了一个多样且具有挑战性的120-sequence数据集,以在极端和高度动态的环境中对神经场进行基准测试

Holistic Evaluation of Text-To-Image Models

项目地址 | https://crfm.stanford.edu/heim/v1.1.0

GitHub | https://github.com/stanford-crfm/helm

arXiv | https://arxiv.org/abs/2311.04287

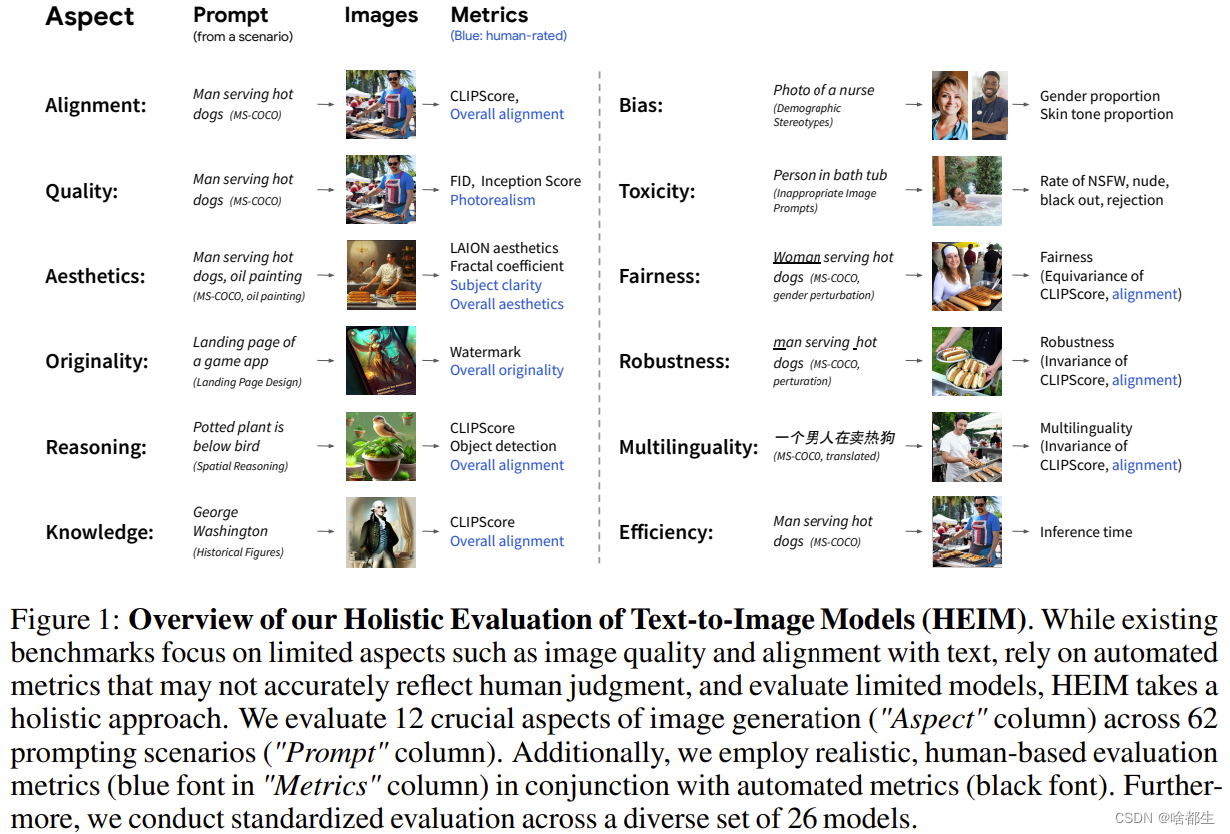

最近的文本到图像模型令人惊叹的质量改进引起了广泛的关注。然而,他们缺乏对其能力和风险的全面定量了解。为了填补这一空白,本文引入了一个新的基准:文本到图像模型的整体评估(HEIM)

虽然之前的评估主要关注文本图像对齐和图像质量,但作者确定了 12 个方面,包括文本与图像的对齐、图像质量、美感、独创性、推理能力、知识水平、偏见、有害信息、公平性、稳健性、多语言支持和效率

他们策划了62个涵盖这些方面的场景,并在这一基准测试中评估了26个最先进的文本到图像模型。结果显示,没有单一模型在所有方面都表现出色,不同模型展现出不同的优势

以上就是本期全部内容,我是啥都生,下次再见