Transformer的前世今生 day03(Word2Vec

前情回顾

- 由上一节,我们可以得到:

- 任何一个独热编码的词都可以通过Q矩阵得到一个词向量,而词向量有两个优点:

- 可以改变输入的维度(原来是很大的独热编码,但是我们经过一个Q矩阵后,维度就可以控制了)

- 相似词之间的词向量有了关系

- 任何一个独热编码的词都可以通过Q矩阵得到一个词向量,而词向量有两个优点:

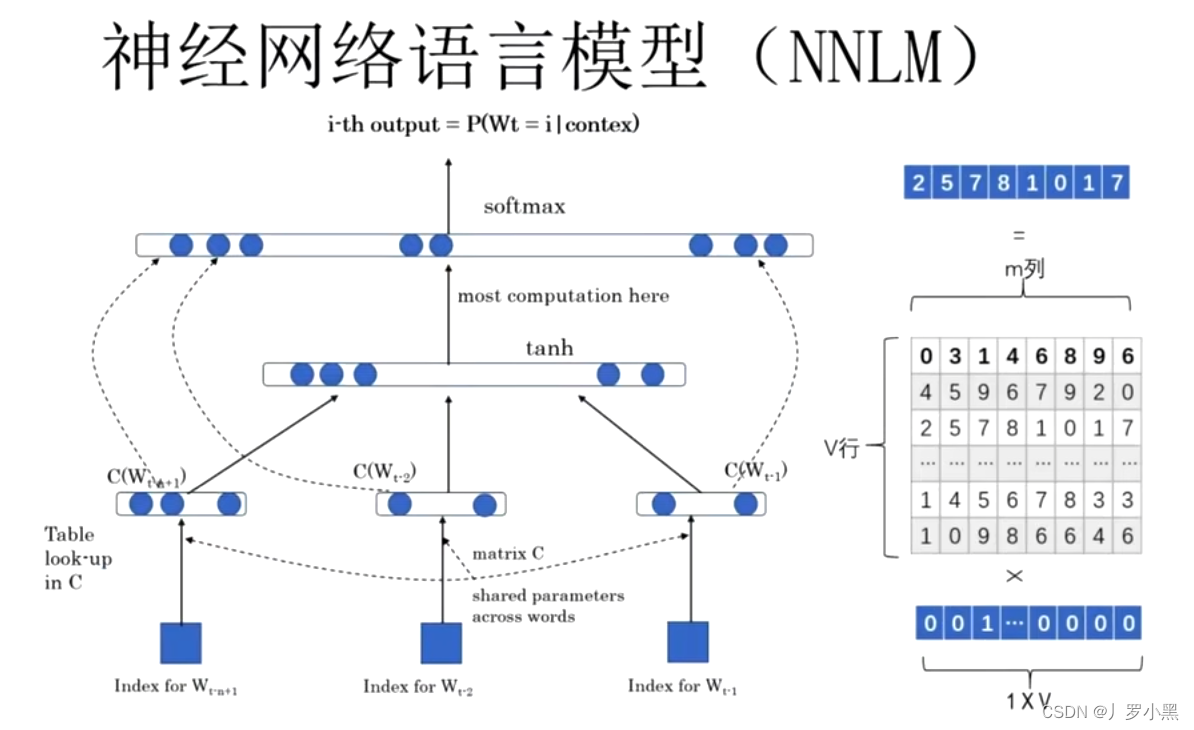

- 但是,在NNLM(神经网络语言模型的一种)中,词向量是一个副产品,即主要目的并不是生成词向量,而是去预测下一个词是什么,所以它对预测的精度要求很高,模型就会很复杂,也就不容易去计算Q矩阵和词向量

- 模型图如下:

- 因此提出了一个专门生成词向量的神经网络语言模型----Word2Vec

Word2Vec

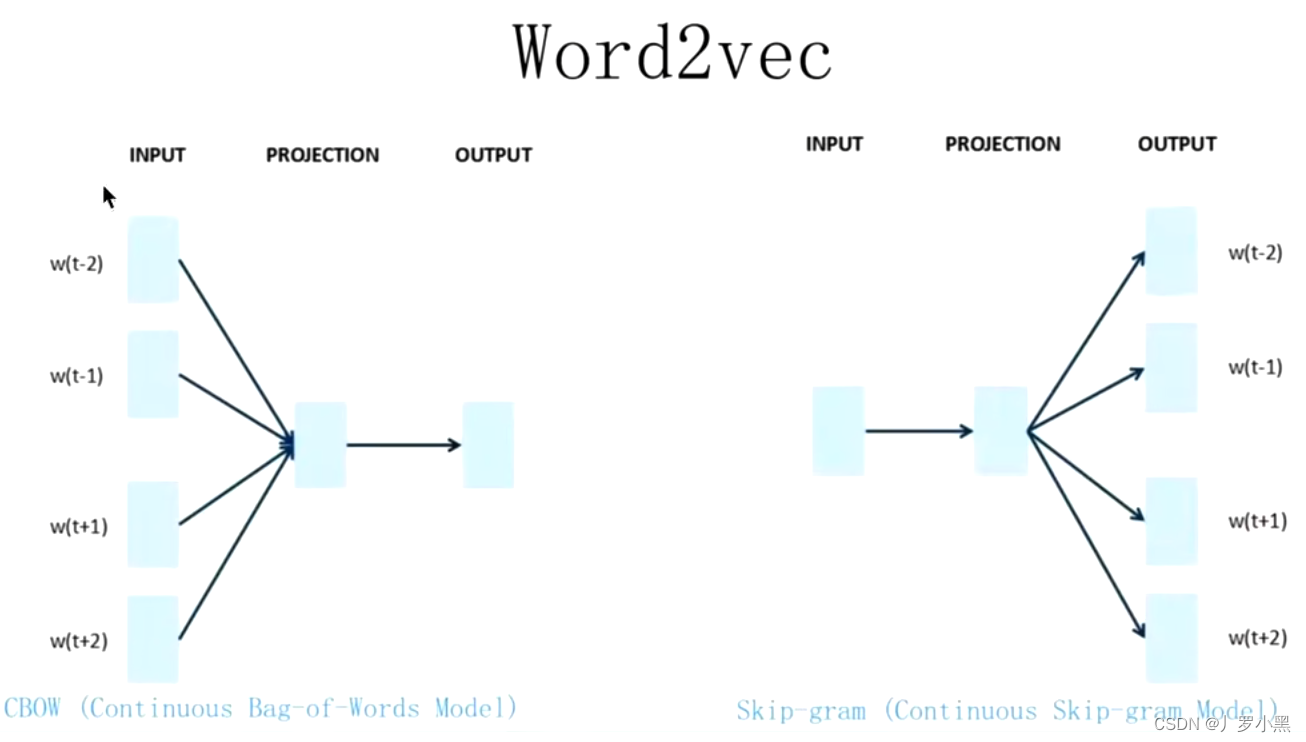

- 主要目的是生成词向量,模型图如下:

- 虽然NNLM和Word2Vec基本一致,不考虑细节,网络架构基本一致

- 但是由于Word2Vec的主要目的是生成词向量,那么对预测精度的要求可以放低,甚至只要合理,就算有多个结果也可以,因此模型不会很复杂,也就是可以更容易的计算出Q矩阵和词向量

- 所以对比NNLM,Word2Vec不用预测更准确,只需要可以正常的进行一个反向传播,可以去掉激活函数,加快计算速度,如下:

- Word2Vec的缺点:

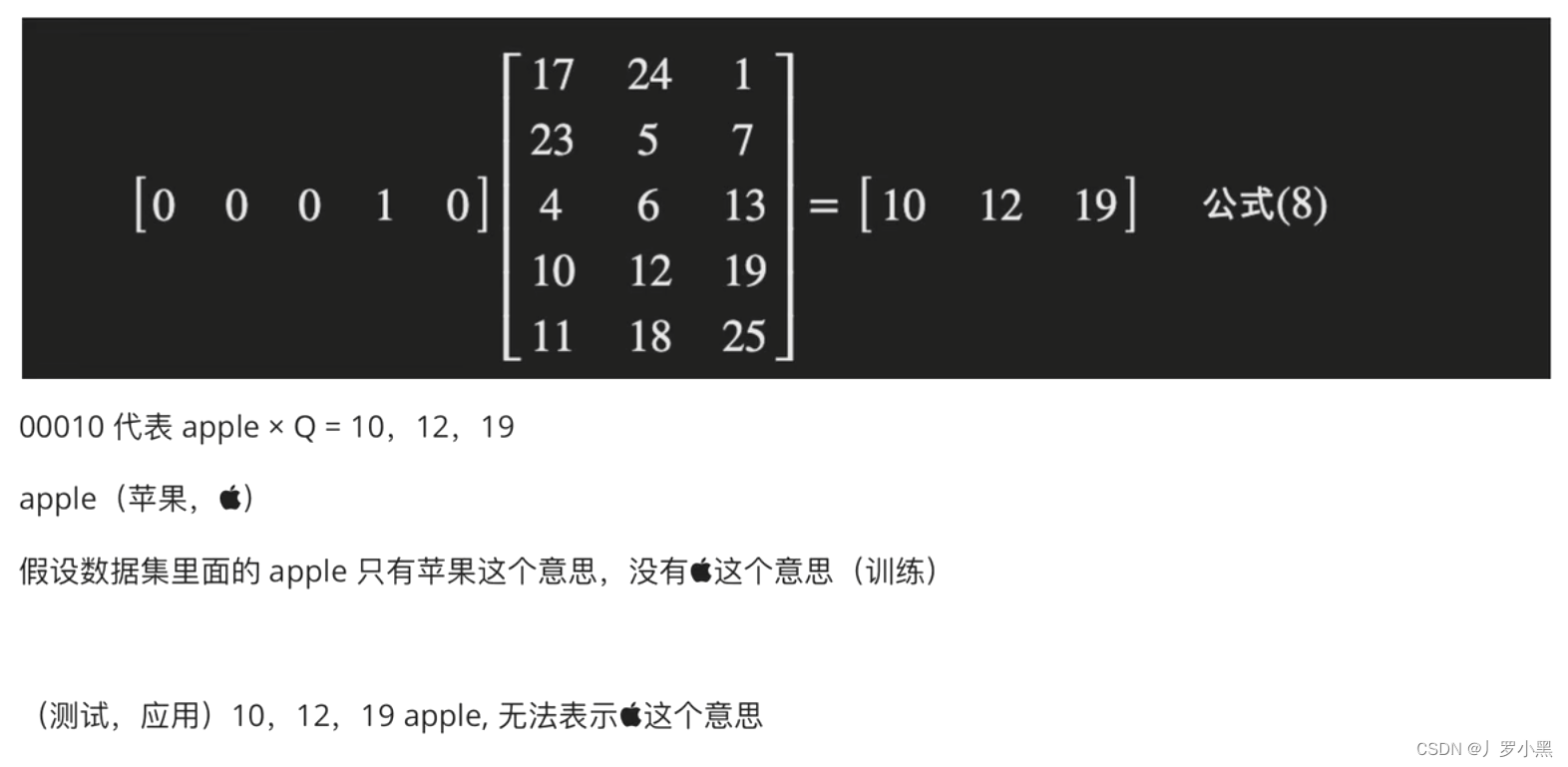

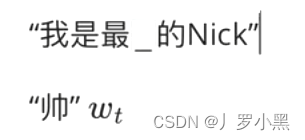

- 词向量不能表示一词多义,如果我们在训练中给某一个词选择了一个词向量,但是在测试中,同样的词可能会有其他意思,那模型仍然不知道这个位置应该填入什么词,如下:

- 词向量不能表示一词多义,如果我们在训练中给某一个词选择了一个词向量,但是在测试中,同样的词可能会有其他意思,那模型仍然不知道这个位置应该填入什么词,如下:

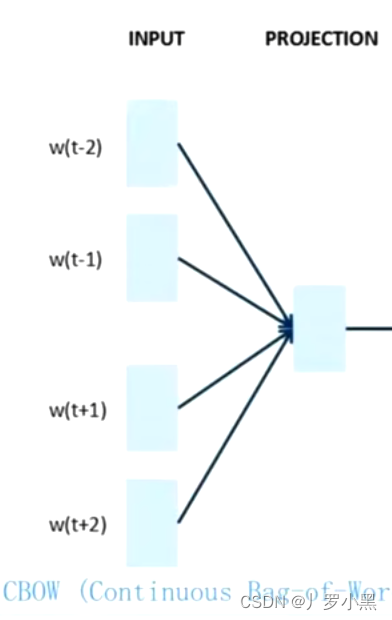

CBOW

- 给出一个词的上下文,预测这个词,如下:

- 由于Q矩阵和词向量的产生在INPUT到PROJECTION的过程中,且CBOW会有更多的Q矩阵和词向量,也就意味着它生成词向量的效率更高,如下:

Skip-gram

- 给出一个词,得到这个词的上下文,如下:

- 相反,在Skip-gram中,我们得到Q矩阵和词向量的效率会低一些