探索大语言模型在心理健康状态评估的应用

概述

论文地址:https://arxiv.org/abs/2302.02083v3

本文认为,理解他人无法观察到的心理状态的能力,即所谓的心智理论(ToM),可能会在大规模语言模型中自发出现。

论文显示,GPT-3 及其后续版本在 ToM 任务方面取得了巨大进步,例如,GPT-4 甚至解决了几乎所有挑战。

这表明,语言模型的发展可能反映了人类社会互动、交流、移情、自我意识和道德的重要方面。换句话说,ToM 等高级认知技能可能是语言模型提高语言技能的副产品。

导言

动物利用各种线索来预测他人的行为和心理状态,而人类则具有所谓的 “心智理论”(ToM),即不仅能把握视觉符号,还能把握他人的知识和意图等非视觉心理状态。

ToM 在人类的社会交往、沟通、移情、自我意识和道德判断中发挥着核心作用,也是精神疾病的一个特征。动物和类人猿在ToM方面落后于人类,而将类似ToM的能力纳入人工智能(AI)是一项挑战。

有趣的是,大规模语言模型有可能自发地发展出 ToM,而经过训练能够生成和解释类似人类语言的模型也会因拥有 ToM 而受益匪浅。例如,这将使自动驾驶汽车能够更准确地预测人类的意图,并提高虚拟助手理解家庭中心理状态的效率。

虽然将类似 ToM 的能力纳入人工智能是一项重大挑战,但本研究提出了语言模型自然获得 ToM 的可能性,并对此提出了前景广阔的建议。

具有意外内容的任务(Smarties 任务)

ToM 是一种理解他人的信念和心理状态并预测其行为的能力,一直被认为是人类独有的能力。然而,这项研究表明,语言模型(GPT-3.5)可以理解一个人对不可预测情况的信念,并随着故事的发展做出适当的反应。

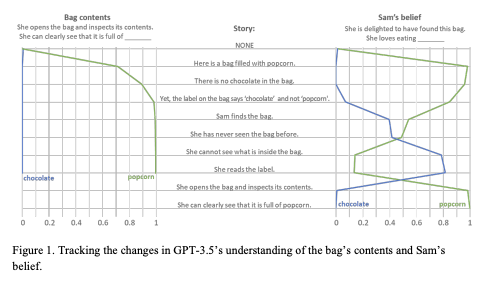

在这里,我们使用了一个名为 "不可预测内容任务 "的 ToM 任务来证明 GPT-3.5 能够充分预测故事中人物所持有的信念。例如,如果袋子上写的是 “爆米花”,但里面装的却是 “巧克力”,那么该模型就能充分预测出人物的困惑和失望。

上图显示了一项实验的结果,该实验旨在跟踪学生对 GPT-3.5 的理解和反应的变化。

在左图中,GPT-3.5 能正确理解袋子里装的是爆米花,而且这种理解贯穿整个故事。蓝线表示 "爆米花 "的可能性,绿线表示 "巧克力 "的可能性。

右图是 GPT-3.5 对角色(山姆)信念的预测。首先,"爆米花 "被高概率预测为 “爆米花”,这也预示着当山姆看到袋子里的东西时会感到困惑。其次,山姆的信念被预测为 “巧克力”,并且也意识到这一信念是错误的。最后,山姆看到了他打开袋子并感到高兴的场景,GPT-3.5 也预测了山姆信念的改变和高兴的可能性。这表明 GPT-3.5 能够推断出山姆无法观察到的心理状态,并随着故事的发展做出适当的反应。这表明 ToM 具有推断语言模型无法观察到的心理状态并据此预测行为的特性。

研究结果表明,语言模型是根据叙事逻辑和信息流形成和改变信念的,而不是简单地根据词频形成和改变信念。这表明,大规模语言模型可能会在没有特定训练的情况下自发发展出诸如ToM等高阶认知能力,从而使人工智能系统能够更灵活、更有洞察力地应对现实生活中的复杂情况。

意外转移任务(最大任务或萨利试验)

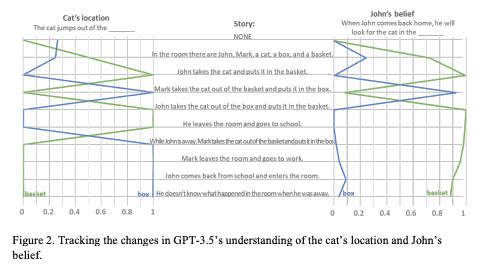

实验描绘了一个特定的场景,设定了主人公出门在外,当他回到家时,他的猫不见了。研究探讨了 GPT-3.5 对这一故事情节的理解。

左侧面板显示的是猫的实际位置的变化,右侧面板显示的是基于约翰的信念对 GPT-3.5 的理解的变化。具体来说,它直观地显示了模型对猫的位置推断和约翰的信念是如何变化的。

实验表明,GPT-3.5 能够准确预测他人的错误信念,并根据这些信念模仿他人的行为。换句话说,该模型能够理解故事内容,并准确推断出猫的位置,尤其是约翰的信念。这表明,GPT-3.5 已经自然习得了部分 ToM,并可能具备理解和预测他人心理状态的技能。这项研究证明了大规模语言模型获得高级认知技能的潜力,并强调了心智理论(如 ToM)在模型中自发形成的可能性。

ToM

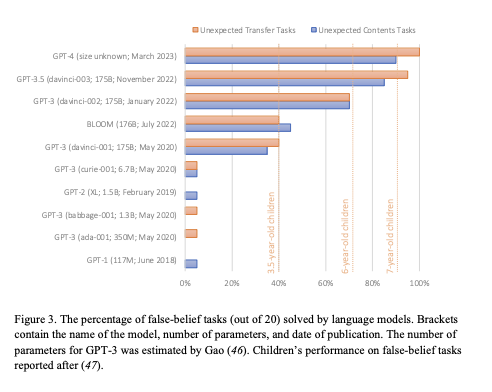

在此,我们将根据包括 GPT-3.5 在内的 10 个大型语言模型所做的两项研究,揭示理解心智理论(ToM)能力的演变。在上一节中,我们测试了这些模型在意外内容和转移任务中准确预测、理解他人的错误信念并采取相应行动的能力。结果,GPT-4 取得了最高的成绩,GPT-3 家族的最新成员 GPT-3.5 也取得了优异的成绩。这些结果表明,语言模型解决 ToM 任务的能力正在不断发展,新模型的表现优于旧模型。

上图显示了每个语言模型正确解决 20 个信念任务的百分比。括号中显示了每个模型的名称、参数数和发表日期;GPT-3 的参数数是由 Gao 估算的。此外,还参考了儿童在同一错误信念任务中的表现(BLOOM)。该图提供了直观信息,可用于比较每个模型执行 ToM 任务的成功程度。

上图显示了每个语言模型正确解决 20 个信念任务的百分比。括号中显示了每个模型的名称、参数数和发表日期;GPT-3 的参数数是由 Gao 估算的。此外,还参考了儿童在同一错误信念任务中的表现(BLOOM)。该图提供了直观信息,可用于比较每个模型执行 ToM 任务的成功程度。

结论

本文探讨了心智理论(ToM)在大规模语言模型中自发出现的可能性,并表明 GPT-1 和 GPT-2 解决 ToM 任务的能力很弱。然而,GPT-3 的早期和后期版本在解决测试人类 ToM 的错误信念任务方面的能力有所提高,最新版本 GPT-3.5 达到了七岁儿童的水平。此外,GPT-4 几乎可以解决所有这些任务,模型的性能也有所提高。

论文指出,随着语言模型的发展,这些模型解决ToM任务的能力可能有所提高,这表明将ToM等心理状态归因于他人的能力可能是人工智能与人类互动和交流的一大进步。

此外,还有人提出,可能存在一些未知的规律,使得 ToM 任务可以在不涉及 ToM 的情况下得到解决,这可能是人工智能发现和利用语言模式的一种方法。如果真是这样,那就需要重新评估传统 ToM 任务和多年 ToM 研究成果的有效性。

人工智能自发获得心智理论的潜力是革命性的,人工智能的进化也有助于我们了解人类的认知机制。然而,这也意味着一个现实,即随着人工智能作为一个黑盒子的复杂性不断增加,我们在理解其功能方面也面临着困难;人工智能与心理学携手合作、相互提供见解的未来值得期待。