大语言模型:AI 时代的文字计算器?

当前,大语言模型已经成为自然语言处理领域的热点。LLMs 是否真的 “智能”?它们又为我们带来了哪些启发?针对这些问题,Darveen Vijayan 为我们带来了这篇引人深思的文章。

今天主要阐释了两个观点:第一,LLMs 应被视为一种文字计算器,它通过预测下一个词来工作,当前阶段还不应被归为 “智能”。第二,尽管 LLMs 目前存在局限,但它们为我们提供了反思人类智能本质的契机。我们应保持开放的思维,不断追逐新的知识和对知识的新理解,积极与他人交流沟通,从而拓展我们的认知边界。

LLMs 是否智能,恐怕仍存在争议。但有一点确定无疑,它们为自然语言处理领域带来了革新,也为人类智能的本质提供了新的思考维度。这篇文章值得每一位大模型工具使用者和 AI 从业者细细品读、反复咀嚼。

如果您也对AI大模型感兴趣想学习却苦于没有方向👀

小编给自己收藏整理好的学习资料分享出来给大家💖

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码关注免费领取【保证100%免费】🆓

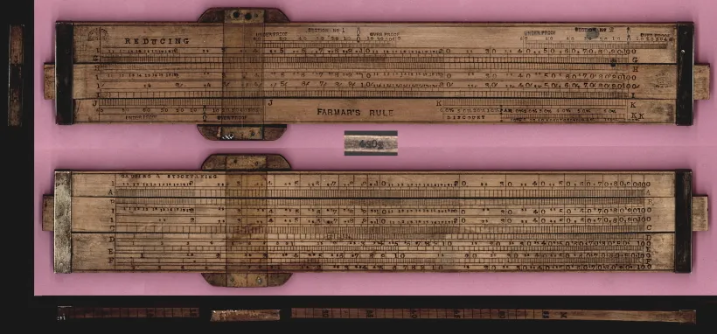

17 世纪初,一位名叫埃德蒙・冈特的数学家和天文学家面临了一个前所未有的天文挑战 —— 要计算行星的复杂运动轨迹并预测日食,天文学家不仅需要依靠直觉,还需要掌握复杂的对数运算和三角方程。因此,像其他优秀的创新者一样,冈特决定发明一种模拟计算装置!他创建的这种装置,最终成为了我们熟知的计算尺 [1]。

计算尺是一个长 30 厘米的长方形木块,由固定框架和滑动部分两部分组成。固定框架中装有固定的对数刻度,而滑动部分则装有可移动的刻度。要使用计算尺,需要理解对数的基本原理,以及如何对准刻度进行乘法、除法和其他数学运算。需要滑动可移动部分,使数字对齐,读出结果,并注意小数点的位置。哎呀,真的太复杂啦!

计算尺

计算尺

大约在 300 年后,贝尔庞克公司(Bell Punch Company)于 1961 年推出了第一台台式电子计算器 “ANITA Mk VII”。在随后的几十年里,电子计算器变得越来越复杂,功能也越来越多。以前需要大量人工计算的工作所花费的时间越来越少,使员工能够专注于更具分析性和创造性的工作。因此,现代电子计算器不仅使工作更加高效,还使人们能够更好地解决问题。

计算器对于数学的处理方式来说是一次重大的改变,那么对于语言呢?

想想你是如何构造句子的。首先,你需要有一个想法(这句话要表达什么意思)。接下来,你需要掌握一堆词汇(拥有足够的词汇量)。然后,你需要能够正确地将这些词汇组成句子(需要掌握语法)。哎呀,还是那么复杂!

早在 5 万年前,也就是现代智人第一次创造语言的时候,我们产生语言词汇的方式就基本保持不变了。

可以说,在构造句子这方面,我们仍然像冈特使用计算尺一样!

It’s fair to say we’re still in Gunther’s era of using a slide rule when it comes to generating sentences!

仔细思考一下,使用恰当的词汇和正确的语法就是在遵守语言规则。

这与数学类似,数学充满了规则,因此我才能确定 1+1=2 以及计算器的工作原理!

我们需要一种用于文字的计算器!

What we need is a calculator but for words!

是的,不同的语言需要遵循不同的规则,但只有遵守语言规则,语言才能被人理解。语言和数学的一个明显区别是,数学有固定且确定的答案,而适合放入句子中的合理单词可能很多。

试着填充下面这个句子:I ate a _________.(我吃了一个 _________。)想象一下接下来可能出现的单词。英语中大约有 100 万个单词。很多单词可以在这里使用,但肯定不是全部。

回答 “黑洞(black hole)” 相当于说 2+2=5。此外,回答 “apple” 也不准确。为什么呢?因为语法的限制!

在过去的几个月里,大语言模型(LLM)[2] 风靡全球。有人将其称为自然语言处理领域的重大突破,也有人将其视为人工智能(AI)新时代的曙光。

事实证明,LLM 非常善于生成类人文本(human-like text),这提高了基于语言的人工智能应用的标准。凭借庞大的知识库和优秀的语境理解能力,LLM 可以应用于各个领域,从语言翻译和内容生成到虚拟助理和用于客户支持的 chatbots。

我们现在是否正处于与上世纪 60 年代的电子计算器类似的转折点?

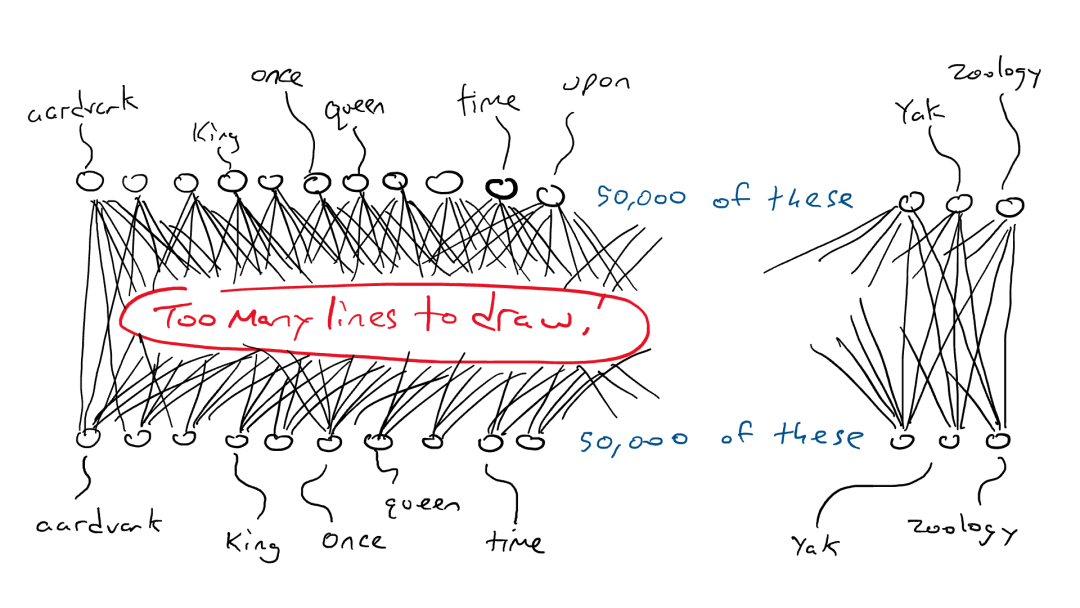

在回答这个问题之前,让我们先了解一下 LLM 是如何工作的?LLM 基于 Transformer 神经网络,用于计算和预测句子中下一个最合适的单词。要构建一个强大的 Transformer 神经网络,需要在大量文本数据的基础上进行训练。这就是为什么 “预测下一个单词或 token” 的方法效果如此好:因为有大量容易获得的训练数据。LLM 将整个单词序列(sequence of words)作为输入,并预测下一个最有可能出现的单词。为了学习最有可能出现的下一个词,他们先吞下所有维基百科数据作为热身,然后再吞下成堆的书籍,最后吞下整个互联网。

我们在前面已经确定,语言包含各种规则和模式。模型会通过所有这些句子来隐式地学习这些规则,用来完成预测下一个单词的任务。

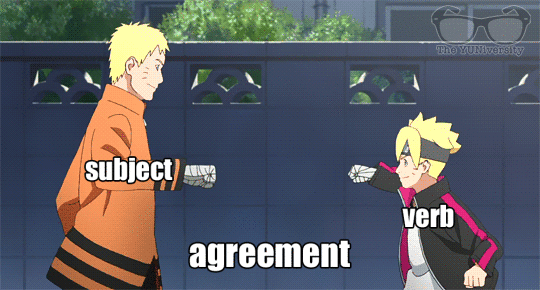

深度神经网络

在单数名词之后,下一个词出现以 "s " 结尾的动词的概率就会增加。同样,在阅读莎士比亚的作品时,出现 "doth " 和 "wherefore " 等词的概率也会增加。

在训练过程中,模型会学习这些语言模式,最终成为一位语言专家!

但这就够了吗?仅仅学习语言规则就足够了吗?

But is that enough? Is learning linguistic rules enough?

语言是复杂的,根据语境,一个词可能有多重含义。

因此,需要自注意力(self-attention)。简单来说,自注意力是语言学习者用来理解句子或文章中不同单词之间关系的一种技巧。就像你会关注故事的不同部分来理解故事一样,自注意力可以让 LLM 在处理信息时更加重视句子中的某些单词。 这样,模型就能更好地理解文本的整体含义和上下文,而不是仅仅根据语言规则盲目地预测下一个单词。

自注意力机制

如果将大语言模型视为一种单词的计算器,只会单纯地预测下一个单词,那么它如何能回答我所有的问题呢?

If LLMs are calculators for words, just predicting the next word, how can it answer all my questions?

当你让大语言模型处理一些需要思考的任务时,而它也能够成功完成,这很可能是因为你给它的任务它已经在成千上万个例子中见过了。即使你提出了一些非常独特的需求,比如:

“写一首关于虎鲸吃鸡的诗”

Write me a poem about an orca eating a chicken

大语言模型也能够成功完成你交待的任务:

Amidst the waves, a sight unseen, An orca hunts, swift and keen, In ocean’s realm, the dance begins, As a chicken’s fate, the orca wins.

With mighty jaws, it strikes the prey, Feathers float, adrift away, In nature’s way, a tale is spun, Where life and death become as one.

- ChatGPT

很不错,对吧?这多亏了它的自注意力机制,使其能够有效地融合和匹配相关信息,从而构建出一个合理而连贯的回答。

在训练过程中,大语言模型(LLM)学会了识别数据中单词(and 短语)之间的模式、关联和关系。经过大量的训练和微调,LLM 可以表现出一些新的特性,例如进行语言翻译、摘要生成、问题解答,甚至是创意写作。尽管模型没有直接接受某些任务或技能的教授,但通过对大量数据的学习和训练,模型可以展现出超出预期的能力,并且表现得非常出色

那么,大语言模型是否具备智能(intelligent)呢?

Are Large Language Models intelligent?

电子计算器(electronic calculator)已经存在了六十多年。这种工具在技术上取得了 “飞跃式” 的进步,但从来没有被认为是智能的。为什么呢?

图灵测试(Turing Test)是一种判断机器是否具有人的智能(human intelligence)的简单方法:如果一台机器能以让人类无法区分的方式与人类进行对话,那么它被认为具有人的智能。

计算器从未经历过图灵测试 [3],因为它不使用与人类相同的语言进行交流,只能使用数学语言。然而,大语言模型生成的是人类语言。它的整个训练过程都围绕着模仿人类语言展开。因此,它能够 “以让人类无法区分的方式与人类进行对话” 并不令人意外。

因此,用 “智能(intelligent)” 一词来描述大语言模型有些棘手,因为对于智能的真正定义并没有明确的共识。判断某物是否智能的一种方式是,它是否能够做出有趣、有用且有一定程度的复杂性或创造性的事情。大语言模型确实符合这个定义。不过,我并不完全同意这种解释。

我将智能定义为拓展知识边界的能力。

I define intelligence as the ability to expand the frontiers of knowledge.

截至本文撰写之时,通过预测下一个 token / 单词方式进行工作的机器仍然无法拓展知识的边界。

不过,它可以根据已有的数据进行推断和填补。它既无法明确理解词语背后的逻辑,也无法理解现有的知识体系。它无法产生创新的想法或深入的洞察力。它只能提供相对一般的回答,而无法产生突破性的想法。

在面对机器无法产生创新思维和深入洞察力的情况下,对于我们人类来说有什么影响或启示呢?

So, what does this mean for us humans?

我们应该将大语言模型(LLMs)更多地视为一种对词语的计算器。 不应该让我们的思考过程完全依赖于大模型,而应将其视为我们思考和表达的辅助工具而非替代品。

同时,随着这些大模型的参数量呈指数级增长,我们可能会感到越来越不知所措和力不从心。对此,我的建议是始终保持对看似不相关的想法的好奇心。有时候我们会遇到一些看似不相关的或矛盾的想法,但通过我们的观察、感知、经验、学习和与他人的交流,我们可以发现这些想法之间可能存在某种联系,或这些想法可能是合理的。(译者注:这种联系可能来自于我们对事物的观察、理解和解释,或者是通过将不同领域的知识和概念相互关联而得出的新的想法。我们应该保持开放的思维,不仅仅局限于表面上的直觉,而是观察、感知、经验、学习和与他人的交流,来发现更深层次的意义和联系。)我们不应满足于仅停留在已知领域,而是应该积极探索新的领域,不断扩展我们的认知边界。 我们也应该不断追求新的知识或对已掌握知识的新理解,并将它们与已有的知识相结合,去创造新的见解和想法。

如果你能够以前文所描述的思维方式和行为方式行动,那么,无论是计算器还是大语言模型,所有形式的技术都将成为你可以利用的工具,而不是你需要担心的生存威胁。

END