聚水潭商品信息集成到MySQL的高效解决方案

聚水潭商品信息集成到MySQL的技术案例分享

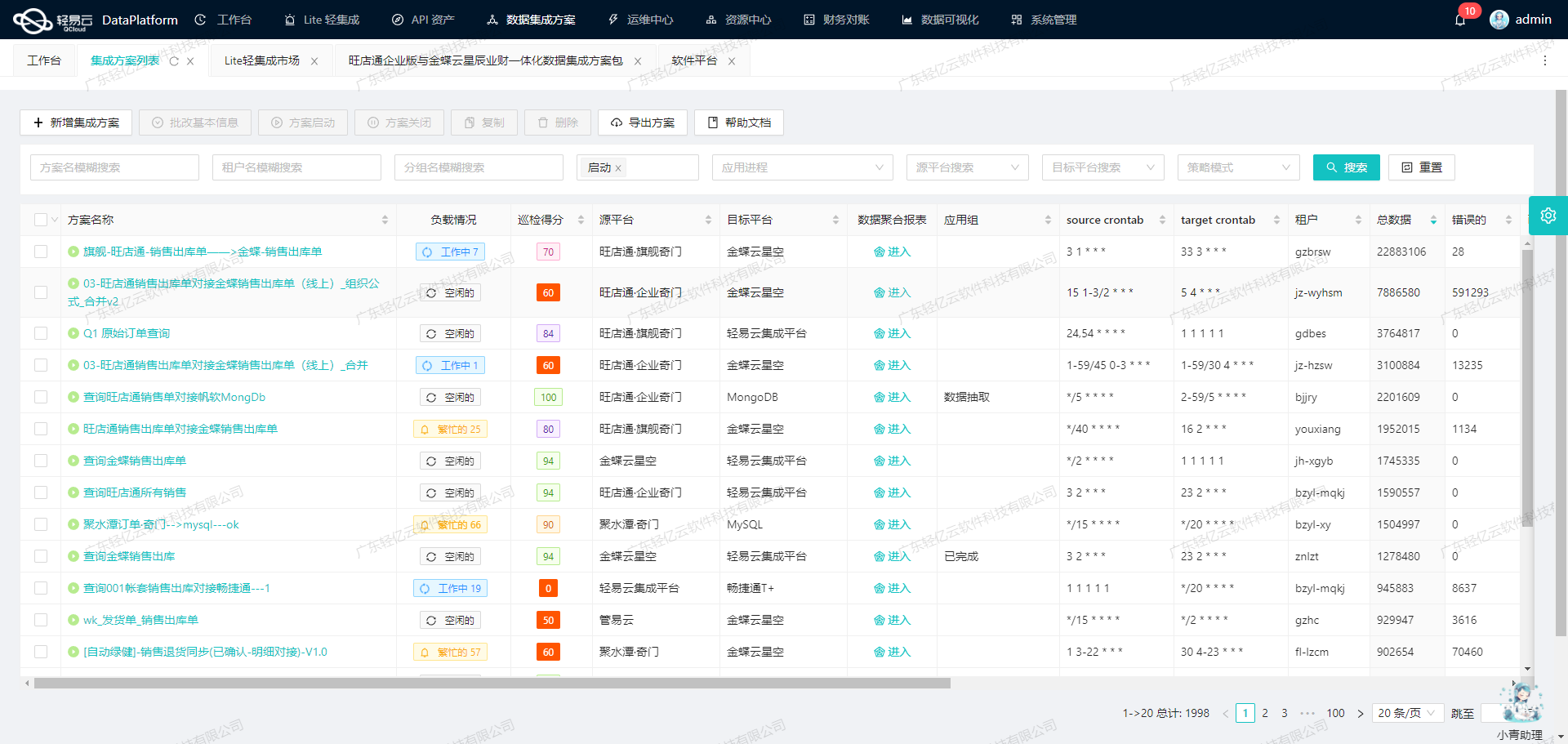

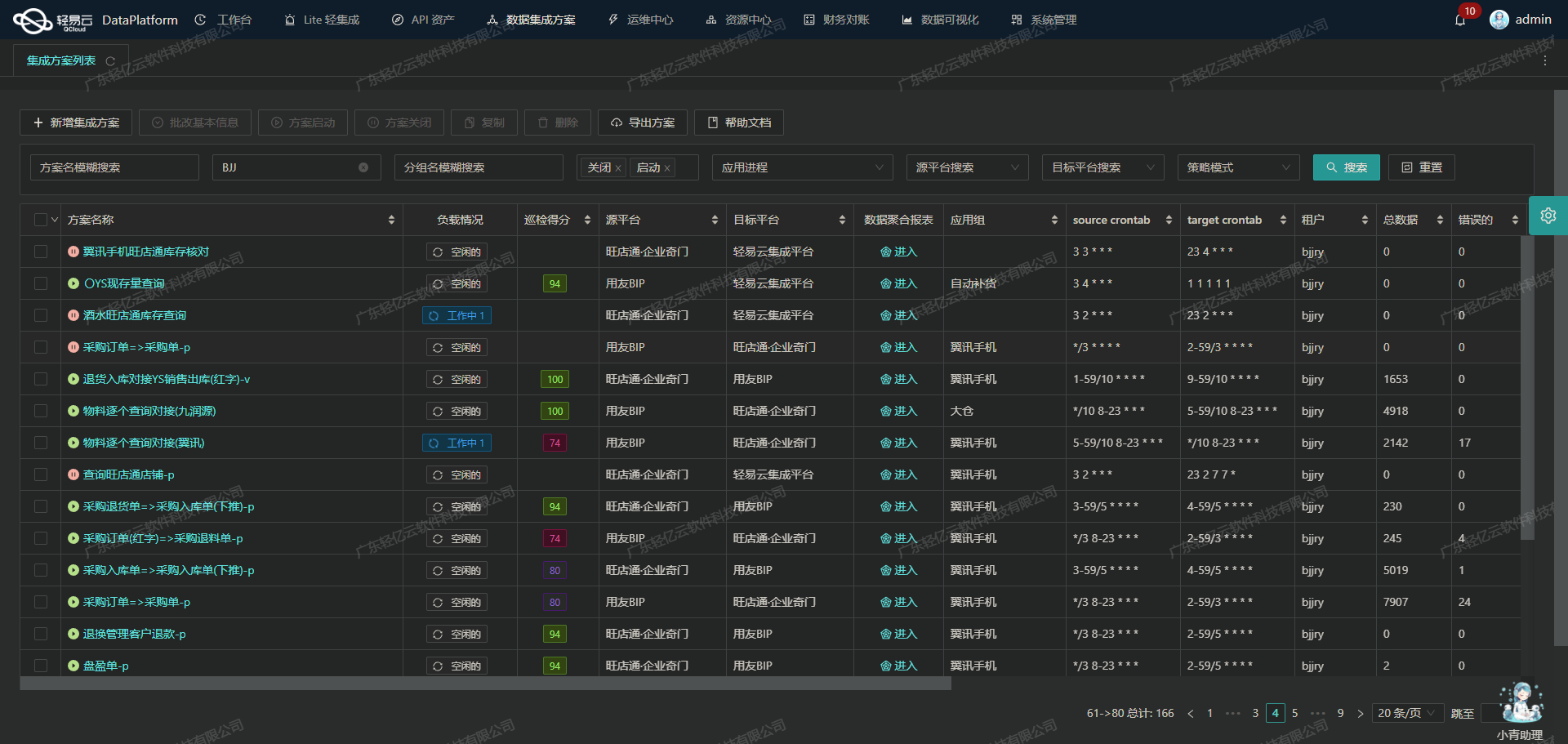

在数据驱动的业务环境中,如何高效地实现不同系统之间的数据对接和集成,是每个企业面临的重要挑战。本文将聚焦于一个具体的系统对接集成案例:将聚水潭平台上的商品信息单集成到BI斯莱蒙的MySQL数据库中,并且仅新增数据。

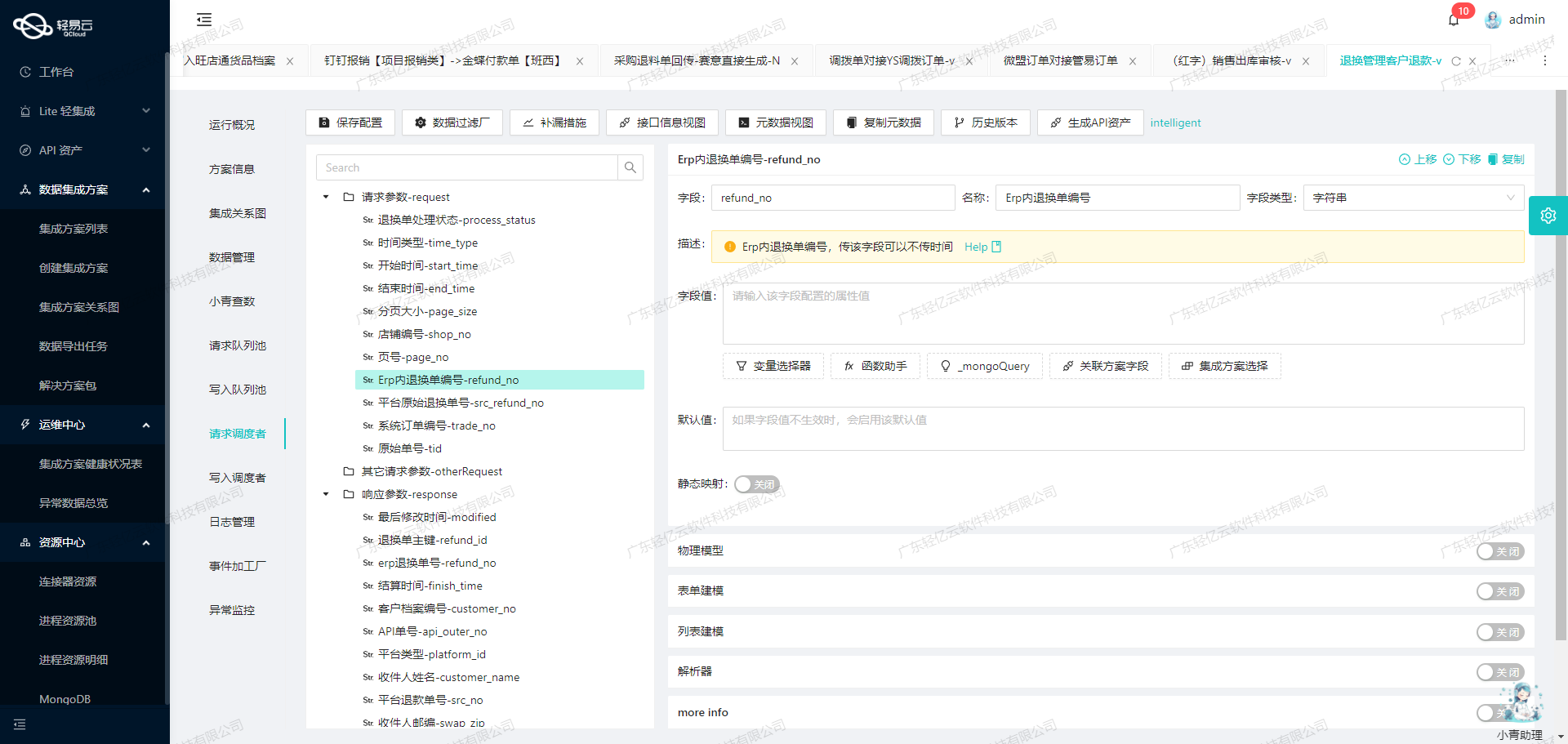

本次集成方案命名为“聚水谭-商品信息单-->BI斯莱蒙-商品信息表(只新增)”,旨在通过轻易云数据集成平台,实现从聚水潭获取最新商品信息并写入到MySQL数据库中的过程。该方案不仅需要处理大量数据的快速写入,还要确保数据质量和实时监控。

首先,我们利用了轻易云平台支持高吞吐量的数据写入能力,使得大量商品信息能够快速被集成到MySQL中,从而提升了整体数据处理的时效性。同时,通过定时可靠地抓取聚水潭接口(/open/sku/query)数据,确保不会漏单,保证了数据的一致性和完整性。

为了应对可能出现的数据格式差异问题,我们自定义了数据转换逻辑,以适应特定的业务需求和数据结构。此外,针对分页和限流问题,我们设计了一套有效的处理机制,确保接口调用的稳定性和效率。

在整个过程中,集中监控和告警系统发挥了重要作用。我们实时跟踪每个数据集成任务的状态和性能,一旦发现异常情况,可以及时进行处理。这种实时监控与日志记录功能,不仅提高了故障响应速度,还增强了系统运行的透明度。

最后,为了进一步优化资源利用,我们通过统一视图掌握API资产管理情况,实现资源配置的高效化。这一系列技术手段共同保障了此次“聚水谭-商品信息单-->BI斯莱蒙-商品信息表(只新增)”方案的成功实施。

接下来,将详细介绍具体实施步骤及技术细节。

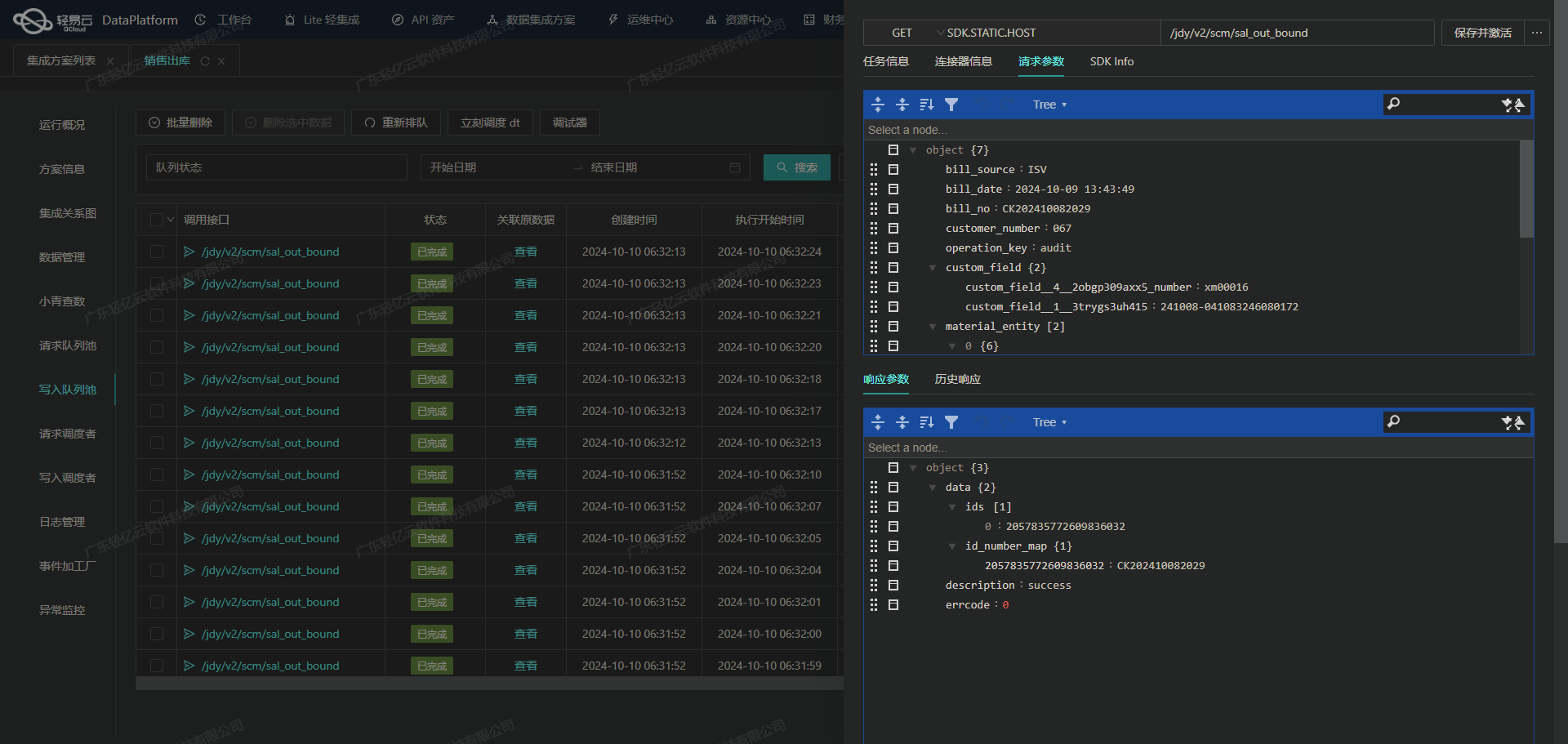

调用聚水潭接口获取并加工数据的技术实现

在数据集成过程中,调用源系统接口是至关重要的一步。本文将详细探讨如何通过轻易云数据集成平台调用聚水潭接口 /open/sku/query 获取商品信息,并对其进行加工处理。

聚水潭接口配置与调用

首先,我们需要配置和调用聚水潭的商品信息查询接口 /open/sku/query。该接口采用POST方法,支持分页查询和时间范围过滤。以下是关键的请求参数:

page_index: 开始页,从第一页开始,默认值为1。page_size: 每页条数,默认30,最大50。modified_begin: 修改起始时间,与结束时间必须同时存在。modified_end: 修改结束时间,与起始时间必须同时存在。sku_ids: 商品编码,与修改时间不能同时为空,最多20个。

这些参数确保了我们可以灵活地控制数据抓取的范围和数量。例如,通过设置 modified_begin 和 modified_end 参数,可以仅获取特定时间段内被修改过的商品信息。

数据分页与限流处理

由于聚水潭接口有分页和限流限制,我们需要设计一个可靠的分页机制来确保所有数据都能被完整抓取。通常情况下,我们会从第一页开始逐页请求,每次请求后检查返回的数据量,如果达到每页最大条数,则继续请求下一页,否则停止请求。这种方式可以有效避免漏单问题。

for (int pageIndex = 1; ; pageIndex++) {

// 设置请求参数

Map<String, Object> params = new HashMap<>();

params.put("page_index", pageIndex);

params.put("page_size", 50);

params.put("modified_begin", lastSyncTime);

params.put("modified_end", currentTime);

// 调用API

List<SkuData> skuDataList = callApi("/open/sku/query", params);

if (skuDataList.size() < 50) {

break;

}

}

数据转换与写入MySQL

在获取到原始数据后,需要对其进行必要的转换,以适应目标系统(如BI斯莱蒙)的数据结构。这一步通常包括字段映射、格式转换等操作。例如,将聚水潭中的 sku_id 映射为目标系统中的主键ID,将名称字段统一格式化等。

for (SkuData sku : skuDataList) {

TargetSku targetSku = new TargetSku();

targetSku.setId(sku.getSkuId());

targetSku.setName(sku.getName());

// 写入MySQL数据库

insertIntoMySql(targetSku);

}

异常处理与重试机制

在实际操作中,不可避免地会遇到网络波动或服务端异常导致的数据抓取失败。因此,需要设计健壮的异常处理和重试机制。例如,在捕获到异常时,可以记录错误日志,并在一定延迟后重新尝试调用API。

try {

List<SkuData> skuDataList = callApi("/open/sku/query", params);

} catch (Exception e) {

log.error("API调用失败: ", e);

Thread.sleep(1000); // 延迟一秒后重试

retryCallApi(params);

}

实时监控与日志记录

为了确保整个数据集成过程透明可控,需要实时监控任务状态并记录详细日志。轻易云平台提供了集中监控和告警系统,可以实时跟踪每个任务的执行情况,并在出现异常时及时告警。这有助于快速定位问题并采取相应措施。

综上所述,通过合理配置聚水潭接口、设计可靠的分页机制、实施有效的数据转换与写入策略,以及完善的异常处理和实时监控,我们可以高效地完成从聚水潭到BI斯莱蒙的数据集成任务。在此过程中,轻易云平台提供了强大的工具支持,使得整个流程更加顺畅和高效。

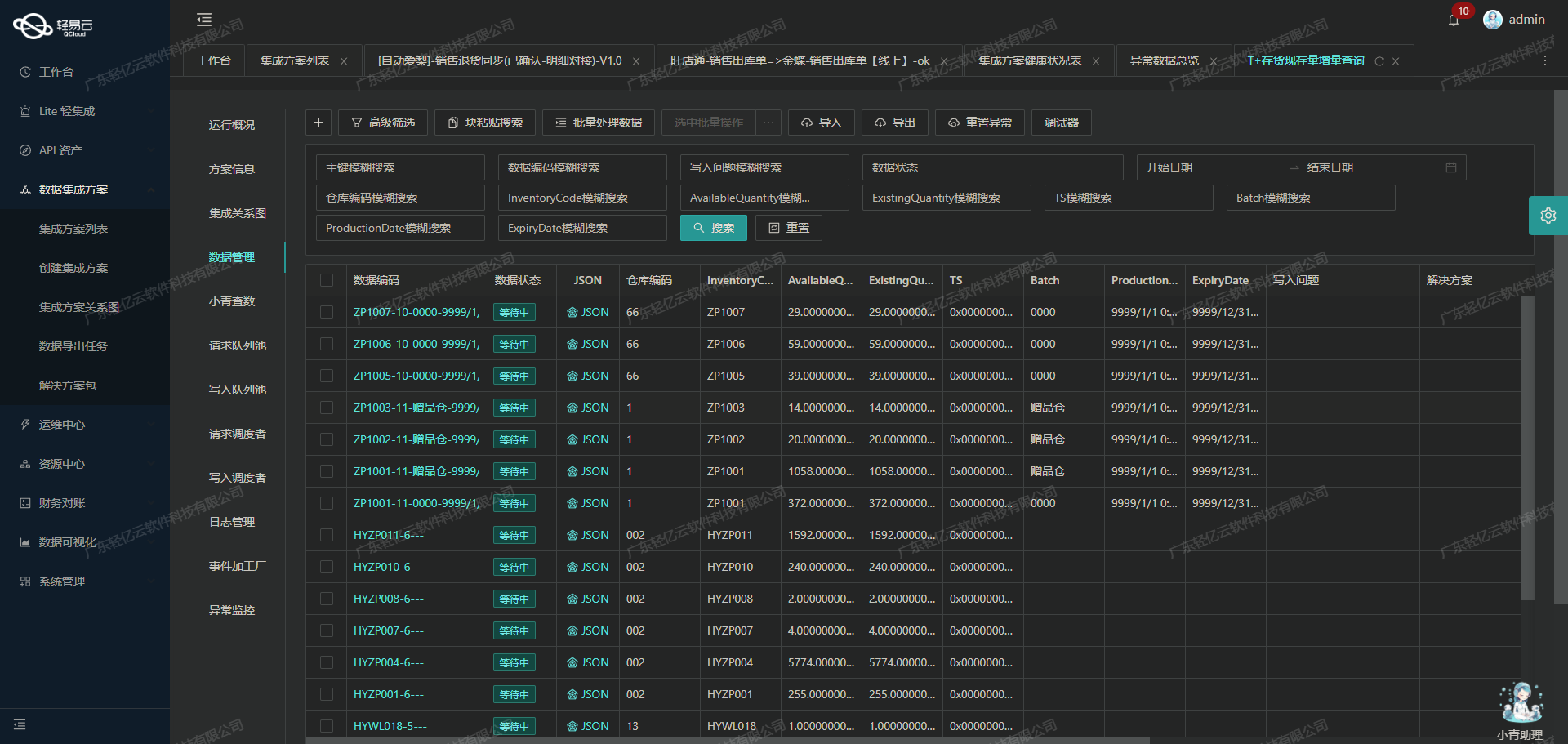

轻易云数据集成平台生命周期中的ETL转换与数据写入MySQL

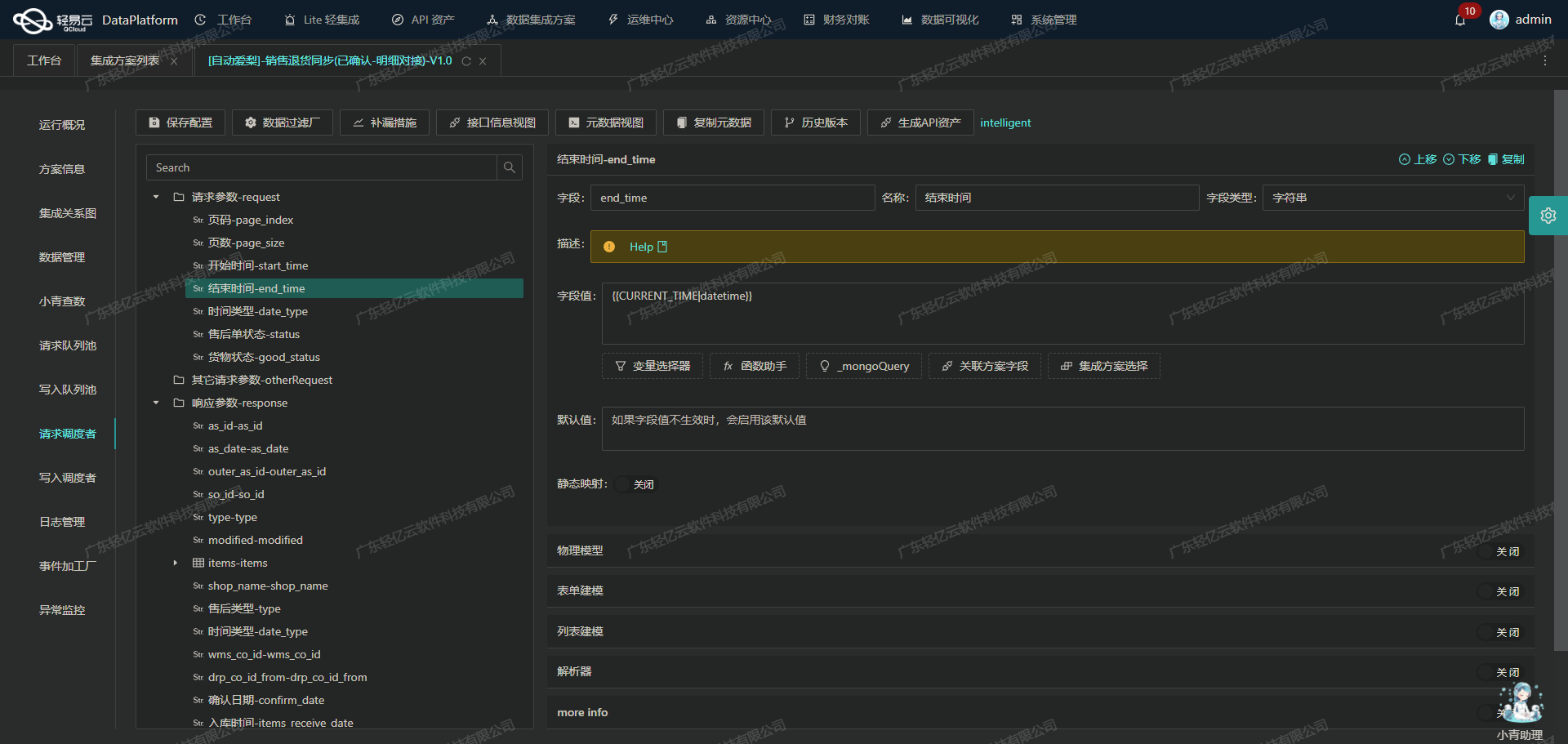

在数据集成的过程中,ETL(提取、转换、加载)是至关重要的一环。本文将详细探讨如何通过轻易云数据集成平台,将聚水谭的商品信息数据进行ETL转换,并最终写入目标平台MySQL数据库。

数据提取与清洗

首先,从聚水谭接口提取商品信息数据。聚水谭API提供了丰富的数据字段,如商品编码(sku_id)、款式编码(i_id)、商品名称(name)等。这些字段在提取后需要进行初步清洗,确保数据的完整性和一致性。例如,过滤掉空值或无效值,并根据业务需求对部分字段进行格式化处理。

数据转换

在数据提取和清洗之后,下一步是将这些数据转换为MySQLAPI接口能够接收的格式。这一步主要涉及字段映射和数据类型转换。以下是几个关键步骤:

-

字段映射:根据元数据配置,将源平台的字段映射到目标平台的相应字段。例如,聚水谭的

sku_id需要映射到MySQL数据库中的sku_id字段。 -

数据类型转换:确保每个字段的数据类型符合目标平台的要求。例如,将字符串类型的价格字段转换为浮点数类型,以便在MySQL中进行数值计算。

-

处理额外逻辑:根据业务需求,自定义一些转换逻辑。例如,对于价格字段,可以增加一个汇率转换逻辑,将人民币价格转换为美元价格。

数据加载

完成数据转换后,需要将这些数据批量写入MySQL数据库。轻易云数据集成平台支持高吞吐量的数据写入能力,可以快速处理大量数据。以下是具体操作步骤:

-

构建SQL语句:根据元数据配置,构建批量插入SQL语句。例如:

INSERT INTO sku_query (sku_id, i_id, name, short_name, sale_price, cost_price, properties_value, c_id, category, pic_big, pic, enabled, weight, market_price, brand, supplier_id, supplier_name, modified, sku_code, supplier_sku_id, supplier_i_id, vc_name, sku_type, creator, created, remark, item_type, stock_disabled, unit, shelf_life, labels, production_licence,l,w,h,is_series_number) VALUES (?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?,?,?)其中,每个问号代表一个待插入的数据值。

-

批量插入:使用轻易云提供的批量执行功能,将构建好的SQL语句和对应的数据批量插入MySQL数据库。这不仅提高了插入效率,还能有效减少网络延迟。

-

分页与限流处理:为了确保系统稳定性和性能,需要对批量插入操作进行分页和限流处理。例如,每次插入1000条记录,并设置合理的限流策略,避免对数据库造成过大压力。

异常处理与重试机制

在实际操作过程中,可能会遇到各种异常情况,如网络中断、数据库连接超时等。为了保证数据写入的可靠性,需要实现异常处理与重试机制:

- 异常捕获:在每次批量插入操作中,捕获可能发生的异常,并记录日志以便后续分析。

- 重试机制:对于临时性故障,可以设置自动重试机制。例如,在网络中断时,每隔几秒钟重试一次,最多重试三次。如果仍然失败,则将该批次的数据保存到错误队列中,以便后续手动处理。

实时监控与告警系统

为了及时发现并解决问题,需要建立实时监控与告警系统。轻易云提供了集中监控和告警功能,可以实时跟踪数据集成任务的状态和性能。一旦发现异常情况,如长时间未完成的数据插入任务或频繁出现的错误,即可自动触发告警通知相关人员进行处理。

通过上述步骤,可以高效地将聚水谭的商品信息数据进行ETL转换,并安全、可靠地写入目标平台MySQL数据库。这不仅提升了业务透明度和效率,还为企业的数据管理提供了强有力的支持。