## EPSANet论文阅读心得

EPSANet论文阅读心得

Zhang H, Zu K, Lu J, et al. EPSANet: An efficient pyramid squeeze attention block on convolutional neural network[C]//Proceedings of the asian conference on computer vision. 2022: 1161-1177.

文章目录

- EPSANet论文阅读心得

- 问题定义

- 创新点

- 方法实现

- PSA模块

- SPC模块

- EPSANET

问题定义

通道注意力和空间注意力可以提升性能。但仍有两个问题:

- 如何有效捕获和利用不同尺度的特征图的空间信息来丰富特征空间;

- 通道或空间注意力只能有效捕捉局部信息,难以建立long-range的通道依赖关系。

现有方法虽能解决上述问题,但会增加模型复杂度和计算开销。论文提出一个低成本且有效的注意力模块——金字塔压缩注意力(Pyramid Squeeze Attention,PSA),旨在以较低模型复杂度学习注意力权重,并有效整合局部注意力和全局注意力以建立long-range长期通道依赖关系。

- 应该是在pyraformer的基础上实现的

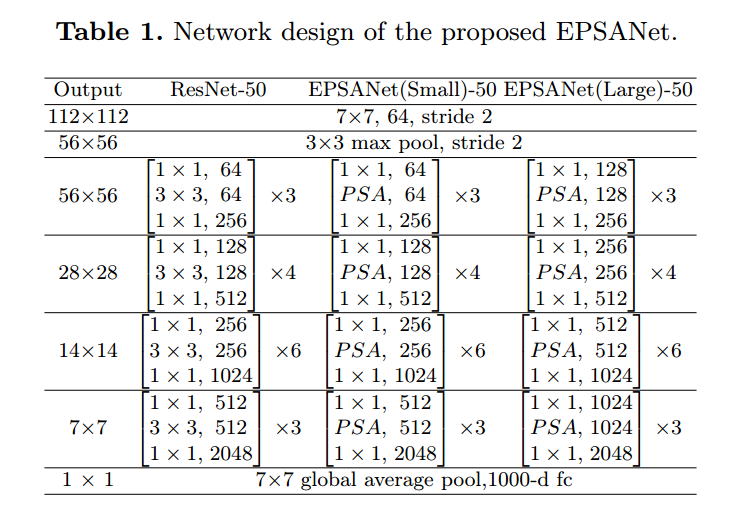

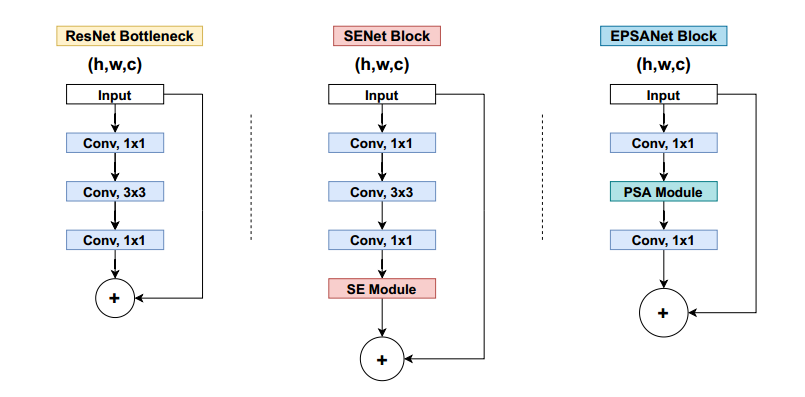

然后,将PSA 模块替换掉ResNet网络Bottleneck中的3x3卷积,其余保持不变,得到新的EPSA(efficient pyramid split attention)模块。基于EPSA block论文构建了一个新的骨干网络EPSANet。

- EPSANet的应用领域是在图像识别中的Top-1 Acc大幅度优于现有技术

创新点

- 提出一种新的Efficient Pyramid Squeeze Attention(EPSA)块,有效提取更细粒度的多尺度空间信息,并发展long-range远程通道依赖性;灵活可扩展,适用于各种网络架构。

- 提出EPSANet主干网络,可以学习更丰富的多尺度特征表示并自适应地中心校准跨维度的通道注意力权重。

- EPSANet在ImageNet和COCO数据集上的图像分类、目标检测、实例分割取得很好的结果。

方法实现

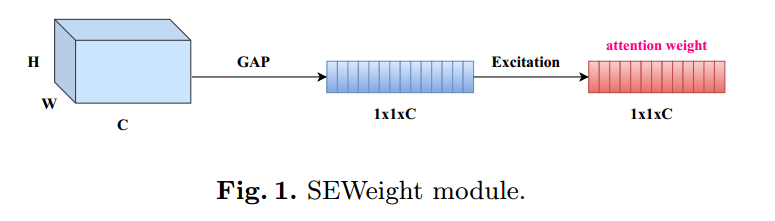

通道注意机制允许网络选择性地加权每个通道的重要性,从而生成更多信息输出。

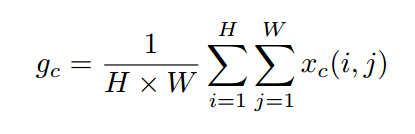

SE块由两部分组成:Squeeze压缩和Excitation激励,分别用于编码全局信息和自适应重新校准通道关系。通道数据使用全局平均池化GAP来生成,将全局空间信息嵌入到通道描述中。全局平均池化公式为:

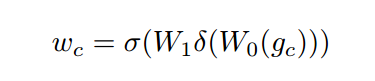

再用两个全连接层组合通道间的线性信息,帮助通道高维和低维信息的交互。c-th通道权重计算公式:

PSA模块

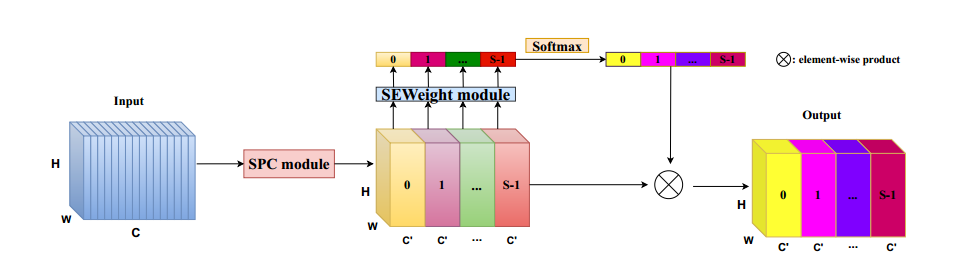

建立一个更高效的通道注意力机制。为此,提出了一种新的金字塔压缩注意力(PSA)模块。PSA模块主要通过四个步骤实现:

- 首先,利用SPC模块来对通道进行切分,然后针对每个通道特征图上的空间信息进行多尺度特征提取;

- 第二,利用SEWeight模块提取不同尺度特征图的通道注意力,得到每个不同尺度上的通道注意力向量;

- 第三,利用Softmax对多尺度通道注意力向量进行特征重新校准,得到新的多尺度通道交互后的注意力权重。

- 第四,对重新校准的权重和相应的特征图按元素进行点乘操作,输出得到一个多尺度特征信息注意力加权之后的特征图。该特征图多尺度信息表示能力更丰富。

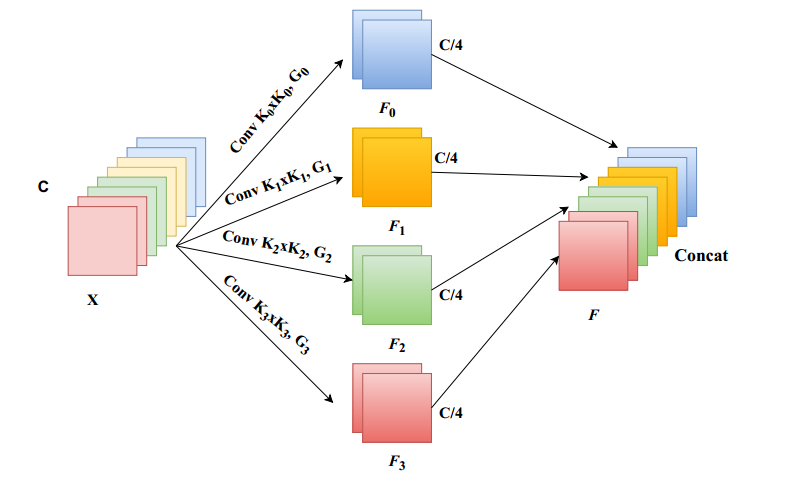

SPC模块

PSA模块中实现多尺度特征提取最重要的模块就是SPC

EPSANET

EPSA block结构如最右图所示,主要将ResNet中bottleneck部分的3x3卷积替换为PSA module。

基于EPSA block,论文提出一种新的骨干网络架构:EPSANet,并且根据PSA module中的分组卷积的大小,具体网络结构配置如下:

block,论文提出一种新的骨干网络架构:EPSANet,并且根据PSA module中的分组卷积的大小,具体网络结构配置如下: