发顶会首选:大模型+时间序列!掌握这3大切入点,小白也能轻松上手!

大模型+时间序列,是当下好发顶会且不卷的方向!

一方面,其在提高模型的预测准确率和效率方面,具有不可替代的作用!比如模型AutoTimes,在性能远超SOTA的同时,参数量减少99.9%,推理速度狂提5倍!主要在于,大模型具有强大的表征学习能力、泛化能力,以及多模态融合能力。其能够整合来自不同数据源和规模的信息,并提取出其中的关键特征和信息,为时间序列分析提供全面的信息。

另一方面,大模型作为新技术,发展时间还尚短,基于其做时间序列正处在上升期,可挖掘空间大;且目前大模型发展迅速,各种新模型层出不穷,也为我们的论文创新,提供了强有力的支撑。

想发论文的伙伴,可以从这3方面着手:构建基础模型、研究模型的可解释性、构建特定领域专有大模型。为让大家能够找到更多idea启发,每种思路,我都给大家准备了参考论文和源码,共17篇!

构建基础模型

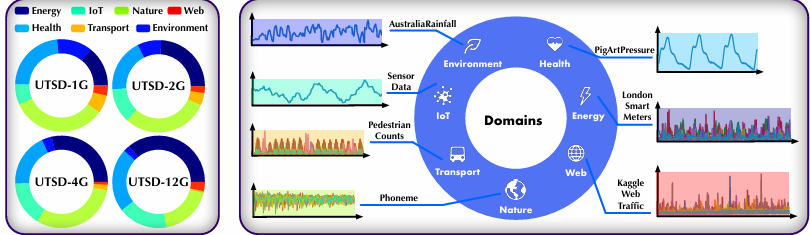

Timer: Pre-trained Transformers Are Large Time Series Models

内容:论文介绍了一个名为Timer的时间序列分析模型,它是一个大规模预训练的Transformer模型,旨在处理小样本场景下的时间序列预测、填补和异常检测任务。Timer通过在大规模多领域数据集上自回归地预测下一个时间点来预训练,并在特定下游任务上进行微调,展现出了良好的性能和泛化能力。

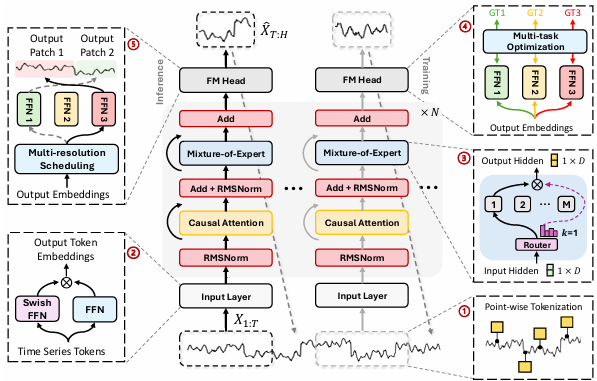

TIME-MOE: BILLION-SCALE TIME SERIES FOUN DATION MODELS WITH MIXTURE OF EXPERTS

内容:论文介绍了TIME-MOE,这是一个用于时间序列预测的大规模、高容量的可扩展基础模型架构,它采用了稀疏混合专家(MoE)设计来提高计算效率,并在保持高模型容量的同时减少推理成本。TIME-MOE由一系列仅解码器的Transformer模型组成,以自回归方式运作,支持灵活的预测范围,并在超过9个领域的300亿个时间点上进行了预训练,实现了2.4亿参数的规模,显著提高了预测精度。

模型可解释性

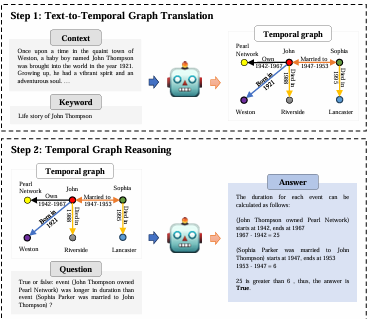

Large Language Models Can Learn Temporal Reasoning

内容:论文介绍了TG-LLM框架,旨在提升大型语言模型在时间推理任务上的性能。该框架首先将文本转换为时间图(TG),然后引导模型在TG上执行符号推理。通过在合成数据集TGQA上的实验,论文证明了TG-LLM框架在时间推理任务上相较于传统方法能够取得更好的效果,并且展示了该框架在不同数据分布上的泛化能力。

特定领域的应用

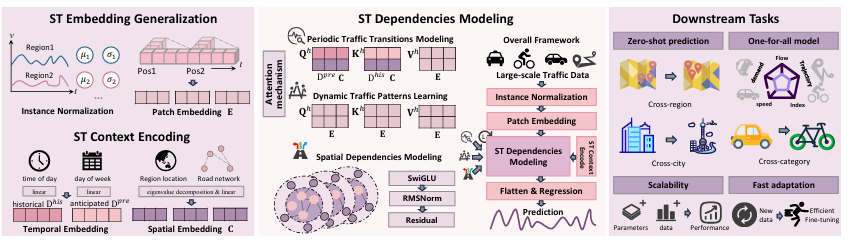

OpenCity: Open Spatio-Temporal Foundation Models for Traffic Prediction

内容:论文介绍了一个名为OpenCity的新地基模型,它旨在通过整合变换器架构和图神经网络来捕捉和规范化交通数据中的潜在时空模式,以实现在不同城市环境中的零样本泛化。OpenCity通过在大规模、异构的交通数据集上进行预训练,学习到丰富且可泛化的表示,能够无缝应用于广泛的交通预测场景,并展现出卓越的零样本预测性能和有希望的扩展性,为开发一个能够适应新城市环境的通用交通预测解决方案提供了可能性。

码字不易,欢迎大家点赞评论收藏!

关注下方《AI科研技术派》

回复【LLTS】获取完整论文

👇