NLP论文速读(CVPR 2024)|使用DPO进行diffusion模型对齐

论文速读|Diffusion Model Alignment Using Direct Preference Optimization

论文信息:

简介:

本文探讨的背景是大型语言模型(LLMs)通过人类比较数据和从人类反馈中学习(RLHF)的方法进行微调,以更好地符合用户的偏好。然而,对于文本到图像的扩散模型,人类偏好学习并没有得到广泛探索。现有的方法主要是通过精心策划的高质量图像和标题来微调预训练模型,以提高视觉吸引力和文本对齐。本文提出了一种新的方法,即直接优化人类比较数据来对齐扩散模型和人类偏好。本文动机在于提高文本到图像扩散模型的性能,使其更符合人类的偏好。LLMs的成功表明,通过人类反馈进行微调可以显著提升模型的表现。本文旨在将这一概念扩展到扩散模型中,通过直接优化人类比较数据来实现更好的模型对齐。

论文方法:

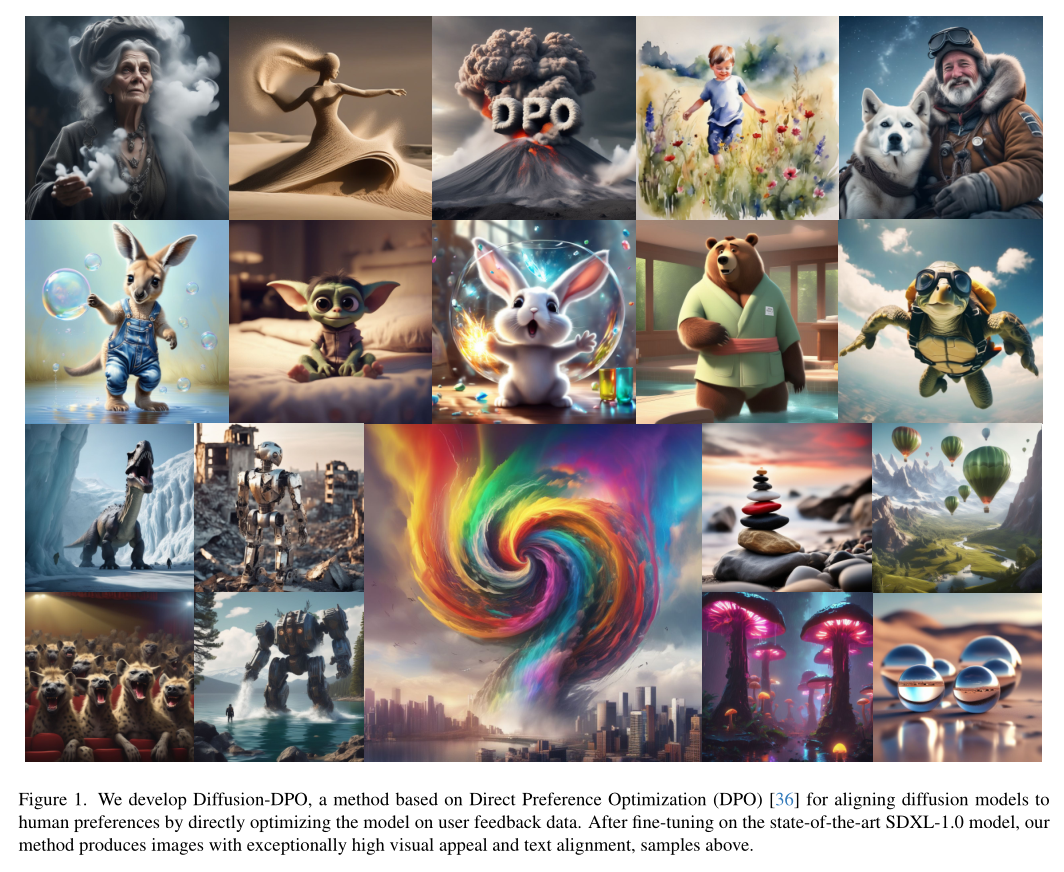

本文提出了一种名为DiffusionDPO的方法,它是基于最近开发出的直接偏好优化(DPO)的变体。

DPO是一种相对于RLHF的简化方法,它直接优化一个策略来最好地满足人类偏好,而不是通过训练一个奖励函数来表示人类偏好。DiffusionDPO通过以下几个步骤实现:

重新制定DPO:作者将DPO重新制定为考虑扩散模型似然性的形式,使用证据下界(ELBO)来推导出一个可微分的目标函数。

利用人群源数据集:使用Picka-Pic数据集中的851K个人群源成对偏好,对最先进的Stable Diffusion XL(SDXL)-1.0模型的基础模型进行微调。

直接优化:通过直接在人类比较数据上优化,而不是通过传统的监督微调或强化学习方法。

变分和AI反馈:开发了一个使用AI反馈的变体,其性能与基于人类偏好的训练相当,为扩散模型对齐方法的扩展打开了大门。

DiffusionDPO通过这些方法,显著提高了视觉吸引力和提示对齐,超越了基础SDXL-1.0模型和包含额外细化模型的更大SDXL-1.0模型。此外,该方法还展示了从AI反馈中学习的有效性,这是以前工作未能成功的领域。总的来说,本文引入了一种从人类偏好中学习的新范式,并展示了由此产生的最新模型。

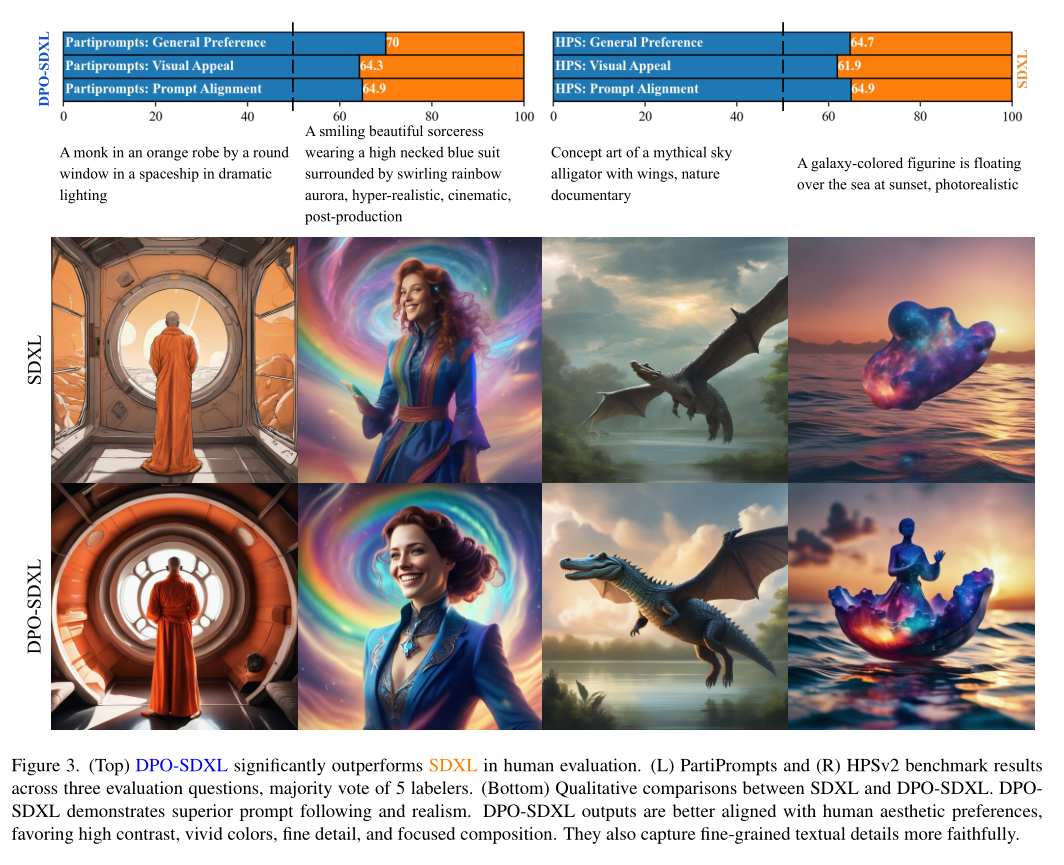

论文实验:

根据Figure 3的内容,本文的实验部分主要关注了Diffusion-DPO(DPO-SDXL)模型与基线模型(SDXL)在人类评估中的性能比较。在PartiPrompts评估中,DPO-SDXL在General Preference(Q1)、Visual Appeal(Q2)和Prompt Alignment(Q3)中被偏好的比例分别为70.0%、相似比例和相似比例。在HPSv2基准测试中,DPO-SDXL在General Preference(Q1)中的获胜率为64.7%。

论文链接:

https://arxiv.org/abs/2311.12908