AI服务器核心部件产业链升级分析

AI服务器核心部件产业链剖析(2024)

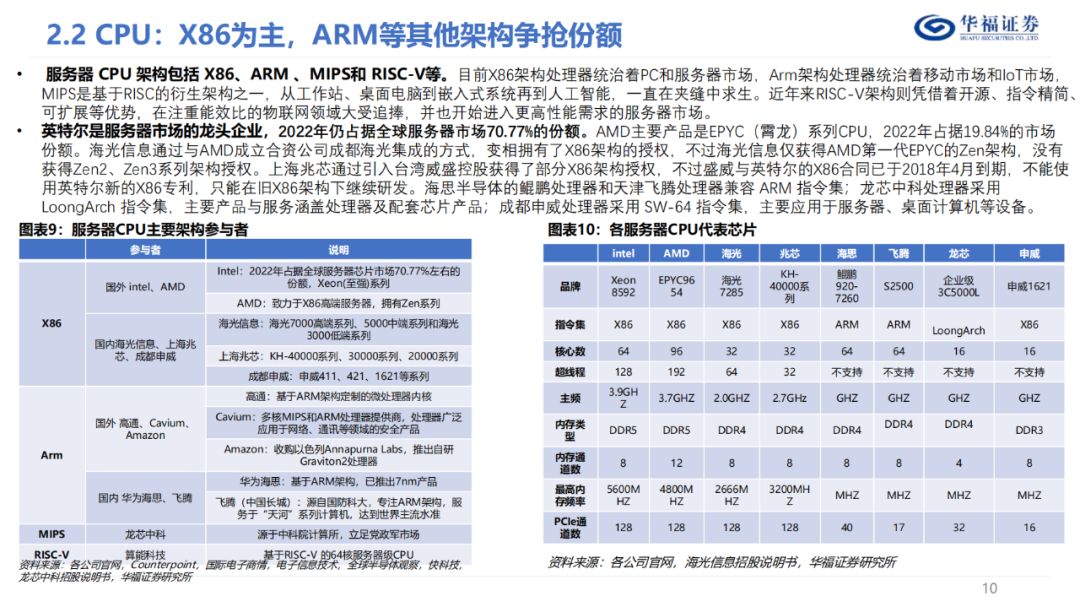

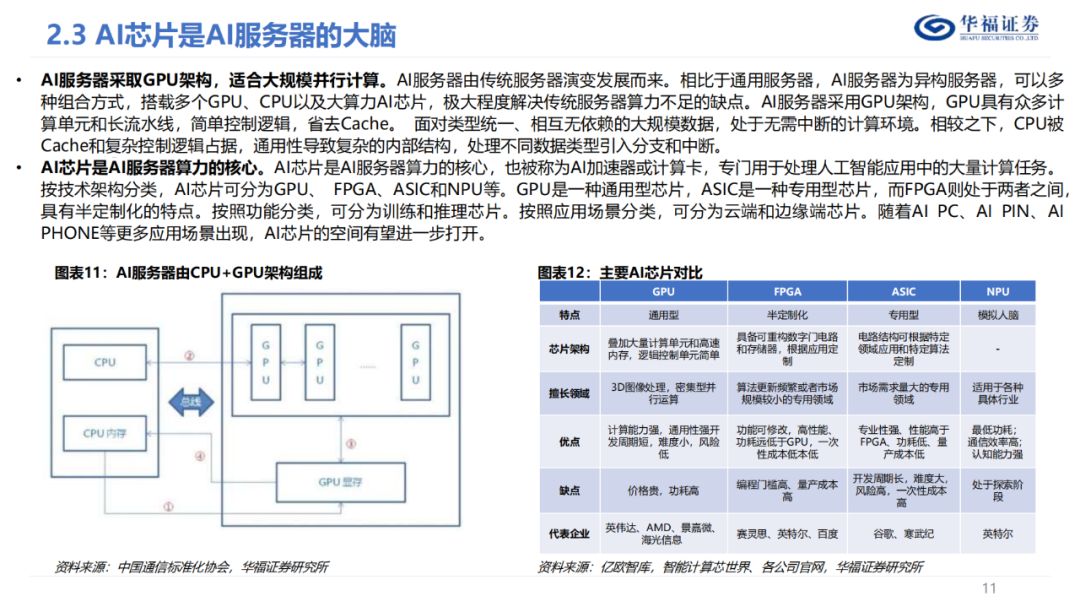

"本文探讨了AI服务器的产业链,涵盖了芯片CPU、GPU,内存DRAM和HBM,本地存储SSD,NIC、PCIe插槽、散热等关键元素。同时,对服务器CPU架构进行了深度剖析,包括X86、ARM、MIPS和RISC-V等主流技术。这些技术的发展与创新,将引领AI服务器行业在2024年的启航阶段,展现出无限的可能与活力。"

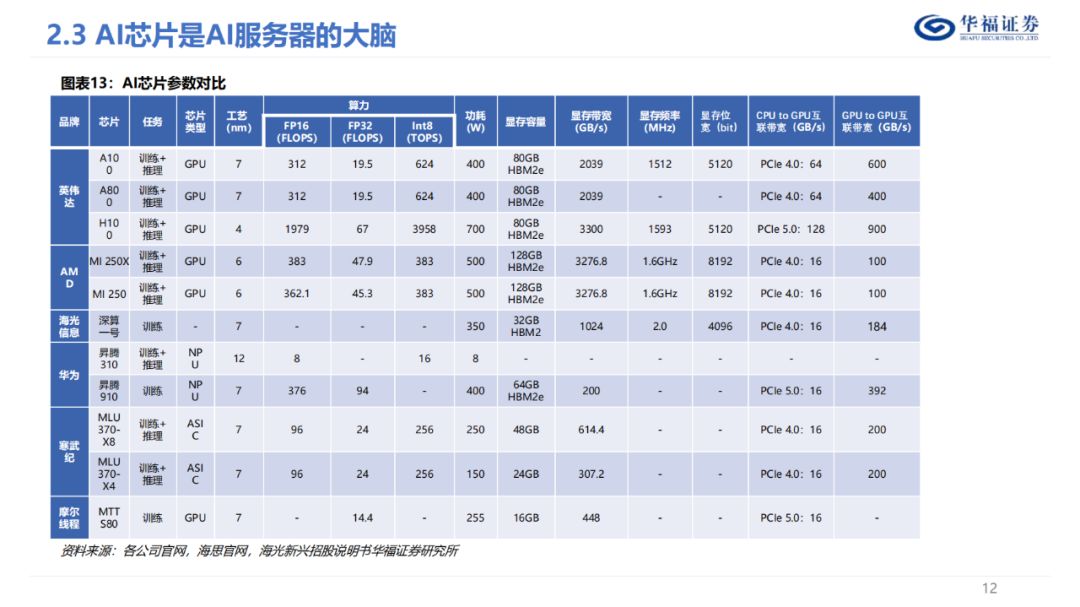

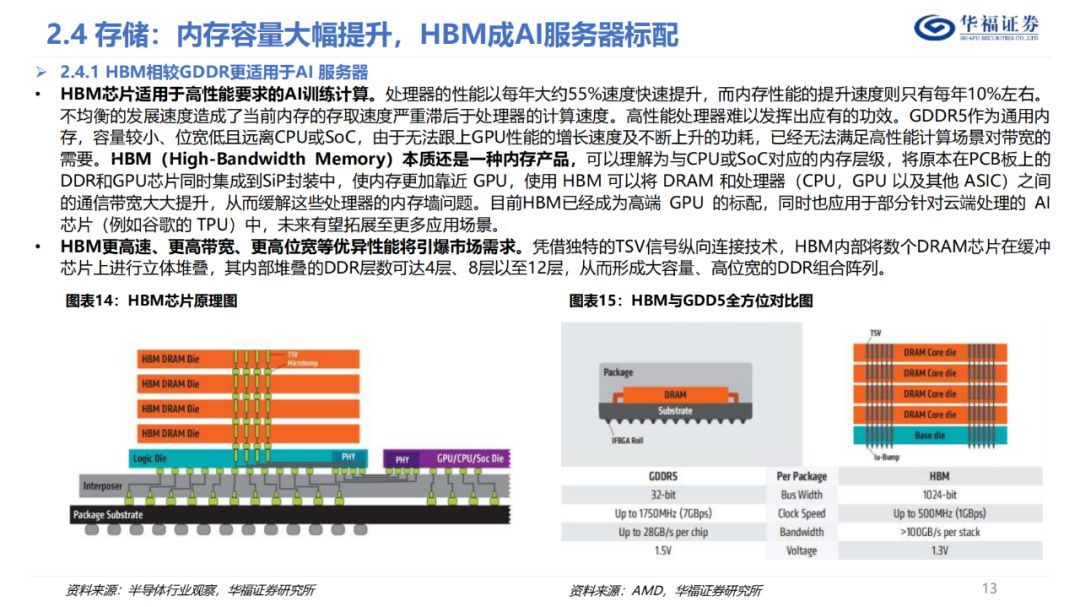

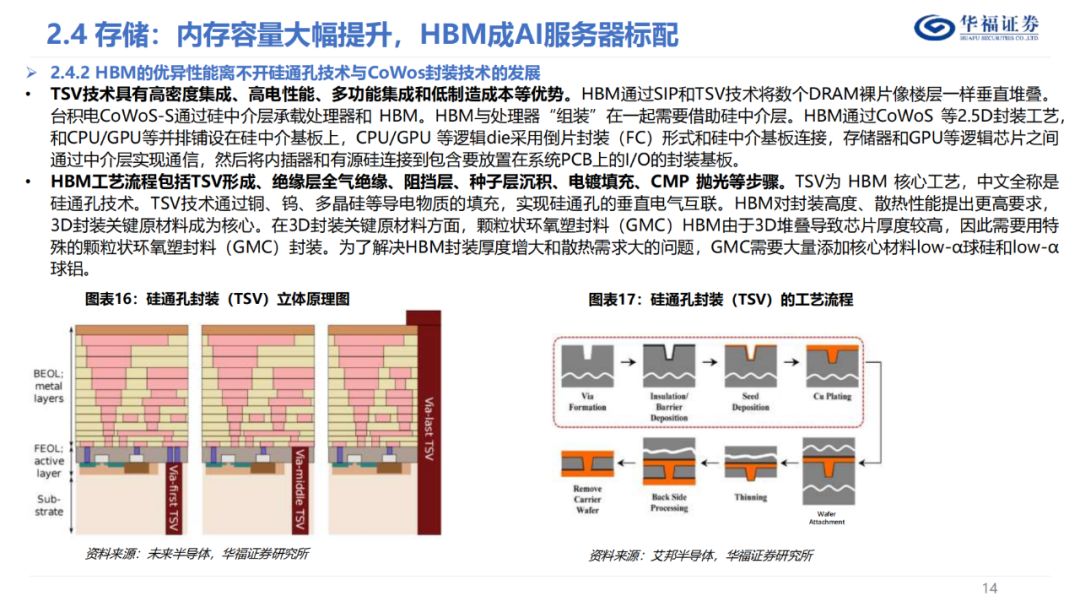

Al芯片是AI服务器算力的核心,专门用于处理人工智能应用中的大量计算任务。HBM作为内存产品的一种,已经成为高端GPU标配,可以理解为与CPU或SoC对应的内存层级,将原本在PCB板上的DDR和GPU芯片同时集成到SiP封装中,使内存更加靠近GPU,使用HBM可以将DRAM和处理器(CPU,GPU以及其他ASIC)之间的通信带宽大大提升,从而缓解这些处理器的内存墙问题 。

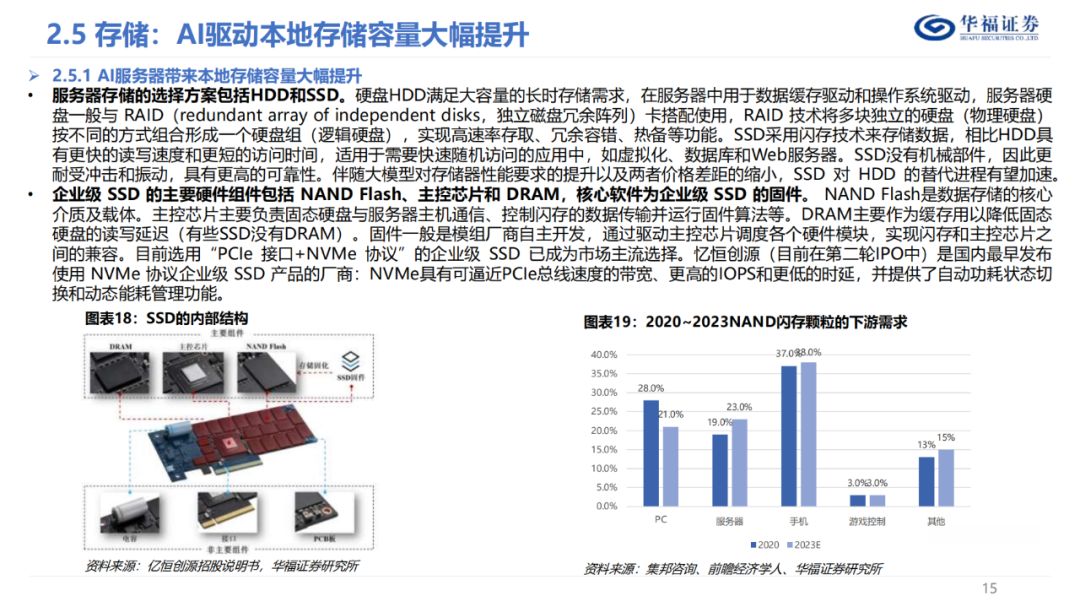

在服务器本地存储选择中,HDD与SSD成为两大主流。SSD,包括NAND Flash、主控芯片和DRAM等关键组件,搭配企业级固件,打造出具备处理、缓存、计算、安全保护功能的数据中心级SSD。这意味着,SSD正逐步摆脱传统硬盘的局限,其市场渗透率有望持续攀升。

-对此,您有什么看法见解?-

-欢迎在评论区留言探讨和分享。-