linux本地部署deepseek-R1模型

国产开源大模型追平甚至超越了CloseAI的o1模型,大国崛起时刻!!!

DeepSeek R1 本地部署指南

在人工智能技术飞速发展的今天,本地部署AI模型成为越来越多开发者和企业关注的焦点。本文将详细介绍如何在本地部署DeepSeek R1,同时涵盖Ollama和Chatbox AI的安装与配置。通过这些步骤,你可以在本地环境中高效地运行和使用这些强大的AI工具。

一、DeepSeek简介

DeepSeek是一个专注于人工智能研究与应用的平台,致力于提供高效、灵活且易于部署的AI解决方案。DeepSeek R1是其最新版本,支持多种AI模型的本地部署,能够满足不同场景下的需求。https://www.deepseek.com/它具备以下特点:

1. 轻量级:模型经过优化,适合在资源有限的设备上运行。

2. 高效推理:能够在低延迟下进行实时推理。

3. 可扩展性:支持自定义训练和微调,满足不同场景需求。

二、Ollama简介与安装

Ollama是一个开源的AI模型管理工具,用于简化AI模型的部署和管理。它支持多种模型格式,能够与DeepSeek R1无缝集成。以下是Ollama的安装步骤:

1. 下载Ollama:访问Ollama的官方网站或GitHub页面,下载最新版本的安装包:https://ollama.com/download

2. 安装Ollama:

(1)对于Windows系统,双击安装包并按照提示完成安装。

(2)对于Linux系统,使用以下命令安装:

curl -fsSL https://ollama.com/install.sh | sh

3. 启动Ollama服务:安装完成后,运行以下命令查看是否安装成功:

ollama -v

4. 验证安装:打开浏览器,访问http://localhost:11434,如果页面显示Ollama的界面,则说明安装成功。

进入ollama的模型库,选择deepseek-r1,就能够看到里面的各种安装命令了,可以选择不同大小的模型进行本地部署,但也是需要与自己电脑的配置相适应,否则GPU容易出问题

如果使用 4-bit 量化,显存需求:1.5B:约 1 GB; 7B:约 4 GB ;8B:约 4.5 GB; 14B:约 8 GB; 32B:约 18 GB; 70B:约 40 GB

使用对应的命令安装deepseek模型:

ollama run deepseek-r1:7b

Chatbox AI是一个基于对话的AI平台,能够实现自然语言交互。它支持多种语言和场景,可以与Ollama和DeepSeek R1配合使用,提供更丰富的交互体验。以下是Chatbox AI的安装步骤:

1. 下载Chatbox AI:访问Chatbox AI的官方网站,下载最新版本的安装包: https://chatboxai.app/zh

2. 安装Chatbox AI:

(1)对于Windows系统,解压下载的文件,并运行安装程序。

(2)对于Linux系统,使用以下命令运行:

sudo ./Chatbox-1.9.5-x86_64.AppImage

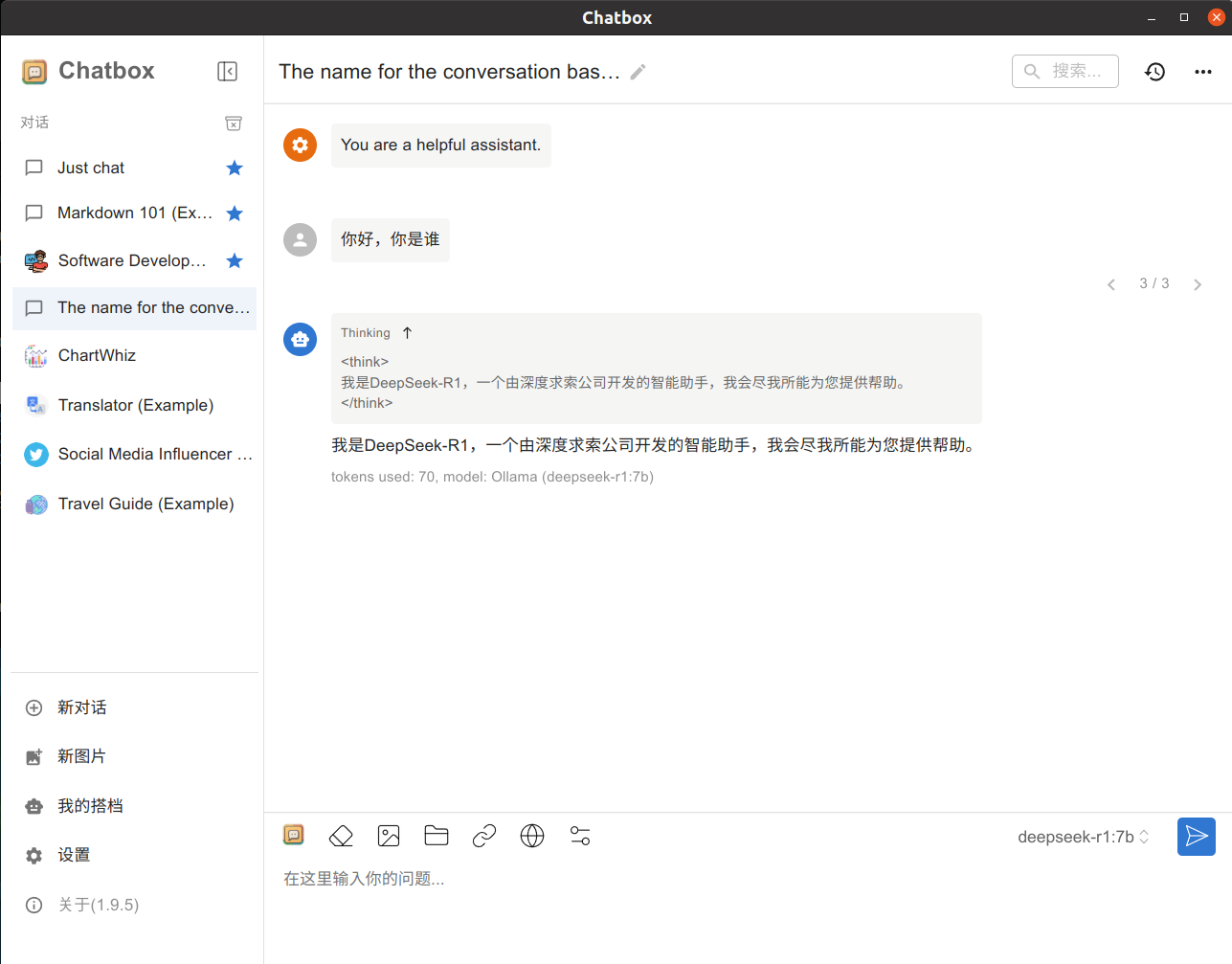

3. 配置Chatbox AI:打开配置文件config.json或者直接打开ui,根据需要修改参数,例如连接Ollama的地址等。进入软件后点击设置,然后选择ollama的api,加载之前下载的模型即可。

4. 测试模型:与部署后的模型进行对话:

注意:除了chatbox可以进行UI可视化之外,还可以用浏览器插件来实现,我们只需要安装一下page assist插件

page assis链接

安装到浏览器后直接打开即可自动链接已经下载的模型:

四、总结

通过上述步骤,你可以在本地成功部署DeepSeek R1,并安装Ollama和Chatbox AI。这些工具的结合将为你的AI项目提供强大的支持,无论是模型训练、推理还是交互式应用,都能轻松实现。希望本文对你有所帮助,祝你在AI开发的道路上越走越远!

2. 模型信息后记

DeepSeek-R1

模型 #总参数 #已激活参数 上下文长度

DeepSeek-R1-Zero 671B 37B 128千

DeepSeek-R1 671B 37B 128千

DeepSeek-R1-Zero 和 DeepSeek-R1 基于 DeepSeek-V3-Base 进行训练。有关模型架构的更多详细信息,请参阅DeepSeek-V3存储库。

DeepSeek-R1-Distill 模型

模型 基础模型

DeepSeek-R1-Distill-Qwen-1.5B Qwen2.5-Math-1.5B

DeepSeek-R1-Distill-Qwen-7B Qwen2.5-Math-7B

DeepSeek-R1-Distill-Llama-8B Llama-3.1-8B

DeepSeek-R1-Distill-Qwen-14B Qwen2.5-14B

DeepSeek-R1-Distill-Qwen-32B Qwen2.5-32B

DeepSeek-R1-Distill-Llama-70B Llama-3.3-70B-Instruct

DeepSeek-R1-Distill 模型基于开源模型进行了微调,使用了 DeepSeek-R1 生成的样本。deepseek对其配置和分词器进行了轻微更改。请使用deepseek的设置来运行这些模型。