【Ai】DeepSeek本地部署+Page Assist图形界面

准备工作

1、ollama,用于部署各种开源模型,并开放接口的程序

https://ollama.com/download

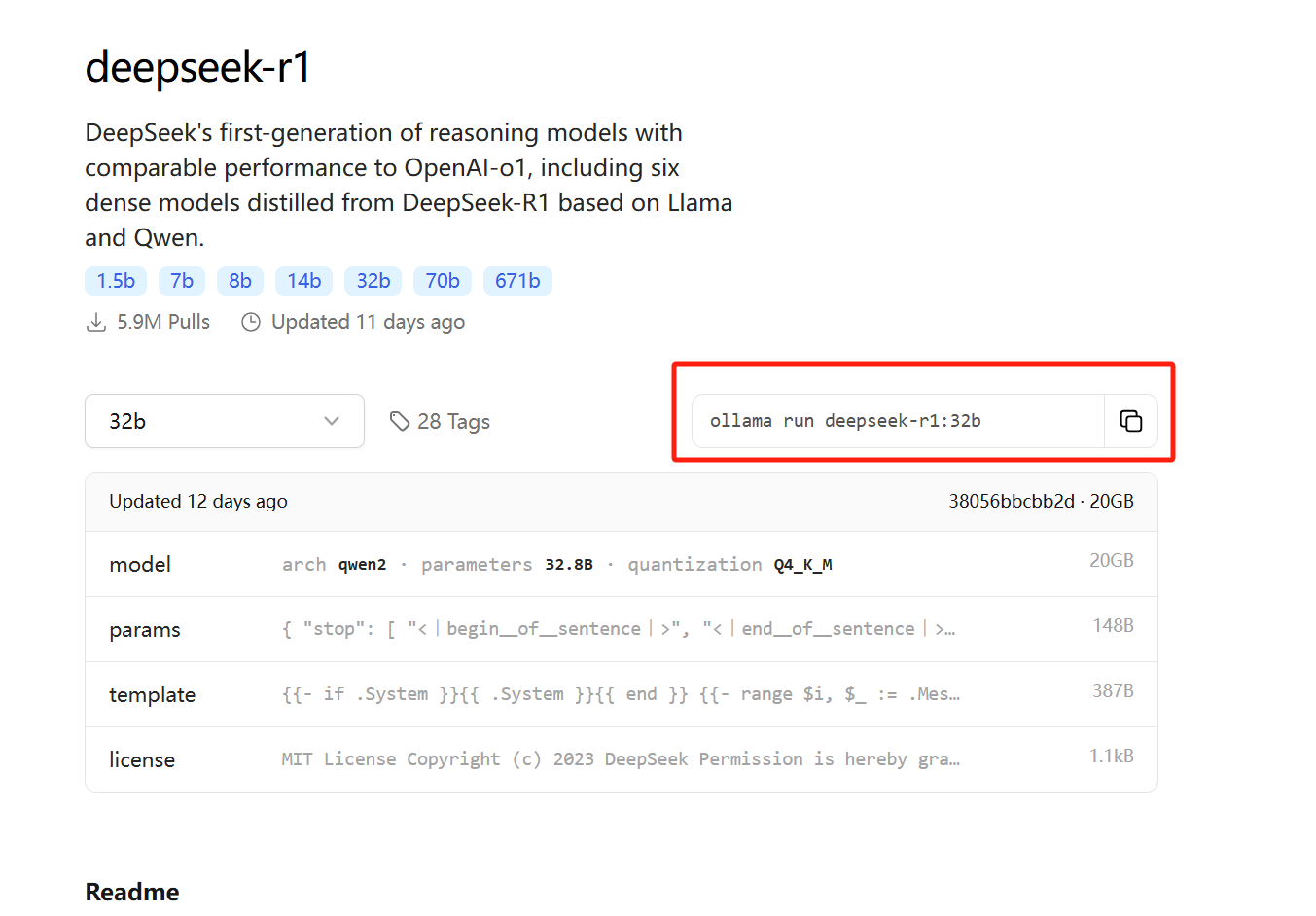

2、deepseek-r1:32b 模型

https://ollama.com/library/deepseek-r1:32b

不同的模型版本对计算机性能的要求不一样,版本越高对显卡和内存的要求越高,大致如下

- 7b:32GB内存,8GB显存

- 32b:128GB内存,24GB显存

3、Page Assist,浏览器插件,用于可视化的模型对话,特点是可接入联网搜索,并且很方便能配合嵌入模型

Firefox商店链接: Page Assist - Firefox Add-ons

安装完成后,可以通过以下方式打开Page Assist:

- 侧边栏:使用快捷键Ctrl+Shift+P

- Web UI:点击扩展图标,或使用快捷键Ctrl+Shift+L

首次使用需要配置本地AI模型,目前支持Ollama和Chrome AI (Gemini Nano)

下载安装

安装ollama

直接下载安装即可

配置环境变量

注意,配置完成后,要重启ollama

打开powershell命令窗口

1、模型存储目录

setx OLLAMA_MODELS D:\soft\ai\model

2、设置ollama服务启动配置

setx OLLAMA_HOST 0.0.0.0

setx OLLAMA_ORIGINS extension://*

安装DeepSeek模型

打开 https://ollama.com/search 第一个就是

复制执行命令,在powershell中运行即可,比如

ollama run deepseek-r1:32b

或

ollama run deepseek-r1:8b

安装模型需要等一段时间

经过数个小时的等待,终于完成了,使用命令提问试试

同时安装deepseek-r1:8b测试体验

GPU加速

模型启动默认使用CPU推理,速度较慢;可以配置使用GPU加速。

编辑文件(如果没有就创建一个)~/.ollama/config.json

{

"gpu": true,

"cuda": true

}

重启ollama服务,终止线程,然后使用命令启动ollama serve,可以看日志是否使用GPU

运行模型后,使用 nvidia-smi 命令查看 GPU 占用

接入 Page Assist

用Firefox打开 https://addons.mozilla.org/en-US/firefox/addon/page-assist/ 安装插件,安装完成后,打开设置,可以配置ollama地址,截图示例是默认地址,正常是直接连上的。

使用web页面提问,还可以联网搜索

使用deepseek-r1:8b测试体验,速度快很多

添加嵌入模型,ollama pull nomic-embed-text,然后在插件里RAG设置中选择嵌入模型即可

总结

我的电脑配置(12代i7cpu,40G内存,3060显卡6G显存)勉强能跑,不过提问回复很慢,效果很差。换8b的模型快了很多。

可能是模型级别太低的原因,本地模型使用效果一直不理想,问一些历史问题错误很多。