深度模型部署工具优劣学习总结

记录一下模型部署时调研的一些笔记

1. OpenVINO优势:

高性能:OpenVINO提供了一系列的性能优化工具,如模型量化和剪枝等,可以在Intel硬件平台上实现高性能和低延迟的推理。

多平台支持:OpenVINO支持多种Intel硬件平台,包括CPU、GPU和FPGA等,可以在不同的硬件平台上进行优化和部署。

多框架支持:OpenVINO支持多种流行的深度学习框架,如TensorFlow、PyTorch和Caffe等,可以方便地将已有的模型集成到OpenVINO中。

简化部署:OpenVINO提供了一系列的工具和API,可以简化模型的部署和集成,使得开发者可以更快速地将模型部署到生产环境中。

预训练模型:OpenVINO提供了一系列的预训练模型,可以直接使用这些模型进行推理,也可以在这些模型的基础上进行微调和优化。

灵活性:OpenVINO提供了灵活的部署选项,可以将模型部署到本地设备、云端或边缘设备上,以满足不同的应用场景需求。

可扩展性:OpenVINO支持分布式推理,可以将模型部署到多个设备上进行并行推理,以提高推理速度和吞吐量。

易用性:OpenVINO提供了易于使用的API和工具,可以帮助开发者快速上手,快速构建和部署深度学习模型。

开源:OpenVINO是一个开源工具包,可以免费使用和修改,开发者可以根据自己的需求进行二次开发和定制。

支持多种操作系统:OpenVINO支持多种操作系统,包括Windows、Linux和macOS等,可以在不同的操作系统上进行开发和部署。

支持多种语言:OpenVINO支持多种编程语言,包括C++、Python和Java等,可以方便地与不同的应用程序进行集成。

安全性:OpenVINO提供了安全性功能,如模型加密和安全推理等,可以保护模型和数据的安全性。

可视化工具:OpenVINO提供了可视化工具,如模型优化器和推理引擎等,可以帮助开发者更好地理解和优化模型。

社区支持:OpenVINO有一个活跃的社区,开发者可以在社区中获取支持和帮助,也可以分享自己的经验和成果。

适用范围广:OpenVINO适用于多种应用场景,如图像识别、目标检测、人脸识别、自然语言处理等,可以满足不同领域的需求。

2. onnx优势

ONNX(Open Neural Network Exchange)是一种开放的深度学习模型交换格式,它具有以下优势:

跨平台支持:ONNX可以在不同的深度学习框架之间进行模型转换和交换,使得模型可以在不同的平台上进行部署和推理。

高效性:ONNX模型可以在不同的硬件平台上进行优化和部署,以实现高效的推理和低延迟。

灵活性:ONNX支持多种深度学习框架,如PyTorch、TensorFlow和Caffe等,可以方便地将已有的模型转换为ONNX格式。

易用性:ONNX提供了易于使用的API和工具,可以帮助开发者快速上手,快速构建和部署深度学习模型。

开源:ONNX是一个开源的深度学习模型交换格式,可以免费使用和修改,开发者可以根据自己的需求进行二次开发和定制。

可扩展性:ONNX支持分布式推理,可以将模型部署到多个设备上进行并行推理,以提高推理速度和吞吐量。

可视化工具:ONNX提供了可视化工具,如ONNX Runtime和Netron等,可以帮助开发者更好地理解和优化模型。

社区支持:ONNX有一个活跃的社区,开发者可以在社区中获取支持和帮助,也可以分享自己的经验和成果。

适用范围广:ONNX适用于多种应用场景,如图像识别、目标检测、人脸识别、自然语言处理等,可以满足不同领域的需求。

模型可移植性:ONNX模型可以在不同的平台和设备上进行部署和推理,使得模型具有更好的可移植性和可重用性。

模型优化:ONNX提供了一系列的模型优化工具,如模型压缩和量化等,可以帮助开发者优化模型的大小和性能。

模型更新:ONNX模型可以通过增量学习和迁移学习等技术进行更新和优化,以适应不断变化的应用场景需求。

模型共享:ONNX模型可以通过云端服务和模型市场等方式进行共享和交换,以促进模型的共享和合作。

模型保护:ONNX提供了模型加密和安全推理等功能,可以保护模型和数据的安全性。

模型可解释性:ONNX模型可以通过可视化工具和解释性技术等方式进行解释和分析,以帮助开发者更好地理解和优化模型。

模型转换:ONNX可以将不同深度学习框架的模型转换为ONNX格式,使得模型可以在不同的框架之间进行转换和交换。

模型集成:ONNX可以将多个模型集成为一个模型,以实现更复杂的任务和应用场景。

模型调试:ONNX提供了模型调试工具,如ONNX Runtime和Netron等,可以帮助开发者调试和优化模型。

模型部署:ONNX可以将模型部署到不同的平台和设备上,如CPU、GPU、FPGA和边缘设备等,以满足不同的应用场景需求。

模型监控:ONNX提供了模型监控工具,可以帮助开发者监控模型的性能和运行状态,以及及时发现和解决问题。

模型迁移:ONNX可以将模型从一个平台或设备迁移到另一个平台或设备,以适应不同的应用场景需求。

模型可重用性:ONNX模型可以在不同的应用场景中进行重用,以提高模型的效率和可靠性。

模型自动化:ONNX可以与自动化工具和流程集成,以实现模型的自动化构建、部署和管理。

模型标准化:ONNX是一个开放的标准化格式,可以促进深度学习模型的标准化和共享,以推动深度学习技术的发展和应用。

模型可扩展性:ONNX可以与其他技术和工具集成,如自然语言处理、计算机视觉和增强学习等,以实现更复杂的任务和应用场景。

ONNX Runtime是一个高性能、跨平台的推理引擎,可以加速ONNX模型的推理。它可以通过以下方式对ONNX模型进行加速:

硬件加速:ONNX Runtime可以利用硬件加速器,如GPU、FPGA和ASIC等,以提高模型的推理速度和吞吐量。

自动优化:ONNX Runtime可以自动优化模型,如自动选择最优算法、自动调整线程数和内存分配等,以提高模型的性能和效率。

异步推理:ONNX Runtime可以实现异步推理,即在推理过程中同时进行数据加载和预处理等操作,以提高推理效率。

模型压缩:ONNX Runtime可以对模型进行压缩,如权重剪枝、量化和分解等,以减小模型的大小和提高推理速度。

网络优化:ONNX Runtime可以对网络进行优化,如层融合、层拆分和层重排等,以减小网络的复杂度和提高推理速度。

并行推理:ONNX Runtime可以实现并行推理,即将模型分成多个部分进行并行计算,以提高推理速度和吞吐量。

缓存机制:ONNX Runtime可以利用缓存机制,将模型和数据缓存到内存中,以减少数据加载和预处理等操作,提高推理效率。

综上所述,ONNX Runtime可以通过多种方式对ONNX模型进行加速,以提高模型的推理速度和效率。

3. ONNX Runtime与OpenVINO各自优势

ONNX Runtime和OpenVINO都是用于深度学习模型推理的工具,它们各自有不同的优势:

ONNX Runtime的优势:

跨平台支持:ONNX Runtime支持多种操作系统和硬件平台,如Windows、Linux、MacOS、Android、iOS、ARM和x86等。

多框架支持:ONNX Runtime支持多种深度学习框架,如PyTorch、TensorFlow和Caffe等。

高性能:ONNX Runtime具有高性能的推理引擎,可以利用硬件加速器、自动优化和并行推理等技术,以提高模型的推理速度和效率。

易用性:ONNX Runtime提供了易于使用的API和工具,可以帮助开发者快速上手,快速构建和部署深度学习模型。

开源:ONNX Runtime是一个开源的深度学习模型推理引擎,可以免费使用和修改,开发者可以根据自己的需求进行二次开发和定制。

OpenVINO的优势:

针对Intel平台优化:OpenVINO是Intel推出的深度学习推理引擎,针对Intel平台进行了优化,可以充分利用Intel CPU、GPU、VPU和FPGA等硬件加速器,以提高模型的推理速度和效率。

支持多种模型格式:OpenVINO支持多种深度学习模型格式,如TensorFlow、Caffe、MXNet和ONNX等。

支持多种操作系统:OpenVINO支持多种操作系统,如Windows、Linux和MacOS等。

支持多种编程语言:OpenVINO支持多种编程语言,如C++、Python和Java等。

支持多种应用场景:OpenVINO支持多种应用场景,如图像识别、目标检测、人脸识别和自然语言处理等。

综上所述,ONNX Runtime和OpenVINO各自有不同的优势,开发者可以根据自己的需求选择适合自己的工具。如果需要跨平台支持和多框架支持,可以选择ONNX Runtime;如果需要针对Intel平台进行优化和支持多种硬件加速器,可以选择OpenVINO。

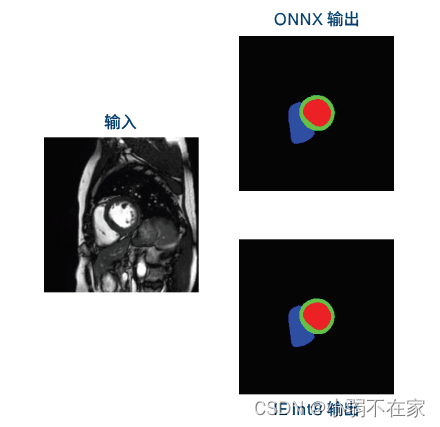

4.针对量化后的模型效果丢失问题,模型量化过程中会裁剪掉一些参数。会导致分割细节明显丢失,但在接受范围之内。不只是自己的模型量化后效果才丢失,其他人的也一样:如下图所示: