MySQL集群高可用架构之MMM

目录

一、MMM概述

1.1 MMM 简介

1.2 MMM高可用架构

1.3 MMM工作原理

1.4 工作流程图

二、MMM高可用双主双从架构部署

1、架构:

2、搭建 MySQL 多主多从模式

3、安装配置 MySQL-MMM

4、故障测试

一、MMM概述

1.1 MMM 简介

MMM(Master-Master replication manager for MvSQL,MySQL主主复制管理器)是一套支持双主故障切换和双主日常管理的脚本程序。

MMM 使用 Perl 语言开发,主要用来监控和管理 MySQL Master-Master (双主)复制,虽然叫做双主复制,但是业务上同一时刻只允许对一个主进行写入,另一台备选主上提供部分读服务,以加速在主主切换时备选主的预热,可以说MMM这套脚本程序一方面实现了故障切换的功能,另一方面其内部附加的工具脚本也可以实现多个 Slave 的 read 负载均衡。

MMM提供了自动和手动两种方式移除一组服务器中复制延迟较高的服务器的虚拟ip,同时它还可以备份数据,实现两节点之间的数据同步等。

由于MMM无法完全保证数据的一致性,所以MMM适用于对数据的一致性要求不是很高,但是又想最大程度地保证业务可用性的场景。

MMM是一套灵活的脚本程序,基于perl实现,用来对 mysql replication 进行监控和故障迁移,并能管理 MySQL Master-Master 复制的配置。

1.2 MMM高可用架构

关于 MMM 高可用架构的说明如下:

●mmm_mon:监控进程,负责所有的监控工作,决定和处理所有节点角色活动。此脚本需要在监控主机上运行。

●mmm_agent:运行在每个MySQL服务器上的代理进程,完成监控的探针工作和执行简单的远端服务设置。此脚本需要在被监管机上运行。

●mmm_control:一个简单的脚本,提供管理 mmm_mon 进程的命令。

●mysql-mmm 的监管端会提供多个虚拟 IP(VIP),包括一个可写 VIP,多个可读 VIP,通过监管的管理,这些 IP 会绑定在可用 MySQL 之上,当某一台 MySQL 宕机时,监管会将 VIP 迁移至其他 MySQL。

在整个监管过程中,需要在 MySQL 中添加相关授权用户,以便让 MySQL 可以支持监控主机的维护。 授权的用户包括一个 mmm_monitor 用户和一个 mmm_agent 用户。

1.3 MMM工作原理

1)MMM 通过监控 MySQL master的状态来实现故障检测和自动故障转移。当一个master主节点发生故障时,MMM 会自动将VIP转到备master节点上,确保数据库的可用性。

2)MMM 还可以根据负载情况自动进行负载均衡。它可以根据每个节点的负载情况,将读操作分发到不同的节点上,从而提高系统的整体性能。

3)MMM 还提供了一些管理工具,可以方便地进行节点的添加、删除和配置修改等操作。

1.4 MMM故障切换流程

Monitor 检测到 Master1 连接失败

Monitor 发送 set_offline 指令到 Master1 的 Agent

Master1 Agent 如果存活,下线写 VIP,尝试把 Master1 设置为 read_only=1

Moniotr 发送 set_online 指令到 Master2

Master2 Agent 接收到指令,执行 select master_pos_wait() 等待同步完毕

Master2 Agent 上线写 VIP,把 Master2 节点设为 read_only=0

Monitor 发送更改同步对象的指令到各个 Slave 节点的 Agent

各个 Slave 节点向新 Master 同步数据

1.4 工作流程图

二、MMM高可用双主双从架构部署

1、架构:

master1 20.0.0.31

master2 20.0.0.32

slave1 20.0.0.33

slave2 20.0.0.34

mariadb 20.0.0.26

关闭防火墙和安全机制

systemctl stop firewalld

setenforce 0

2、搭建 MySQL 多主多从模式

//修改 master01 配置文件

vim /etc/my.cnf

......

[mysqld]

user = mysql

basedir = /usr/local/mysql

datadir = /usr/local/mysql/data

port = 3306

character_set_server=utf8

pid-file = /usr/local/mysql/mysqld.pid

socket = /usr/local/mysql/mysql.sock

server-id = 1

log-error=/usr/local/mysql/data/mysql_error.log

general_log=ON

general_log_file=/usr/local/mysql/data/mysql_general.log

slow_query_log=ON

slow_query_log_file=mysql_slow_query.log

long_query_time=5

binlog-ignore-db=mysql,information_schema

log_bin=mysql_bin

log_slave_updates=true

sync_binlog=1

innodb_flush_log_at_trx_commit=1

auto_increment_increment=2

auto_increment_offset=1

//把配置文件复制到其它 3 台数据库服务器上并启动服务器,注意:配置文件中的 server_id 要修改

//配置主主复制,两台主服务器相互复制

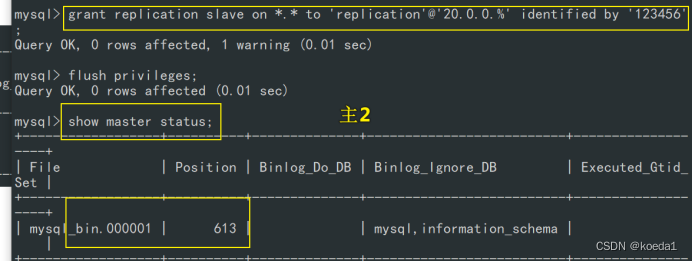

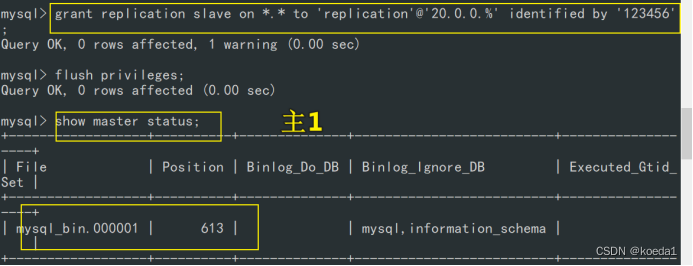

#在两台主服务器上都执行授予从的权限,从服务器上不需要执行

grant replication slave on *.* to 'replication'@'20.0.0.%' identified by '123456';

#在两台主服务器上查看,记录日志文件名称和同步点

show master status;

在 master01 上配置同步

change master to master_host='20.0.0.32',master_user='replication',master_password='123456',master_log_file='mysql_bin.000001',master_log_pos=613;

start slave;

show slave status\G

Slave_IO_Running: Yes

Slave_SQL_Running: Yes

#在 master02 上配置同步

change master to master_host='20.0.0.32',master_user='replication',master_password='123456',master_log_file='mysql_bin.000001',master_log_pos=758;

start slave;

show slave status\G

Slave_IO_Running: Yes

Slave_SQL_Running: Yes

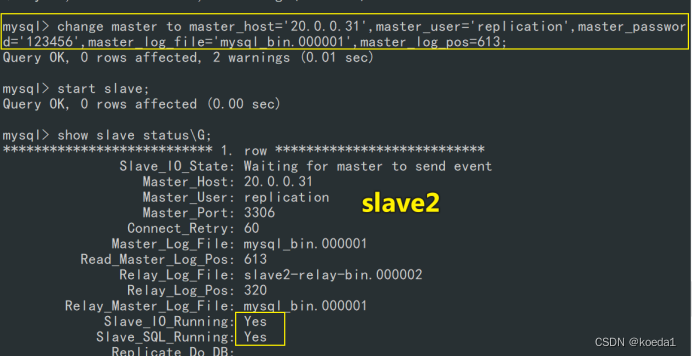

配置主从复制,在两台从服务器上做

change master to master_host='20.0.0.31',master_user='replication',master_password='123456',master_log_file='mysql_bin.000001',master_log_pos=758;

start slave;

show slave status\G

Slave_IO_Running: Yes

Slave_SQL_Running: Yes

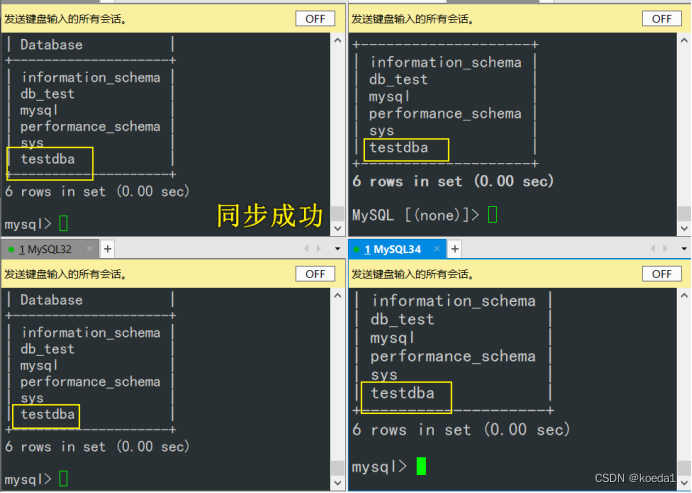

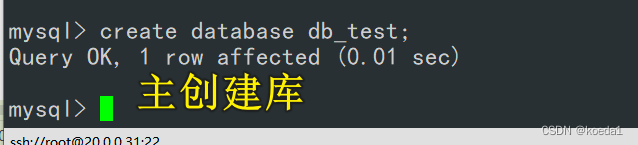

//测试主主、主从 同步情况

create database db_test;

3、安装配置 MySQL-MMM

//在所有服务器上安装 MySQL-MMM

wget -O /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-7.repo

yum -y install epel-release

yum -y install mysql-mmm*

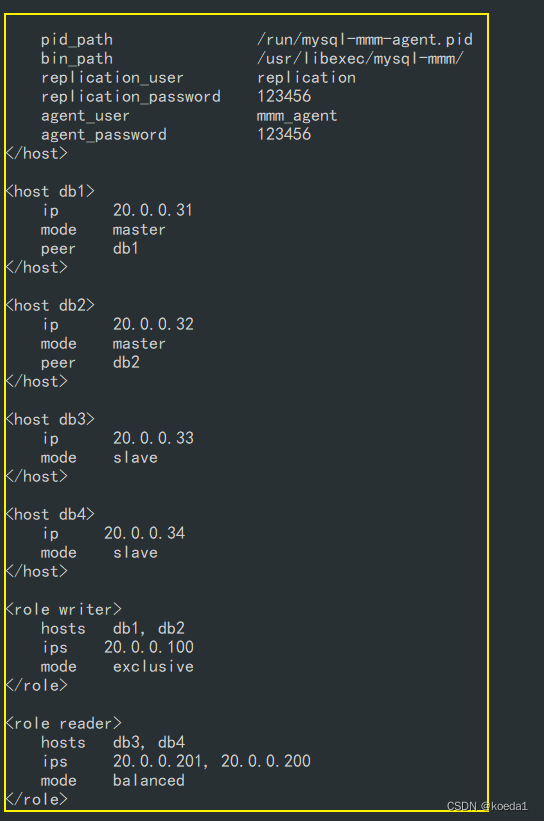

//在 所有主机 上对 MySQL-MMM 进行配置

cd /etc/mysql-mmm/

vim mmm_common.conf

……

<host default>

cluster_interface ens33

……

replication_user replication

replication_password 123456

agent_user mmm_agent

agent_password 123456

<host db1>

ip 20.0.0.31

mode master

peer db2

</host>

<host db2>

ip 20.0.0.32

mode master

peer db1

</host>

<host db3>

ip 20.0.0.33

mode slave

</host>

<host db4>

ip 20.0.0.34

mode slave

</host>

<role writer>

hosts db1, db2

ips 20.0.0.100

mode exclusive

</role>

<role reader>

hosts db3, db4

ips 20.0.0.201, 20.0.0.200

mode balanced

</role>

其他几台配置文件一样

修改所有数据库服务器的代理配置文件 mmm_agent.conf

vim /etc/mysql-mmm/mmm_agent.conf

include mmm_common.conf

this db1 #根据不同的主机分别修改为 db1,db2,db3,db4

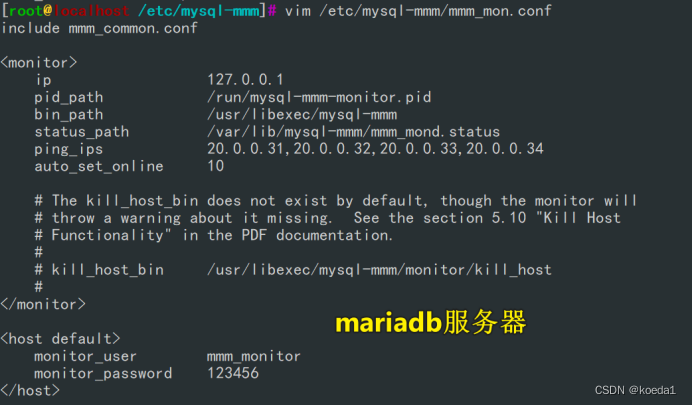

在 monitor 监控服务器上修改监控配置文件 mmm_mon.conf

先新开一个主机,安装mariadb

vim /etc/mysql-mmm/mmm_mon.conf

include mmm_common.conf

<monitor>

.....

ping_ips 20.0.0.31,20.0.0.32,20.0.0.33,20.0.0.34

auto_set_online 10

</monitor>

<host default>

monitor_user mmm_monitor

monitor_password 123456

</host>

在所有数据库上为 mmm_agent(代理进程)授权

grant super, replication client, process on *.* to 'mmm_agent'@'20.0.0.%' identified by '123456';

在所有数据库上为 mmm_moniter(监控进程)授权

grant replication client on *.* to 'mmm_monitor'@'20.0.0.%' identified by '123456';

flush privileges;

在所有数据库服务器上启动 mysql-mmm-agent

systemctl start mysql-mmm-agent.service

systemctl enable mysql-mmm-agent.service

//在 monitor 服务器上启动 mysql-mmm-monitor

systemctl start mysql-mmm-monitor.service

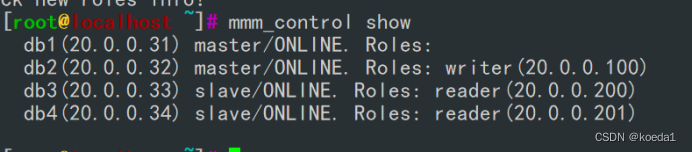

在 monitor 服务器上测试群集

#查看各节点的情况

mmm_control show

db1(192.168.80.20) master/ONLINE. Roles: writer(192.168.80.188)

db2(192.168.80.30) master/ONLINE. Roles:

db3(192.168.80.13) slave/ONLINE. Roles: reader(192.168.80.198)

db4(192.168.80.14) slave/ONLINE. Roles: reader(192.168.80.199)

检测监控功能是否都完善,需要各种OK

mmm_control checks all

#指定绑定 VIP 的主机

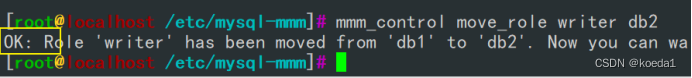

mmm_control move_role writer db2

4、故障测试

mmm_control move_role writer db1

#停止 master01 确认 VIP 是否移动到 master02 上。注意:master01 主服务器恢复服务后,不会抢占

mmm_control show

db1(192.168.80.20) master/HARD_OFFLINE. Roles:

db2(192.168.80.30) master/ONLINE. Roles: writer(192.168.80.188)

#停止一台从服务器,另一台将接管两个虚拟IP,以保证业务不停止

mmm_control show

客户端测试

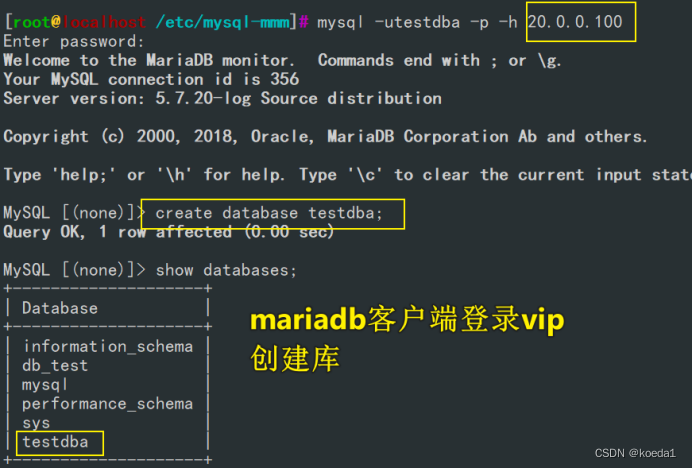

#在 master01 服务器上为 monitor 服务器地址授权登录

grant all on *.* to 'testdba'@'20.0.0.26' identified by '123456';

flush privileges;

#在 monitor 服务器上使用 VIP 登录

yum install -y mariadb-server mariadb

systemctl start mariadb.service

mysql -utestdba -p -h 192.168.235.188

#创建数据,测试同步情况

create database testdba;

看四个库是否同步: