手势识别4:C/C++实现手部检测和手势识别(含源码下载)

手势识别4:C/C++实现手部检测和手势识别(含源码下载)

目录

手势识别4:C/C++实现手部检测和手势识别(含源码下载)

1. 前言

2. 手势识别模型(YOLOv5)

(1)手势识别模型训练

(2)将Pytorch模型转换ONNX模型

(3)将ONNX模型转换为TNN模型

3. 手势识别模型C++部署

(1)项目结构

(2)配置开发环境(OpenCV+OpenCL+base-utils+TNN)

(3)部署TNN模型

(4)CMake配置

(5)main源码

(6)源码编译和运行

4. 手势识别检测效果

5. 项目源码下载

6. 手势识别Android版本

7.项目推荐:手部关键点检测

1. 前言

这是手势识别项目系列之《C/C++实现手部检测和手势识别》;本篇主要分享将Python训练后的YOLOv5的手势识别模型转写成C/C++代码。我们将开发一个简易的、可实时运行的手势识别C/C++ Demo,支持one,two,ok等18种常见的通用手势动作识别,也可以根据业务需求自定义训练的手势识别的类别。C/C ++版本手势识别模型推理支持CPU和GPU加速,在GPU(OpenCL)加速下,可以达到实时的检测效果,基本满足业务的性能需求。

先展示一下手势识别检测的效果:

|

|  |

【尊重原创,转载请注明出处】https://blog.csdn.net/guyuealian/article/details/134690422

更多手势识别,手部关键点检测的系列文章请参考:

- 手势识别1:HaGRID手势识别数据集使用说明和下载

- 手势识别2:基于YOLOv5的手势识别系统(含手势识别数据集+训练代码)

- 手势识别3:Android实现手部检测和手势识别(可实时运行,含Android源码)

- 手势识别4:C/C++实现手部检测和手势识别(含源码下载)

- 手部关键点检测1:手部关键点(手部姿势估计)数据集(含下载链接)

- 手部关键点检测2:YOLOv5实现手部检测(含训练代码和数据集)

- 手部关键点检测3:Pytorch实现手部关键点检测(手部姿势估计)含训练代码和数据集

- 手部关键点检测4:Android实现手部关键点检测(手部姿势估计)含源码 可实时检测

- 手部关键点检测5:C++实现手部关键点检测(手部姿势估计)含源码 可实时检测

2. 手势识别模型(YOLOv5)

(1)手势识别模型训练

考虑到手机端CPU/GPU性能比较弱鸡,直接部署yolov5s运行速度十分慢,所以这里Android部署仅仅考虑yolov5s05模型,yolov5s05即是在yolov5s的基础上做了模型轻量化处理,其channels通道数全部都减少一半,并且模型输入由原来的640×640降低到320×320。从性能来看,yolov5s05比yolov5s快5多倍,而mAP下降了5%(0.87605→0.82706),对于手机端,这精度还是可以接受。

官方YOLOv5: GitHub - ultralytics/yolov5: YOLOv5 🚀 in PyTorch > ONNX > CoreML > TFLite

下面是yolov5s05和yolov5s的参数量和计算量对比:

| 模型 | input-size | params(M) | GFLOPs | 手势识别mAP(0.5:0.95) |

| yolov5s | 640×640 | 7.2 | 16.5 | 0.87605 |

| yolov5s05 | 320×320 | 1.7 | 1.1 | 0.82706 |

yolov5s05和yolov5s训练过程完全一直,仅仅是配置文件不一样而已;碍于篇幅,本篇博客不在赘述,详细训练过程请参考:《基于YOLOv5的手势识别系统(含手势识别数据集+训练代码)》

(2)将Pytorch模型转换ONNX模型

训练好yolov5s模型后,你需要先将Pytorch模型转换为ONNX模型,并使用onnx-simplifier简化网络结构,Python版本的已经提供了ONNX转换脚本,终端输入命令如下:

# 转换yolov5s05模型

python export.py --weights "data/model/yolov5s05_320/weights/best.pt" --img-size 320 320

# 转换yolov5s模型

python export.py --weights "data/model/yolov5s_640/weights/best.pt" --img-size 640 640GitHub: https://github.com/daquexian/onnx-simplifier

Install: pip3 install onnx-simplifier

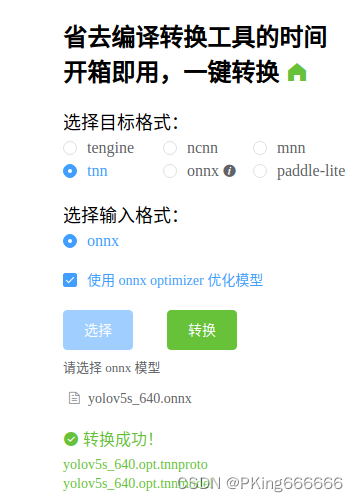

(3)将ONNX模型转换为TNN模型

目前在C++端上,CNN模型有多种部署方式,可以采用TNN,MNN,NCNN,以及TensorRT等部署工具,鄙人采用TNN进行Android端上部署

TNN转换工具:

- (1)将ONNX模型转换为TNN模型,请参考TNN官方说明:TNN/onnx2tnn.md at master · Tencent/TNN · GitHub

- (2)一键转换,懒人必备:一键转换 Caffe, ONNX, TensorFlow 到 NCNN, MNN, Tengine (可能存在版本问题,这个工具转换的TNN模型可能不兼容,建议还是自己build源码进行转换,2022年9约25日测试可用)

转换成功后,会生成两个文件(*.tnnproto和*.tnnmodel) ,下载下来后面会用到

3. 手势识别模型C++部署

项目IDE开发工具使用CLion,相关依赖库主要有OpenCV,base-utils以及TNN和OpenCL(可选),其中OpenCV必须安装,OpenCL用于模型加速,base-utils以及TNN已经配置好,无需安装;

项目仅在Ubuntu18.04进行测试,Windows系统下请自行配置好开发环境。

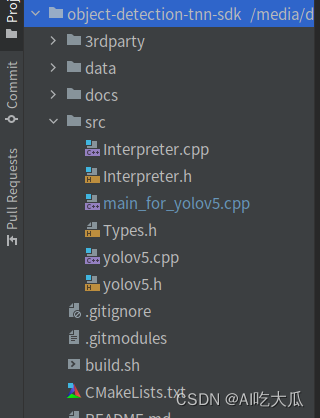

(1)项目结构

(2)配置开发环境(OpenCV+OpenCL+base-utils+TNN)

项目仅在Ubuntu18.04进行测试,Windows系统下请自行配置和编译

- 安装OpenCV:图像处理

图像处理(如读取图片,图像裁剪等)都需要使用OpenCV库进行处理

安装教程:Ubuntu18.04安装opencv和opencv_contrib

OpenCV库使用opencv-4.3.0版本,opencv_contrib库暂时未使用,可不安装

- 安装OpenCL:模型加速

安装教程:Ubuntu16.04 安装OpenCV&OpenCL

OpenCL用于模型GPU加速,若不使用OpenCL进行模型推理加速,纯C++推理模型,速度会特别特别慢

- base-utils:C++库

GitHub:https://github.com/PanJinquan/base-utils (无需安装,项目已经配置了)

base_utils是个人开发常用的C++库,集成了C/C++ OpenCV等常用的算法

- TNN:模型推理

GitHub:https://github.com/Tencent/TNN (无需安装,项目已经配置了)

由腾讯优图实验室开源的高性能、轻量级神经网络推理框架,同时拥有跨平台、高性能、模型压缩、代码裁剪等众多突出优势。TNN框架在原有Rapidnet、ncnn框架的基础上进一步加强了移动端设备的支持以及性能优化,同时借鉴了业界主流开源框架高性能和良好拓展性的特性,拓展了对于后台X86, NV GPU的支持。手机端 TNN已经在手机QQ、微视、P图等众多应用中落地,服务端TNN作为腾讯云AI基础加速框架已为众多业务落地提供加速支持。

(3)部署TNN模型

项目模型推理采用TNN部署框架(支持多线程CPU和GPU加速推理);图像处理采用OpenCV库,模型加速采用OpenCL,在普通电脑设备即可达到实时处理。

如果你想在这个 C++ Demo部署你自己训练的模型,你可以将训练好的Pytorch模型转换ONNX ,再转换成TNN模型,然后把原始的模型替换成你自己的TNN模型即可。

(4)CMake配置

这是CMakeLists.txt,其中主要配置OpenCV+OpenCL+base-utils+TNN这四个库,Windows系统下请自行配置和编译

cmake_minimum_required(VERSION 3.5)

project(Detector)

add_compile_options(-fPIC) # fix Bug: can not be used when making a shared object

set(CMAKE_CXX_FLAGS "-Wall -std=c++11 -pthread")

#set(CMAKE_CXX_FLAGS_RELEASE "-O2 -DNDEBUG")

#set(CMAKE_CXX_FLAGS_DEBUG "-g")

if (NOT CMAKE_BUILD_TYPE AND NOT CMAKE_CONFIGURATION_TYPES)

# -DCMAKE_BUILD_TYPE=Debug

# -DCMAKE_BUILD_TYPE=Release

message(STATUS "No build type selected, default to Release")

set(CMAKE_BUILD_TYPE "Release" CACHE STRING "Build type (default Debug)" FORCE)

endif ()

# opencv set

find_package(OpenCV REQUIRED)

include_directories(${OpenCV_INCLUDE_DIRS} ./src/)

#MESSAGE(STATUS "OpenCV_INCLUDE_DIRS = ${OpenCV_INCLUDE_DIRS}")

# base_utils

set(BASE_ROOT 3rdparty/base-utils) # 设置base-utils所在的根目录

add_subdirectory(${BASE_ROOT}/base_utils/ base_build) # 添加子目录到build中

include_directories(${BASE_ROOT}/base_utils/include)

include_directories(${BASE_ROOT}/base_utils/src)

MESSAGE(STATUS "BASE_ROOT = ${BASE_ROOT}")

# TNN set

# Creates and names a library, sets it as either STATIC

# or SHARED, and provides the relative paths to its source code.

# You can define multiple libraries, and CMake builds it for you.

# Gradle automatically packages shared libraries with your APK.

# build for platform

# set(TNN_BUILD_SHARED OFF CACHE BOOL "" FORCE)

if (CMAKE_SYSTEM_NAME MATCHES "Android")

set(TNN_OPENCL_ENABLE ON CACHE BOOL "" FORCE)

set(TNN_ARM_ENABLE ON CACHE BOOL "" FORCE)

set(TNN_BUILD_SHARED OFF CACHE BOOL "" FORCE)

set(TNN_OPENMP_ENABLE ON CACHE BOOL "" FORCE) # Multi-Thread

#set(TNN_HUAWEI_NPU_ENABLE OFF CACHE BOOL "" FORCE)

add_definitions(-DTNN_OPENCL_ENABLE) # for OpenCL GPU

add_definitions(-DTNN_ARM_ENABLE) # for Android CPU

add_definitions(-DDEBUG_ANDROID_ON) # for Android Log

add_definitions(-DPLATFORM_ANDROID)

elseif (CMAKE_SYSTEM_NAME MATCHES "Linux")

set(TNN_OPENCL_ENABLE ON CACHE BOOL "" FORCE)

set(TNN_CPU_ENABLE ON CACHE BOOL "" FORCE)

set(TNN_X86_ENABLE OFF CACHE BOOL "" FORCE)

set(TNN_QUANTIZATION_ENABLE OFF CACHE BOOL "" FORCE)

set(TNN_OPENMP_ENABLE ON CACHE BOOL "" FORCE) # Multi-Thread

add_definitions(-DTNN_OPENCL_ENABLE) # for OpenCL GPU

add_definitions(-DDEBUG_ON) # for WIN/Linux Log

add_definitions(-DDEBUG_LOG_ON) # for WIN/Linux Log

add_definitions(-DDEBUG_IMSHOW_OFF) # for OpenCV show

add_definitions(-DPLATFORM_LINUX)

elseif (CMAKE_SYSTEM_NAME MATCHES "Windows")

set(TNN_OPENCL_ENABLE ON CACHE BOOL "" FORCE)

set(TNN_CPU_ENABLE ON CACHE BOOL "" FORCE)

set(TNN_X86_ENABLE ON CACHE BOOL "" FORCE)

set(TNN_QUANTIZATION_ENABLE OFF CACHE BOOL "" FORCE)

set(TNN_OPENMP_ENABLE ON CACHE BOOL "" FORCE) # Multi-Thread

add_definitions(-DTNN_OPENCL_ENABLE) # for OpenCL GPU

add_definitions(-DDEBUG_ON) # for WIN/Linux Log

add_definitions(-DDEBUG_LOG_ON) # for WIN/Linux Log

add_definitions(-DDEBUG_IMSHOW_OFF) # for OpenCV show

add_definitions(-DPLATFORM_WINDOWS)

endif ()

set(TNN_ROOT 3rdparty/TNN)

include_directories(${TNN_ROOT}/include)

include_directories(${TNN_ROOT}/third_party/opencl/include)

add_subdirectory(${TNN_ROOT}) # 添加外部项目文件夹

set(TNN -Wl,--whole-archive TNN -Wl,--no-whole-archive)# set TNN library

MESSAGE(STATUS "TNN_ROOT = ${TNN_ROOT}")

# Detector

include_directories(src)

set(SRC_LIST

src/yolov5.cpp

src/Interpreter.cpp)

add_library(dmcv SHARED ${SRC_LIST})

target_link_libraries(dmcv ${OpenCV_LIBS} base_utils)

MESSAGE(STATUS "DIR_SRCS = ${SRC_LIST}")

#add_executable(Detector src/main.cpp)

#add_executable(Detector src/main_for_detect.cpp)

add_executable(Detector src/main_for_yolov5.cpp)

target_link_libraries(Detector dmcv ${TNN} -lpthread)

(5)main源码

主程序src/main_for_yolov5.cpp中提供行手势识别的Demo,支持图片,视频和摄像头测试

//

// Created by Pan on 2018/6/24.

//

#include <iostream>

#include <string>

#include <vector>

#include "file_utils.h"

#include "yolov5.h"

#include "image_utils.h"

using namespace dl;

using namespace vision;

using namespace std;

const int num_thread = 1;

DeviceType device = GPU; // 使用GPU运行,需要配置好OpenCL

//DeviceType device = CPU; // 使用CPU运行

// 测试YOLOv5s_640

string proto_file = "../data/tnn/yolov5/yolov5s_640.opt.tnnproto";

string model_file = "../data/tnn/yolov5/yolov5s_640.opt.tnnmodel";

YOLOv5Param model_param = YOLOv5s_640;//模型参数

// 测试YOLOv5s05_320

//string proto_file = "../data/tnn/yolov5/yolov5s05_320_anchor.opt.tnnproto";

//string model_file = "../data/tnn/yolov5/yolov5s05_320_anchor.opt.tnnmodel";

//YOLOv5Param model_param = YOLOv5s05_320;//模型参数

// 设置检测阈值

const float scoreThresh = 0.3;

const float iouThresh = 0.3;

YOLOv5 *detector = new YOLOv5(model_file,

proto_file,

model_param,

num_thread,

device);

/***

* 测试图片文件

* @return

*/

int test_image_file() {

// 测试图片

string image_dir = "../data/test_image";

vector<string> image_list = get_files_list(image_dir);

for (string image_path:image_list) {

cv::Mat bgr_image = cv::imread(image_path);

if (bgr_image.empty()) continue;

FrameInfo resultInfo;

// 开始检测

detector->detect(bgr_image, &resultInfo, scoreThresh, iouThresh);

// 可视化代码

detector->visualizeResult(bgr_image, &resultInfo);

}

printf("FINISHED.\n");

return 0;

}

/***

* 测试视频文件

* @return

*/

int test_video_file() {

string video_file = "../data/video/video-test.mp4"; //视频文件

cv::VideoCapture cap;

bool ret = get_video_capture(video_file, cap);

cv::Mat frame;

while (ret) {

cap >> frame;

if (frame.empty()) break;

FrameInfo resultInfo;

// 开始检测

detector->detect(frame, &resultInfo, scoreThresh, iouThresh);

// 可视化代码

detector->visualizeResult(frame, &resultInfo, 30);

}

cap.release();

delete detector;

detector = nullptr;

printf("FINISHED.\n");

return 0;

}

/***

* 测试摄像头

* @return

*/

int test_camera() {

int camera = 0; //摄像头ID号(请修改成自己摄像头ID号)

cv::VideoCapture cap;

bool ret = get_video_capture(camera, cap);

cv::Mat frame;

while (ret) {

cap >> frame;

if (frame.empty()) break;

FrameInfo resultInfo;

// 开始检测

detector->detect(frame, &resultInfo, scoreThresh, iouThresh);

// 可视化代码

detector->visualizeResult(frame, &resultInfo, 10);

}

cap.release();

delete detector;

detector = nullptr;

printf("FINISHED.\n");

return 0;

}

int main() {

//test_image_file();

test_video_file();

//test_camera();

return 0;

}

(6)源码编译和运行

编译脚本,或者直接:bash build.sh

#!/usr/bin/env bash

if [ ! -d "build/" ];then

mkdir "build"

else

echo "exist build"

fi

cd build

cmake ..

make -j4

sleep 1

./Detector

- 如果你要测试CPU运行的性能,请修改src/main_for_yolov5.cpp

DeviceType device = CPU;

- 如果你要测试GPU运行的性能,请修改src/main_for_yolov5.cpp (需配置好OpenCL)

DeviceType device = GPU; //默认使用GPU

纯C++推理模式需要耗时几秒的时间,而开启OpenCL加速后,GPU模式耗时仅需十几毫秒,性能极大的提高。

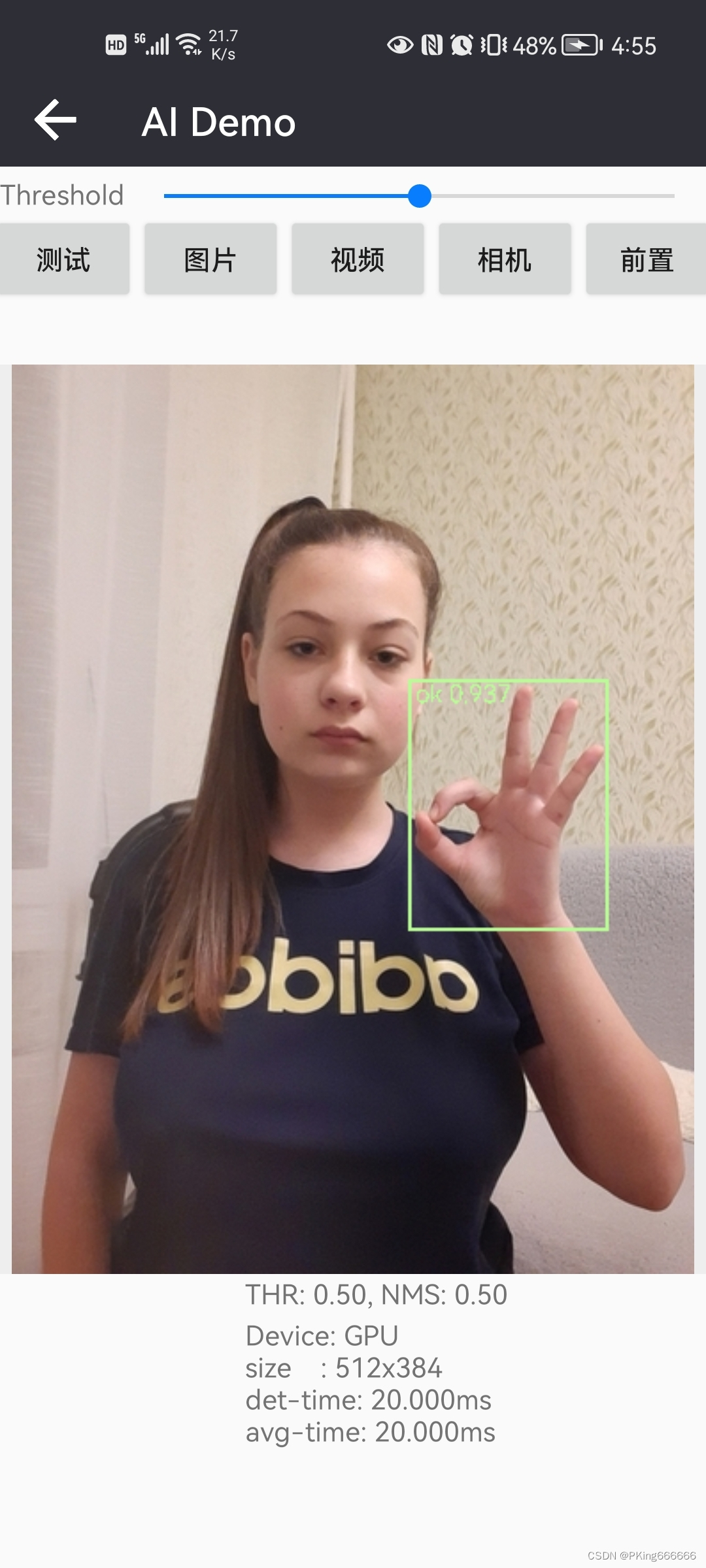

4. 手势识别检测效果

C++版本手势识别的检测效果与Python版本的检测效果几乎一致:

5. 项目源码下载

源码下载:C/C++实现手部检测和手势识别(含源码下载)

内容包含:

提供快速版yolov5s05手势识别,在普通手机可实时检测识别,CPU(4线程)约30ms左右,GPU约25ms左右

提供高精度版本yolov5s手势识别,CPU(4线程)约250ms左右,GPU约100ms左右

C/C++项目源码支持图片,视频,摄像头测试

项目配置好了base-utils和TNN,而OpenCV和OpenCL需要自行编译安装

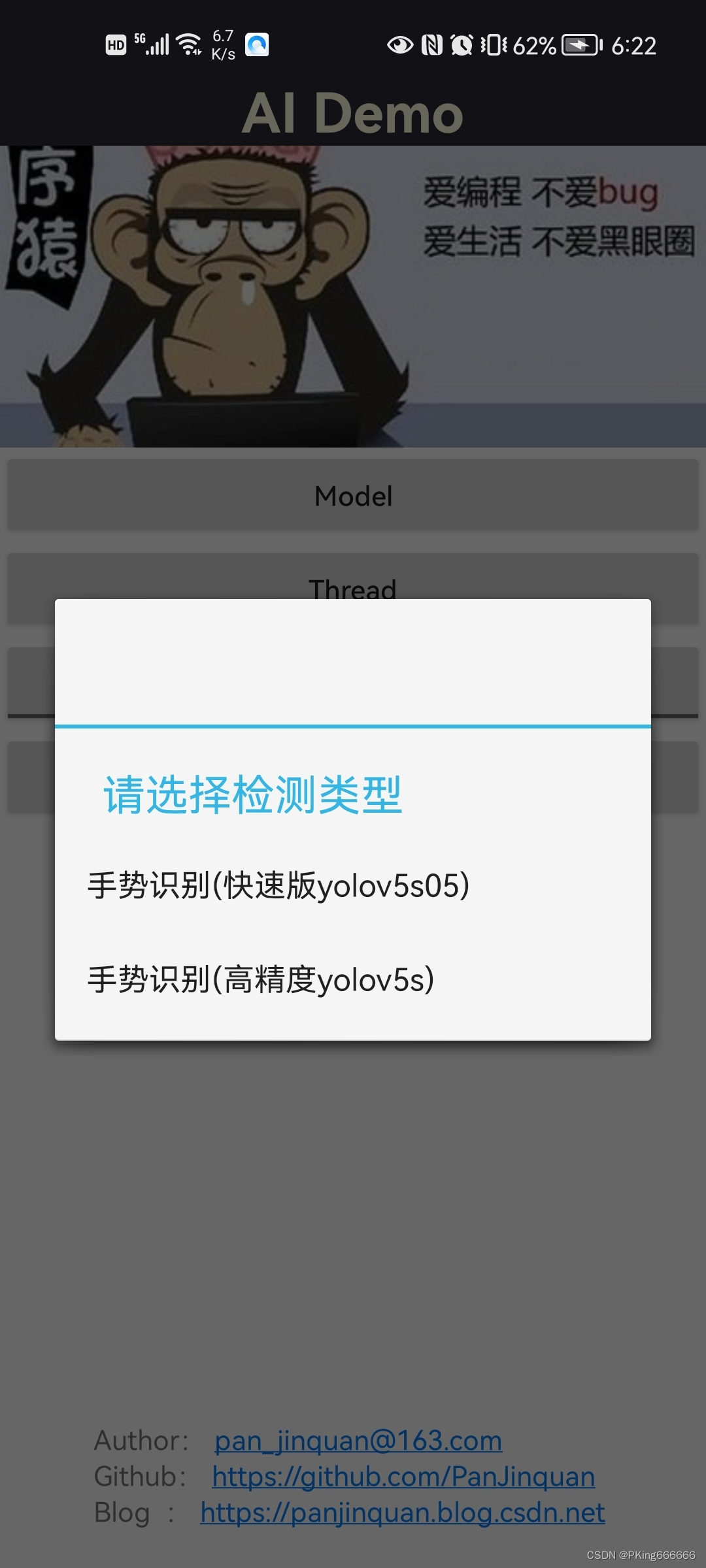

6. 手势识别Android版本

【Android APP体验】https://download.csdn.net/download/guyuealian/86666991

APP在普通Android手机上可以达到实时的手势识别效果,CPU(4线程)约30ms左右,GPU约25ms左右 ,基本满足业务的性能需求。

|  |  |

7.项目推荐:手部关键点检测

更多项目《手部关键点检测(手部姿势估计)》系列文章请参考:

- 手部关键点检测1:手部关键点(手部姿势估计)数据集(含下载链接)

- 手部关键点检测2:YOLOv5实现手部检测(含训练代码和数据集)

- 手部关键点检测3:Pytorch实现手部关键点检测(手部姿势估计)含训练代码和数据集

- 手部关键点检测4:Android实现手部关键点检测(手部姿势估计)含源码 可实时检测

- 手部关键点检测5:C++实现手部关键点检测(手部姿势估计)含源码 可实时检测

![]()