GPT-Crawler一键爬虫构建GPTs知识库

GPT-Crawler一键爬虫构建GPTs知识库

- 写在最前面

- 安装node.js

- 安装GPT-Crawler

- 启动爬虫

- 结合 OpenAI

- 自定义 assistant

- 自定义 GPTs(笔者用的这个)

- 总结

写在最前面

GPT-Crawler一键爬虫构建GPTs知识库

能够爬取网站数据,构建GPTs的知识库,项目依赖node.js环境,接下来我们按步骤来安装,非常简单

参考:https://zhuanlan.zhihu.com/p/668700619

安装node.js

Node.js下载地址:https://nodejs.org/en

下载20.10.0版本即可,下载后一路默认安装

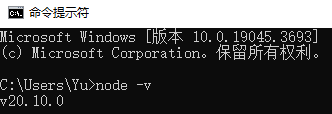

安装完成后在命令行输入node -v,显示版本则安装成功

安装GPT-Crawler

项目地址:https://github.com/BuilderIO/gpt-crawler

这个项目能爬取网站数据,生成用于创建GPTs的知识库文件

打开项目地址后,点击【Code】,下载压缩文件,保存到电脑本地解压

VSCode官网下载:https://code.visualstudio.com/Download

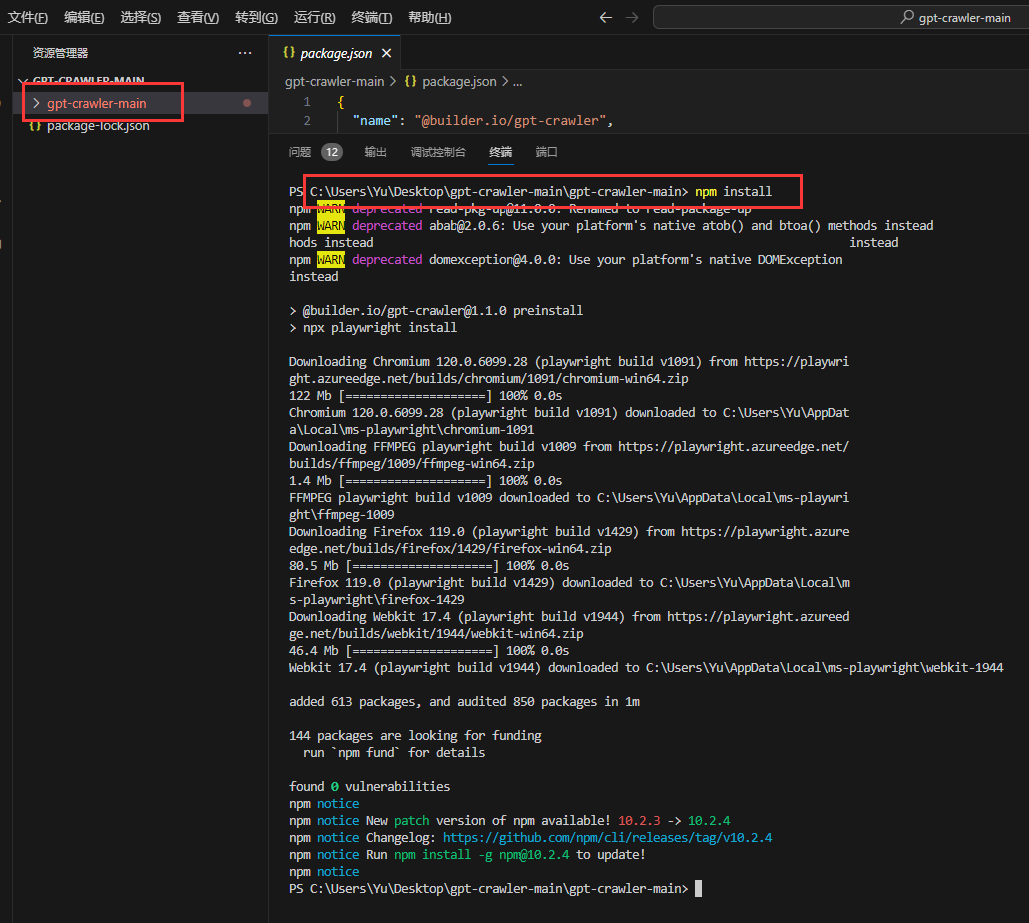

用VSCode编码工具打开,

或者点开VSCode,左上角文件,点击打开文件夹,地址选择解压的地址

切换到项目目录(例如我的是C:\Users\Yu\Desktop\gpt-crawler-main\gpt-crawler-main>),右键,选择在集成终端中打开

输入npm install,把项目依赖包进行安装

启动爬虫

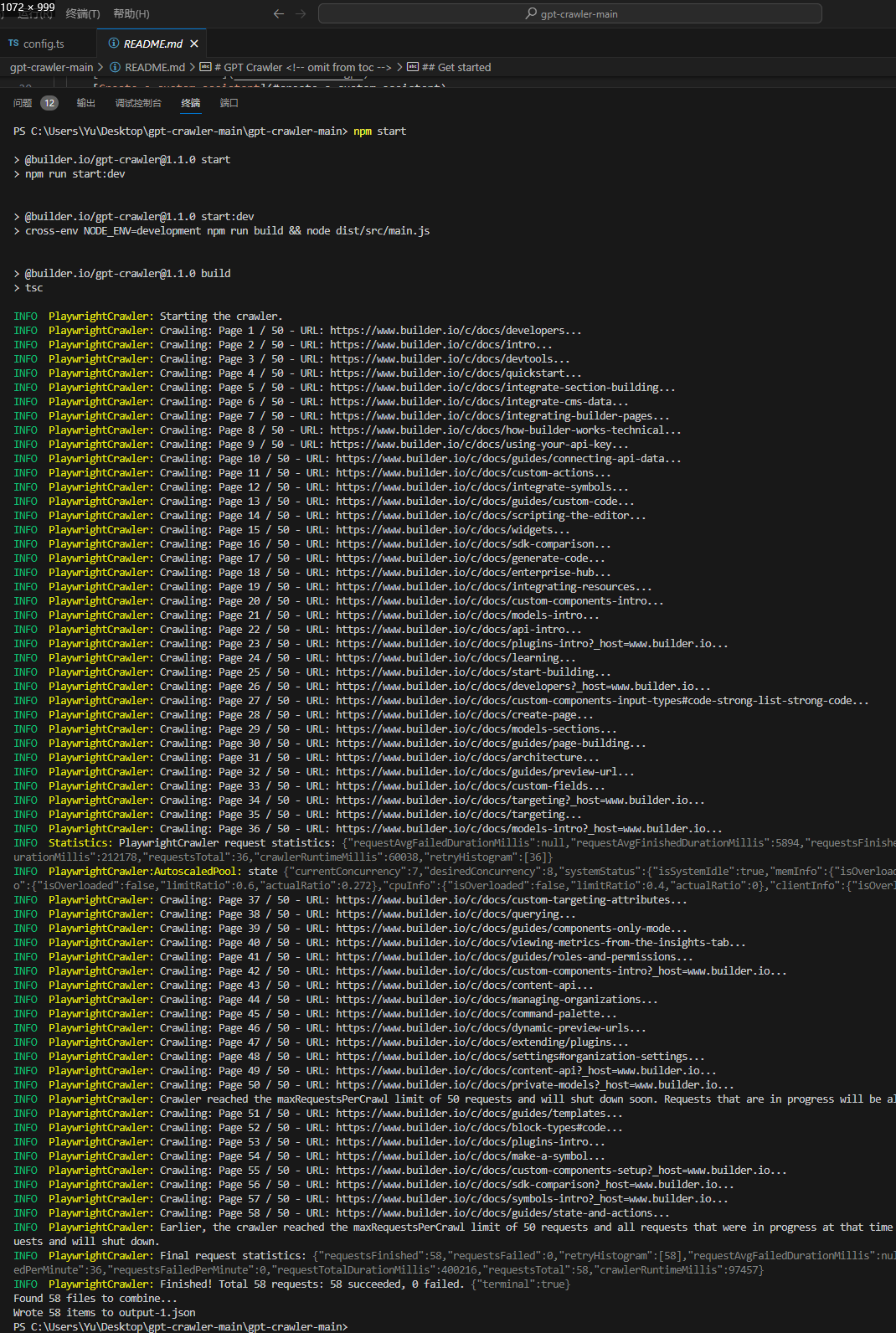

npm start

日志输出下面这些为正常:

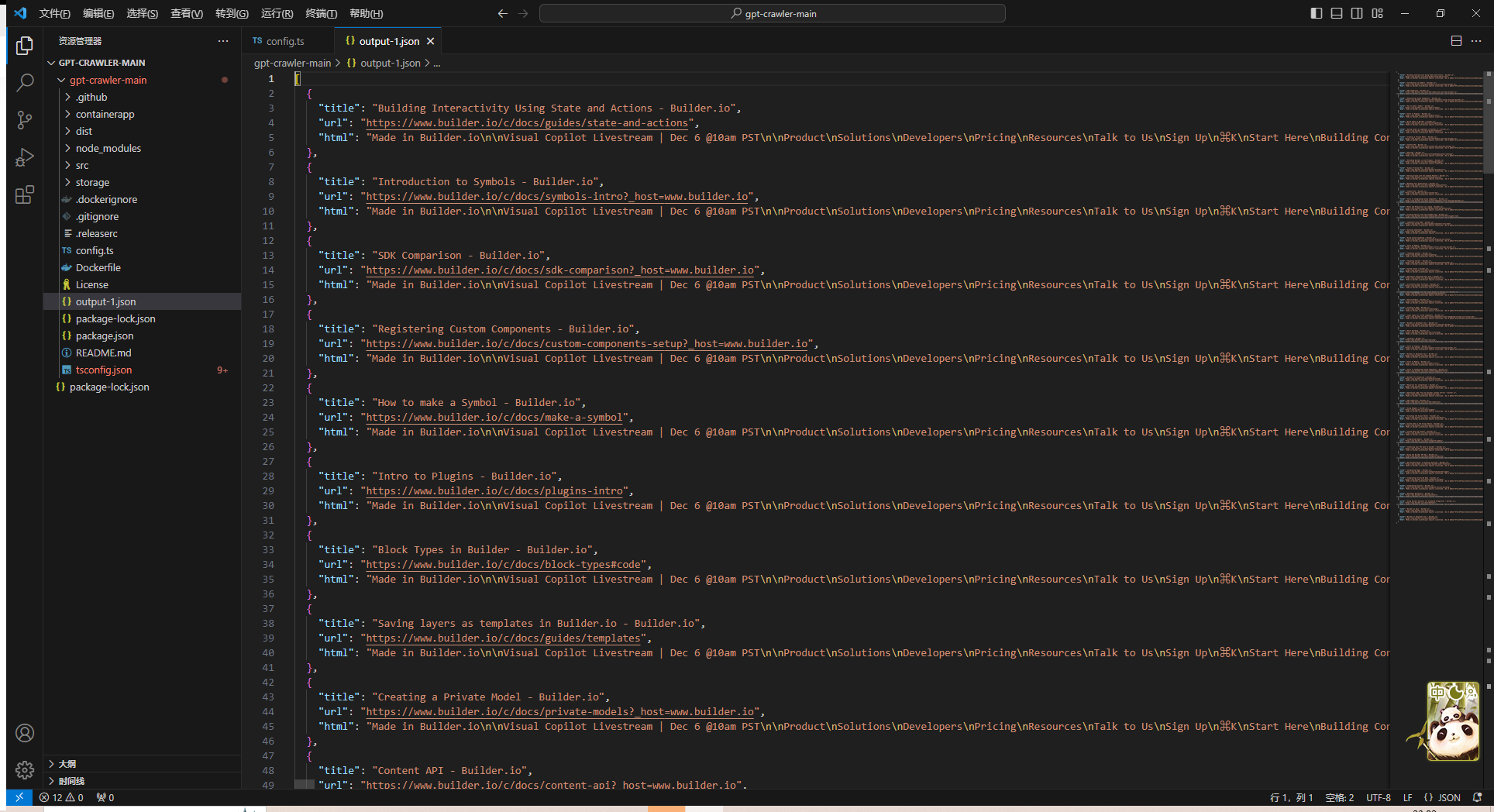

最后程序会在项目根目录输出文件output.json,这就是我们需要的文件。

输出的文件就在该目录下

点开看一下,很完美

结合 OpenAI

这步需要一个 OpenAI 账户,我们需要将生成的文件上传给 OpenAI。

自定义 assistant

选择 assistant 的优势是,我们可以使用 OpenAI 提供的 assistant API,集成到自己的系统中。

操作步骤:

1、进入自定义 Assistants 页面https://platform.openai.com/assistants

2、创建一个 Assistant

3、添加上面生成的output.json文件

4、配置其他选项

上传配置完点击保存,然后开始测试:

自定义 GPTs(笔者用的这个)

自定义 GPTs 和上面的操作类似,大家自行体验。GPTs 需要大家付费 Plus,并且官方似乎还没有提供 GPTs 的 API 可用。

总结

GPT Crawler 项目能让我们只做简单的配置,即可自定义自己的知识库。结合 OpenAI 的 API,能够做很多的事情。大家自行体验。