mac M系列芯片安装chatGLM3-6b模型

1 环境安装

1.1 mac安装conda.

下载miniconda,并安装

curl -O https://repo.anaconda.com/miniconda/Miniconda3-latest-MacOSX-arm64.sh

sh Miniconda3-latest-MacOSX-arm64.sh

1.2 创建虚拟环境并激活

创建名为chatglm3的虚拟环境,python版本为3.10.2

激活环境(后续要在这个环境安装pytorch及依赖包)

conda create -n chatglm3 python==3.10.2

conda activate chatglm3

1.3 安装pytorch-nightly

conda install pytorch torchvision torchaudio -c pytorch-nightly

1.4 下载chatglm3 代码

1 下载地址,git地址:https://github.com/THUDM/ChatGLM3

2 进入代码中,安装依赖包

git clone https://github.com/THUDM/ChatGLM3

cd ChatGLM3-main

pip install -r requirement.txt

2 模型下载

推荐使用方式3下载,可以下载任意开源大模型,且速度飞快,没有墙限制

方式1: 直接在huggingface官网下载(国内比较难)

https://huggingface.co/dwdcth/chatglm3-6b-int4

方式2 使用国内镜像

https://hf-mirror.com/dwdcth/chatglm3-6b-int4

方式3

-

使用modelscope下载

https://modelscope.cn/models/ZhipuAI/chatglm3-6b/summary -

安装魔塔依赖

pip install modelscope -U -

代码中的路径即为要下载的模型,可以自行选择模型下载(mac 16G推荐下载int4)

model_dir = snapshot_download(‘ZhipuAI/chatglm3-6b’, revision=‘v1.0.1’) -

模型默认保存路径为家目录下, ~/.cache/modelscope/hub/ZhipuAI/ChatGLM3-6B/

1 安装依赖

pip install modelscope -U

2 使用代码下载

from modelscope import snapshot_download

model_dir = snapshot_download("ZhipuAI/chatglm3-6b", revision = "v1.0.0")

3 模型使用

1 修改web_demo2.py中的device为"mps"

DEVICE = ‘mps’

如果测试cli_demo.py文件,修改如下代码,模型需要时float()类型的,不然会报错。(不过好像还没有用到mps,待测试)

DEVICE = ‘mps’

model = AutoModel.from_pretrained(TOKENIZER_PATH, trust_remote_code=True).float()

# web_demo2.py 运行

streamlit run basic_demo/web_demo2.py

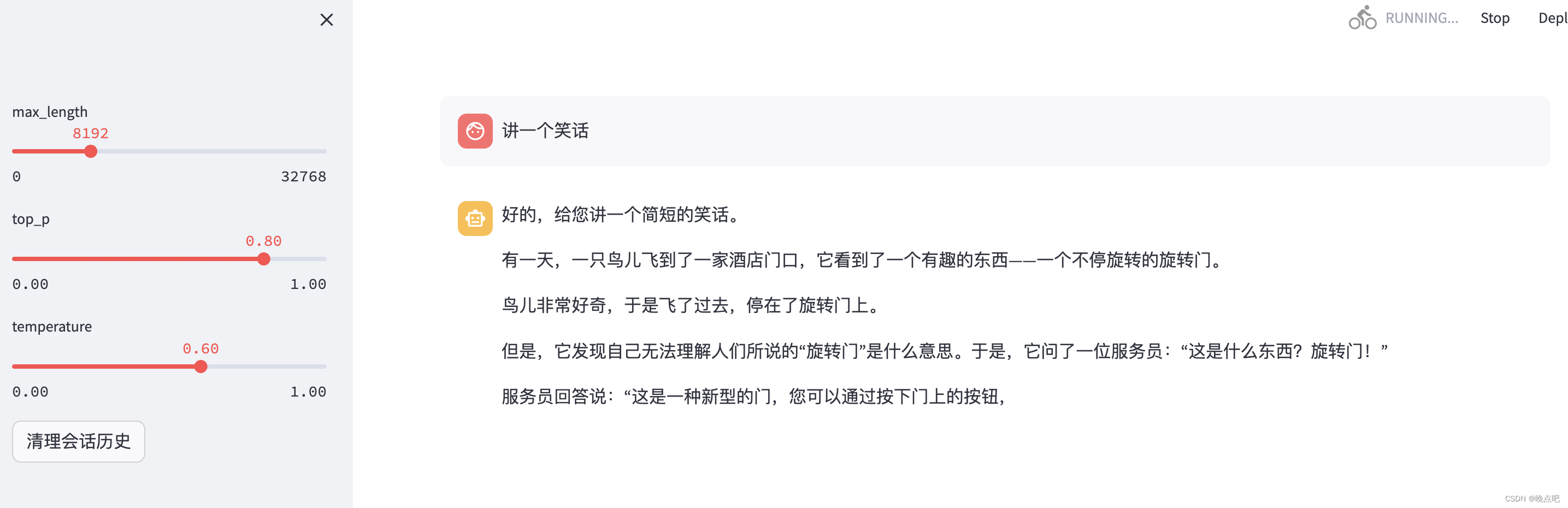

4 模型web展示

streamlit run basic_demo/web_demo2.py