【语音合成】中文-多情感领域-16k-多发音人

模型介绍

- 语音合成-中文-多情感领域-16k-多发音人

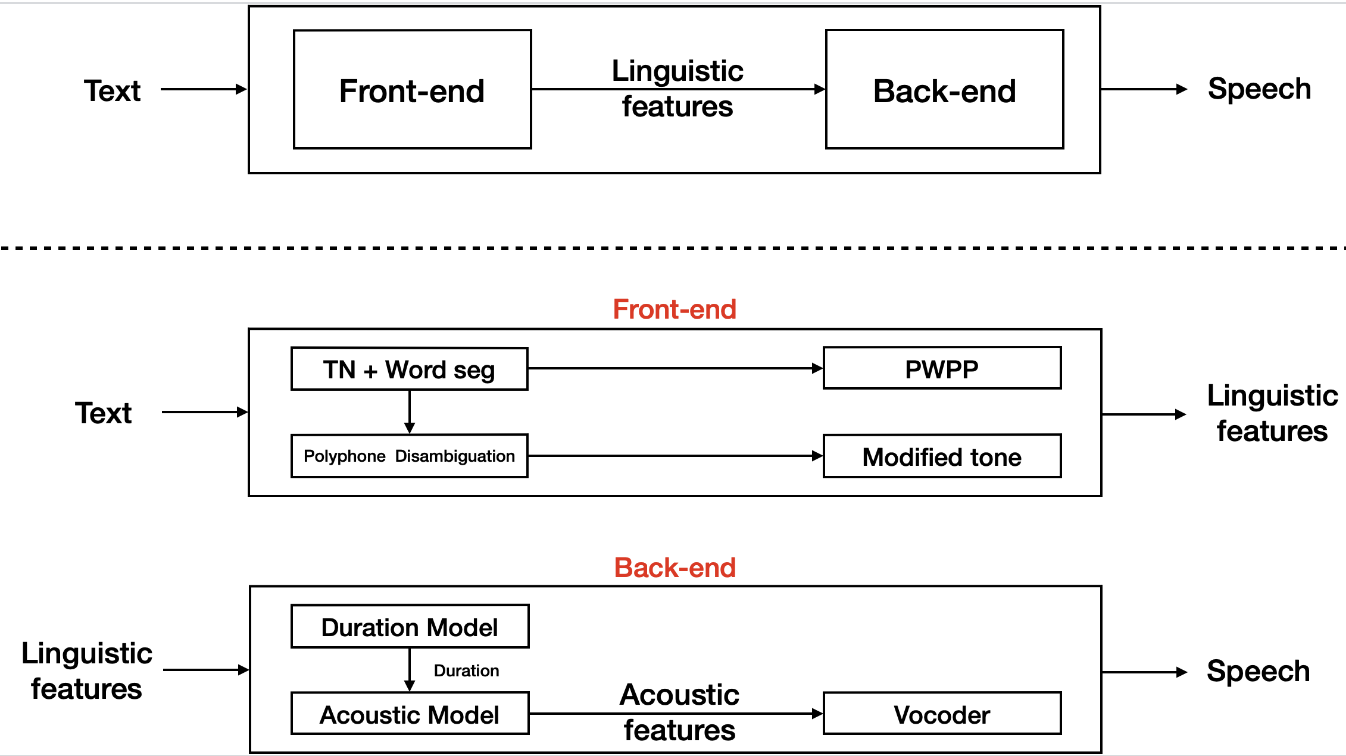

框架描述

拼接法和参数法是两种Text-To-Speech(TTS)技术路线。近年来参数TTS系统获得了广泛的应用,故此处仅涉及参数法。

参数TTS系统可分为两大模块:前端和后端。 前端包含文本正则、分词、多音字预测、文本转音素和韵律预测等模块,它的功能是把输入文本进行解析,获得音素、音调、停顿和位置等语言学特征。 后端包含时长模型、声学模型和声码器,它的功能是将语言学特征转换为语音。其中,时长模型的功能是给定语言学特征,获得每一个建模单元(例如:音素)的时长信息;声学模型则基于语言学特征和时长信息预测声学特征;声码器则将声学特征转换为对应的语音波形。

前端模块我们采用模型结合规则的方式灵活处理各种场景下的文本,后端模块则采用SAM-BERT + HIFIGAN提供高表现力的流式合成效果。

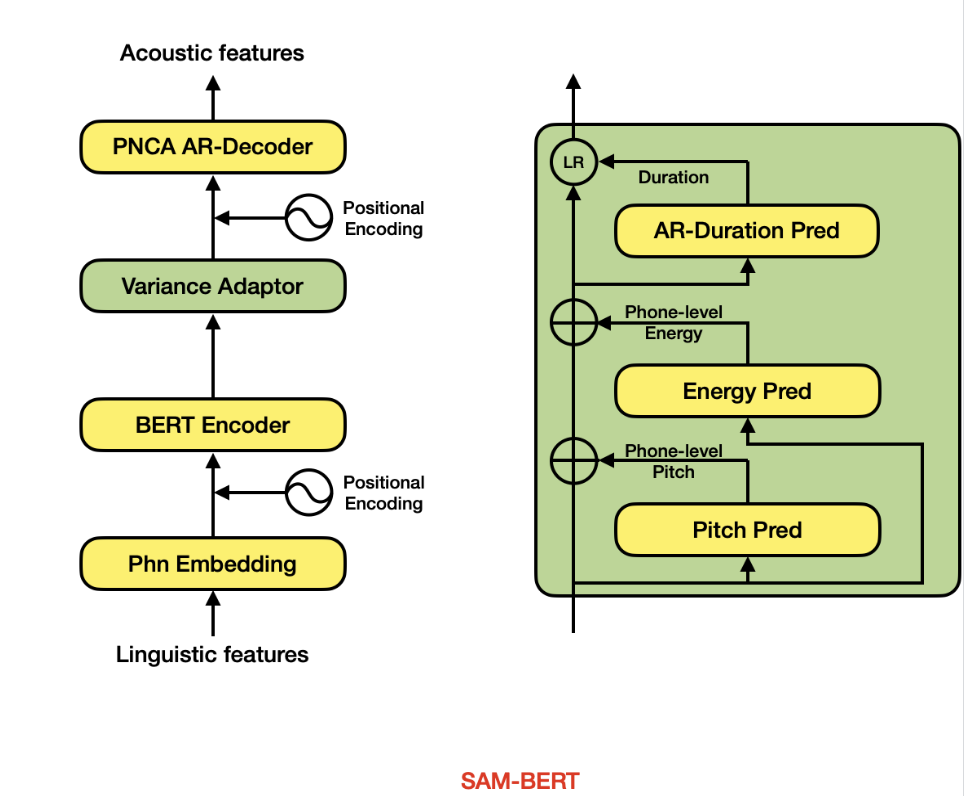

声学模型SAM-BERT

后端模块中声学模型采用自研的SAM-BERT,将时长模型和声学模型联合进行建模。

- Backbone采用Self-Attention-Mechanism(SAM),提升模型建模能力。

- Encoder部分采用BERT进行初始化,引入更多文本信息,提升合成韵律。

- Variance Adaptor对音素级别的韵律(基频、能量、时长)轮廓进行粗粒度的预测,再通过decoder进行帧级别细粒度的建模;并在时长预测时考虑到其与基频、能量的关联信息,结合自回归结构,进一步提升韵律自然度.

- Decoder部分采用PNCA AR-Decoder[@li2020robutrans],自然支持流式合成。

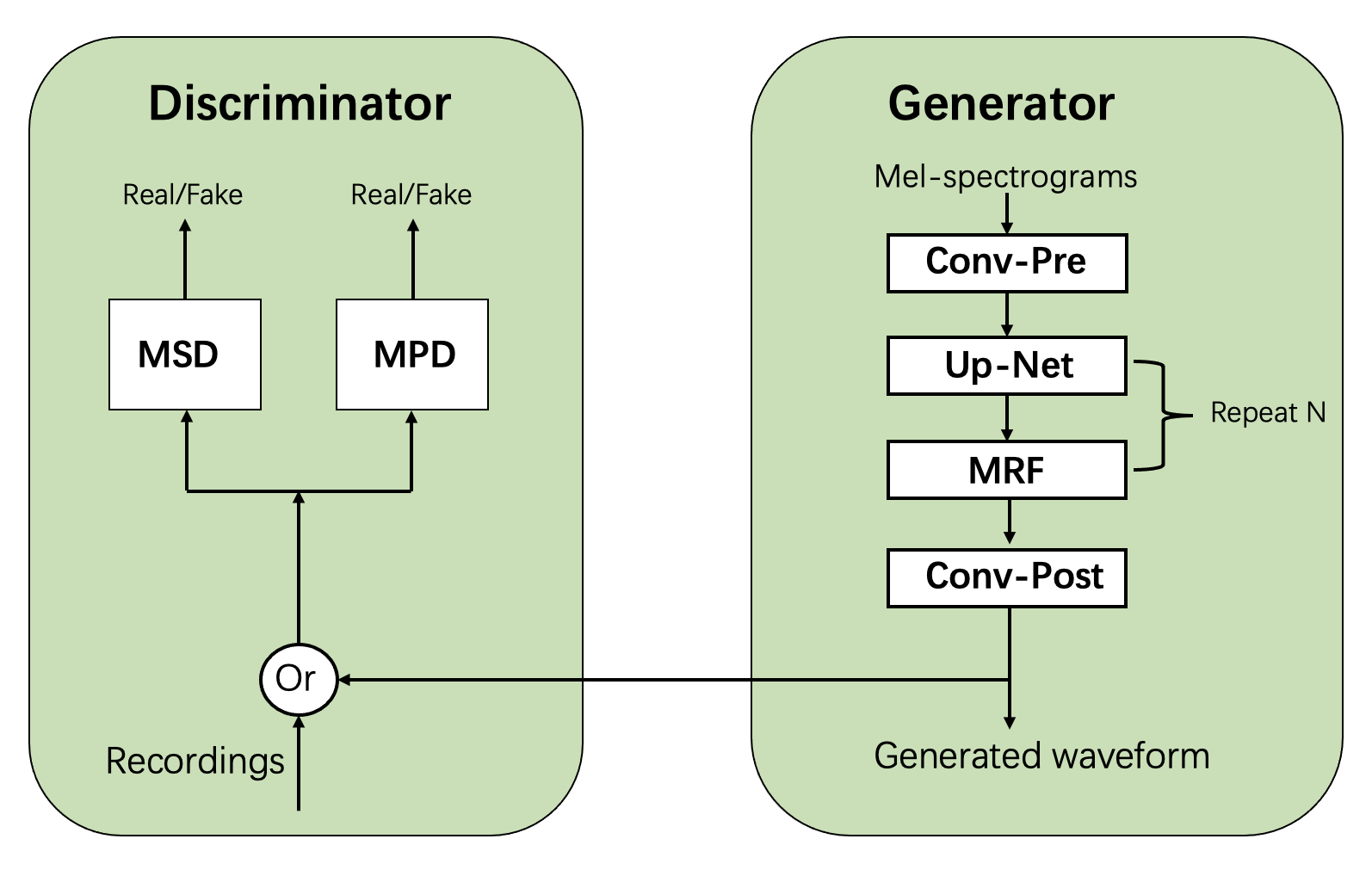

声码器模型

后端模块中声码器采用HIFI-GAN, 基于GAN的方式利用判别器(Discriminator)来指导声码器(即生成器Generator)的训练,相较于经典的自回归式逐样本点CE训练, 训练方式更加自然,在生成效率和效果上具有明显的优势。

在HIFI-GAN开源工作[1]的基础上,我们针对16k, 48k采样率下的模型结构进行了调优设计,并提供了基于因果卷积的低时延流式生成和chunk流式生成机制,可与声学模型配合支持CPU、GPU等硬件条件下的实时流式合成。

部署

- 下载模型:

git lfs clone https://www.modelscope.cn/iic/speech_sambert-hifigan_tts_zh-cn_16k.git modelscope库安装:- 安装

modelscope基础功能:pip install modelscope -i https://mirrors.cloud.aliyuncs.com/pypi/simple - 安装

modelscope cv功能:pip install "modelscope[cv]" -f https://modelscope.oss-cn-beijing.aliyuncs.com/releases/repo.html - 安装

modelscope audio功能:pip install "modelscope[audio]" -f https://modelscope.oss-cn-beijing.aliyuncs.com/releases/repo.html

- 安装

使用方式和范围

- 使用方式: 直接输入文本进行推理

- 使用范围: 适用于中文或中英文混合的语音合成场景,输入文本使用

utf-8编码,整体长度建议不超过30字 - 目标场景: 各种语音合成任务,比如配音,虚拟主播,数字人等

代码范例

from modelscope.outputs import OutputKeys

from modelscope.pipelines import pipeline

from modelscope.utils.constant import Tasks

def text_to_speech(text, speech_file_path, voice_type):

model_id = 'damo/speech_sambert-hifigan_tts_zh-cn_16k'

sambert_hifigan_tts = pipeline(task=Tasks.text_to_speech, model=model_id)

output = sambert_hifigan_tts(input=text, voice=voice_type)

wav = output[OutputKeys.OUTPUT_WAV]

with open(speech_file_path, 'wb') as f:

f.write(wav)

if __name__ == "__main__":

text_to_speech('待合成文本', 'output.wav', 'zhitian_emo')