熟悉常用的 Linux 操作和 Hadoop 操作

文章目录

- 前言

- 一、常用命令集合

- 1、cd命令:切换目录

- 1、切换到目录/usr/local

- 2、切换回上级目录

- 3、切换到当前登录Linux系统的用户的自己的文件夹

- 2、ls命令:查看文件与目录

- 3、mkdir命令:创建目录

- 4、rmdir命令:删除空的目录

- 5、cp 命令:复制文件或目录

- 6、mv 命令:移动文件与目录,或更名

- 7、rm 命令:移除文件或目录

- 8、cat 命令:查看文件内容

- 9、tac 命令:反向查看文件内容

- 10、more 命令:一页一页翻动查看

- 11、head 命令:取出前面几行

- 12、tail 命令:取出后面几行

- 13、touch 命令:修改文件时间或创建新文件

- 14、chown 命令:修改文件所有者权限

- 15、find 命令:文件查找

- 16、tar 命令:压缩命令

- 17、grep 命令:查找字符串

- 18、配置环境变量

- 二、常用的 Hadoop 操作

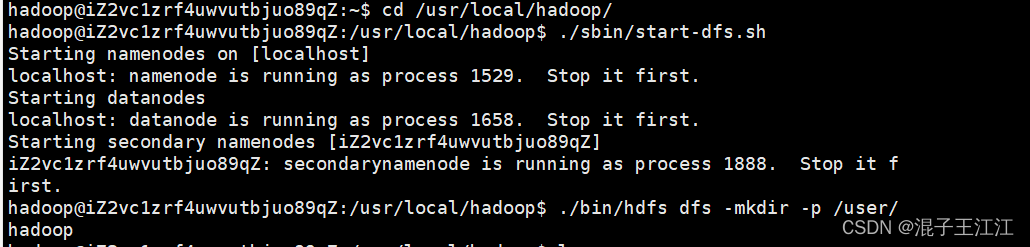

- 1.启动 Hadoop,为 hadoop 用户在 HDFS 中创建用户目录/user/hadoop

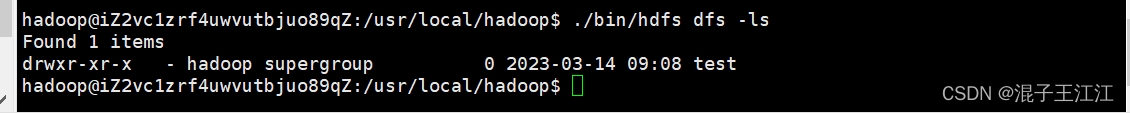

- 2、接着在 HDFS 的目录/user/hadoop下,创建 test 文件夹,并查看文件列表

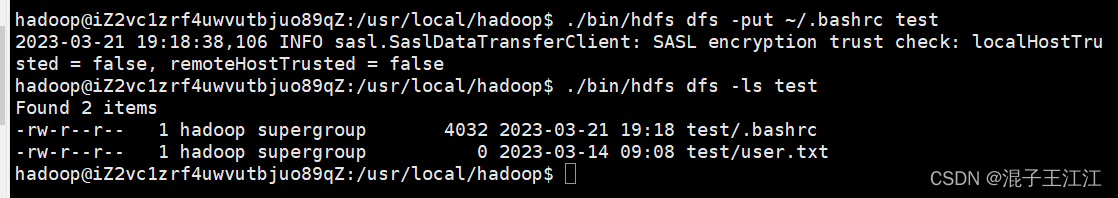

- 3、将 Linux 系统本地的“~/.bashrc”文件上传到 HDFS 的 test 文件夹中,并查看 test

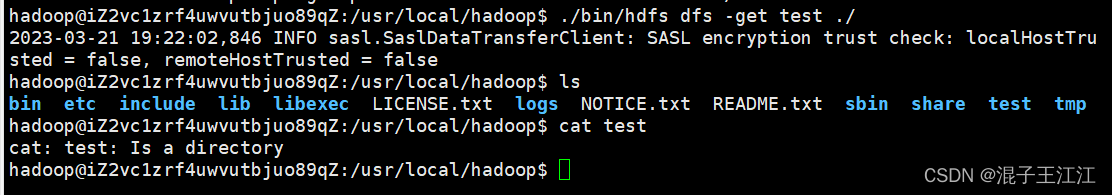

- 4、将 HDFS 文件夹 test 复制到 Linux 系统本地文件系统的/usr/local/hadoop目录下

- 三、总结

- 四、参考资料

前言

Hadoop 运行在 Linux 系统上,因此,需要学习实践一些常用的 Linux 命令。本实验旨在熟悉常用的 Linux 操作和 Hadoop 操作,为顺利开展后续其他实验奠定基础。

环境:

1、阿里云服务器 Ubuntu18.0.4

2、Hadoop 3.1.3

3、JDK 1.8

一、常用命令集合

1、cd命令:切换目录

1、切换到目录/usr/local

cd /usr/local

2、切换回上级目录

cd …

3、切换到当前登录Linux系统的用户的自己的文件夹

cd ~

2、ls命令:查看文件与目录

- 查看当前目录下的所有文件与目录

ls -al

3、mkdir命令:创建目录

- 创建单个目录:

mkdir a

- 创建多个目录:

mkdir -p a1/a2/a3/a4

4、rmdir命令:删除空的目录

- 删除单个目录:

rmdir a

- 删除多个目录:

rmdir -p a1/a2/a3/a4

5、cp 命令:复制文件或目录

- 将当前用户的主文件夹下的文件.bashrc 复制到目录“/usr”下,并重命名为 bashrc1:

sudo cp ~/.bashrc /usr/bashrc1

- 在目录“/tmp”下新建目录 test,再把这个目录复制到“/usr”目录下:

cd /tmp

mkdir test

sudo cp -r /tmp/test /usr

6、mv 命令:移动文件与目录,或更名

- 将“/usr”目录下的文件 bashrc1 移动到“/usr/test”目录下:

sudo mv /usr/bashrc1 /usr/test

- 将“/usr”目录下的 test 目录重命名为 test2:

sudo mv /usr/test /usr/test2

7、rm 命令:移除文件或目录

- 将“/usr/test2”目录下的 bashrc1 文件删除:

sudo rm /usr/test2/bashrc1

- 将“/usr”目录下的 test2 目录删除:

sudo rm -r /usr/test2

8、cat 命令:查看文件内容

- 查看当前用户主文件夹下的.bashrc 文件内容:

cat ~/.bashrc

9、tac 命令:反向查看文件内容

- 反向查看当前用户主文件夹下的.bashrc 文件的内容:

tac ~/.bashrc

10、more 命令:一页一页翻动查看

- 翻页查看当前用户主文件夹下的.bashrc 文件的内容:

more ~/.bashrc

11、head 命令:取出前面几行

- 1、查看当前用户主文件夹下.bashrc 文件内容前 20 行:

head -n 20 ~/.bashrc

- 2、查看当前用户主文件夹下.bashrc 文件内容,后面 50 行不显示,只显示前面几行

head -n -50 ~/.bashrc

12、tail 命令:取出后面几行

- 1、查看当前用户主文件夹下.bashrc 文件内容最后 20 行:

tail -n 20 ~/.bashrc

- 2、查看当前用户主文件夹下.bashrc 文件内容,并且只列出 50 行以后的数据:

tail -n +50 ~/.bashrc

13、touch 命令:修改文件时间或创建新文件

- 1、在“/tmp”目录下创建一个空文件 hello,并查看文件时间:

cd /tmp

touch hello

ls -l hello

- 2、修改 hello 文件,将文件时间整为 5 天前:

touch -d “5 days ago” hello

14、chown 命令:修改文件所有者权限

- 将 hello 文件所有者改为 root 帐号,并查看属性:

sudo chown root /tmp/hello

ls -l /tmp/hello

15、find 命令:文件查找

- 找出主文件夹下文件名为.bashrc 的文件:

find ~ -name .bashrc

16、tar 命令:压缩命令

- 1、在根目录“/”下新建文件夹 test,然后在根目录“/”下打包成 test.tar.gz:

sudo mkdir /test

sudo tar -zcv -f /test.tar.gz test

- 2、把上面的 test.tar.gz 压缩包,解压缩到“/tmp”目录:

sudo tar -zxv -f /test.tar.gz -C /tmp

17、grep 命令:查找字符串

- 从“~/.bashrc”文件中查找字符串’examples’:

grep -n 'examples' ~/.bashrc

18、配置环境变量

- 1、首先,使用 vim 编辑器打开文件“~/.bashrc”,命令如下:

vim ~/.bashrc

- 2、然后,在该文件的最上面加入一行如下形式的语句:

export JAVA_HOME=JDK 安装路径

- 3、最后,执行如下命令使得环境变量配置生效:

source ~/.bashrc

- 4、查看 JAVA_HOME 变量的值:

echo $JAVA_HOME

二、常用的 Hadoop 操作

1.启动 Hadoop,为 hadoop 用户在 HDFS 中创建用户目录/user/hadoop

cd /usr/local/hadoop

./sbin/start-dfs.sh

./bin/hdfs dfs -mkdir -p /user/hadoop

2、接着在 HDFS 的目录/user/hadoop下,创建 test 文件夹,并查看文件列表

cd /usr/local/hadoop

./bin/hdfs dfs -mkdir test

./bin/hdfs dfs -ls

3、将 Linux 系统本地的“~/.bashrc”文件上传到 HDFS 的 test 文件夹中,并查看 test

cd /usr/local/hadoop

./bin/hdfs dfs -put ~/.bashrc test

./bin/hdfs dfs -ls test

4、将 HDFS 文件夹 test 复制到 Linux 系统本地文件系统的/usr/local/hadoop目录下

cd /usr/local/hadoop

./bin/hdfs dfs -get test ./

三、总结

实验内容主要就是熟悉linux命令以及hadoop的一些基本操作,实验内容已全部完成。出现的重大问题就是在启动hadoop过后使用jps查看各个名称节点时,未显示,尝试了许多方法也无法解决,后面猜想可能是jdk和hadoop以及ubuntu等的版本不互相匹配造成,后来跟着林子雨老师的慕课重新装了一边才成功。

四、参考资料

https://www.icourse163.org/learn/XMU-1002335004?tid=1469834441#/learn/announce