部署一个本地的ChatGPT(Ollama)

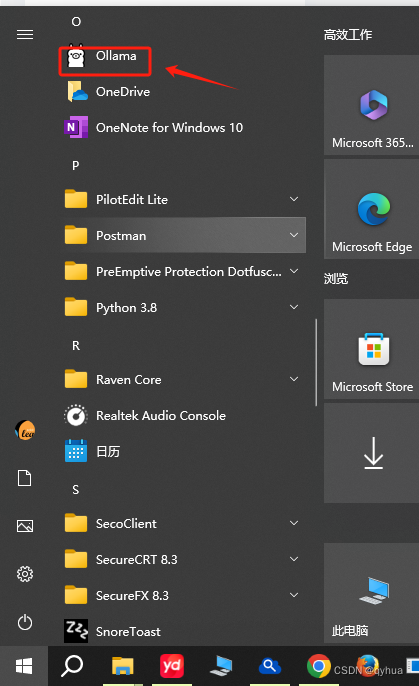

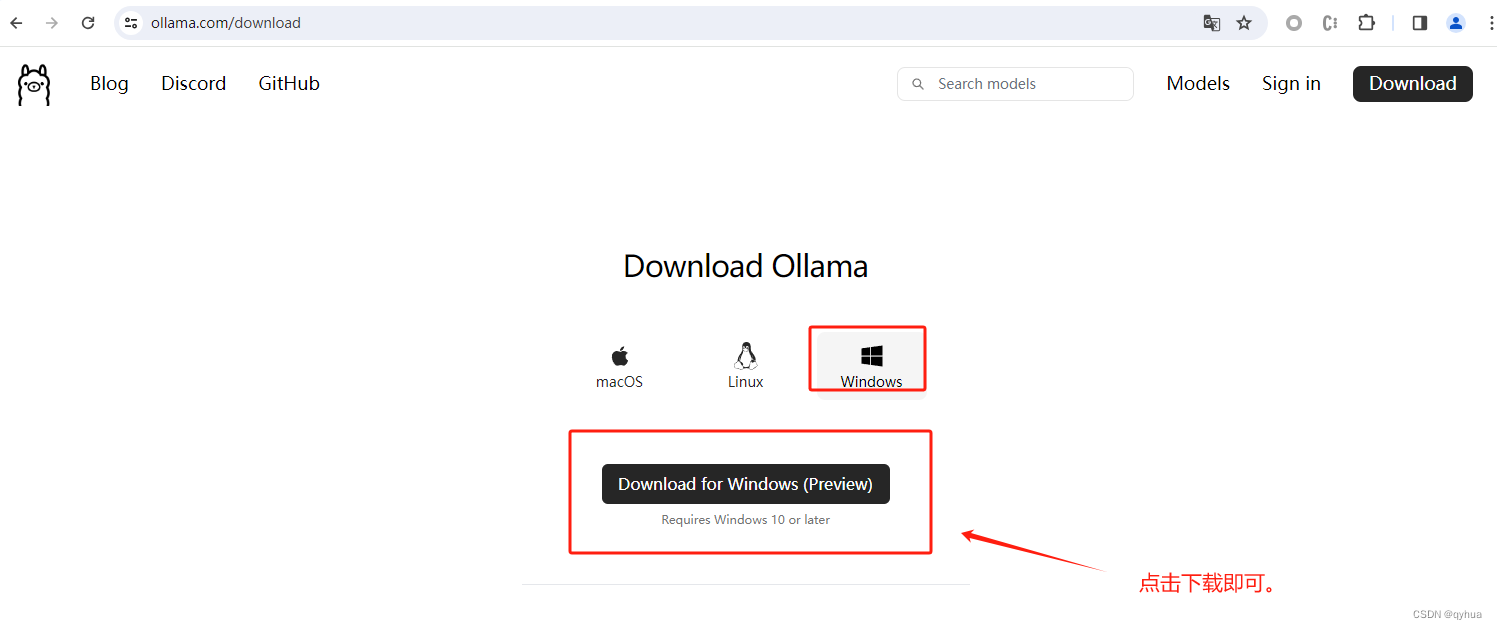

一 下载Ollama

Ollama下载地址:https://ollama.com/download

下载完后

![]()

二 安装运行

双击下载好的OllamaSetup.exe开发 安装Ollama:

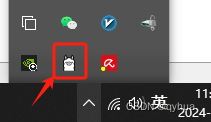

安装完成后,多了一个Ollama的菜单如下图 :

Ollama安装好默认是配置开机运行,如果没有运行可以在菜单上点击一下即可,正常情况要查看是否运行状态看一下任务栏这个图标即可。

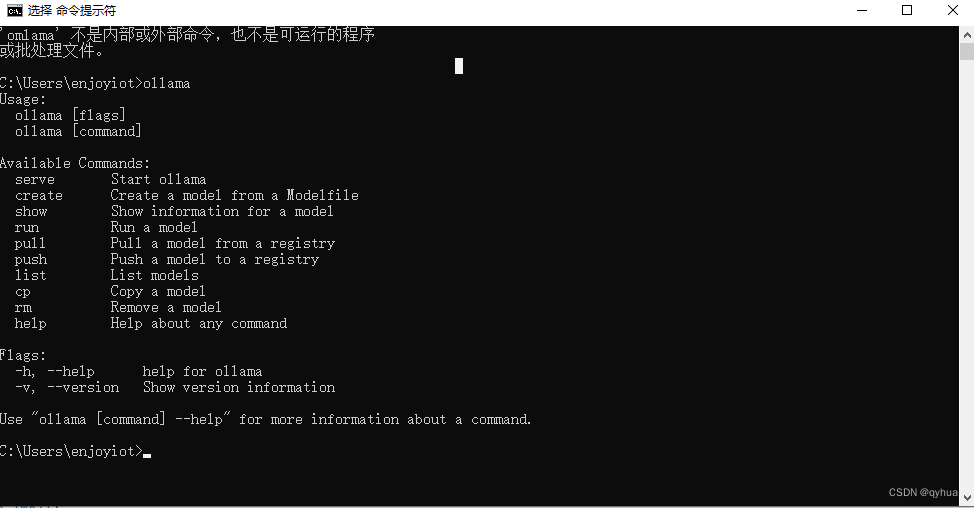

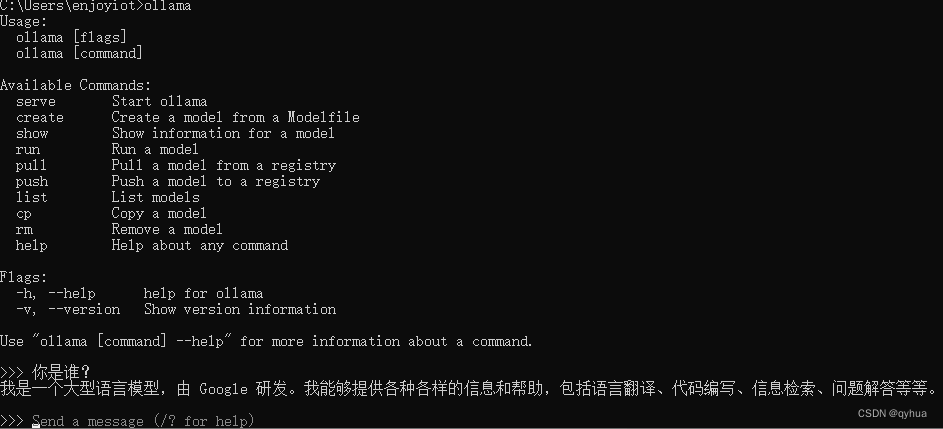

在命令行运行

ollama

首次运行需要选择下载的模型

ollama run gemma:7b指定使用的模型gemma:7b,这里可以选择其它模型,第一次调用当本地不存在时会自动下载该模型,运行成功可直接在命令行模型上发问如下图:

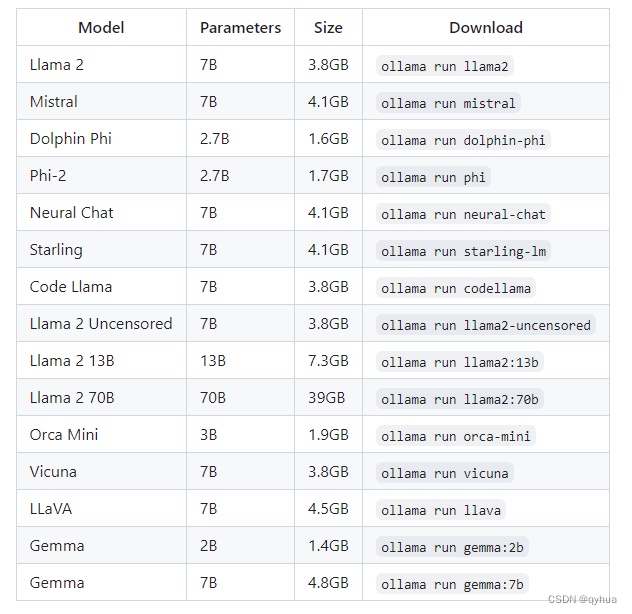

模型

可以根据电脑配置和自己的爱好选择模型:

注意:运行7B机型至少应该有8gb可用内存,运行13B机型至少应该有16gb可用内存,运行33B机型至少应该有32gb可用内存。

三 配置Chat Ollama 客户端

配置Chat Ollama 客户端,加一个壳用来调用的。

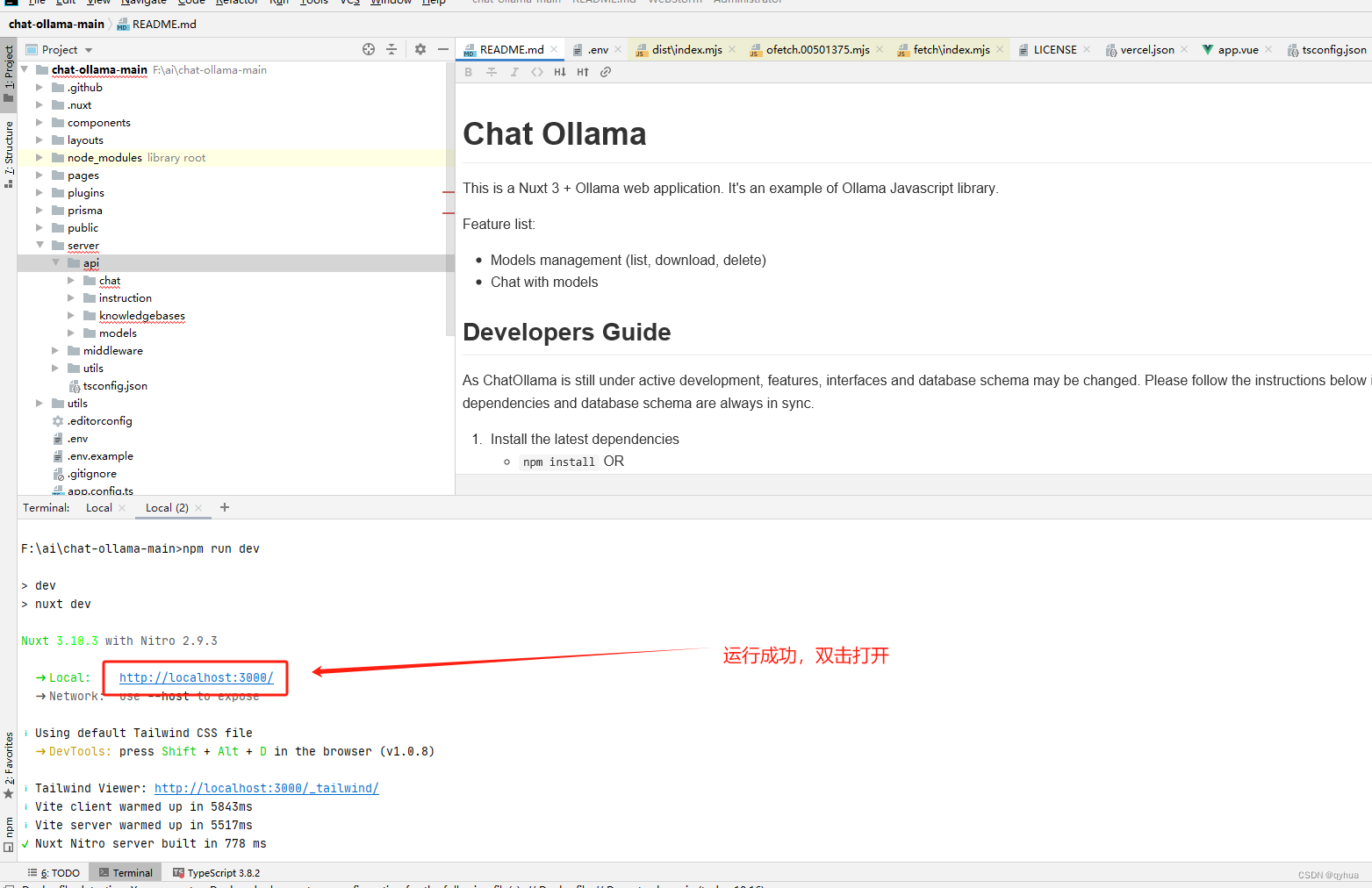

在github找到一个开源的web客户端 https://github.com/ivanfioravanti/chatbot-ollama

开发环境运行:

配置好的Chat Ollama 客户端,运行效果,界面不够美的可以直接修改页面代码。

这里我们只需配置本地的服务配置即可,如下图:

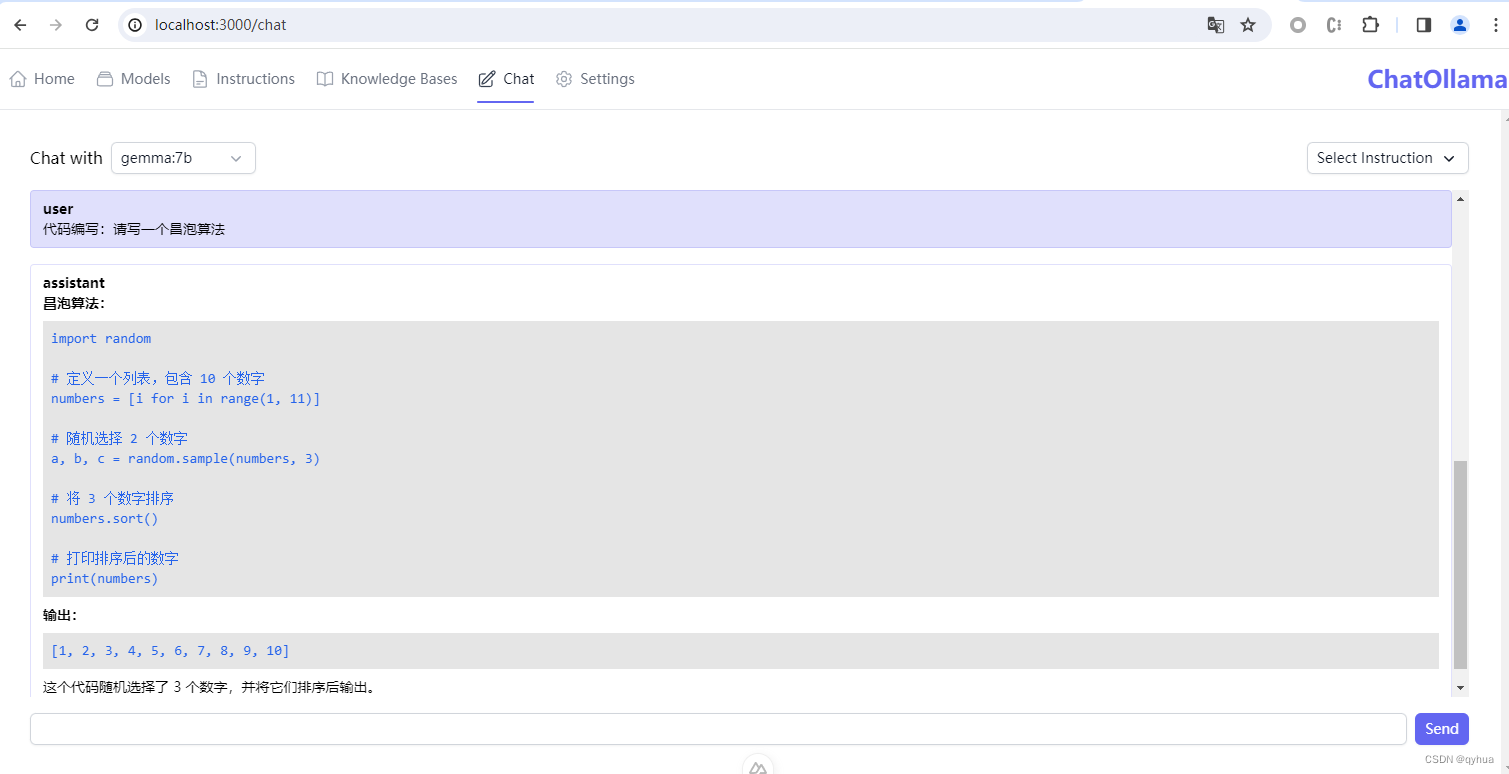

选好模型开始聊天:

可以开始聊天了,如下图:

可以开始聊天了,如下图:

帮助写代码如下图:

这样跑起来方便很多

这样跑起来方便很多