Bert的一些理解

Bert的一些理解

- Masked Language Model (MLM)

- Next Sentence Prediction (NSP)

- 总结

参考链接1

参考链接2

BERT 模型的训练数据集通常是以预训练任务的形式来构建的,其中包括两个主要任务:Masked Language Model (MLM) 和 Next Sentence Prediction (NSP)。下面简要介绍这两个任务在数据集中的格式:

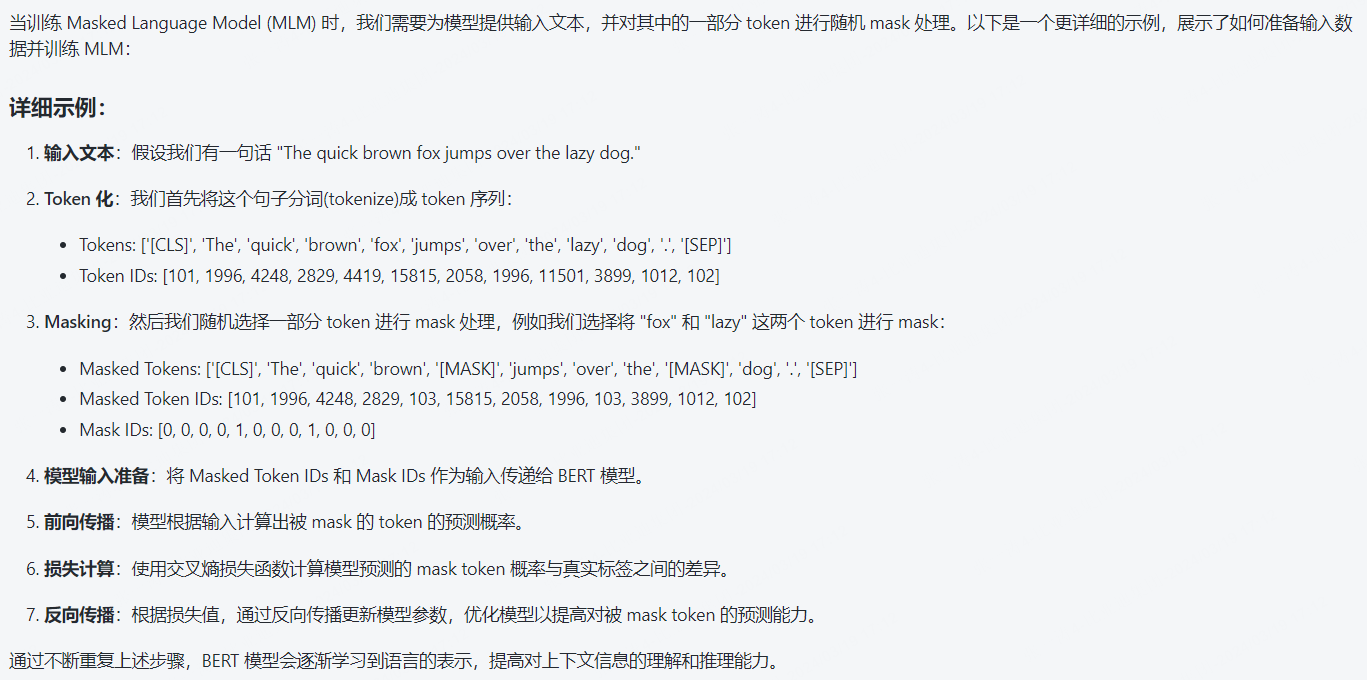

Masked Language Model (MLM)

- 在 MLM 中,输入文本会被处理为一组 token 序列,其中一些 token 会被随机选择并替换为特殊的 [MASK] 标记。

- 数据集中的每条样本是一个包含 [CLS] 句子 A [SEP] 句子 B [SEP] 的序列。

- 句子 A 和句子 B 可能是相邻的句子,也可能是来自不同文本的句子。

- 对于每个样本,一部分 token 会被随机选择并替换为 [MASK] 标记。

- 训练时,BERT 模型需要预测这些被遮挡的 token。

举个例子

Next Sentence Prediction (NSP)

- NSP 任务通过判断两个句子是否在原始文本中相邻来训练模型,以帮助提高模型在理解句子之间关系方面的能力。

- 数据集中的每条样本由一对句子组成,包括正例 (IsNext) 和负例 (NotNext)。

- 正例是原始文本中相邻的两个句子,负例是从其他地方抽取的两个不相邻的句子。

- BERT 模型需要通过 NSP 任务来预测这对句子是否是相邻的。

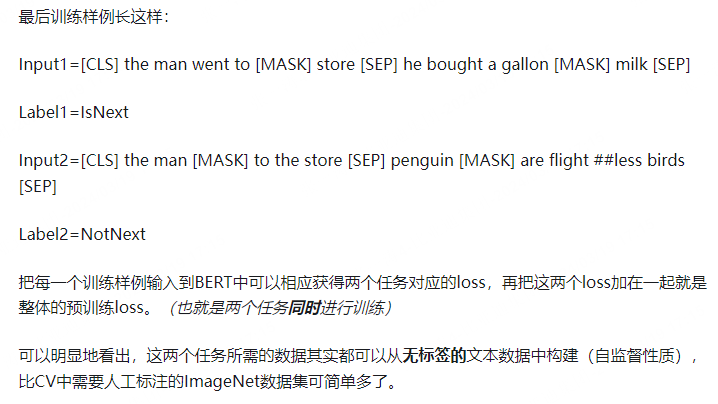

举个例子:

对于每一个训练样例,我们在语料库中挑选出句子A和句子B来组成,50%的时候句子B就是句子A的下一句(标注为IsNext),剩下50%的时候句子B是语料库中的随机句子(标注为NotNext)。接下来把训练样例输入到BERT模型中,用[CLS]对应的C信息去进行二分类的预测。

因此,BERT 模型的训练数据集会以一定格式准备包含上述任务的样本,以便模型在预训练阶段学习语言表示。这种训练数据集的设计有助于提高模型对语言理解和推理的能力。

总结