通过 Flink 的火焰图定位反压

在 Apache Flink 中,Web UI 提供了丰富的监控工具来帮助用户分析和解决作业性能问题,其中火焰图(Flame Graph)是用于分析反压问题的一个强有力的工具。反压可能是由于作业中某些算子处理速度过慢,或者资源耗尽导致的。火焰图展示了作业执行时,算子占用 CPU 时间的分布情况,可以帮助定位哪一部分代码或者算子可能引起了反压。

以下是通过 Flink Web UI 火焰图定位反压问题的详细步骤和思路:

1. 生成 Flink 的火焰图

火焰图的生成主要依赖 Flink 的 JFR (Java Flight Recorder) 或 Profiler 工具。Flink 提供了一些内置的工具,可以在运行时对作业的性能进行监控并生成火焰图。

1.1 启用 Flink 的 Profiling

在 Flink 作业运行时,可以通过启用 Profiler 来生成火焰图。这些工具会监控各个算子的 CPU 使用情况,生成 CPU 占用的详细信息。

- 通过 Flink 内置的

flamegraphprofiler 启动火焰图

你可以在 Flink Web UI 中找到 “Taskmanager” 页面,启动 Profiling 或者直接在 Flink 运行时的命令行中启动火焰图生成。

命令行中,Flink 提供了 flamegraph 命令,可以从作业中获取火焰图:

bin/flink run -c <main-class> -Dtaskmanager.profiler.enabled=true <jar-file>

在启动时添加配置 -Dtaskmanager.profiler.enabled=true 以启用 Profiling。

1.2 使用 JFR (Java Flight Recorder)

可以通过 JFR 工具采集数据并生成火焰图。

-

在 Flink 启动时配置 JFR:

-Dtaskmanager.profiler.enable-jfr=true通过 JFR 工具获取 CPU 样本数据,之后可以通过 JFR 可视化工具生成火焰图。

2. 分析火焰图中的反压

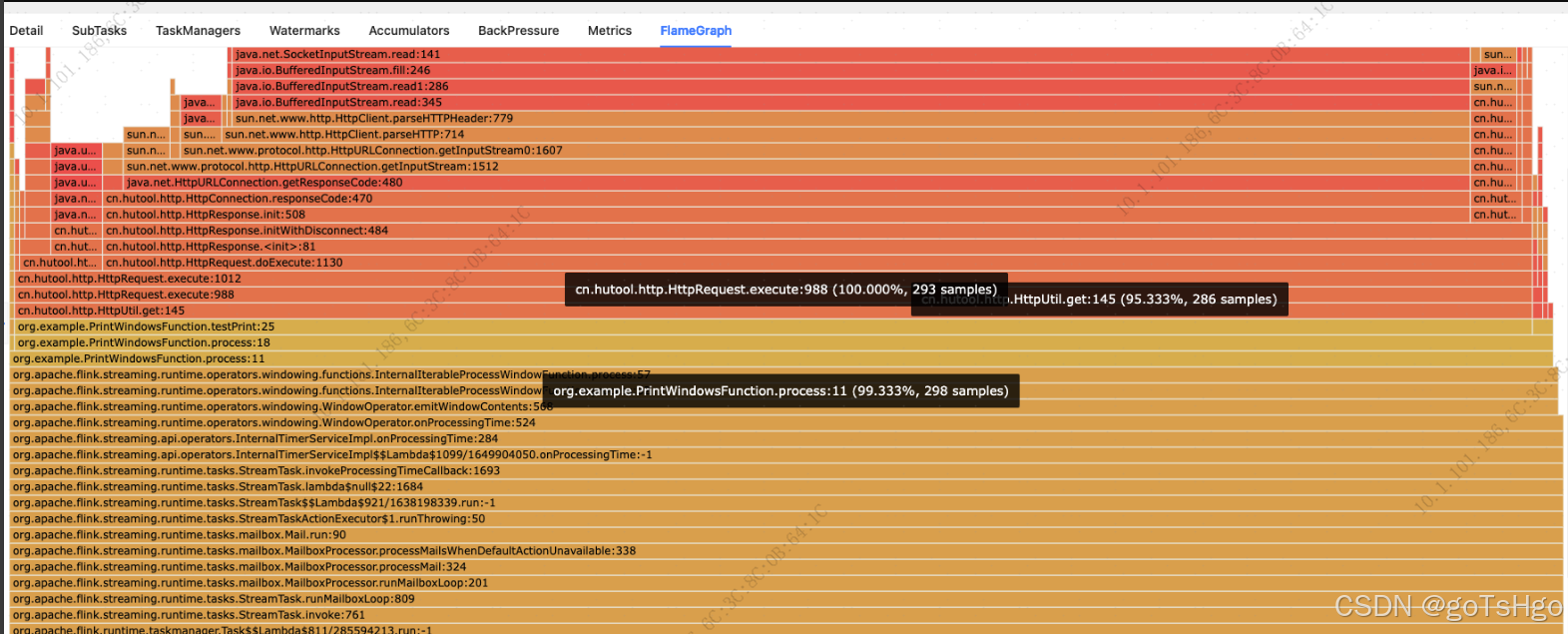

火焰图是一种直观的工具,用于展示程序执行时各个方法或函数所占用的 CPU 时间。每个矩形代表某一方法栈帧的执行时间,越宽的矩形代表消耗的时间越多。火焰图的顶部代表当前正在执行的代码,越往下则代表调用栈。

在 Flink 中,火焰图可以帮助你理解作业中每个算子的 CPU 消耗情况。你可以从以下几个方面着手分析反压:

2.1 定位消耗 CPU 时间较多的算子

在火焰图中,CPU 时间消耗较多的算子通常会以较宽的矩形条显示。如果某个算子占用 CPU 时间过多,很可能说明该算子的处理速度较慢,可能成为反压的瓶颈。

- 如果某个算子处理逻辑复杂,可能需要优化算子的逻辑或者拆分任务以提高并行度。

- 对于 CPU 时间较长的 IO 密集型算子(例如 Sink 到外部系统),可能需要检查是否外部系统的性能成为瓶颈。

2.2 分析 StreamTask 和 AsyncWaitOperator

在 Flink 中,一些算子的异步操作可能导致反压。常见的算子如 AsyncWaitOperator,它处理异步 I/O 请求。如果在火焰图中发现 AsyncWaitOperator 或 StreamTask 占用了大量的 CPU 时间,说明这些异步操作可能成为瓶颈。

你可以进一步分析这些算子调用的外部服务或网络 I/O 操作是否存在延迟,进而导致处理速度下降。

2.3 检查 GC (Garbage Collection) 或线程切换

有时,火焰图可能显示大量的时间被垃圾回收(GC)或线程切换消耗。如果火焰图中出现大量的 GC 相关的调用栈,说明可能是由于内存问题导致了反压。此时你需要:

- 调整 TaskManager 的内存参数,避免频繁 GC。

- 检查是否有大对象或过多的状态存储导致内存压力过大。

-Dtaskmanager.memory.process.size=4096m通过增大 TaskManager 的内存配置,可以减轻 GC 的负担。

2.4 识别低效的操作或热点

火焰图能够清晰地展示出最消耗 CPU 的地方,帮助你识别低效的操作或热点。如果某个算子的特定操作(例如某个复杂的转换、聚合等)消耗了过多时间,可能需要优化这些操作的执行效率。

2.5 定位反压传播的根源

火焰图不仅能够帮助定位 CPU 的消耗,还能够通过 CPU 负载的分布,帮助你理解反压传播的路径。如果某个下游算子处理时间非常长(例如由于外部系统的瓶颈或计算复杂度过高),上游算子可能由于数据无法及时处理而被迫减慢速度,从而引发反压。

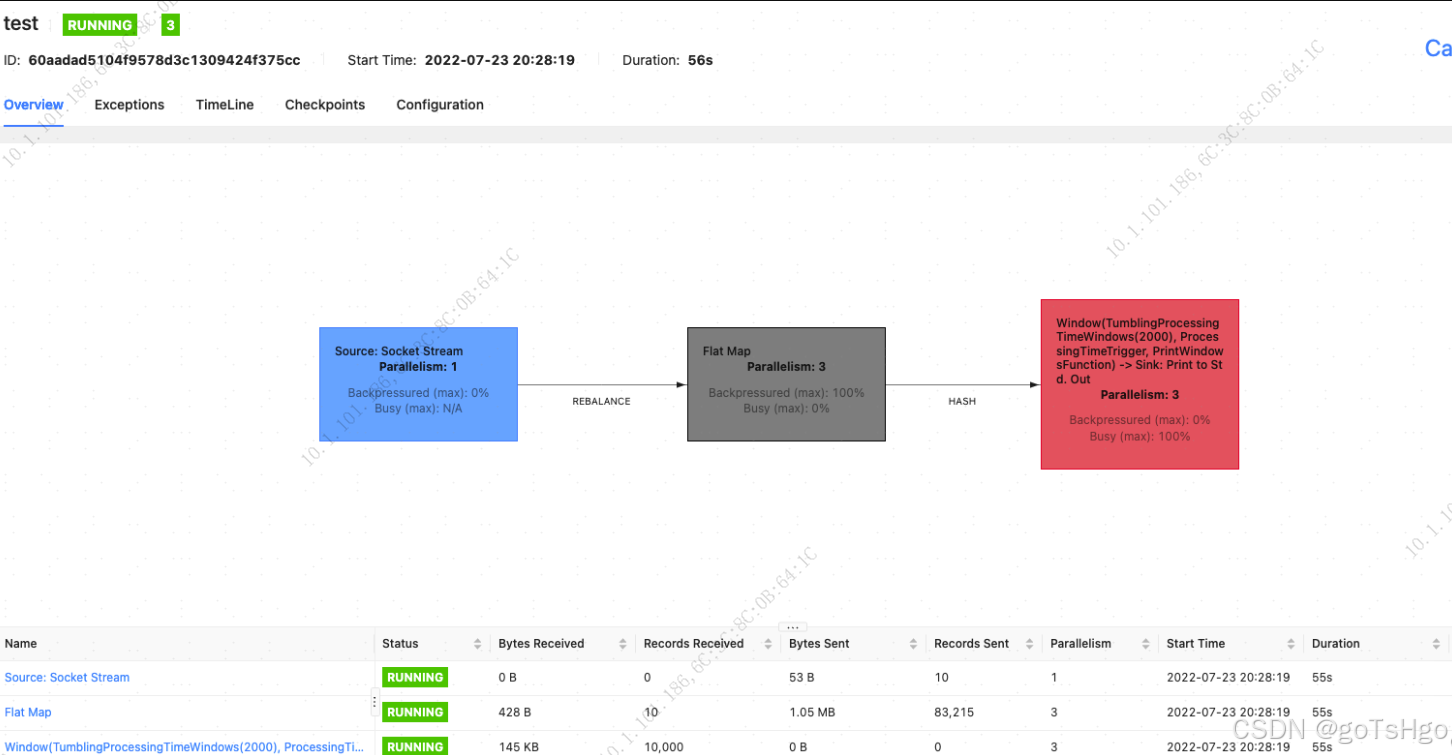

3. 从 Web UI 查看反压信息

除了火焰图,Flink Web UI 还提供了一些其他反压相关的信息,这些信息可以和火焰图结合起来使用。

3.1 查看反压等级

在 Flink Web UI 中,反压信息可以在每个算子(operator)级别上看到。在 Web UI 的作业详情页面,点击每个任务,可以看到一个指标叫 Backpressure(反压)。该指标有三种状态:

- No Backpressure: 没有反压。

- Low Backpressure: 轻微的反压,表明某些子任务正在缓慢处理数据。

- High Backpressure: 表示存在严重的反压,某些子任务由于处理速度过慢,导致了明显的反压。

通过查看反压状态,你可以进一步缩小火焰图中需要重点分析的算子范围。

3.2 查看 Task 的延迟和吞吐量

Flink Web UI 也提供了每个 Task 的延迟(Latency)和吞吐量(Throughput)数据。通过这些数据,你可以找到性能异常的算子或任务,并结合火焰图分析这些任务的 CPU 使用情况,确定性能瓶颈。

4. 如何解决反压问题

通过火焰图和 Web UI 的结合,可以定位到导致反压的具体算子或任务。解决反压问题的一些常见方法包括:

-

增加并行度:对于处理速度慢的算子,可以通过增加并行度来提升处理能力。

val stream = env.addSource(source).setParallelism(8) -

优化外部系统:如果问题出在外部系统(如数据库、Kafka),可以优化外部系统的性能,或者采用批量操作、异步处理等方式来减轻压力。

-

优化算子逻辑:通过分析火焰图中消耗时间最多的代码路径,优化算子的处理逻辑,减少复杂计算的时间。

-

减少数据量或提前过滤:如果数据量过大,可以考虑在

join或聚合之前对数据进行过滤,减少后续处理的数据量。 -

调整 TaskManager 配置:如果反压是由于 GC 或内存不足引起的,可以通过调整 TaskManager 的内存配置、GC 参数等来缓解问题。

总结

通过 Flink 的火焰图,你可以清晰地了解作业中各个算子的 CPU 时间分布,进而发现处理速度慢的地方。结合 Flink Web UI 提供的反压状态、延迟和吞吐量信息,可以有效定位和解决反压问题。火焰图是一个强有力的工具,能够帮助你快速找到导致反压的具体原因,从而进行针对性的优化。