多模态大型语言模型(MLLM)综述

目录

多模态大语言模型的基础

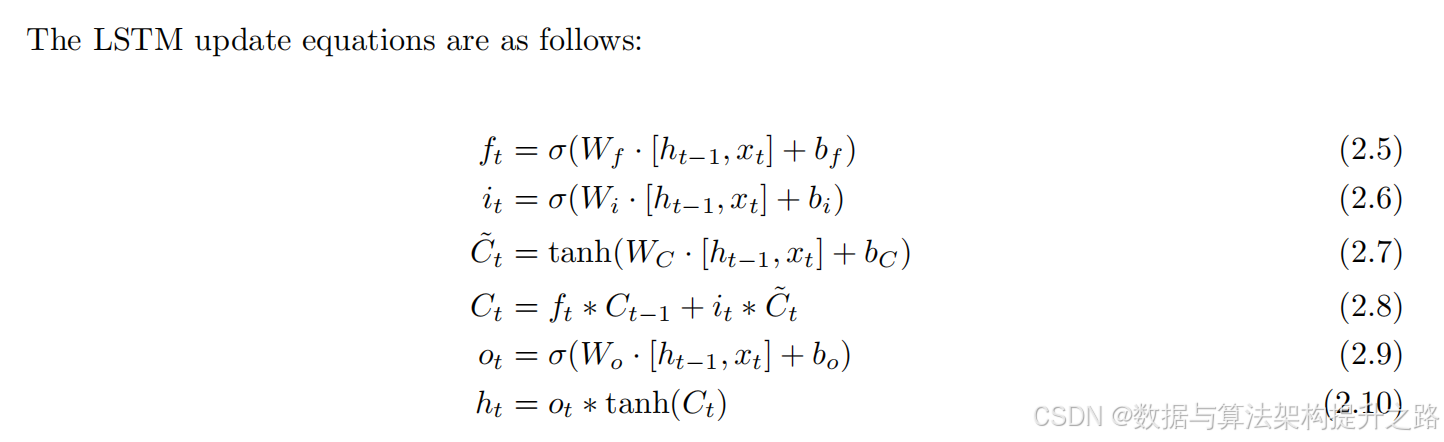

长短期网络结构(LSTM)

自注意力机制

基于Transformer架构的自然语言处理模型

多模态嵌入概述

多模态嵌入关键步骤

多模态嵌入现状

TF-IDF

TF-IDF的概念

TF-IDF的计算公式

TF-IDF的主要思路

TF-IDF的案例

训练和微调多模态大语言模型(MLLM)

训练大模型

对比学习 (CLIP, ALIGN)

掩码语言模型(MLM)

视觉问答(VQA)预训练

视觉与语言预训练(VLP)

微调大模型

MLLM 在视觉语言任务中的应用

图像字幕与 VQA

视觉叙事与场景理解

MLLM 在 Cross-Modal 检索和搜索中的应用

突出的多模态大语言模型案例研究

图片生成

代码生成

搜索与信息检索

检索增强生成 (RAG)

道德考量与负责任的人工智能

多模态大语言模型的基础

长短期网络结构(LSTM)

1. LSTM通过复杂的门控机制比标准RNN更有效地捕捉长期依赖性。

2. LSTM在机器翻译、语音识别和文本摘要等NLP任务中取得了特别的成功。

3. RNN和LSTM在NLP领域发挥了关键作用,是许多先进模型的基础架构。

4. 它们处理序列数据和捕捉时间依赖性的能力对提高多种语言相关任务的性能至关重要。

5. 尽管最近的Transformer架构在许多应用中超越了RNN和LSTM&#x