DeepSeek-R1 本地部署教程(超简版)

文章目录

- 一、DeepSeek相关网站

- 二、DeepSeek-R1硬件要求

- 三、本地部署DeepSeek-R1

- 1. 安装Ollama

- 1.1 Windows

- 1.2 Linux

- 1.3 macOS

- 2. 下载和运行DeepSeek模型

- 3. 列出本地已下载的模型

- 四、Ollama命令大全

- 五、常见问题解决

- 附:DeepSeek模型资源

一、DeepSeek相关网站

官方网站:DeepSeek

开源模型:https://huggingface.co/deepseek-ai

GitHub地址:https://github.com/deepseek-ai

接口文档:首次调用 API | DeepSeek API 文档

二、DeepSeek-R1硬件要求

以下是 DeepSeek-R1 系列模型在不同规模下的硬件需求(以 Q4_K_M 量化 为例)。这些需求是估算值,实际需求可能因实现方式和上下文长度而有所不同:

| 模型规模 | 显存需求 (Q4_K_M) | 硬件需求说明 |

|---|---|---|

| 1.5B | ~1.5 GB | 轻量级,适合大多数消费级 GPU(如 GTX 1060 以上) |

| 7B | 4.7 GB | 示例数据(Q4_K_M 量化),需要中端 GPU(如 RTX 3060) |

| 8B | ~5.4 GB | 略高于 7B,适合 RTX 3060/3070 |

| 14B | ~9.4 GB | 需要高端消费级 GPU(如 RTX 3080/3090) |

| 32B | ~21.5 GB | 需要专业级 GPU(如 A100 或 3090 24GB) |

| 70B | ~47 GB | 通常需要多 GPU 或 云服务器(如 A100 40GB) |

| 671B | ~450 GB | 仅适合分布式系统或超大规模集群 |

说明:

-

量化方式:假设使用 4-bit 量化(Q4_K_M),显存需求较低。如果使用 FP16/32,显存需求会大幅增加(如 7B FP16 需要约 14 GB)。

-

硬件建议:

1.5B-14B:适合消费级 GPU,如 RTX 3060/3080。

32B-70B:需要专业级 GPU 或多 GPU 并行。

671B:仅适合超大规模集群或分布式系统。 -

上下文长度:长上下文会进一步增加显存需求,建议根据实际场景调整硬件配置。

如果需要更高精度(如 FP16/32)的显存需求,可以按比例估算(FP16 约为 Q4_K_M 的 4 倍)

三、本地部署DeepSeek-R1

1. 安装Ollama

https://ollama.com/download

根据你的操作系统选择安装方式:

1.1 Windows

- 访问 https://ollama.com/download/windows 下载Windows安装程序。

- 双击安装,完成后在命令行输入

ollama验证。

1.2 Linux

curl -fsSL https://ollama.ai/install.sh | sh

1.3 macOS

方式1:直接下载安装,访问 https://ollama.com/download/mac 下载macOS安装包,双击安装。

方式2:Homebrew 安装

brew install ollama

2. 下载和运行DeepSeek模型

访问 ollama 网站 deepseek-r1 各个版本:https://ollama.com/library/deepseek-r1

选择电脑符合条件的模型规模,复制命令。

- 方式一:直接运行

以使用70b为例,打开命令行粘贴或输入:

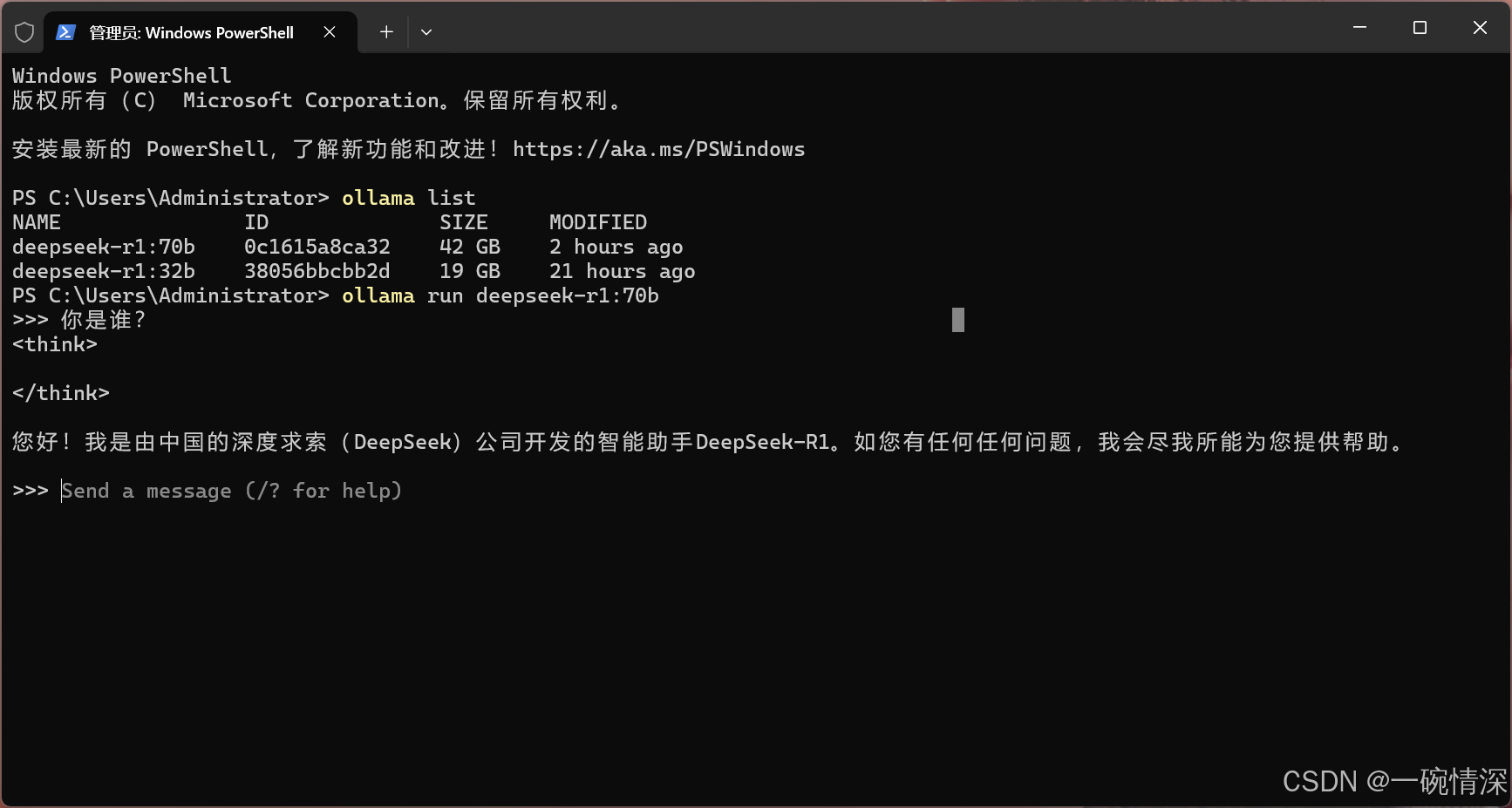

ollama run deepseek-r1:70b

当我们没有该模型时会自动下载并运行,如果已经下载完成,运行该命令则直接启动。

运行后出现以下提示表示成功:

>>> Send a message (/? for help)

- 方式二:下载并部署

拉取的过程后面可能会很慢,对于 linux 和 mac 使用挂在后台拉取:

nohup ollama pull deepseek-r1:70b &

3. 列出本地已下载的模型

ollama list

四、Ollama命令大全

| 命令 | 描述 | 示例 |

|---|---|---|

| ollama run [model-name] | 启动模型并与之交互 | ollama run deepseek-r1:7b |

| ollama list | 列出本地已下载的模型 | ollama list |

| ollama pull [model-name] | 从模型库中下载一个模型 | ollama pull deepseek-r1:7b |

| ollama rm [model-name] | 删除本地的一个模型 | ollama rm deepseek-r1:7b |

| ollama show [model-name] | 查看某个模型的详细信息 | ollama show deepseek-r1:7b |

| ollama serve | 启动 Ollama 服务 | ollama serve |

| ollama stop | 停止 Ollama 服务 | ollama stop |

| ollama logs | 查看 Ollama 的日志信息 | ollama logs |

| ollama create [model-name] -f [config-file] | 使用自定义的模型配置文件创建模型 | ollama create deepseek-r1:7b -f ./my-model-config.yaml |

| ollama export [model-name] [output-file] | 导出模型为文件 | ollama export deepseek-r1:7b ./llama2-model.tar |

| ollama import [input-file] | 从文件导入模型 | ollama import ./llama2-model.tar |

| ollama version | 查看 Ollama 的版本信息 | ollama version |

| ollama --help | 查看所有可用的命令及其说明 | ollama --help |

五、常见问题解决

- 模型不存在?

确认模型名称正确,或访问DeepSeek官网获取最新模型名称。 - 网络问题

配置代理(Linux/macOS):

export HTTP_PROXY=http://127.0.0.1:7890

export HTTPS_PROXY=http://127.0.0.1:7890

附:DeepSeek模型资源

- DeepSeek-R1:https://github.com/deepseek-ai/DeepSeek-R1

- 官方模型库:https://huggingface.co/deepseek-ai

- Ollama文档:https://github.com/ollama/ollama