AnaXNet: Anatomy Aware Multi-label Finding Classification in Chest X-ray

文章来源:[MICCAI 2021]

代码:https://github.com/Nkechinyere-Agu/AnaXNet

Keywords:Graph Convolutional Networks · Multi-Label Chest X-ray image classification · Graph Representation

本文提出的问题以及解决方案:

与上篇文章类似,都是围绕着anatomical regions,本文是一篇多标签胸部X-ray分类。医生在对X-ray图像做决策时都是关注于每一个解剖学区域,然而目前的深度学习方法只关注于图像的整体,不能充分利用解剖学信息。另外,虽然有一些工作是基于注意力机制或者辅助任务(auxiliary tasks),但是都没有考虑对解剖学区域以及findings之间进行相关性建模,例如输出每个findings的解剖学位置语义。

本文提出的多标签胸部X-ray分类模型能够准确对图像进行分类并且定位正确的解剖学区域。

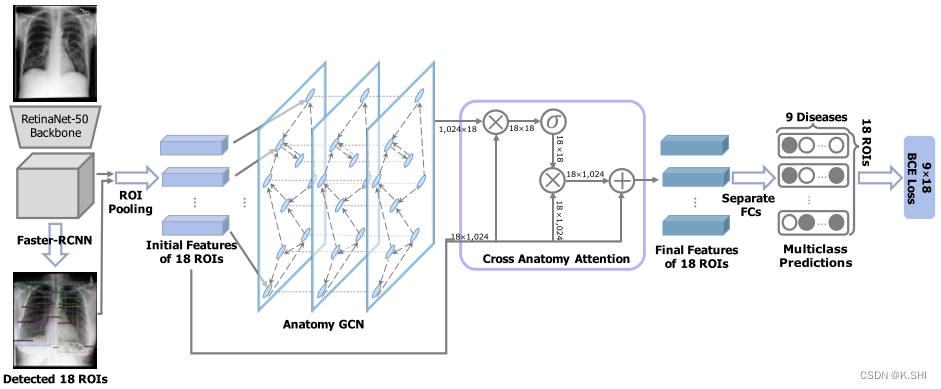

模型包含两部分,一是检测模块(detection module),二是解剖学依赖模块(anatomical dependency module)。后者使用GCN,使模型不仅能学习标签依赖性,还能学习胸部X-ray中解剖区域之间的关系。

Methodology

1、问题的定义

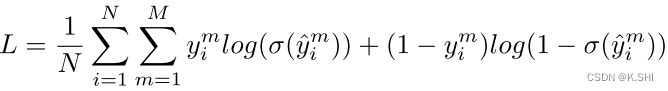

chest-X ray images C = { x 1 , . . . , x N } C = \{x_1, . . . , x_N\} C={x1,...,xN}, 每一个图像 x i x_i xi中的标签 Y i = { y i 1 , . . . , y i M } ,其中 y i m ∈ { 0 , 1 } Yi = \{y_i^1 , . . . , y_i^M \},其中y_i^m\in\{0,1\} Yi={yi1,...,yiM},其中yim∈{0,1}表示病理(pathology)M是否在 x i x_i xi中出现。最后的目标是预测给定图像的label set。

2、模型结构

- Faster-RCNN:提取解剖ROIs以及相对应的特征

- Anatomy GCN:将得到的特征向量输入到GCN中学习相互依赖关系

- Cross Anatomy Attention:将输出与注意力机制相结合

- FC:进行多标签分类预测

2.1 Faster-RCNN

在上图中,提取了18个ROIs,即本文中的k,每一个区域的embedding的维度为d。因此, R i = f ( x i ) ∈ R k × d R_i = f(x_i) \in R^{k \times d} Ri=f(xi)∈Rk×d。

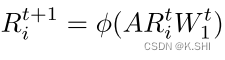

2.2 Anatomy GCN

对解剖区域表征

R

i

R_i

Ri做初始化,本文定义了一个normalized adjacency matrix

A

∈

R

k

×

k

A \in R^{k \times k}

A∈Rk×k捕获区域之间的关联,然后利用GCN来更新

R

i

R_i

Ri,这里就是GCN的基本操作。

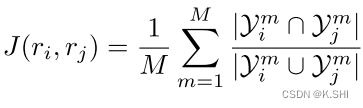

对于上面提到的邻接矩阵A,本文对label pairs使用解剖学区域共现(co-occurrence)的方式提取,共现矩阵基于Jaccard相似性计算:

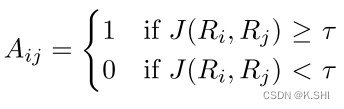

然而,这种标签共现构造可能由于包含有噪声的罕见出现而使训练数据过拟合,因此本文添加了阈值进行过滤:

2.3 Cross Anatomy Attention

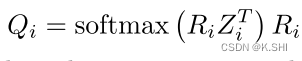

为了获取解剖学区域中全局和局部的依赖,使用了a non-local operation that resembles self-attention:

上述公式为将GCN的输出与原始的

R

i

R_i

Ri相乘,经过softmax后再与

R

i

R_i

Ri相乘,可以从framework中的流程与公式相对应。

2.4 FC层

最后的预测是将

R

i

与

Q

i

R_i与Q_i

Ri与Qi拼接再经FC层获得label的预测。