TensorFlow:GPU的使用

**引言**

TensorFlow 是一个由 Google 开发的开源机器学习框架,它提供了丰富的工具和库,支持开发者构建和训练各种深度学习模型。而 GPU 作为一种高性能并行计算设备,能够显著提升训练深度学习模型的速度,从而加快模型迭代和优化的过程。因此,理解如何在 TensorFlow 中合理地利用 GPU 对深度学习任务进行加速是至关重要的。

**GPU 加速与深度学习**

深度学习模型的训练过程通常需要大量数据和复杂的计算,尤其是在处理图像、语音、自然语言处理等信息密集型任务时。在传统的 CPU 上进行这种大规模并行计算会受到性能限制,训练过程可能需要花费数天甚至数周的时间。而 GPU 由于其并行计算的优势,能够在深度学习任务中发挥出色的加速作用,显著缩短训练时间,提高模型训练效率。

**TensorFlow 中的 GPU 加速**

TensorFlow 提供了丰富的 GPU 加速功能,支持使用 NVIDIA 的 CUDA 和 cuDNN 库来与 NVIDIA GPU 协同工作。通过合理配置 TensorFlow 和 GPU,开发者可以充分利用 GPU 的并行计算能力来加速深度学习模型的训练和推理过程。

在 TensorFlow 中,可以通过以下几种方式来实现 GPU 加速:

1. 指定运行设备:在 TensorFlow 中,可以通过 `with tf.device('/GPU:0'):` 这样的语句来明确地将计算任务分配到 GPU 上进行处理。这样可以确保模型的计算操作能够在 GPU 上并行执行,充分利用 GPU 的计算资源。

2. 使用 tf.keras.layers 中的 GPU 加速层:TensorFlow 的高级 API 中提供了许多针对 GPU 加速优化过的层,比如 `tf.keras.layers.Conv2D` 和 `tf.keras.layers.Dense` 等。在构建深度学习模型时,使用这些 GPU 加速层可以充分发挥 GPU 的计算能力,提高模型训练的速度。

3. 分布式训练:TensorFlow 支持分布式训练,可以将训练任务分布到多个 GPU 或多台机器上进行并行计算,从而进一步提高训练速度和可扩展性。

4. TensorFlow Profiler:TensorFlow 提供了专门用于分析模型性能的工具,比如 TensorFlow Profiler,可以帮助开发者及时发现并优化模型中的性能瓶颈,从而充分发挥 GPU 的加速能力。

**GPU 驱动与环境配置**

除了在代码中进行相应的配置,合理配置 GPU 驱动及深度学习环境也是充分利用 GPU 加速的关键。首先确保计算机上合适的 NVIDIA GPU 已经安装正确的驱动程序,然后安装相应版本的 CUDA 和 cuDNN 库。此外,也需要根据 TensorFlow 版本选择适配的 GPU 支持库版本,确保环境的兼容性和稳定性。

**结语**

GPU 加速已经成为深度学习领域必不可少的一部分,而 TensorFlow 作为广泛应用的深度学习框架之一,也提供了丰富的 GPU 加速功能。通过合理地配置 TensorFlow 和 GPU,开发者可以充分利用 GPU 的并行计算能力,加速深度学习模型的训练和推理过程,从而提高工作效率和模型性能。未来,随着硬件技术的不断进步和深度学习框架的优化,我们有望看到更加高效和强大的 GPU 加速技术,为深度学习任务的处理提供更为便利和高效的计算支持。

在日常的深度学习工作中,合理地利用 GPU 加速技术不仅能够提高训练速度,还能够加速模型迭代和优化过程,帮助开发者更快地实现并部署各种深度学习应用。因此,深入理解 TensorFlow 中与 GPU 相关的知识,并灵活运用到实际工作中,将对提升深度学习模型的效率和性能起到重要作用。

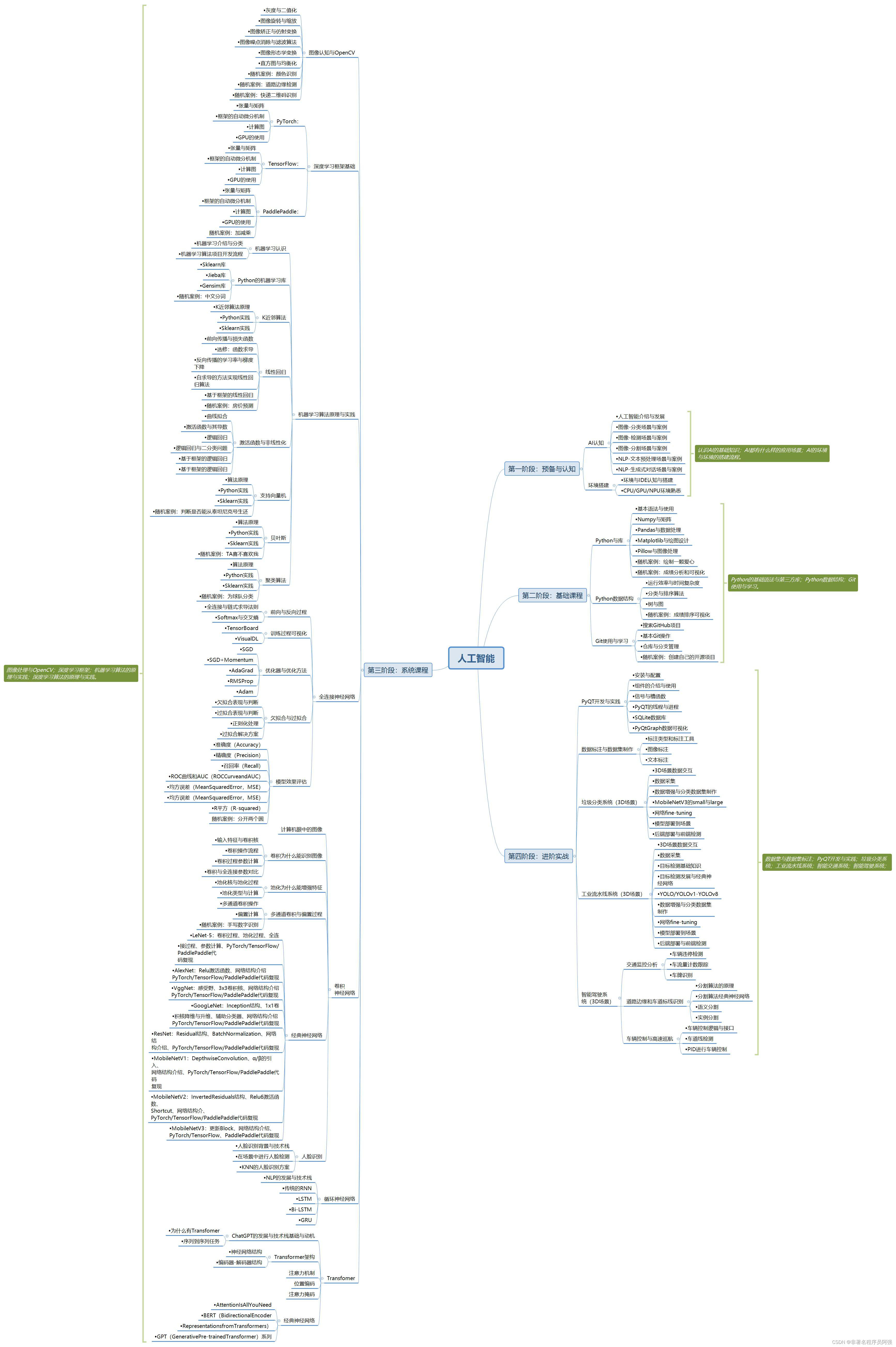

人工智能的学习之路非常漫长,不少人因为学习路线不对或者学习内容不够专业而举步难行。不过别担心,我为大家整理了一份600多G的学习资源,基本上涵盖了人工智能学习的所有内容。点击下方链接,0元进群领取学习资源,让你的学习之路更加顺畅!记得点赞、关注、收藏、转发哦!扫码进群领资料