深度学习记录--logistic回归损失函数向量化实现

前言

再次明确向量化的目的:减少for循环的使用,以更少的代码量和更快的速度来实现程序

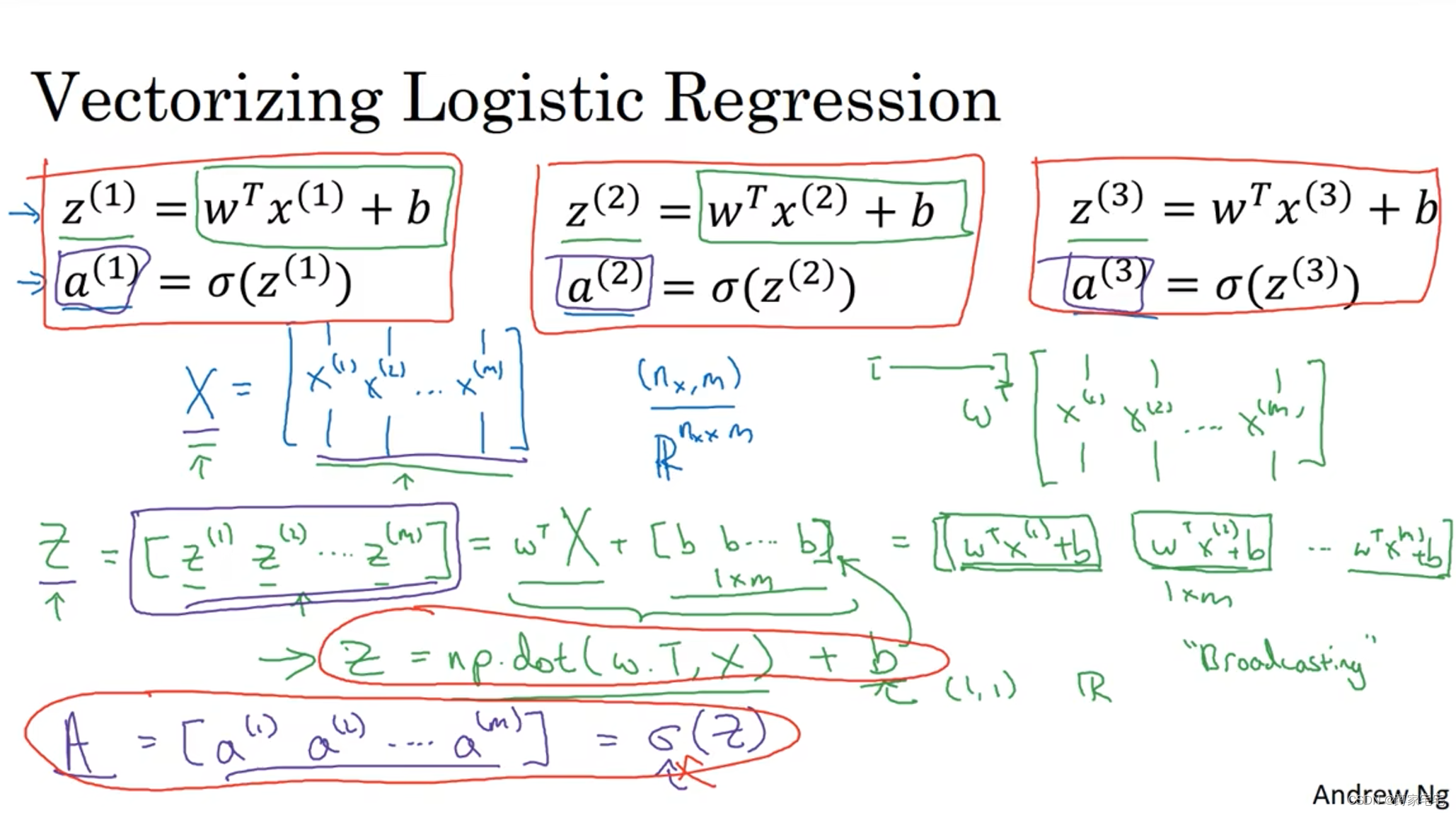

正向传播的向量化

对于,用向量化来实现,只需要

就可以完成,其中

,

,

ps.这里b只是一个常数,但是依然可以加在每个向量里(python的广播(Broadcasting))

激活函数,同样用向量化实现,只需要

就可以完成,其中

因此,正向传播的向量化,我们只用了两行代码就完成了

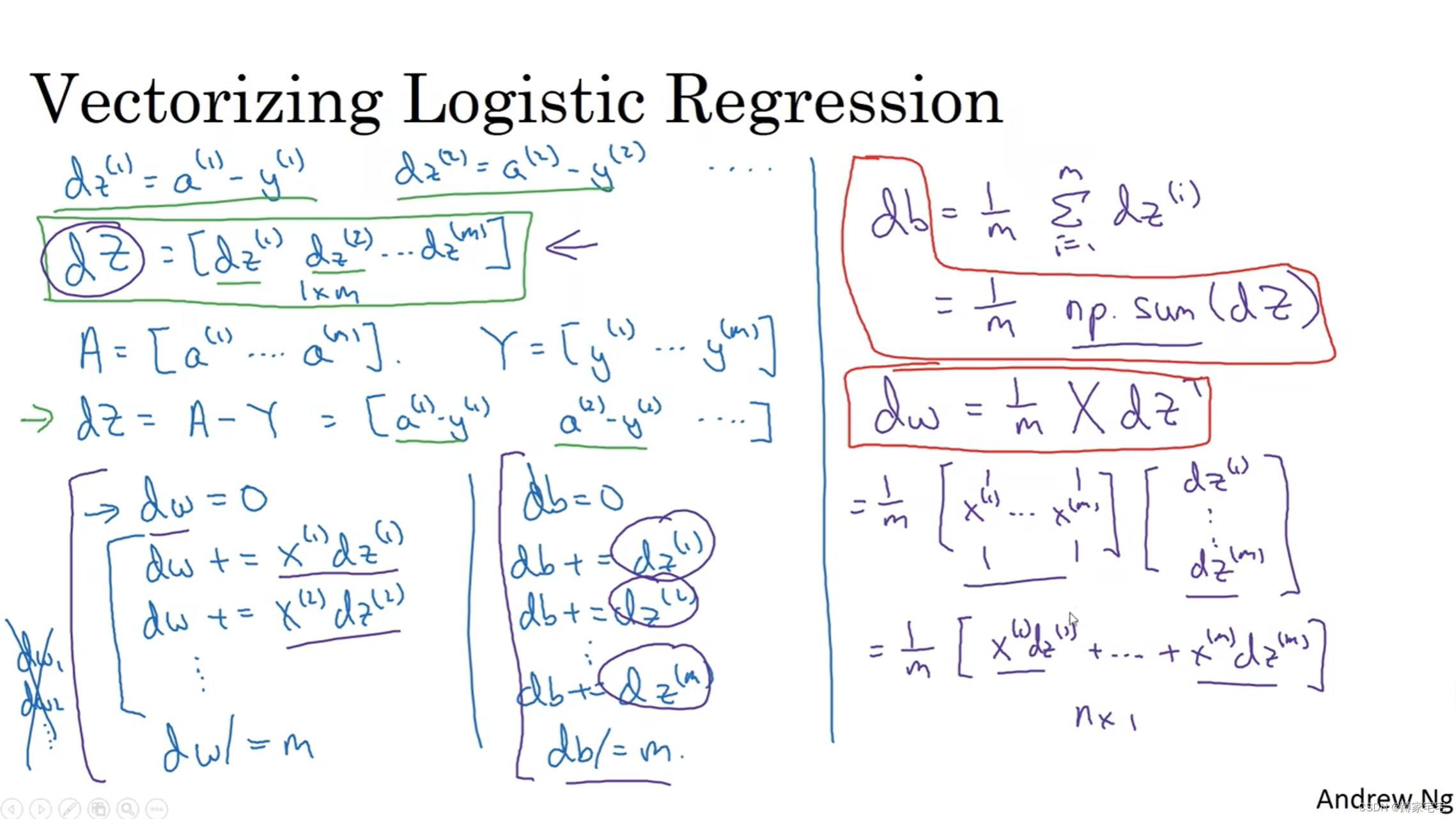

反向传播的向量化

与正向传播的向量化实现类似,也是用矩阵来计算

最后对w和b进行更新即可

当然,进行多次样本的训练还是要用for循环来实现,但是速度已经提升很多了