「深度学习」门控循环单元GRU

一、梯度消失问题

-

梯度消失:

基础的 RNN 模型不善于处理长期依赖关系,有很多局部影响,很难调整自己前面的计算。y^{<i>} 仅仅受自己附近的值影响。

-

解决方法:GRU 或 LSTM

-

梯度爆炸:

反向传播时,随着层数增多,梯度不仅可能指数型下降,还有可能指数型上升 —— 会导致参数过大,网络崩溃

解决方法:梯度修剪 —— 观察梯度向量,若大于某个阈值,则放缩梯度向量,保证其不会过大

二、GRU

目的:使隐藏层更好地捕捉深层连接,改善梯度消失的问题

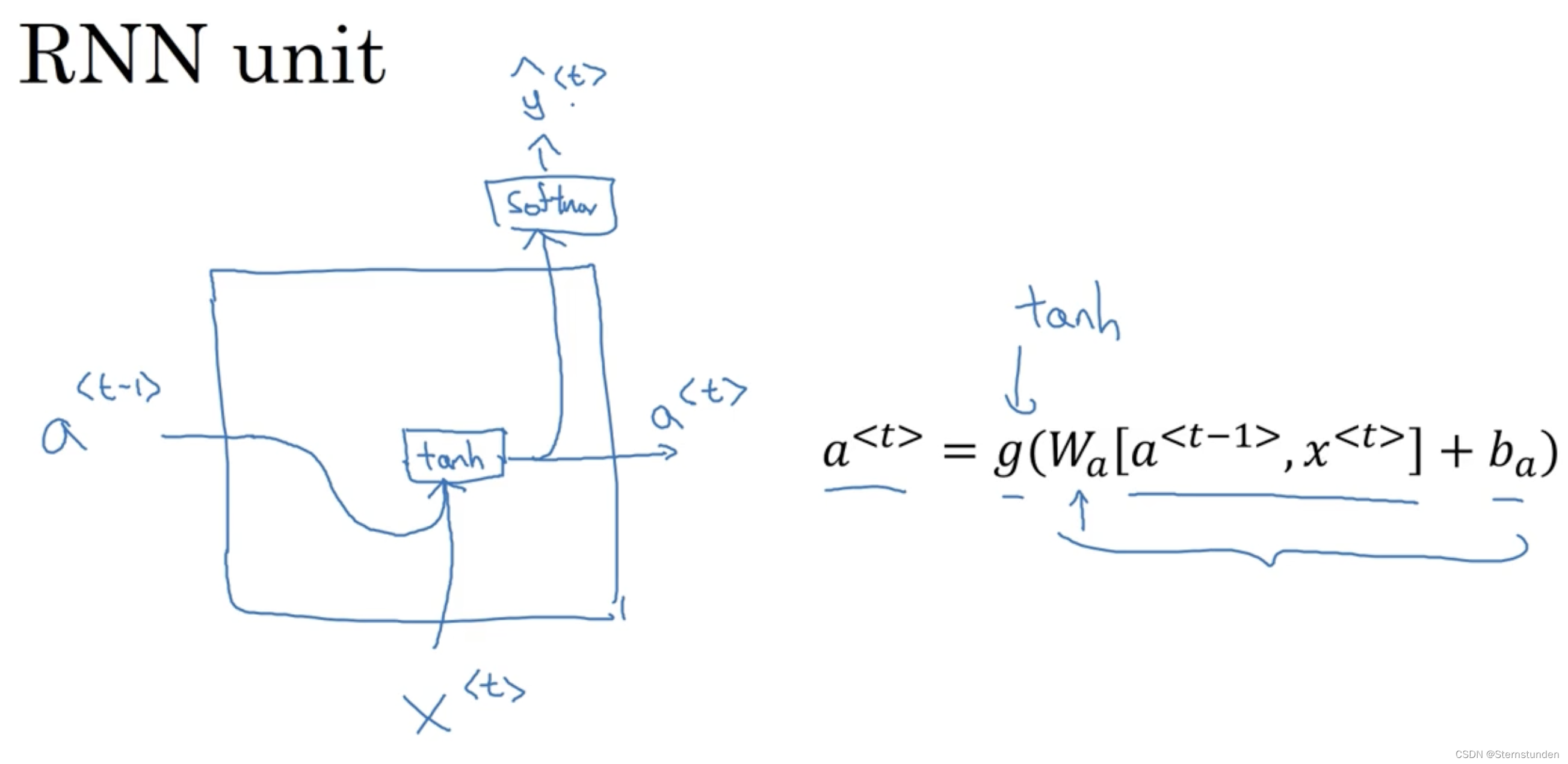

1. RNN 单元

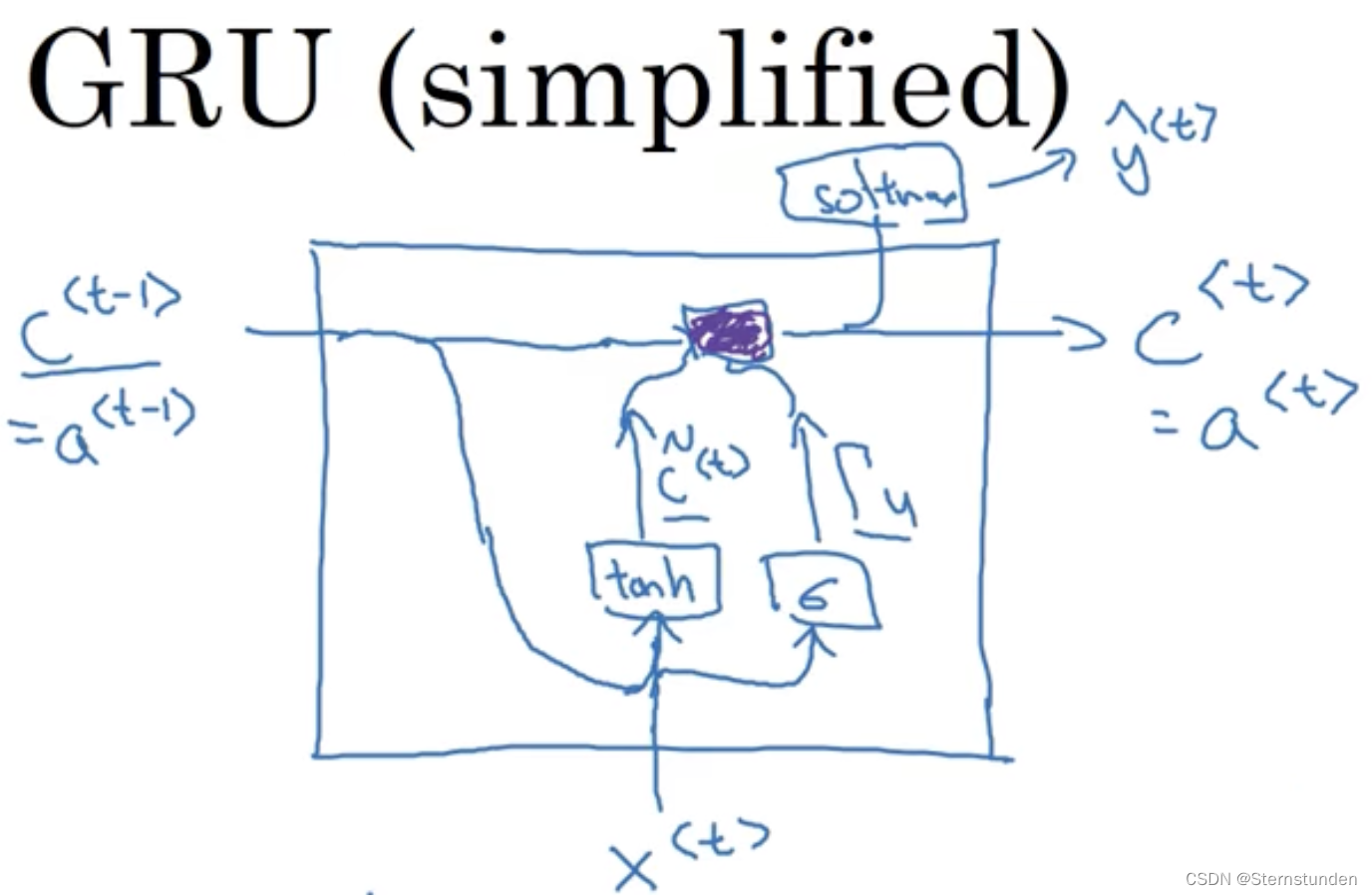

2. 简化版 GRU 单元

c = memory \space cell

c^{<t>} = a^{<t>}

-

c^{<t>} 的候选值:\widetilde{c}^{<t>} = tanh(w_{c}[c^{<t-1>},x^{<t>}]+b_{c})

-

核心思想 "门" - 决定什么时候更新:\Gamma_{u} = \sigma(w_{u}[c^{<t-1>},x^{<t>}]+b_{u})

u:“update”

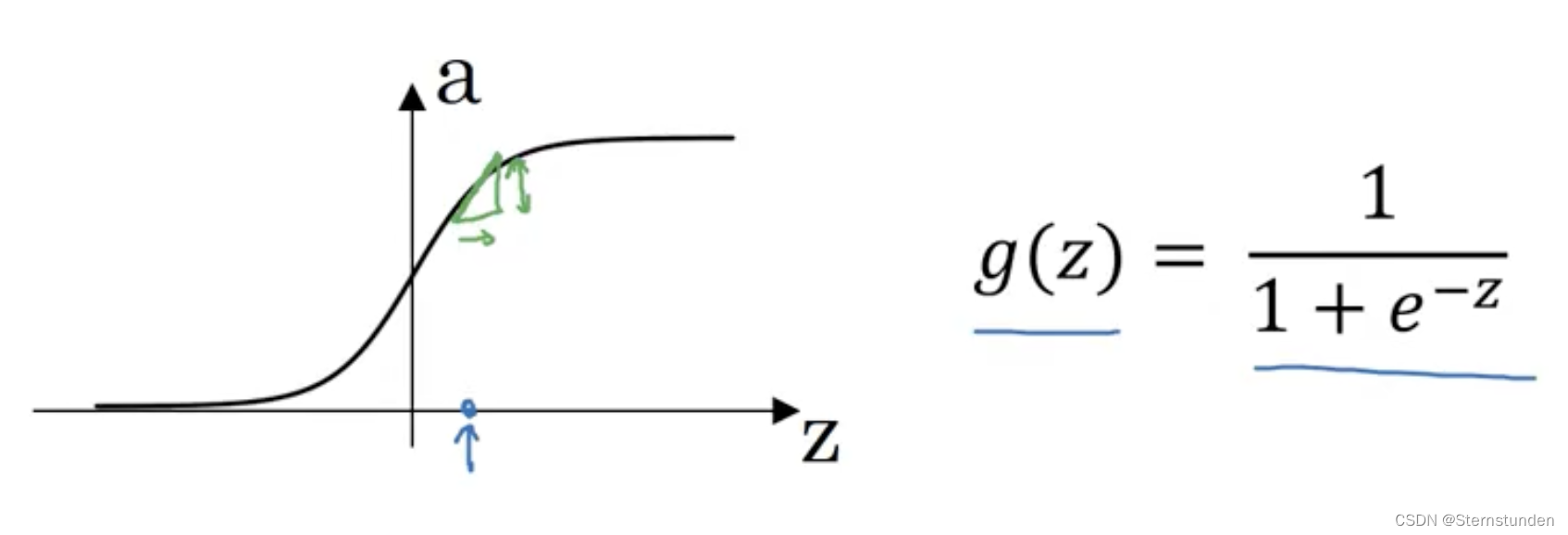

\Gamma_{u} 介于0到1之间,大多数情况下非常接近0或1

sigmoid 激活函数:

-

关键部分:c^{<t>} = \Gamma_{u}*\widetilde{c}^{<t>} + (1-\Gamma_{u})*\widetilde{c}^{<t-1>}

\Gamma_{u} = 1:将 c^{<t>} 更新为候选值

\Gamma_{u} = 0:保留原来的值

优点:若 \Gamma_{u} 接近0,c^{<t>}几乎等于c^{<t-1>},即使经过了很多层,c^{<t>}的值依然会被保留,故可以缓和梯度下降带来的问题。

c^{<t>} 可以是向量,用不同的bit去记忆不同的单词。

3. 完整版 GRU

\widetilde{c}^{<t>} = tanh(w_{c}[\Gamma_{r}*c^{<t-1>},x^{<t>}]+b_{c})

\Gamma_{u} = \sigma(w_{u}[c^{<t-1>},x^{<t>}]+b_{u})

- \Gamma_{r} = \sigma(w_{r}[c^{},x^{}]+b_{u})

r:"relevance"

表示计算出的 \widetilde{c}^{<t>} 与 c^{<t-1>} 有多大的相关性

c^{<t>} = \Gamma_{u}*\widetilde{c}^{<t>} + (1-\Gamma_{u})*\widetilde{c}^{<t-1>}

a^{<t>} = c^{<t>}