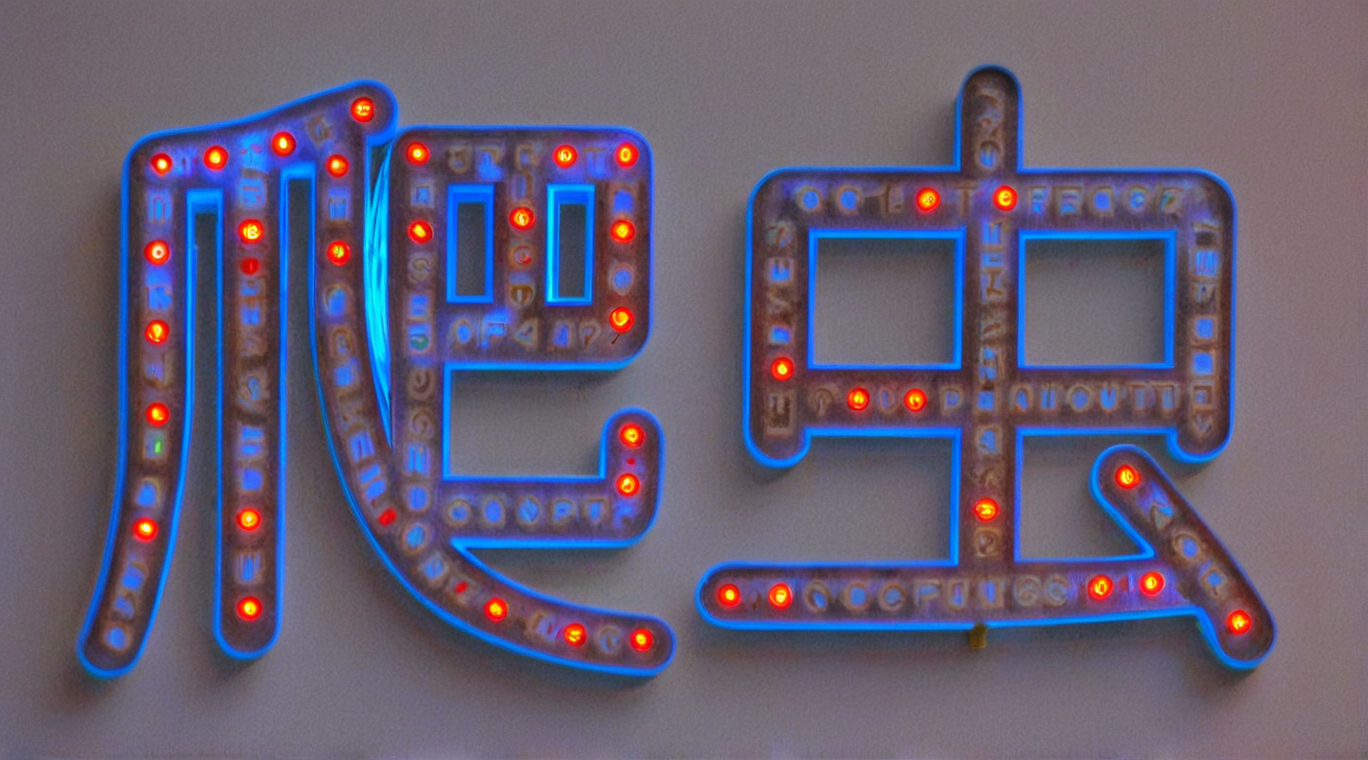

Java爬虫开发:Jsoup库在图片URL提取中的实战应用

在当今的互联网时代,数据的获取和处理变得尤为重要。对于网站内容的自动化抓取,爬虫技术扮演着不可或缺的角色。Java作为一种广泛使用的编程语言,拥有丰富的库支持网络爬虫的开发。其中,Jsoup库以其简洁、高效的特点,成为处理HTML内容和提取数据的优选工具。本文将详细介绍如何使用Jsoup库开发Java爬虫,以实现图片URL的提取。

Jsoup库简介

Jsoup是一个用于解析HTML文档的Java库,它提供了非常便捷的API来提取和操作数据。Jsoup能够处理任意的无格式HTML文档,并且可以从中提取数据,操作元素,或者输出修改后的HTML。Jsoup的解析器非常宽容,能够处理各种糟糕的HTML代码。

环境准备

在开始编写代码之前,需要确保开发环境中已经安装了Java开发工具包(JDK)和构建工具(如Maven或Gradle)。此外,还需要将Jsoup库添加到项目的依赖中。

如果使用Maven,可以在pom.xml文件中添加以下依赖:

xml

<dependencies>

<dependency>

<groupId>org.jsoup</groupId>

<artifactId>jsoup</artifactId>

<version>1.13.1</version>

</dependency>

</dependencies>

如果使用Gradle,则在build.gradle文件中添加:

groovy

dependencies {

implementation 'org.jsoup:jsoup:1.13.1'

}

图片URL提取实战

1. 创建爬虫类

首先,创建一个Java类,用于实现爬虫的功能。

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.io.IOException;

import java.util.ArrayList;

import java.util.List;

public class ImageCrawler {

public static void main(String[] args) {

String url = "http://example.com"; // 目标网站URL

try {

List<String> imageUrls = fetchImageUrls(url);

imageUrls.forEach(System.out::println);

} catch (IOException e) {

e.printStackTrace();

}

}

private static List<String> fetchImageUrls(String url) throws IOException {

List<String> imageUrls = new ArrayList<>();

// 设置代理

String proxyHost = "www.16yun.cn";

String proxyPort = "5445";

String proxyUser = "16QMSOML";

String proxyPass = "280651";

Document document = Jsoup.connect(url)

.proxy(proxyHost, Integer.parseInt(proxyPort)) // 设置代理服务器

// 如果代理需要认证,可以使用以下方式(Jsoup 1.11.3及更高版本支持)

.header("Proxy-Authorization", "Basic " + Base64.getEncoder().encodeToString((proxyUser + ":" + proxyPass).getBytes()))

.get();

Elements images = document.select("img[src]");

for (Element image : images) {

String src = image.attr("src");

imageUrls.add(src);

}

return imageUrls;

}

}

2. 连接目标网站

使用Jsoup的connect方法连接到目标网站。这个方法会发送一个HTTP GET请求到指定的URL,并返回一个Document对象,该对象代表了网页的HTML内容。

3. 解析HTML并提取图片URL

通过Document对象,我们可以调用select方法来选择页面中的特定元素。在这个例子中,我们使用CSS选择器img[src]来选择所有具有src属性的img标签,这通常用于图片链接。

4. 存储和输出图片URL

将提取到的图片URL存储到一个列表中,并遍历列表输出每个URL。

异常处理

在网络爬虫的开发中,异常处理是非常重要的一环。在上述代码中,我们通过try-catch块来捕获可能发生的IOException,这可能是由于网络问题或目标网站不可访问造成的。

优化和注意事项

- 尊重Robots协议:在进行网页抓取前,应该检查目标网站的

robots.txt文件,确保爬虫的行为符合网站的规定。 - 设置User-Agent:有些网站会根据User-Agent来决定是否响应请求。在Jsoup中可以通过

.userAgent("Your User Agent")来设置。 - 处理相对URL:有时网页中的图片URL可能是相对路径,需要转换为绝对路径。可以使用

URL类来实现。 - 多线程爬取:对于大规模的数据抓取,可以考虑使用Java的并发工具来提高效率。

结论

Jsoup库为Java爬虫开发提供了强大的支持,使得图片URL的提取变得简单而高效。通过本文的介绍和示例代码,读者应该能够掌握使用Jsoup进行基本的网页内容抓取和数据处理。随着技术的不断进步,爬虫技术也在不断发展,掌握这些基础技能将为进一步的学习和实践打下坚实的基础。