小白学大模型:斯坦福CS25 Transformers与LLMs

CS25: Transformers United V4 是斯坦福大学(Stanford University)在2024年春季开设的一门课程,从4月4日持续到5月30日。这门课程专注于深度学习领域中的Transformers和大模型。

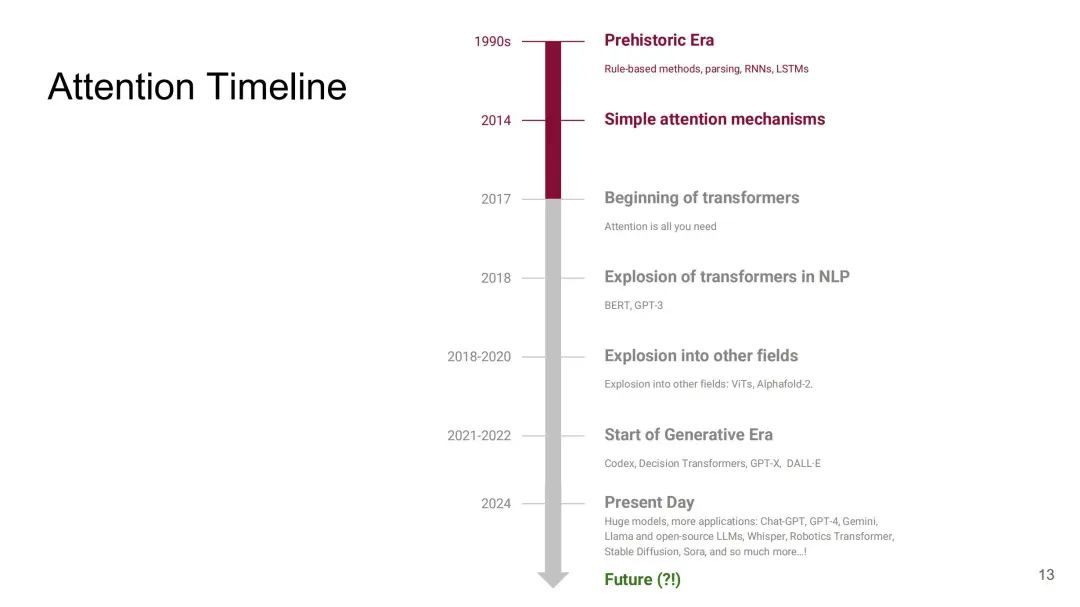

unsetunset技术发展时间轴unsetunset

-

1990年代:史前时代,基于规则的方法、解析、递归神经网络(RNNs)、长短期记忆网络(LSTMs)。

-

2014年:简单的注意力机制。

-

2017年:论文《Attention is all you need》标志着这一转变。

-

2018年:Transformers在自然语言处理(NLP)领域的爆炸性增长,BERT、GPT-3等模型的出现。

-

2018-2020年:Transformers扩展到其他领域,如视觉变换器(ViTs)、Alphafold-2等。

-

2021-2022年:生成时代的开始,Codex、决策变换器、GPT-X、DALL·E等模型的出现。

-

2024年:当前时代,大型模型和更多应用的出现,如Chat-GPT、GPT-4、Gemini、Llama、开源LLMs、Whisper、机器人变换器、Stable Diffusion、Sora等。

unsetunsetNLP技术介绍unsetunset

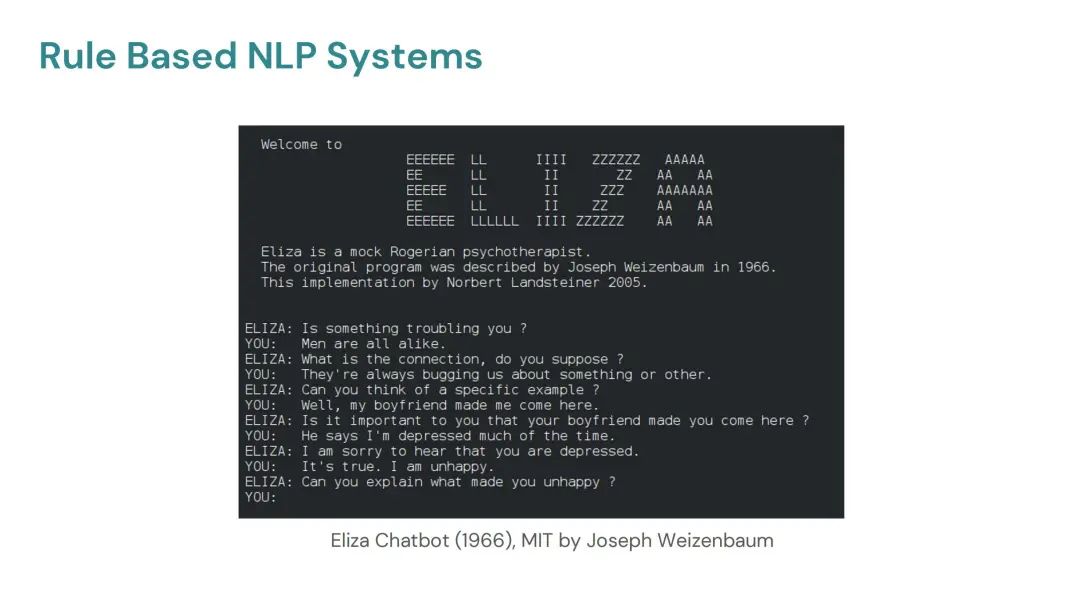

Eliza Chatbot(1966年,麻省理工学院,约瑟夫·魏岑鲍姆)

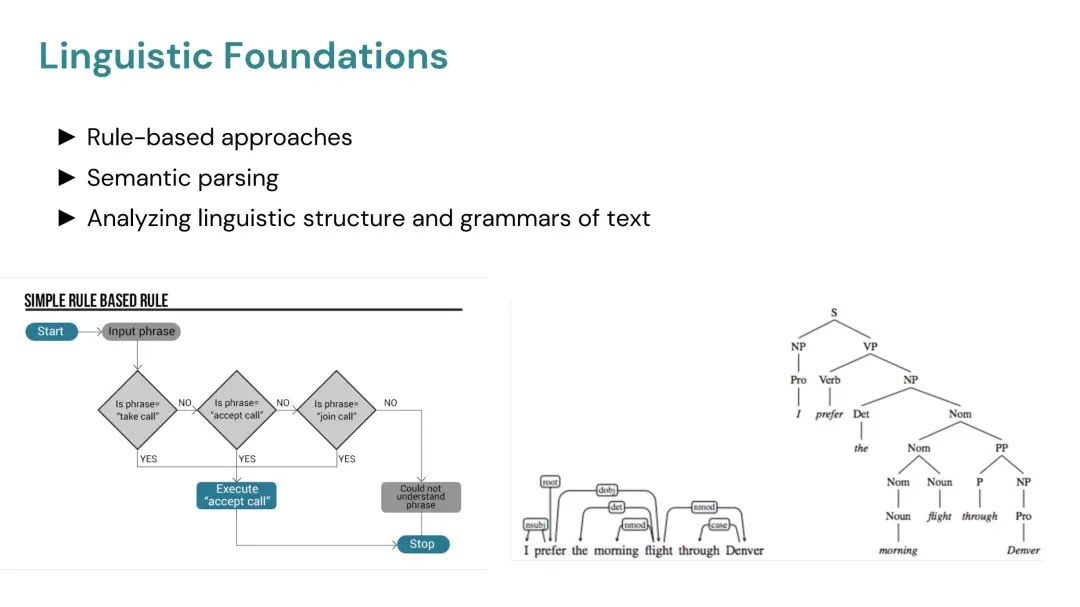

- 语言基础:基于规则的方法,语义解析,分析文本的语言结构和语法。

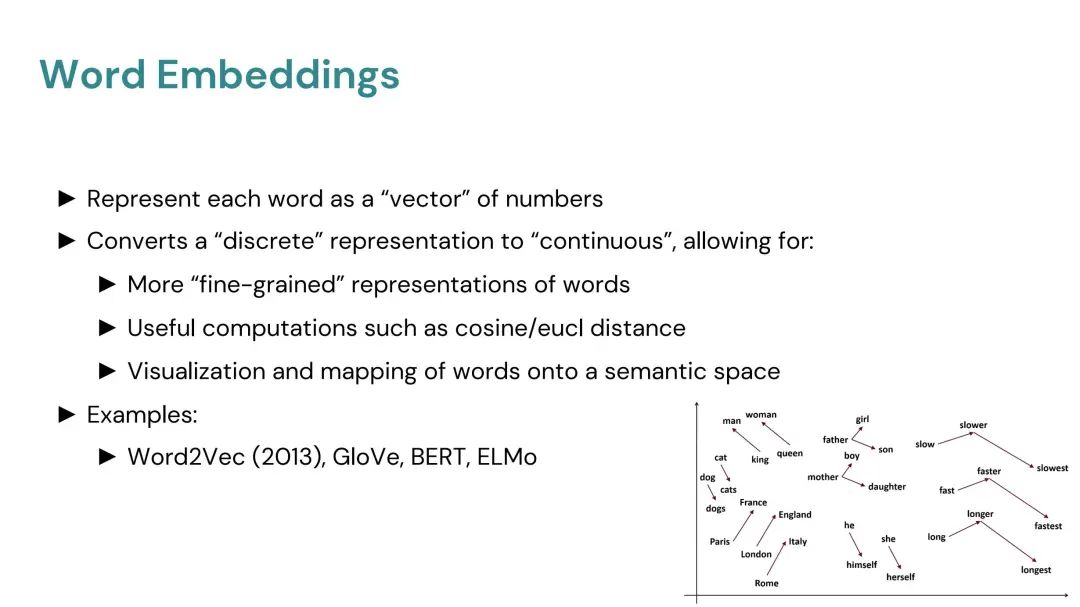

词嵌入技术

-

将每个词表示为一个“向量”数字。

-

将“离散”表示转换为“连续”的,允许更精细的词表示,以及余弦/欧几里得距离等有用计算,以及将词映射到语义空间的可视化。

-

例子包括:Word2Vec(2013年)、GloVe、BERT、ELMo。

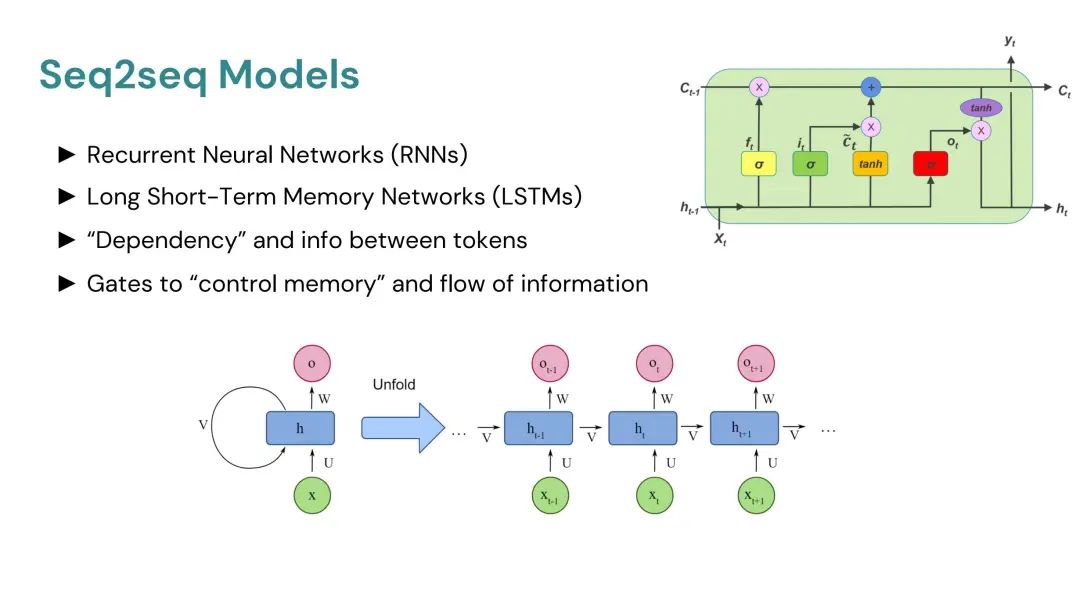

序列到序列模型(Seq2seq Models)

-

循环神经网络(RNNs)、长短期记忆网络(LSTMs)。

-

处理令牌之间的“依赖性”和信息。

-

通过门控控制信息的“记忆”和流动。

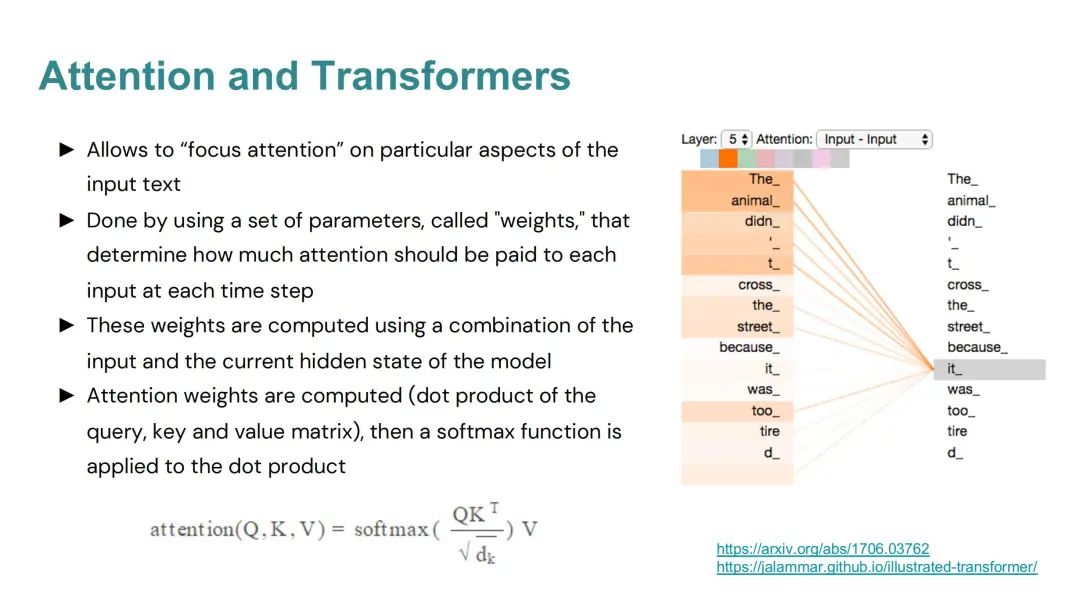

注意力机制和变换器(Attention and Transformers)

-

允许模型“聚焦”输入文本的特定方面。

-

通过一组称为“权重”的参数实现,这些权重决定了在每个时间步应该对每个输入关注多少。

-

这些权重是使用输入和模型当前隐藏状态的组合计算得出的。

-

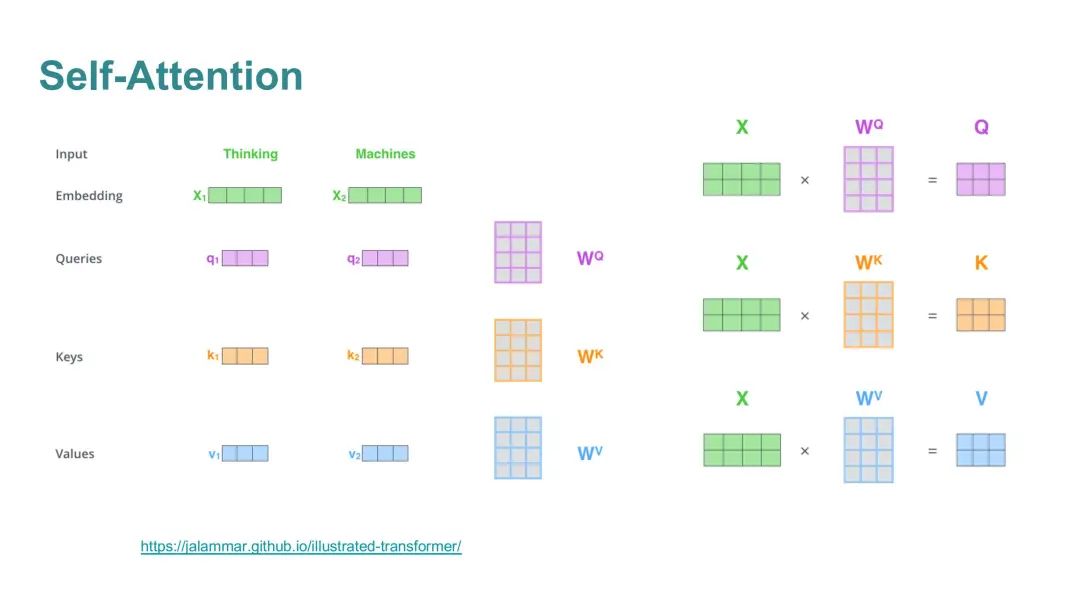

注意力权重通过查询、键和值矩阵的点积计算,然后对点积应用softmax函数。

Q、K、V的类比(Analogy for Q, K, V)

假设你正在寻找特定主题的信息(查询),每本书都有一个概要(键),帮助你识别它是否包含你要找的信息。一旦你找到查询和概要之间的匹配,你就可以访问这本书以获取所需的详细信息(值)。在注意力机制中,我们对多个值进行“软匹配”,例如从多本书中获取信息。

自注意力(Self-Attention)

- 允许模型在处理序列中的每个单词时,考虑序列中的其他单词,以更好地理解上下文和含义。

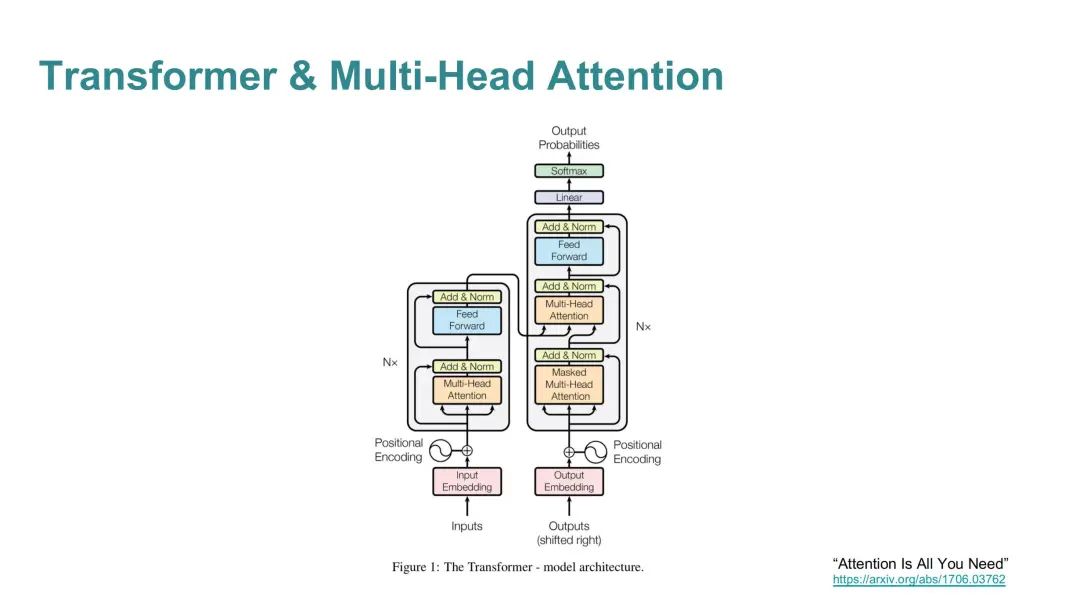

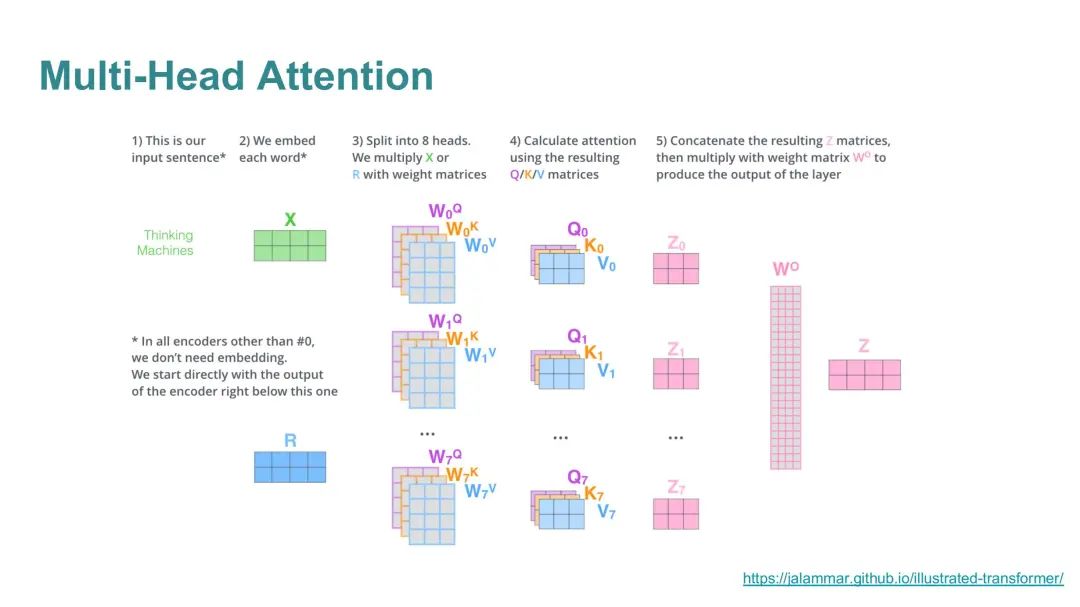

Transformer & Multi-Head Attention

-

Transformer完全基于注意力机制,不使用循环或卷积网络。

-

多头注意力允许模型在不同的表示子空间中联合关注信息,提高了模型的性能和泛化能力。

跨注意力(Cross-Attention,例如机器翻译)

- 在机器翻译等任务中,跨注意力允许模型关注输入序列的不同部分,以生成更准确的输出。

文章还提供了两个链接,一个是到变换器模型的原始论文《Attention Is All You Need》的链接,另一个是到一个详细解释变换器模型的图解指南。这些资源为读者提供了深入了解变换器模型的途径。

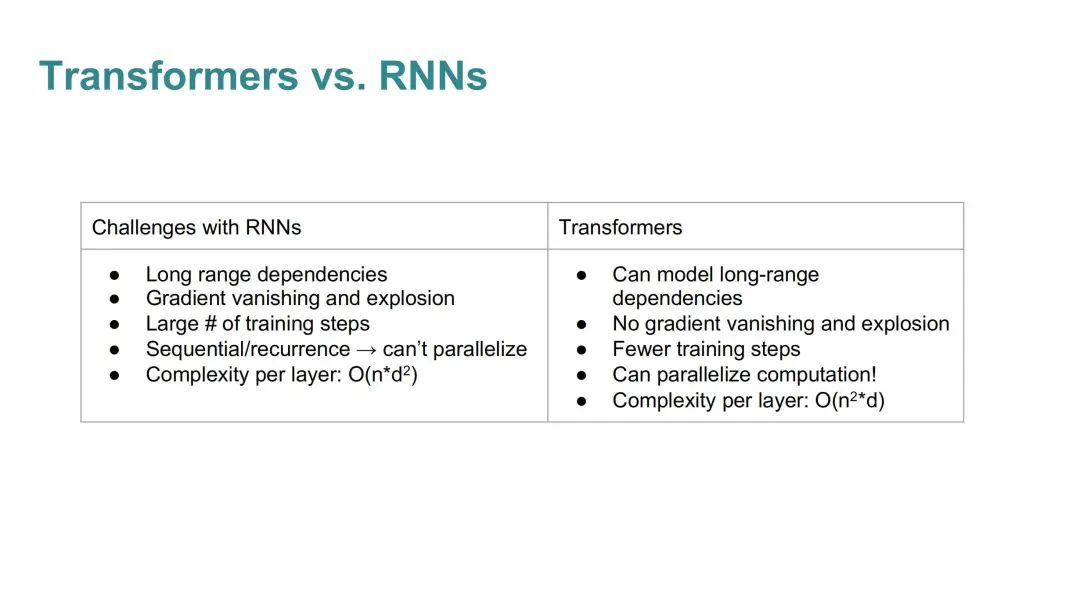

unsetunsetRNN 与 Transformers 对比unsetunset

在自然语言处理(NLP)领域,变换器(Transformers)和循环神经网络(RNNs)是两种处理序列数据的主要模型。以下是对这两种模型的对比:

循环神经网络(RNNs)

-

长距离依赖性(Long range dependencies):RNNs 在处理长距离依赖问题时表现不佳,因为随着序列的增长,信息可能会逐渐丢失。

-

梯度消失和梯度爆炸(Gradient vanishing and explosion):在训练过程中,RNNs 可能会遇到梯度消失或梯度爆炸的问题,这使得学习长序列变得困难。

-

大量的训练步骤(Large # of training steps):由于上述问题,RNNs 通常需要更多的训练步骤来收敛。

-

每层的复杂度(Complexity per layer):RNNs 的每层复杂度通常是 O(n*d^2),其中 n 是序列长度,d 是特征维度。这种复杂度随着序列长度和特征维度的增加而增加。

Transformers

-

长距离依赖性(Can model long-range dependencies):Transformers 能够更好地处理长距离依赖性,因为它们使用自注意力机制,可以直接捕捉序列中任意两个位置之间的关系。

-

无梯度消失和梯度爆炸(No gradient vanishing and explosion):Transformers 避免了梯度消失和梯度爆炸的问题,因为它们不依赖于链式法则来传递信息。

-

较少的训练步骤(Fewer training steps):由于上述优势,Transformers 通常需要较少的训练步骤来达到相同的性能。

-

可以并行化计算(Can parallelize computation):Transformers 的架构允许在整个序列上并行处理,这大大提高了训练效率。

-

每层的复杂度(Complexity per layer):Transformers 的每层复杂度是 O(n^2*d),虽然看起来比 RNNs 高,但由于可以并行化,实际上在实践中可以更快地处理。

针对所有自学遇到困难的同学们,我帮大家系统梳理大模型学习脉络,将这份 LLM大模型资料 分享出来:包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

👉[CSDN大礼包🎁:全网最全《LLM大模型入门+进阶学习资源包》免费分享(安全链接,放心点击)]()👈

unsetunset大型语言模型(LLMs)unsetunset

大型语言模型(LLMs)通常包含数百万到数十亿个参数,通常在大量“通用”文本数据(例如网络语料库)上进行训练。

-

训练目标通常是“下一个词预测”:给定前文的情况下预测下一个词的概率。

-

随着模型规模的增加,会出现“突现能力”,例如通过思考链(chain-of-thought)进行推理。

-

训练成本高昂,涉及时间、金钱和GPU资源。

-

更大的通用模型可以实现“即插即用”,通过少量或零次学习适应不同任务,无需重新训练。

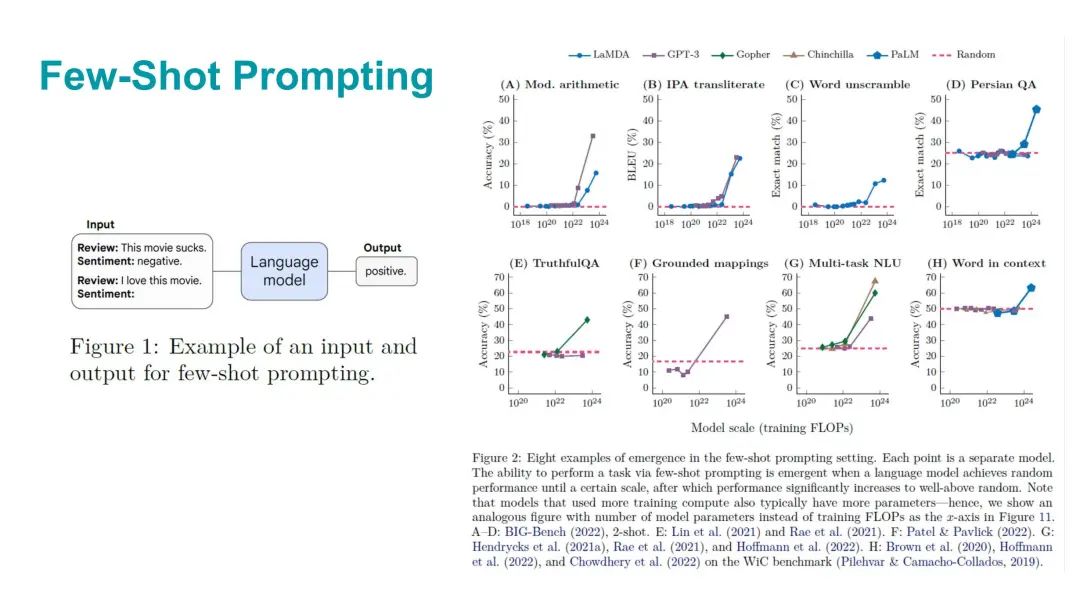

涌现能力

-

为什么大型语言模型效果这么好?随着规模扩大会发生什么?

-

潜在解释:突现能力。

-

如果一个能力在较大的模型中存在,而在较小的模型中不存在,则被认为是突现的。

-

这些能力不能通过简单外推较小模型的性能来直接预测。

-

性能在达到某个临界阈值之前接近随机,然后显著提高,这种现象被称为“相变”,不能通过检查较小规模的系统来预测。

unsetunset强化学习与人类反馈(RLHF)、ChatGPT、GPT-4和Geminiunsetunset

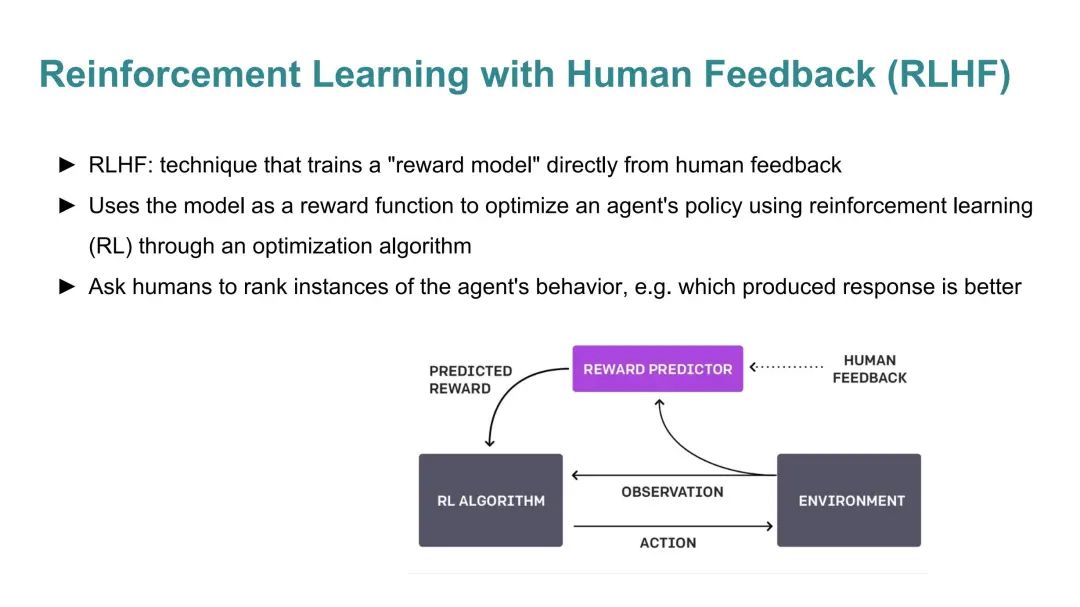

强化学习与人类反馈(RLHF)

-

RLHF是一种技术,它直接从人类反馈中训练一个“奖励模型”。

-

该技术使用模型作为奖励函数,通过优化算法在强化学习(RL)中优化代理的政策。

-

要求人类对代理的行为实例进行排名,例如哪个生成的响应更好。

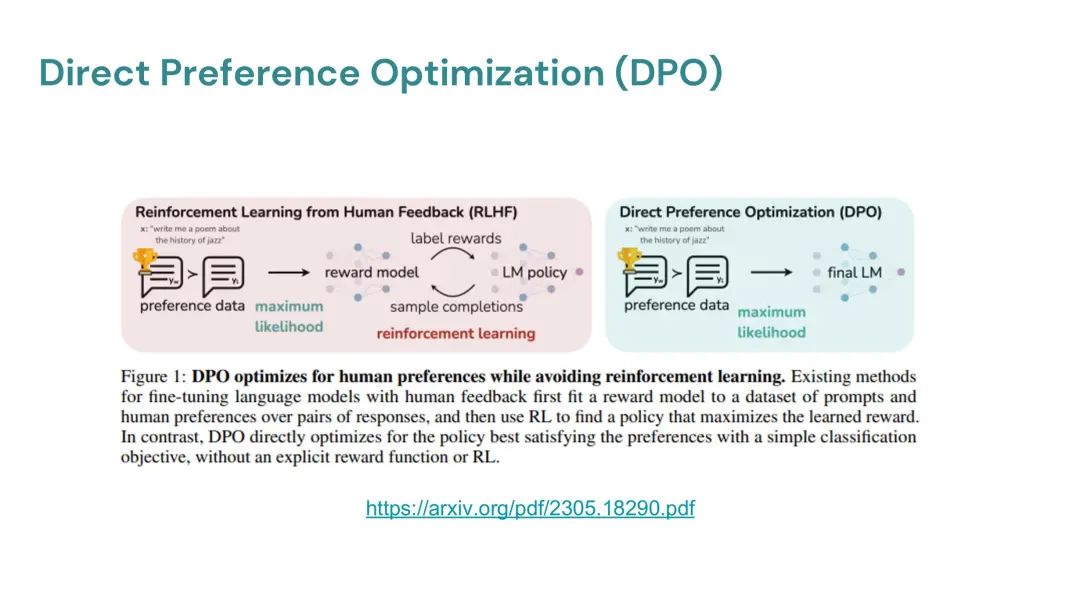

直接偏好优化(DPO)

-

DPO是一种新的参数化方法,它允许从简单的分类损失中提取相应的最优策略,消除了在微调期间从语言模型中采样或进行大量超参数调整的需要。

-

DPO在稳定性、性能和计算效率方面表现出色,并且实验表明DPO至少和现有方法一样有效,包括基于PPO的RLHF。

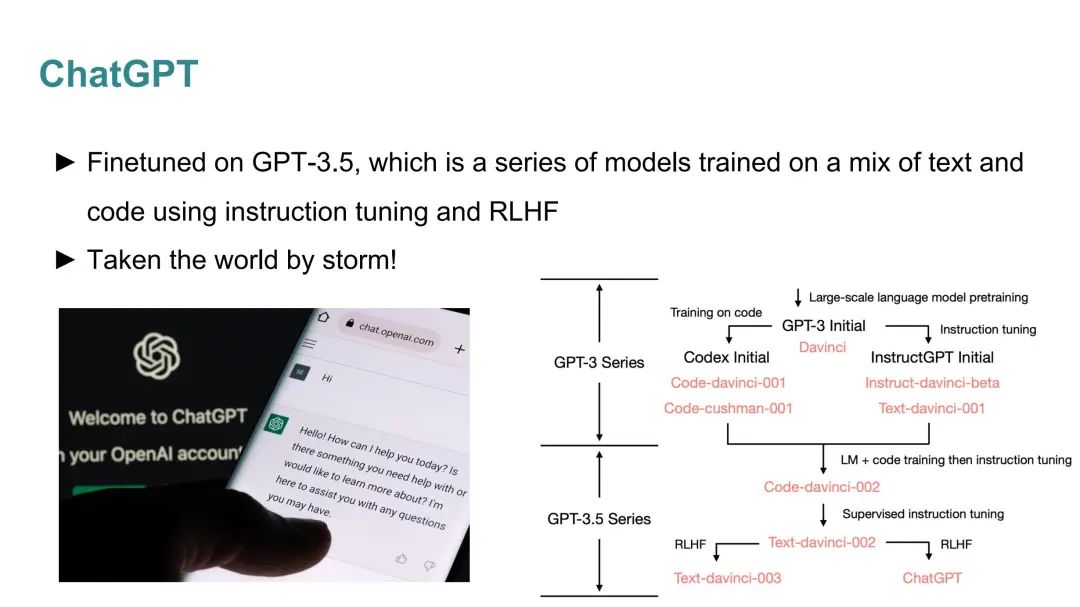

ChatGPT

- ChatGPT是在GPT-3.5的基础上微调的,GPT-3.5是一系列使用指令调整和RLHF训练的模型。

GPT-4

-

GPT-4在大型数据集上进行监督学习,然后进行RLHF和RLAIF(从人工智能反馈中进行强化学习)。

-

GPT-4在图像和文本上进行训练,具备视觉能力,能够讨论图像中的幽默、总结屏幕截图文本等。

-

GPT-4比GPT-3.5“更可靠、更有创意,并且能够处理更细微的指令”。

-

GPT-4具有更长的上下文窗口,能够处理8,192和32,768个令牌。

-

GPT-4在标准化测试中表现出色,但未发布GPT-4的技术细节。

Gemini

-

最新的Gemini 1.5 Pro版本。

-

Gemini Ultra在32个学术基准测试中的30个上表现优于ChatGPT,涉及推理和理解。

-

Gemini有效地处理和整合不同模态的数据:文本、音频、图像和视频。

-

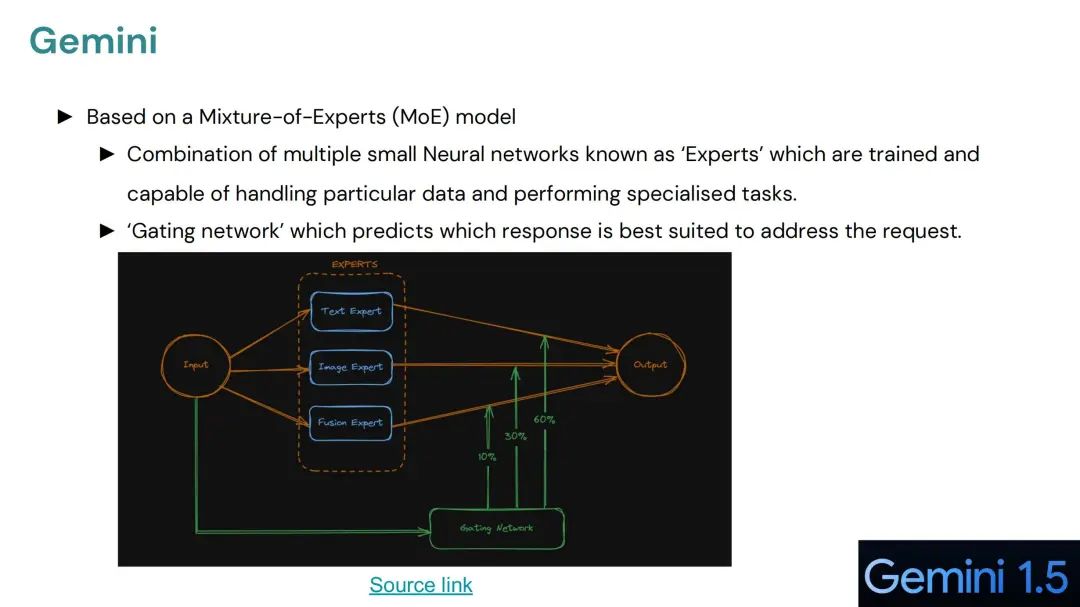

基于Mixture-of-Experts(MoE)模型,显著提高了训练和应用的效率。

unsetunset链式思考(Chain-of-Thought,CoT)unsetunset

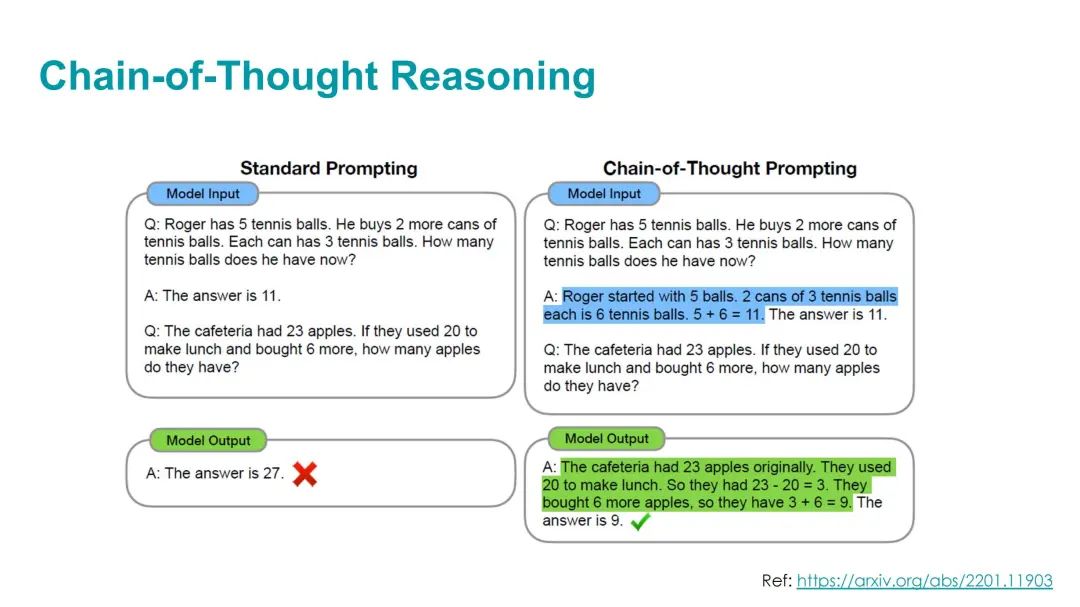

CoT推理是一种提升大型语言模型(Large Language Models,简称LLMs)复杂推理能力的方法。

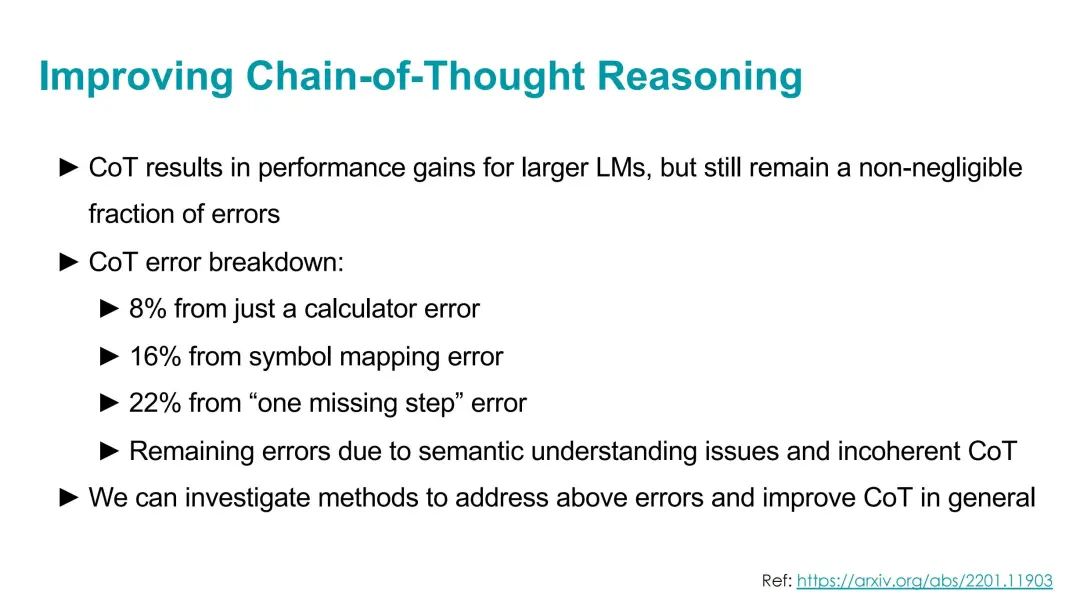

通过生成一系列中间推理步骤,CoT使得模型在算术、常识和符号推理任务上表现出色。然而,即使CoT在大型模型上取得了性能提升,仍然存在一定比例的错误。

对于规模较小的模型,CoT的效果并不理想,通常需要大约100B参数或更大的模型才能有效。

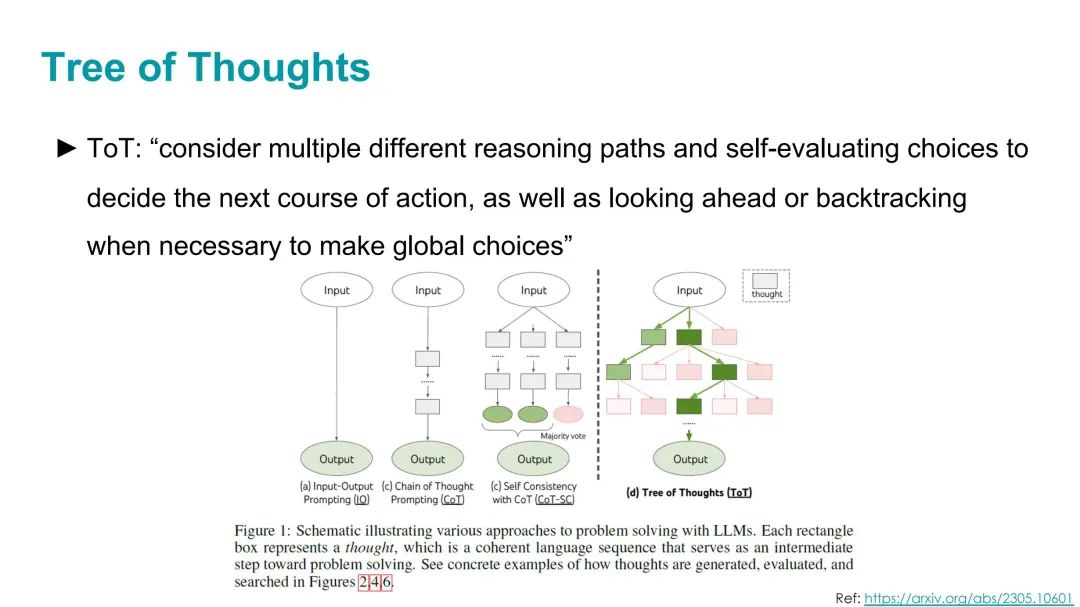

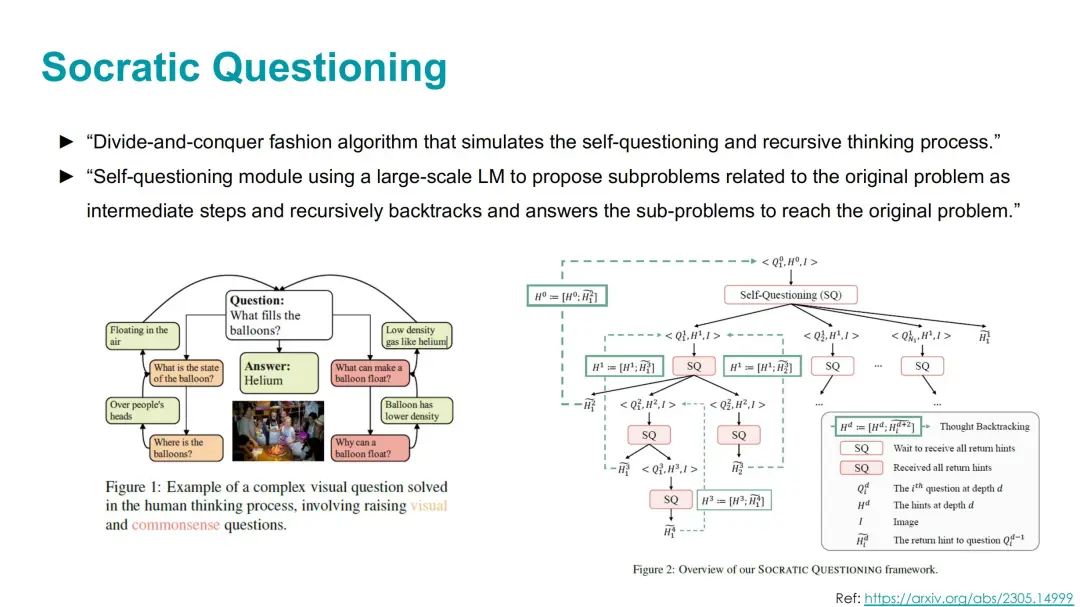

CoT推理在特定领域和问题类型上具有优势,特别是那些任务具有挑战性且需要多步骤推理的情况,以及任务的扩展曲线相对平坦。

unsetunset大模型与智能体unsetunset

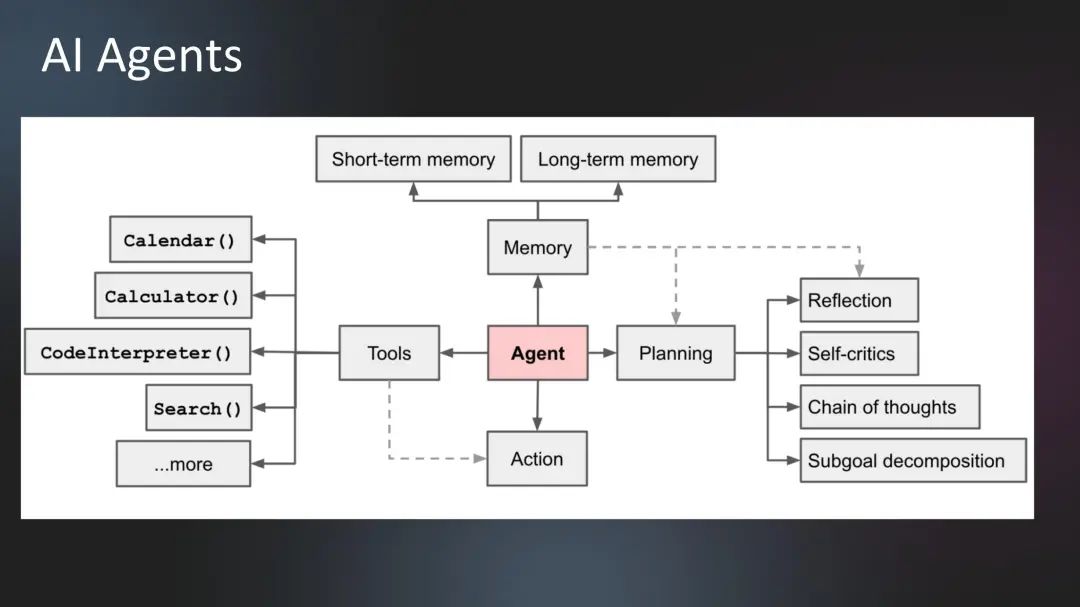

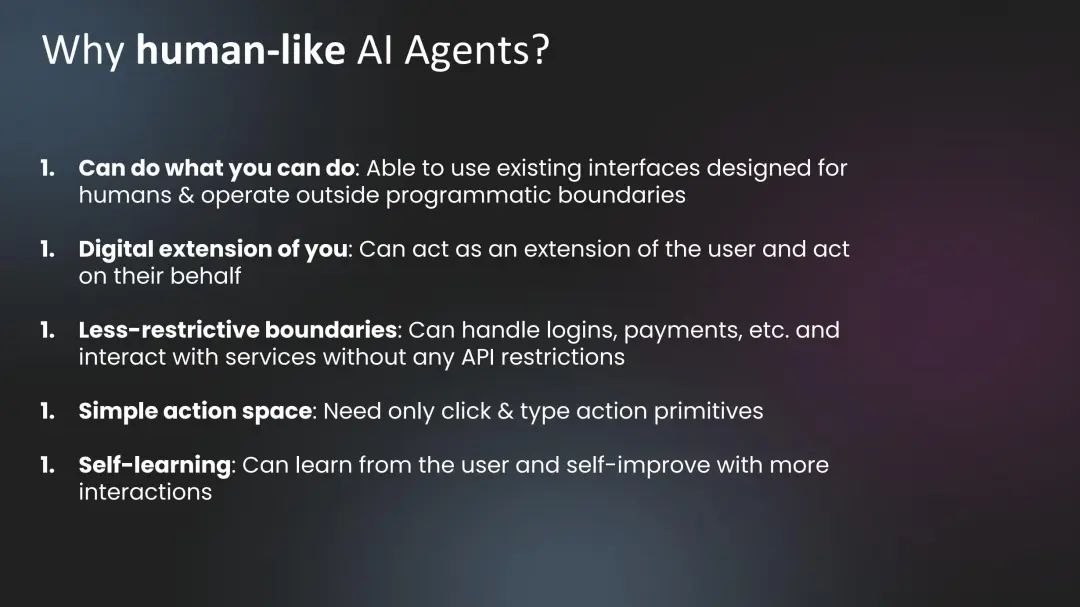

AI Agents能够使用为人类设计的现有界面,操作超出程序边界之外的任务,处理登录、支付等服务,而不受API限制,仅需基本的点击和输入操作。AI代理的关键优势在于它们可以作为用户的数字延伸,代表用户行事,并能够自我学习、自我改进。

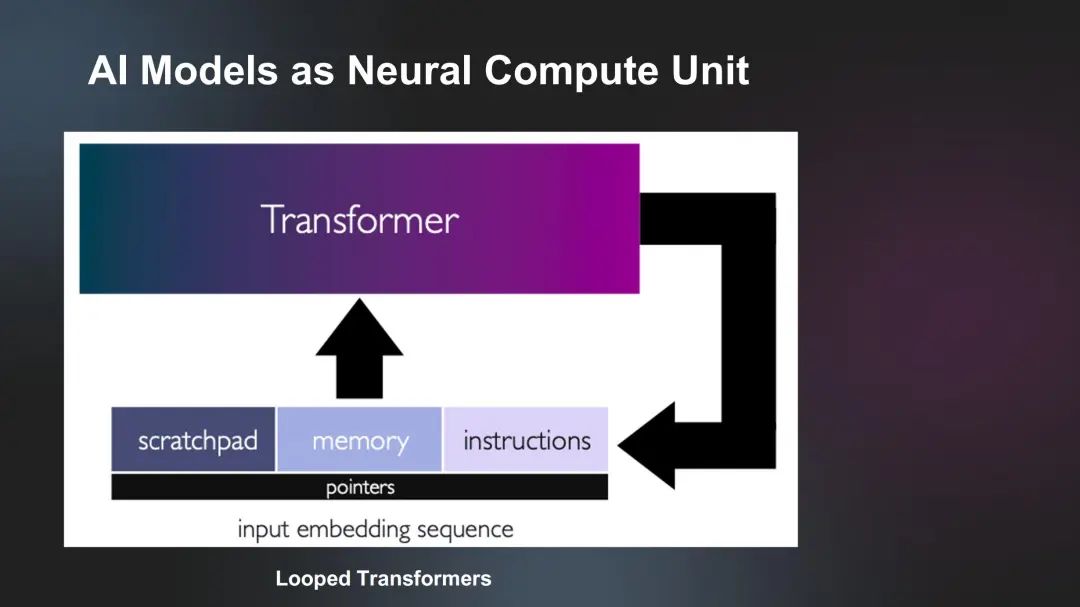

AI代理的核心论点是,人类将使用自然语言与AI软件3.0进行交流,AI将操作机器,实现更直观、高效的操作。为了构建这些代理,我们需要使用模型链、反射等机制,并结合记忆、上下文长度、个性化、行动和互联网访问等要素。

为什么我们需要类似人类的AI代理?

首先,它们能够执行人类能够执行的任务,操作人类设计的界面,并在没有API限制的情况下与服务交互。其次,它们可以作为用户的数字延伸,代表用户行事。此外,AI代理具有自我学习能力,可以从用户互动中学习并自我改进。

如何与AI代理进行交互?

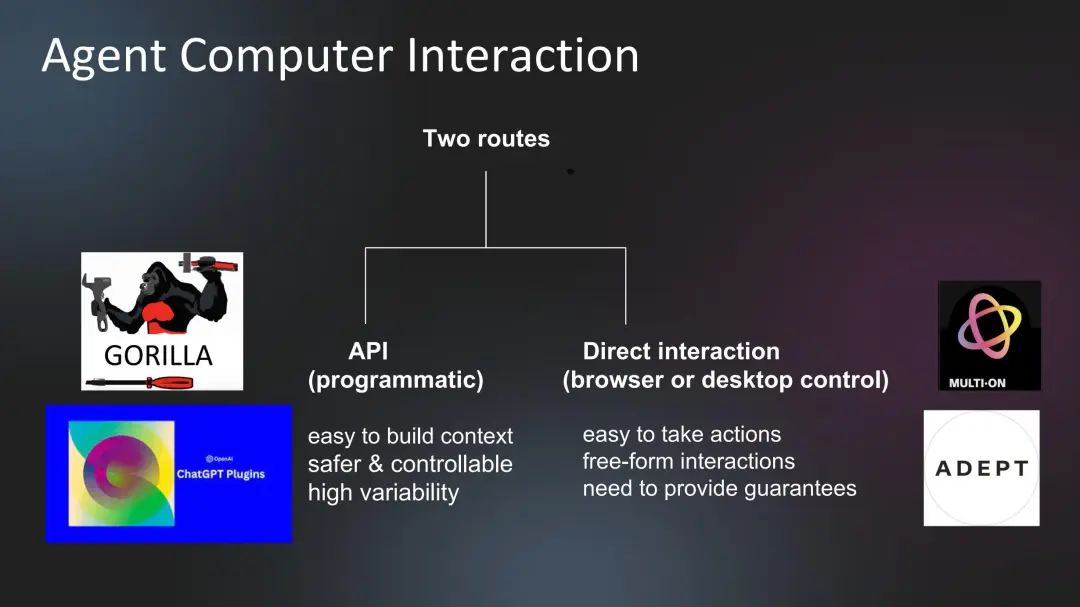

在计算机交互方面,AI代理可以通过API或直接交互(如浏览器或桌面控制)与计算机进行交互。这两条路径各有优势:API交互易于构建上下文,更安全、可控;而直接交互则允许自由形式的交互。

在大模型时代,我们如何有效的去学习大模型?

现如今大模型岗位需求越来越大,但是相关岗位人才难求,薪资持续走高,AI运营薪资平均值约18457元,AI工程师薪资平均值约37336元,大模型算法薪资平均值约39607元。

掌握大模型技术你还能拥有更多可能性:

• 成为一名全栈大模型工程师,包括Prompt,LangChain,LoRA等技术开发、运营、产品等方向全栈工程;

• 能够拥有模型二次训练和微调能力,带领大家完成智能对话、文生图等热门应用;

• 薪资上浮10%-20%,覆盖更多高薪岗位,这是一个高需求、高待遇的热门方向和领域;

• 更优质的项目可以为未来创新创业提供基石。

可能大家都想学习AI大模型技术,也_想通过这项技能真正达到升职加薪,就业或是副业的目的,但是不知道该如何开始学习,因为网上的资料太多太杂乱了,如果不能系统的学习就相当于是白学。为了让大家少走弯路,少碰壁,这里我直接把都打包整理好,希望能够真正帮助到大家_。

👉[CSDN大礼包🎁:全网最全《LLM大模型入门+进阶学习资源包》免费分享(安全链接,放心点击)]()👈

一、AGI大模型系统学习路线

很多人学习大模型的时候没有方向,东学一点西学一点,像只无头苍蝇乱撞,下面是我整理好的一套完整的学习路线,希望能够帮助到你们学习AI大模型。

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF书籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型各大场景实战案例

结语

【一一AGI大模型学习 所有资源获取处(无偿领取)一一】

所有资料 ⚡️ ,朋友们如果有需要全套 《LLM大模型入门+进阶学习资源包》,扫码获取~

👉[CSDN大礼包🎁:全网最全《LLM大模型入门+进阶学习资源包》免费分享(安全链接,放心点击)]()👈

本文转自 https://mp.weixin.qq.com/s/7K75KogwSdBtcYvJ2f6JCw,如有侵权,请联系删除。