联邦多任务蒸馏助力多接入边缘计算下的个性化服务 | TPDS 2023

联邦多任务蒸馏助力多接入边缘计算下的个性化服务 | TPDS 2023

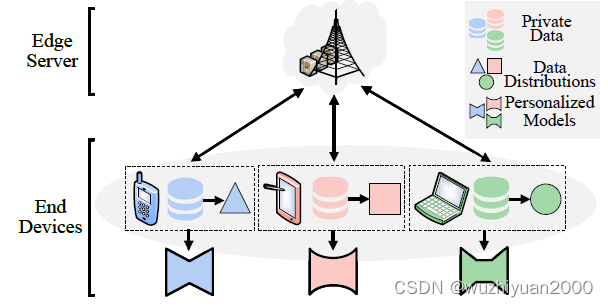

随着移动智能设备的普及和人工智能技术的发展,越来越多的分布式数据在终端被产生与收集,并以多接入边缘计算(MEC)的形式进行处理和分析。但是由于用户的行为模式与服务需求的多样,不同设备上的数据分布与模型的任务需求往往存在显著差异,叠加MEC场景设备硬件配置高度差异化、通信受限等多重限制,给部署与协同训练机器学习模型带来了挑战。

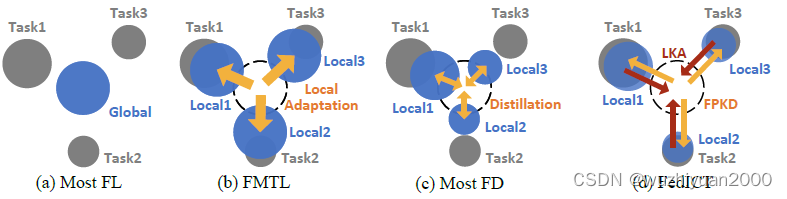

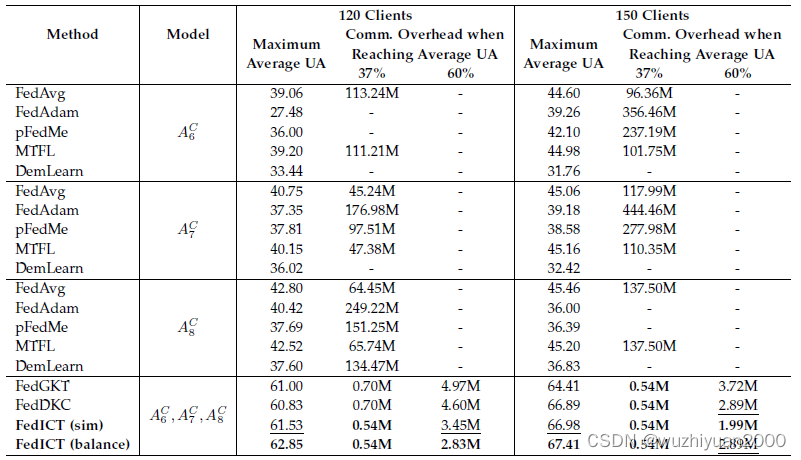

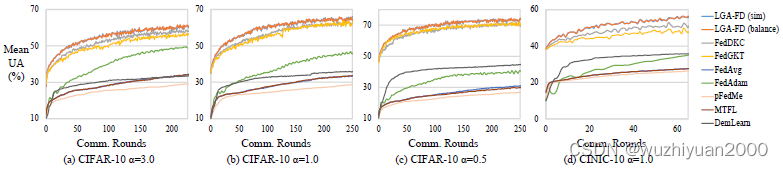

针对这个问题,中科院计算所、中国科学院大学、中关村实验室与北京交通大学研究团队在TPDS 2023上提出了一种“联邦多任务蒸馏”方法,在兼顾边缘计算场景对于模型异构与低通信开销需求的同时提升客户端在多任务场景的性能。该方法通过在服务器和客户端之间传递知识而不是模型参数,大大减少了通信开销。同时,客户端可以自主选择不同的模型架构,并在此基础上实现模型的个性化优化。具体地,通过引导疏离的设备端和服务器端的双向蒸馏训练过程,该方法实现了在资源受限的MEC环境下,快速高效地训练出对本地任务拟合较好的定制化模型。

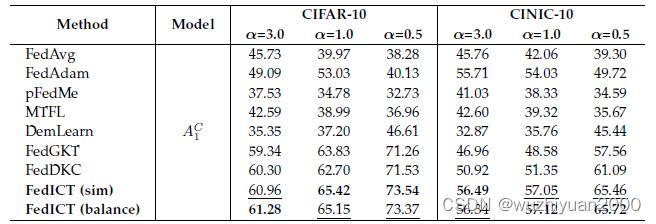

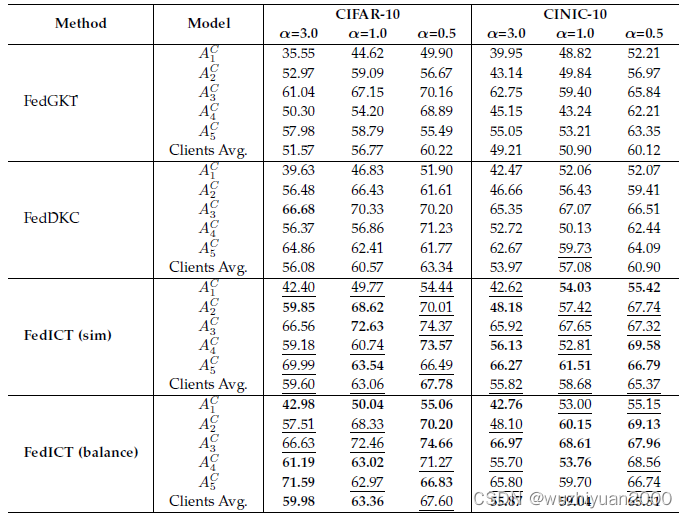

在图像识别与运动状态检测上的实验表明,相比现有方法,该联邦多任务蒸馏在保证收敛速度与通信效率的同时,显著提升了模型在本地任务上的表现。

论文链接:https://ieeexplore.ieee.org/document/10163770