Istio1.6官方文档中文版

目 录

致谢概念

Istio 是什么? 流量管理

扩展性安全

可观察性

安装

开始

平台安装

阿里云

Azure

Docker Desktop

使用 Google Kubernetes Engine 快速开始

IBM Cloud 快速开始

kind

Kubernetes Gardener 快速开始

MicroK8s Minikube OpenShift

Oracle Cloud Infrastructure

安装

使用 Istioctl 安装

使用 Helm 自定义安装安装独立 Operator [实验] 多集群安装

简化地多集群安装[实验性] 控制平面副本集

共享控制平面(单一网络) 共享的控制平面(多网络)

升级

使用 istioctl 命令升级Istio [实验中]

使用 Helm 升级更多指南

安装配置 设置 Sidecar

安装Istio CNI 插件

任务

流量管理

配置请求路由故障注入

流量转移 TCP 流量转移设置请求超时熔断

镜像

Ingress

Ingress Gateway

安全网关(文件挂载)

使用SDS 为 Gateway 提供HTTPS 加密支持无 TLS 终止的Ingress Gateway

Egress

访问外部服务

Egress TLS Origination Egress Gateway

Egress 网关的TLS 发起过程

Wildcard 主机的egress

TLS Egress 监控和策略配置使用外部HTTPS 代理Kubernetes Egress 流量服务

安全

认证

自动双向TLS

认证策略

通过HTTPS 进行TLS

双向TLS 迁移

Citadel 配置授权

HTTP 流量授权TCP 流量的授权基于JWT 授权

授权策略信任域迁移插入外部CA 证书

Istio DNS 证书管理

策略

启用策略检查功能启用速率限制

请求头和路由控制

Denials 和黑白名单可观察性

指标度量

采集指标

收集TCP 服务指标

通过Prometheus 查询度量指标使用Grafana 可视化指标

日志

收集日志

获取Envoy 访问日志

使用Fluentd 进行日志收集分布式追踪

概述

Zipkin Jaeger LightStep

网络可视化

远程访问遥测插件

示例

Bookinfo 应用虚拟机

单个网络网格中的虚拟机多网络网格中的虚拟机

在虚拟机上部署Bookinfo 应用程序使用Kubernetes 和 Istio 学习微服务

前提条件

设置Kubernetes 集群设置本地计算机

本地运行微服务

在 Docker 中运行ratings 服务使用Kubernetes 运行Bookinfo 生产测试

运维

部署

架构

部署模型

性能和可扩展性

Pod 和 Service

配置

网格配置

动态准入 Webhook 概述

Sidecar 自动注入

创建服务账号 Secret Istio 服务的健康检查

流量管理

协议选择

地域负载均衡

安全

加固 Docker 容器镜像延长自签名证书的寿命

可观测性

Envoy 的统计信息

不使用 Mixer 生成 Istio 指标 [Alpha]

最佳实践

Deployment 最佳实践流量管理最佳实践 安全最佳实践

常见问题

流量管理问题安全问题

可观测性问题 Sidecar 自动注入问题配置验证的问题

诊断工具

使用Istioctl 命令行工具调试Envoy 和 Pilot

通过Istioctl Describe 理解您的网格使用Istioctl Analyze 诊断配置

组件自检

组件日志记录

集成

cert-manager

参考

配置

Service Mesh Operator Installation

安装选项(Helm)

IstioOperator Options Resource Annotations

流量管理

Destination Rule Envoy Filter Gateway

Virtual Service Sidecar Service Entry

Security

JWTRule RequestAuthentication PeerAuthentication Authentication Policy Authorization Policy 授权策略

RBAC (deprecated)

RBAC 约束和属性(不建议使用)

Telemetry V2

Istio 标准度量指标

使用Wasm 运行时的Telemetry V2(实验性) 可配置指标(实验性)

配置分析消息

Analyzer Message Format ConflictingMeshGatewayVirtualServiceHosts ConflictingSidecarWorkloadSelectors Deprecated

GatewayPortNotOnWorkload InternalError IstioProxyImageMismatch

JwtFailureDueToInvalidServicePortPrefix MisplacedAnnotation MTLSPolicyConflict

MultipleSidecarsWithoutWorkloadSelectors NamespaceNotInjected VirtualServiceDestinationPortSelectorRequired UnknownAnnotation

SchemaValidationError ReferencedResourceNotFound PortNameIsNotUnderNamingConvention PodMissingProxy

Mixer 策略和遥测

Mixer Client Rules

Mixer 配置模型

属性词汇 表达式语言适配器

Apache SkyWalking Apigee

App Identity and Access Circonus

CloudMonitor CloudWatch Datadog Zipkin

Denier Fluentd

Kubernetes Env List

Memory quota New Relic

Wavefront by VMware Stdio

StatsD Stackdriver SolarWinds Redis Quota Prometheus OPA

模板

Analytics API Key Authorization

Check Nothing Edge Kubernetes List Entry

Log Entry Metric Trace Span

Report Nothing Quota

默认监控指标

命令

galley istio_ca istioctl mixs

sidecar-injector pilot-discovery pilot-agent operator node_agent

术语表

概念

一些概念,理解它们有助于您更好地了解 Istio 系统的不同部分及其使用的抽象。

Istio 是什么?

介绍 Istio,它要解决的问题,高层面的架构和设计目标。

流量管理

描述 Istio 多样的流量路由和控制特性。

扩展性

讲述 Istio 的 WebAssembly 插件系统。

安全

描述 Istio 的授权与认证功能。

可观察性

描述 Istio 提供的遥测和监控特性。

Istio 是什么?

云平台令使用它们的公司受益匪浅。但不可否认的是,上云会给 DevOps 团队带来压力。为了可移植性,开发人员必须使用微服务来 应用,同时运维人员也正在管理着极端庞大的混合云和多云的部署环境。 Istio 允许您连接、保

护、控制和观察服务。

从较高的层面来说,Istio 有助于降低这些部署的复杂性,并减轻开发团队的压力。它是一个完全开源的服务网格, 作为透明的一层接入到现有的分布式应用程序里。它也是一个平台,拥有可以集成任何日志、遥测和策略系统的 API 接口。Istio 多样化的特性使您能够成功且高效地运行分布式微服务架构,并提供保护、连接和监控微服务的统一方法。

服务网格是什么?

Istio 解决了开发人员和运维人员所面临的从单体应用向分布式微服务架构转变的挑战。了解它是如何做到这一点的可以让我们更详细地理解 Istio 的服务网格。

术语服务网格用来描述组成这些应用程序的微服务网络以及它们之间的交互。随着服务网格的规模和复杂性不断的增长,它将会变得越来越难以理解和管理。它的需求包括服务发现、负载均衡、故障恢复、度量和监控等。服务网格通常还有更复杂的运维需求,比如 A/B 测试、金丝雀发布、速率限制、访问控制和端到端认证。

Istio 提供了对整个服务网格的行为洞察和操作控制的能力,以及一个完整的满足微服务应用各种需求的解决方案。

为什么使用 Istio?

通过负载均衡、服务间的身份验证、监控等方法,Istio 可以轻松地创建一个已经部署了服务的网络,而服务的代码只需很少更改甚至无需更改。通过在整个环境中部署一个特殊的 sidecar 代理为服务添加 Istio 的支持,而代理会拦截微服务之间的所有网络通信,然后使用其控制平面的功能来配置和管理 Istio,这包括:

为 HTTP、gRPC、WebSocket 和 TCP 流量自动负载均衡。

通过丰富的路由规则、重试、故障转移和故障注入对流量行为进行细粒度控制。

可插拔的策略层和配置 API,支持访问控制、速率限制和配额。

集群内(包括集群的入口和出口)所有流量的自动化度量、日志记录和追踪。

在具有强大的基于身份验证和授权的集群中实现安全的服务间通信。

Istio 为可扩展性而设计,可以满足不同的部署需求。

核心特性

Istio 以统一的方式提供了许多跨服务网络的关键功能:

流量管理

Istio 简单的规则配置和流量路由允许您控制服务之间的流量和 API 调用过程。Istio 简化了服务级属性(如熔断器、超时和重试)的配置,并且让它轻而易举的执行重要的任务(如 A/B 测试、金丝雀发布和按流量百分比划分的分阶段发布)。

有了更好的对流量的可视性和开箱即用的故障恢复特性,您就可以在问题产生之前捕获它们,无论面对什么情况都可以使调用更可靠,网络更健壮。

请参考流量管理文档获取更多细节。

安全

Istio 的安全特性解放了开发人员,使其只需要专注于应用程序级别的安全。Istio 提供了底层的安全通信通道, 并为大规模的服务通信管理认证、授权和加密。有了 Istio,服务通信在默认情况下就是受保护的,可以让您在跨不同协议和运行时的情况下实施一致的策略——而所有这些都只需要很少甚至不需要修改应用程序。

Istio 是独立于平台的,可以与 Kubernetes(或基础设施)的网络策略一起使用。但它更强大,能够在网络和应用层面保护pod到 pod 或者服务到服务之间的通信。

请参考安全文档获取更多细节。

可观察性

Istio 健壮的追踪、监控和日志特性让您能够深入的了解服务网格部署。通过 Istio 的监控能力,可以真正的了解到服务的性能是如何影响上游和下游的;而它的定制 Dashboard 提供了对所有服务性能的可视化能力,并让您看到它如何影响其他进程。

Istio 的 Mixer 组件负责策略控制和遥测数据收集。它提供了后端抽象和中介,将一部分 Istio 与后端的基础设施实现细节隔离开来,并为运维人员提供了对网格与后端基础实施之间交互的细粒度控制。

所有这些特性都使您能够更有效地设置、监控和加强服务的 SLO。当然,底线是您可以快速有效地检测到并修复出现的问题。

请参考可观察性文档获取更多细节。

平台支持

Istio 独立于平台,被设计为可以在各种环境中运行,包括跨云、内部环境、Kubernetes、Mesos 等等。您可以在 Kubernetes 或是装有 Consul 的 Nomad 环境上部署 Istio。Istio 目前支持:

Kubernetes 上的服务部署

基于 Consul 的服务注册

服务运行在独立的虚拟机上

整合和定制

Istio 的策略实施组件可以扩展和定制,与现有的 ACL、日志、监控、配额、审查等解决方案集成。

流量管理

Istio 的流量路由规则可以让您很容易的控制服务之间的流量和 API 调用。Istio 简化了服务级别属性的配置, 比如熔断器、超时和重试,并且能轻松的设置重要的任务,如 A/B 测试、金丝雀发布、基于流量百分比切分的概率发布等。它还提供了开箱即用的故障恢复特性,有助于增强应用的健壮性,从而更好地应对被依赖的服务或网络发生故障的情况。

Istio 的流量管理模型源于和服务一起部署的 Envoy 代理。网格内服务发送和接收的所有流量(data plane流量)都经由 Envoy 代理,这让控制网格内的流量变得异常简单,而且不需要对服务做任何的更改。

本节中描述的功能特性,如果您对它们是如何工作的感兴趣的话,可以在架构概述中找到关于 Istio 的流量管理实现的更多信息。本部分只介绍 Istio 的流量管理特性。

Istio 流量管理介绍

为了在网格中导流,Istio 需要知道所有的 endpoint 在哪和属于哪个服务。为了定位到service registry(服务注册中心),Istio 会连接到一个服务发现系统。例如,如果您在 Kubernetes 集群上安装了 Istio,那么它将自动检测该集群中的服务和 endpoint。

使用此服务注册中心,Envoy 代理可以将流量定向到相关服务。大多数基于微服务的应用程序,每个服务的工作负载都有多个实例来处理流量,称为负载均衡池。默认情况下,Envoy 代理基于轮询调度模型在服务的负载均衡池内分发流量,按顺序将请求发送给池中每个成员,一旦所有服务实例均接收过一次请求后,重新回到第一个池成员。

Istio 基本的服务发现和负载均衡能力为您提供了一个可用的服务网格,但它能做到的远比这多的多。在许多情况下,您可能希望对网格的流量情况进行更细粒度的控制。作为 A/B 测试的一部分,您可能想将特定百分比的流量定向到新版本的服务,或者为特定的服务实例子集应用不同的负载均衡策略。您可能还想对进出网格的流量应用特殊的规则,或者将网格的外部依赖项添加到服务注册中心。通过使用 Istio 的流量管理 API 将流量配置添加到Istio,就可以完成所有这些甚至更多的工作。

和其他 Istio 配置一样,这些 API 也使用 Kubernetes 的自定义资源定义(CRDs)来声明,您可以像示例中看到的那样使用 YAML 进行配置。

本章节的其余部分将分别介绍每个流量管理 API 以及如何使用它们。这些资源包括: 虚拟服务

目标规则网关

服务入口

Sidecar

指南也对 在 API 资源内的网络弹性和测试做了概述。

虚拟服务

虚拟服务(Virtual Service) 和目标规则(Destination Rule) 是 Istio 流量路由功能的关键拼图。虚拟服务让您配置如何在服务网格内将请求路由到服务,这基于 Istio 和平台提供的基本的连通性和服务发现能力。

每个虚拟服务包含一组路由规则,Istio 按顺序评估它们,Istio 将每个给定的请求匹配到虚拟服务指定的实际目标地址。您的网格可以有多个虚拟服务,也可以没有,取决于您的使用场景。

为什么使用虚拟服务?

虚拟服务在增强 Istio 流量管理的灵活性和有效性方面,发挥着至关重要的作用,通过对客户端请求的目标地址与真实响应请求的目标工作负载进行解耦来实现。虚拟服务同时提供了丰富的方式,为发送至这些工作负载的流量指定不同的路由规则。

为什么这如此有用?就像在介绍中所说,如果没有虚拟服务,Envoy 会在所有的服务实例中使用轮询的负载均衡策略分发请求。您可以用您对工作负载的了解来改善这种行为。例如,有些可能代表不同的版本。这在 A/B 测试中可能有用,您可能希望在其中配置基于不同服务版本的流量百分比路由,或指引从内部用户到特定实例集的流量。

使用虚拟服务,您可以为一个或多个主机名指定流量行为。在虚拟服务中使用路由规则,告诉 Envoy 如何发送虚拟服务的流量到适当的目标。路由目标地址可以是同一服务的不同版本,也可以是完全不同的服务。

一个典型的用例是将流量发送到被指定为服务子集的服务的不同版本。客户端将虚拟服务视为一个单一实体,将请求发送至虚拟服务主机,然后 Envoy 根据虚拟服务规则把流量路由到不同的版本。例如,“20% 的调用转到新版

本”或“将这些用户的调用转到版本 2”。这允许您创建一个金丝雀发布,逐步增加发送到新版本服务的流量百分比。流量路由完全独立于实例部署,这意味着实现新版本服务的实例可以根据流量的负载来伸缩,完全不影响流量路由。相比之下,像 Kubernetes 这样的容器编排平台只支持基于实例缩放的流量分发,这会让情况变得复杂。您可以在使用 Istio 进行金丝雀部署的文章里阅读到更多用虚拟服务实现金丝雀部署的内容。

虚拟服务可以让您:

通过单个虚拟服务处理多个应用程序服务。如果您的网格使用 Kubernetes,可以配置一个虚拟服务处理特定命名空间中的所有服务。映射单一的虚拟服务到多个“真实”服务特别有用,可以在不需要客户适应转换的情况下,将单体应用转换为微服务 的复合应用系统。您的路由规则可以指定为“对这些 monolith.com 的 URI

调用转到 ”等等。您可以在下面的一个示例看到它是如何工作的。

microservice A

和网关整合并配置流量规则来控制出入流量。

在某些情况下,您还需要配置目标规则来使用这些特性,因为这是指定服务子集的地方。在一个单独的对象中指定服务子集和其它特定目标策略,有利于在虚拟服务之间更简洁地重用这些规则。在下一章节您可以找到更多关于目标规则的内容。

虚拟服务示例

下面的虚拟服务根据请求是否来自特定的用户,把它们路由到服务的不同版本。

-

apiVersion: networking.istio.io/v1alpha3

-

kind: VirtualService

-

metadata:

-

name: reviews

-

spec:

-

hosts:

-

- reviews

-

http:

-

- match:

-

- headers:

-

end-user:

-

exact: jason

-

route:

-

- destination:

-

host: reviews

-

subset: v2

-

- route:

-

- destination:

-

host: reviews

-

subset: v3

hosts 字段

使用 字段列举虚拟服务的主机——即用户指定的目标或是路由规则设定的目标。这是客户端向服务发送请求

hosts

时使用的一个或多个地址。

- hosts:

-

- reviews

虚拟服务主机名可以是 IP 地址、DNS 名称,或者依赖于平台的一个简称(例如 Kubernetes 服务的短名称), 隐式或显式地指向一个完全限定域名(FQDN)。您也可以使用通配符(“*”)前缀,让您创建一组匹配所有服务的路

由规则。虚拟服务的 字段实际上不必是 Istio 服务注册的一部分,它只是虚拟的目标地址。这让您可以

hosts

为没有路由到网格内部的虚拟主机建模。

路由规则

在 字段包含了虚拟服务的路由规则,用来描述匹配条件和路由行为,它们把 HTTP/1.1、HTTP2 和 gRPC

http

等流量发送到 hosts 字段指定的目标(您也可以用 和 片段为 TCP 和未终止的 TLS 流量设置路

tcp

tls

由规则)。一个路由规则包含了指定的请求要流向哪个目标地址,具有 0 或多个匹配条件,取决于您的使用场景。

匹配条件

示例中的第一个路由规则有一个条件,因此以 match 字段开始。在本例中,您希望此路由应用于来自 ”jason“

headers

exact

用户的所有请求,所以使用

、 end-user 和

字段选择适当的请求。

-

- match:

-

- headers:

- end-user:

- exact: jason

Destination

route 部分的

字段指定了符合此条件的流量的实际目标地址。与虚拟服务的

不同,

destination 的 host 必须是存在于 Istio 服务注册中心的实际目标地址,否则 Envoy 不知道该将请求发送到哪里。可以是一个有代理的服务网格,或者是一个通过服务入口被添加进来的非网格服务。本示例运行在Kubernetes 环境中,host 名为一个 Kubernetes 服务名:

destination

hosts

- route:

-

- destination:

- host: reviews

- subset: v2

请注意,在该示例和本页其它示例中,为了简单,我们使用 Kubernetes 的短名称设置 destination 的

host。在评估此规则时,Istio 会添加一个基于虚拟服务命名空间的域后缀,这个虚拟服务包含要获取主机的完全限定名的路由规则。在我们的示例中使用短名称也意味着您可以复制并在任何喜欢的命名空间中尝试它们。

只有在目标主机和虚拟服务位于相同的 Kubernetes 命名空间时才可以使用这样的短名称。因为使用 Kubernetes

的短名称容易导致配置出错,我们建议您在生产环境中指定完全限定的主机名。

destination 片段还指定了 Kubernetes 服务的子集,将符合此规则条件的请求转入其中。在本例中子集名称是

v2。您可以在目标规则章节中看到如何定义服务子集。

路由规则优先级

路由规则按从上到下的顺序选择,虚拟服务中定义的第一条规则有最高优先级。本示例中,不满足第一个路由规则的流量均流向一个默认的目标,该目标在第二条规则中指定。因此,第二条规则没有 match 条件,直接将流量导向v3 子集。

-

- route:

-

- destination:

- host: reviews

- subset: v3

我们建议提供一个默认的“无条件”或基于权重的规则(见下文)作为每一个虚拟服务的最后一条规则,如案例所示, 从而确保流经虚拟服务的流量至少能够匹配一条路由规则。

路由规则的更多内容

正如上面所看到的,路由规则是将特定流量子集路由到指定目标地址的强大工具。您可以在流量端口、header 字段、URI 等内容上设置匹配条件。例如,这个虚拟服务让用户发送请求到两个独立的服务:ratings 和

reviews,就好像它们是

http://bookinfo.com/

指向适当服务的请求匹配流量。

这个更大的虚拟服务的一部分。虚拟服务规则根据请求的 URI 和

-

apiVersion: networking.istio.io/v1alpha3

-

kind: VirtualService

-

metadata:

-

name: bookinfo

-

spec:

-

hosts:

-

- bookinfo.com

-

http:

-

- match:

-

- uri:

-

prefix: /reviews

-

route:

-

- destination:

-

host: reviews

-

- match:

-

- uri:

-

prefix: /ratings

-

route:

-

- destination:

-

host: ratings 21. …

-

http:

-

- match:

-

sourceLabels:

-

app: reviews

-

route: 28. …

有些匹配条件可以使用精确的值,如前缀或正则。

您可以使用 AND 向同一个

块添加多个匹配条件,或者使用 OR 向同一个规则添加多个

块。对

于任何给定的虚拟服务也可以有多个路由规则。这可以在单个虚拟服务中使路由条件变得随您所愿的复杂或简单。匹

match

match

配条件字段和备选值的完整列表可以在 参考中找到。

HTTPMatchRequest

另外,使用匹配条件您可以按百分比”权重“分发请求。这在 A/B 测试和金丝雀发布中非常有用:

- spec:

- hosts:

-

- reviews

- http:

-

- route:

-

- destination:

- host: reviews

- subset: v1

- weight: 75

-

- destination:

- host: reviews

- subset: v2

- weight: 25

您也可以使用路由规则在流量上执行一些操作,例如:

添加或删除 header。重写 URL。

为调用这一目标地址的请求设置重试策略。

想了解如何利用这些操作,查看 参考。

HTTPRoute

目标规则

与虚拟服务一样,目标规则也是 Istio 流量路由功能的关键部分。您可以将虚拟服务视为将流量如何路由到给定目

标地址,然后使用目标规则来配置该目标的流量。在评估虚拟服务路由规则之后,目标规则将应用于流量的“真实”目标地址。

特别是,您可以使用目标规则来指定命名的服务子集,例如按版本为所有给定服务的实例分组。然后可以在虚拟服务的路由规则中使用这些服务子集来控制到服务不同实例的流量。

目标规则还允许您在调用整个目的地服务或特定服务子集时定制 Envoy 的流量策略,比如您喜欢的负载均衡模型、

TLS 安全模式或熔断器设置。在目标规则参考中可以看到目标规则选项的完整列表。

负载均衡选项

默认情况下,Istio 使用轮询的负载均衡策略,实例池中的每个实例依次获取请求。Istio 同时支持如下的负载均

衡模型,可以在 中为流向某个特定服务或服务子集的流量指定这些模型。

DestinationRule

随机:请求以随机的方式转到池中的实例。权重:请求根据指定的百分比转到实例。 最少请求:请求被转到最少被访问的实例。

查看 Envoy 负载均衡文档获取这部分的更多信息。

目标规则示例

在下面的示例中,目标规则为 目标服务配置了 3 个具有不同负载均衡策略的子集:

my-svc

- apiVersion: networking.istio.io/v1alpha3

- kind: DestinationRule

- metadata:

- name: my-destination-rule

- spec:

- host: my-svc

- trafficPolicy:

- loadBalancer:

- simple: RANDOM

- subsets:

-

- name: v1

- labels:

- version: v1

-

- name: v2

- labels:

- version: v2

- trafficPolicy:

- loadBalancer:

- simple: ROUND_ROBIN

-

- name: v3

- labels:

- version: v3

每个子集都是基于一个或多个 定义的,在 Kubernetes 中它是附加到像 Pod 这种对象上的键/值对。

labels

这些标签应用于 Kubernetes 服务的 Deployment 并作为 来识别不同的版本。

metadata

除了定义子集之外,目标规则对于所有子集都有默认的流量策略,而对于该子集,则有特定于子集的策略覆盖它。定

v3

v2

义在 上的默认策略,为 和

subsets

v1

子集设置了一个简单的随机负载均衡器。在

策略中,

轮询负载均衡器被指定在相应的子集字段上。

网关

使用网关为网格来管理入站和出站流量,可以让您指定要进入或离开网格的流量。网关配置被用于运行在网格边界的独立 Envoy 代理,而不是服务工作负载的 sidecar 代理。

与 Kubernetes Ingress API 这种控制进入系统流量的其他机制不同,Istio 网关让您充分利用流量路由的强大能力和灵活性。您可以这么做的原因是 Istio 的网关资源可以配置 4-6 层的负载均衡属性,如对外暴露的端

口、TLS 设置等。作为替代应用层流量路由(L7)到相同的 API 资源,您绑定了一个常规的 Istio 虚拟服务到网关。这让您可以像管理网格中其他数据平面的流量一样去管理网关流量。

网关主要用于管理进入的流量,但您也可以配置出口网关。出口网关让您为离开网格的流量配置一个专用的出口节 点,这可以限制哪些服务可以或应该访问外部网络,或者启用出口流量安全控制为您的网格添加安全性。您也可以使用网关配置一个纯粹的内部代理。

Istio 提供了一些预先配置好的网关代理部署( 和 )供您使用——如

istio-ingressgateway

istio-egressgateway

果使用我们的演示安装它们都已经部署好了;如果使用默认或 sds 配置文件则只部署了入口网关。可以将您自己的网关配置应用到这些部署或配置您自己的网关代理。

Gateway 示例

下面的示例展示了一个外部 HTTPS 入口流量的网关配置:

- apiVersion: networking.istio.io/v1alpha3

- kind: Gateway

- metadata:

- name: ext-host-gwy

- spec:

- selector:

- app: my-gateway-controller

- servers:

-

- port:

- number: 443

- name: https

- protocol: HTTPS

- hosts:

-

- ext-host.example.com

- tls:

- mode: SIMPLE

- serverCertificate: /tmp/tls.crt

- privateKey: /tmp/tls.key

这个网关配置让 HTTPS 流量从 通过 443 端口流入网格,但没有为请求指定任何路由规

ext-host.example.com

则。为想要工作的网关指定路由,您必须把网关绑定到虚拟服务上。正如下面的示例所示,使用虚拟服务的字段进行设置:

gateways

- apiVersion: networking.istio.io/v1alpha3

- kind: VirtualService

- metadata:

- name: virtual-svc

- spec:

- hosts:

-

- ext-host.example.com

- gateways:

-

- ext-host-gwy

然后就可以为出口流量配置带有路由规则的虚拟服务。

服务入口

使用服务入口(Service Entry) 来添加一个入口到 Istio 内部维护的服务注册中心。添加了服务入口后, Envoy 代理可以向服务发送流量,就好像它是网格内部的服务一样。配置服务入口允许您管理运行在网格外的服务的流量,它包括以下几种能力:

为外部目标 redirect 和转发请求,例如来自 web 端的 API 调用,或者流向遗留老系统的服务。为外部目标定义重试、超时和故障注入策略。

添加一个运行在虚拟机的服务来扩展您的网格。

从逻辑上添加来自不同集群的服务到网格,在 Kubernetes 上实现一个多集群 Istio 网格。

您不需要为网格服务要使用的每个外部服务都添加服务入口。默认情况下,Istio 配置 Envoy 代理将请求传递给未知服务。但是,您不能使用 Istio 的特性来控制没有在网格中注册的目标流量。

服务入口示例

下面示例的 mesh-external 服务入口将 外部依赖项添加到 Istio 的服务注册中心:

ext-resource

- apiVersion: networking.istio.io/v1alpha3

- kind: ServiceEntry

- metadata:

- name: svc-entry

- spec:

- hosts:

-

- ext-svc.example.com

- ports:

-

- number: 443

- name: https

- protocol: HTTPS

- location: MESH_EXTERNAL

- resolution: DNS

您指定的外部资源使用 字段。可以使用完全限定名或通配符作为前缀域名。

hosts

您可以配置虚拟服务和目标规则,以更细粒度的方式控制到服务入口的流量,这与网格中的任何其他服务配置流量的

方式相同。例如,下面的目标规则配置流量路由以使用双向 TLS 来保护到 外部服务的连

ext-svc.example.com

接,我们使用服务入口配置了该外部服务:

- apiVersion: networking.istio.io/v1alpha3

- kind: DestinationRule

- metadata:

- name: ext-res-dr

- spec:

- host: ext-svc.example.com

- trafficPolicy:

- tls:

- mode: MUTUAL

- clientCertificate: /etc/certs/myclientcert.pem

- privateKey: /etc/certs/client_private_key.pem

- caCertificates: /etc/certs/rootcacerts.pem

查看服务入口参考获取更多可能的配置项。

Sidecar

默认情况下,Istio 让每个 Envoy 代理都可以访问来自和它关联的工作负载的所有端口的请求,然后转发到对应的工作负载。您可以使用 sidecar 配置去做下面的事情:

微调 Envoy 代理接受的端口和协议集。限制 Envoy 代理可以访问的服务集合。

您可能希望在较庞大的应用程序中限制这样的 sidecar 可达性,配置每个代理能访问网格中的任意服务可能会因为高内存使用量而影响网格的性能。

您可以指定将 sidecar 配置应用于特定命名空间中的所有工作负载,或者使用 选择特定的工

workloadSelector

作负载。例如,下面的 sidecar 配置将 命名空间中的所有服务配置为仅能访问运行在相同命名空间和

bookinfo

Istio 控制平面中的服务(目前需要使用 Istio 的策略和遥测功能):

-

apiVersion: networking.istio.io/v1alpha3

-

kind: Sidecar

-

metadata:

-

name: default

-

namespace: bookinfo

-

spec:

-

egress:

-

- hosts:

-

- “./*”

-

- “istio-system/*”

查阅 Sidecar 参考获取详细信息。

网络弹性和测试

除了为您的网格导流之外,Istio 还提供了可选的故障恢复和故障注入功能,您可以在运行时动态配置这些功能。使

用这些特性可以让您的应用程序运行稳定,确保服务网格能够容忍故障节点,并防止局部故障级联影响到其他节点。

超时

超时是 Envoy 代理等待来自给定服务的答复的时间量,以确保服务不会因为等待答复而无限期的挂起,并在可预测的时间范围内调用成功或失败。HTTP 请求的默认超时时间是 15 秒,这意味着如果服务在 15 秒内没有响应,调用将失败。

对于某些应用程序和服务,Istio 的缺省超时可能不合适。例如,超时太长可能会由于等待失败服务的回复而导致过度的延迟;而超时过短则可能在等待涉及多个服务返回的操作时触发不必要地失败。为了找到并使用最佳超时设置, Istio 允许您使用虚拟服务按服务轻松地动态调整超时,而不必修改您的业务代码。下面的示例是一个虚拟服务,它对 ratings 服务的 v1 子集的调用指定 10 秒超时:

- apiVersion: networking.istio.io/v1alpha3

- kind: VirtualService

- metadata:

- name: ratings

- spec:

- hosts:

-

- ratings

- http:

-

- route:

-

- destination:

- host: ratings

- subset: v1

- timeout: 10s

重试

重试设置指定如果初始调用失败,Envoy 代理尝试连接服务的最大次数。通过确保调用不会因为临时过载的服务或网络等问题而永久失败,重试可以提高服务可用性和应用程序的性能。重试之间的间隔(25ms+)是可变的,并由 Istio 自动确定,从而防止被调用服务被请求淹没。默认情况下,在第一次失败后,Envoy 代理不会重新尝试连接服务。

与超时一样,Istio 默认的重试行为在延迟方面可能不适合您的应用程序需求(对失败的服务进行过多的重试会降低速度)或可用性。您可以在虚拟服务中按服务调整重试设置,而不必修改业务代码。您还可以通过添加每次重试的超 时来进一步细化重试行为,并指定每次重试都试图成功连接到服务所等待的时间量。下面的示例配置了在初始调用失 败后最多重试 3 次来连接到服务子集,每个重试都有 2 秒的超时。

-

apiVersion: networking.istio.io/v1alpha3

-

kind: VirtualService

-

metadata:

-

name: ratings

-

spec:

-

hosts:

-

- ratings

-

http:

-

- route:

-

- destination:

host: ratings subset: v1

retries: attempts: 3

perTryTimeout: 2s

熔断器

熔断器是 Istio 为创建具有弹性的微服务应用提供的另一个有用的机制。在熔断器中,设置一个对服务中的单个主机调用的限制,例如并发连接的数量或对该主机调用失败的次数。一旦限制被触发,熔断器就会“跳闸”并停止连接到该主机。使用熔断模式可以快速失败而不必让客户端尝试连接到过载或有故障的主机。

熔断适用于在负载均衡池中的“真实”网格目标地址,您可以在目标规则中配置熔断器阈值,让配置适用于服务中的每

个主机。下面的示例将 v1 子集的 服务工作负载的并发连接数限制为 100:

reviews

- apiVersion: networking.istio.io/v1alpha3

- kind: DestinationRule

- metadata:

- name: reviews

- spec:

- host: reviews

- subsets:

-

- name: v1

- labels:

- version: v1

- trafficPolicy:

- connectionPool:

- tcp:

- maxConnections: 100

您可以在熔断中查看更多相关信息。

故障注入

在配置了网络,包括故障恢复策略之后,可以使用 Istio 的故障注入机制来为整个应用程序测试故障恢复能力。故障注入是一种将错误引入系统以确保系统能够承受并从错误条件中恢复的测试方法。使用故障注入特别有用,能确保故障恢复策略不至于不兼容或者太严格,这会导致关键服务不可用。

与其他错误注入机制(如延迟数据包或在网络层杀掉 Pod)不同,Istio 允许在应用层注入错误。这使您可以注入更多相关的故障,例如 HTTP 错误码,以获得更多相关的结果。

您可以注入两种故障,它们都使用虚拟服务配置:

延迟:延迟是时间故障。它们模拟增加的网络延迟或一个超载的上游服务。

终止:终止是崩溃失败。他们模仿上游服务的失败。终止通常以 HTTP 错误码或 TCP 连接失败的形式出现。

例如,下面的虚拟服务为千分之一的访问 服务的请求配置了一个 5 秒的延迟:

ratings

- apiVersion: networking.istio.io/v1alpha3

- kind: VirtualService

- metadata:

- name: ratings

- spec:

- hosts:

-

- ratings

- http:

-

- fault:

- delay:

- percentage:

- value: 0.1

- fixedDelay: 5s

- route:

-

- destination:

- host: ratings

- subset: v1

有关如何配置延迟和终止的详细信息请参考故障注入。

和您的应用程序一起运行

Istio 故障恢复功能对应用程序来说是完全透明的。在返回响应之前,应用程序不知道 Envoy sidecar 代理是否正在处理被调用服务的故障。这意味着,如果在应用程序代码中设置了故障恢复策略,那么您需要记住这两个策略都 是独立工作的,否则会发生冲突。例如,假设您设置了两个超时,一个在虚拟服务中配置,另一个在应用程序中配

置。应用程序为服务的 API 调用设置了 2 秒超时。而您在虚拟服务中配置了一个 3 秒超时和重试。在这种情况下,应用程序的超时会先生效,因此 Envoy 的超时和重试尝试会失效。

虽然 Istio 故障恢复特性提高了网格中服务的可靠性和可用性,但应用程序必须处理故障或错误并采取适当的回退

操作。例如,当负载均衡中的所有实例都失败时,Envoy 返回一个 代码。应用程序必须实现回退逻辑来处

HTTP 503

理 错误代码。

HTTP 503

相关内容

使用 Admiral 管理 Istio 多集群的配置和服务发现

为 Istio deployment(cluster)提供自动化 Istio 配置,并让其像单个网格一样工作。把 Istio 作为外部服务的代理

把 Istio 入口网关配置为外部服务的代理。用于隔离和边界保护的多网格部署

将需要隔离的环境部署到单独的网格中,并通过网格联邦启用网格间通信。

Istio 中安全管控出口流量,第三部分

管控出口流量的备选方案比较,包括性能因素。

Istio 中的安全管控出口流量,第二部分

使用 Istio 的出口流量管控来阻止相关出口流量攻击。

Istio 中的安全管控出口流量,第一部分涉及出口流量攻击和出口流量管控要求。

扩展性

WebAssembly 是一种沙盒技术,可以用于扩展 Istio 代理(Envoy)的能力。Proxy-Wasm 沙盒 API 取代了

Mixer 作为 Istio 主要的扩展机制。在 Istio 1.6 中将会为 Proxy-Wasm 插件提供一种统一的配置 API。WebAssembly 沙盒的目标:

效率 - 这是一种低延迟,低 CPU 和内存开销的扩展机制。

功能 - 这是一种可以执行策略,收集遥测数据和执行有效荷载变更的扩展机制。隔离 - 一个插件中程序的错误或是崩溃不会影响其它插件。

配置 - 插件使用与其它 Istio API 一致的 API 进行配置。可以动态的配置扩展。运维 - 扩展可以以仅日志,故障打开或者故障关闭的方式进行访问和部署。

扩展开发者 - 可以用多种编程语言编写。

这个演讲视频是关于 WebAssembly 集成架构的介绍。

高级架构

Istio 扩展(Proxy-Wasm 插件)有几个组成部分:

过滤器服务提供商接口 用于为过滤器 Proxy-Wasm 插件。沙盒 在 Envoy 中嵌入 V8 Wasm 运行时。

主机 **API **用于处理请求头,尾和元数据。调出 **API **针对 gRPC 和 HTTP 请求。统计和记录 **API **用于度量统计和监控。

扩展 Istio/Envoy

例子

这里是用 C++ 为过滤器实现 Proxy-Wasm 插件的例子。为过滤器实现一个 Proxy-Wasm 插件需要:

实现一个继承了 base context 类的 root context 类。实现一个继承了 base context 类的 流 context 类。

重写 context API 的方法,以此处理来自主机的相应初始化和流事件。

注册 这个 和流 。

root context

stream context

SDK

C++ SDK 的详细说明见这里。

生态

Proxy-Wasm ABI 说明

Proxy-Wasm C++ SDK Proxy-Wasm Rust SDK

Proxy-Wasm AssemblyScript SDK WebAssembly Hub

网络代理的 WebAssembly 扩展(视频)

相关内容

在 Istio 中进行 WebAssembly 声明式部署

以声明方式为 Envoy 和 Istio 配置 Wasm 扩展。

重新定义代理的扩展性:Envoy 和 Istio 引入 WebAssembly Istio 的扩展中使用 WASM 的前景。

安全

将单一应用程序分解为微服务可提供各种好处,包括更好的灵活性、可伸缩性以及服务复用的能力。但是,微服务也有特殊的安全需求:

为了抵御中间人攻击,需要流量加密。

为了提供灵活的服务访问控制,需要双向 TLS 和细粒度的访问策略。要确定谁在什么时候做了什么,需要审计工具。

Istio Security 尝试提供全面的安全解决方案来解决所有这些问题。本页概述了如何使用 Istio 的安全功能来保护您的服务,无论您在何处运行它们。特别是 Istio 安全性可以缓解针对您的数据、端点、通信和平台的内部和外部威胁。

安全概述

Istio 安全功能提供强大的身份,强大的策略,透明的 TLS 加密,认证,授权和审计(AAA)工具来保护你的服务和数据。Istio 安全的目标是:

默认安全:应用程序代码和基础设施无需更改

深度防御:与现有安全系统集成以提供多层防御零信任网络:在不受信任的网络上 安全解决方案

请访问我们的双向 TLS 迁移相关文章,开始在已部署的服务中使用 Istio 安全功能。 请访问我们的安全任务,以获取有关使用安全功能的详细说明。

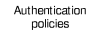

高级架构

Istio 中的安全性涉及多个组件:

用于密钥和证书管理的证书颁发机构(CA)

配置 API 服务器分发给代理:

认证策略授权策略

安全命名信息

Sidecar 和边缘代理作为 Policy Enforcement Points(PEPs) 以保护客户端和服务器之间的通信安全.

一组 Envoy 代理扩展,用于管理遥测和审计

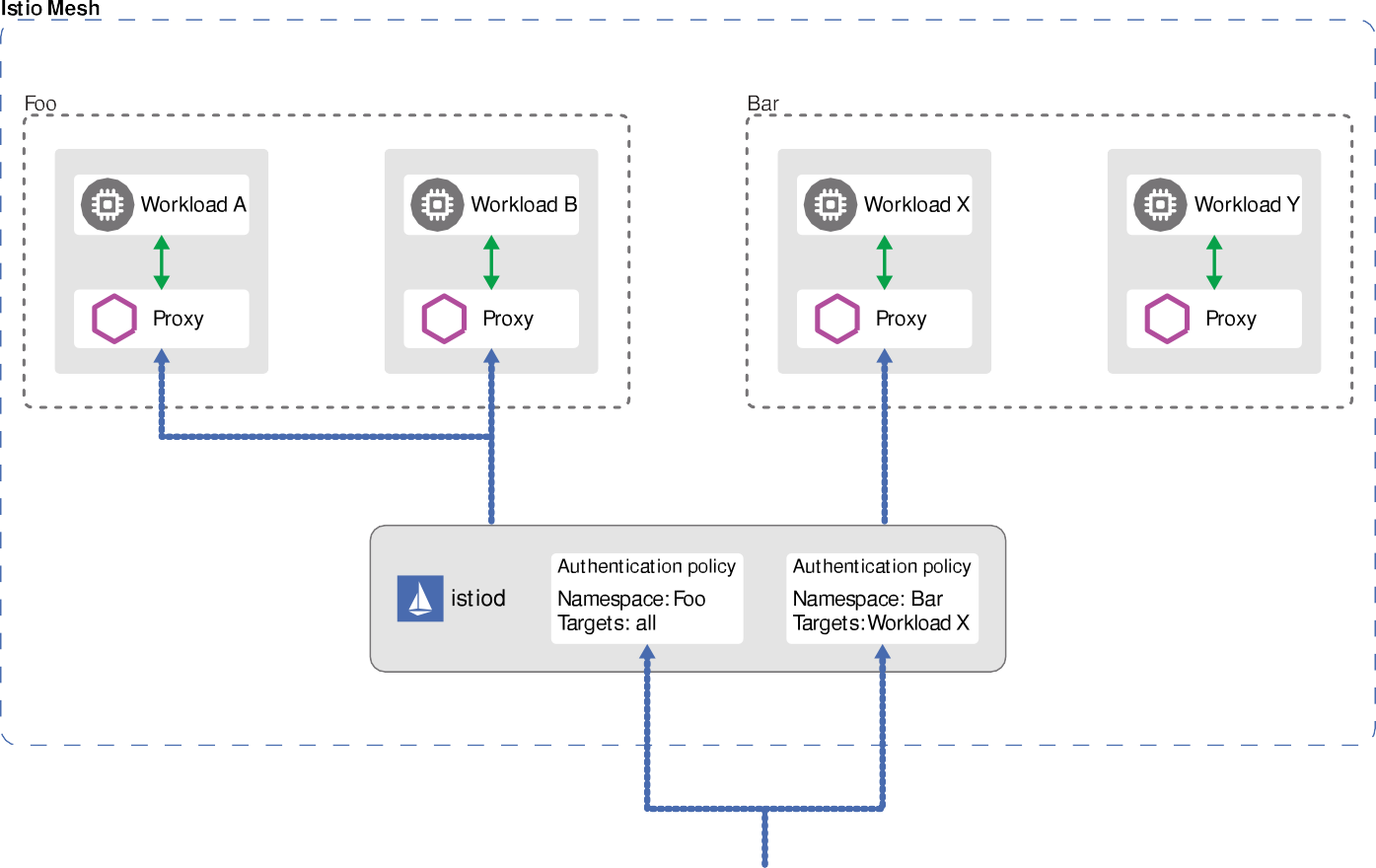

控制面处理来自 API server 的配置,并且在数据面中配置 PEPs。PEPs 用 Envoy 实现。下图显示了架构。

安全架构

在下面的部分中,我们将详细介绍 Istio 安全功能。

Istio 身份

身份是任何安全基础架构的基本概念。在工作负载间通信开始时,双方必须交换包含身份信息的凭证以进行双向验 证。在客户端,根据安全命名信息检查服务器的标识,以查看它是否是该服务的授权运行程序。在服务器端,服务器可以根据授权策略确定客户端可以访问哪些信息,审计谁在什么时间访问了什么,根据他们使用的工作负载向客户收费,并拒绝任何未能支付账单的客户访问工作负载。

Istio 身份模型使用 (服务身份)来确定一个请求源端的身份。这种模型有极好的灵活性和粒

service identity

度,可以用服务身份来标识人类用户、单个工作负载或一组工作负载。在没有服务身份的平台上,Istio 可以使用其它可以对服务实例进行分组的身份,例如服务名称。

下面的列表展示了在不同平台上可以使用的服务身份:

Kubernetes: Kubernetes service account GKE/GCE: GCP service account

GCP: GCP service account

AWS: AWS IAM user/role account

本地(非 Kubernetes):用户帐户、自定义服务帐户、服务名称、Istio 服务帐户或 GCP 服务帐户。自定义服务帐户引用现有服务帐户,就像客户的身份目录管理的身份一样。

公钥基础设施 (PKI)

Istio PKI 使用 X.509 证书为每个工作负载都提供强大的身份标识。可以大规模进行自动化密钥和证书轮换,伴

随每个 Envoy 代理都运行着一个 负责证书和密钥的供应。下图显示了这个机制的运行流程。

istio-agent

译者注:这里用 来表述,是因为下图及对图的相关解读中反复用到了 “Istio agent” 这个术语,

istio-agent

istio-agent

pilot-agent

这样的描述更容易理解。 另外,在实现层面,

是指 sidecar 容器中的

进程,它有

很多功能,这里不表,只特别提一下:它通过 Unix socket 的方式在本地提供 SDS 服务供 Envoy 使用,这个信息对了解 Envoy 与 SDS 之间的交互有意义。

身份供应

Istio 供应身份是通过 secret discovery service(SDS)来实现的,具体流程如下:

- CA 提供 gRPC 服务以接受证书签名请求(CSRs)。

- Envoy 通过 Envoy 秘密发现服务(SDS)API 发送证书和密钥请求。

- 在收到 SDS 请求后, 创建私钥和 CSR,然后将 CSR 及其凭据发送到 Istio CA 进行签名。

istio-agent

- CA 验证 CSR 中携带的凭据并签署 CSR 以生成证书。

- 通过 Envoy SDS API 将私钥和从 Istio CA 收到的证书发送给 Envoy。

Istio-agent

- 上述 CSR 过程会周期性地重复,以处理证书和密钥轮换。

认证

Istio 提供两种类型的认证:

Peer authentication:用于服务到服务的认证,以验证进行连接的客户端。Istio 提供双向 TLS 作为传

输认证的全栈解决方案,无需更改服务代码就可以启用它。这个解决方案:

为每个服务提供强大的身份,表示其角色,以实现跨群集和云的互操作性。保护服务到服务的通信。

提供密钥管理系统,以自动进行密钥和证书的生成,分发和轮换。

Request authentication:用于最终用户认证,以验证附加到请求的凭据。 Istio 使用 JSON Web Token(JWT)验证启用请求级认证,并使用自定义认证实现或任何 OpenID Connect 的认证实现(例如下面列举的)来简化的开发人员体验。

ORY Hydra Keycloak Auth0 Firebase Auth Google Auth

在所有情况下,Istio 都通过自定义 Kubernetes API 将认证策略存储在 。Istiod 使每

Istio config store

个代理保持最新状态,并在适当时提供密钥。此外,Istio 的认证机制支持宽容模式(permissive mode),以帮助您了解策略更改在实施之前如何影响您的安全状况。

双向 TLS 认证

Istio 通过客户端和服务器端 PEPs 建立服务到服务的通信通道,PEPs 被实现为Envoy 代理。当一个工作负载使用双向 TLS 认证向另一个工作负载发送请求时,该请求的处理方式如下:

- Istio 将出站流量从客户端重新路由到客户端的本地 sidecar Envoy。

- 客户端 Envoy 与服务器端 Envoy 开始双向 TLS 握手。在握手期间,客户端 Envoy 还做了安全命名检查,以验证服务器证书中显示的服务帐户是否被授权运行目标服务。

- 客户端 Envoy 和服务器端 Envoy 建立了一个双向的 TLS 连接,Istio 将流量从客户端 Envoy 转发到服务器端 Envoy。

- 授权后,服务器端 Envoy 通过本地 TCP 连接将流量转发到服务器服务。

宽容模式

Istio 双向 TLS 具有一个宽容模式(permissive mode),允许服务同时接受纯文本流量和双向 TLS 流量。这个功能极大的提升了双向 TLS 的入门体验。

在运维人员希望将服务移植到启用了双向 TLS 的 Istio 上时,许多非 Istio 客户端和非 Istio 服务端通信时会产生问题。通常情况下,运维人员无法同时为所有客户端安装 Istio sidecar,甚至没有这样做的权限。即使在服务端上安装了 Istio sidecar,运维人员也无法在不中断现有连接的情况下启用双向 TLS。

启用宽容模式后,服务可以同时接受纯文本和双向 TLS 流量。这个模式为入门提供了极大的灵活性。服务中安装的Istio sidecar 立即接受双向 TLS 流量而不会打断现有的纯文本流量。因此,运维人员可以逐步安装和配置客户端 Istio sidecar 发送双向 TLS 流量。一旦客户端配置完成,运维人员便可以将服务端配置为仅 TLS 模式。更多信息请访问双向 TLS 迁移向导。

安全命名

服务器身份(Server identities)被编码在证书里,但服务名称(service names)通过服务发现或 DNS 被

检索。安全命名信息将服务器身份映射到服务名称。身份

A

到服务名称

的映射表示“授权

运行服务

“。控制平面监视

B

A

B

apiserver

命名对身份验证至关重要。

,生成安全命名映射,并将其安全地分发到 PEPs。 以下示例说明了为什么安全

假设运行服务

的合法服务器仅使用

身份。恶意用户拥有 test-team 身份的证书和密

钥。恶意用户打算模拟服务以检查从客户端发送的数据。恶意用户使用证书和 test-team 身份的密钥部署伪造服务

datastore

infra-team

器。假设恶意用户成功攻击了发现服务或 DNS,以将 服务名称映射到伪造服务器。

datastore

当客户端调用 datastore 服务时,它从服务器的证书中提取 test-team 身份,并用安全命名信息检查

test-

是否被允许运行 datastore 。客户端检测到 test-team 不允许运行 服务,认证失败。

team

datastore

安全命名能够防止 HTTPS 流量受到一般性网络劫持,除了 DNS 欺骗外,它还可以保护 TCP 流量免受一般网络劫持。如果攻击者劫持了 DNS 并修改了目的地的 IP 地址,它将无法用于 TCP 通信。这是因为 TCP 流量不包含主机名信息,我们只能依靠 IP 地址进行路由,而且甚至在客户端 Envoy 收到流量之前,也可能发生 DNS 劫持。

认证架构

您可以使用 peer 和 request 认证策略为在 Istio 网格中接收请求的工作负载指定认证要求。网格运维人员使

用 文件来指定策略。部署后,策略将保存在 Istio 配置存储中。Istio 控制器监视配置存储。

.yaml

一有任何的策略变更,新策略都会转换为适当的配置,告知 PEP 如何执行所需的认证机制。控制平面可以获取公共密钥,并将其附加到配置中以进行 JWT 验证。或者,Istiod 提供了 Istio 系统管理的密钥和证书的路径,并将它们安装到应用程序 pod 用于双向 TLS。您可以在 PKI 部分中找到更多信息。

Istio 异步发送配置到目标端点。代理收到配置后,新的认证要求会立即生效。

发送请求的客户端服务负责遵循必要的认证机制。对于 peer authentication,应用程序负责获取 JWT 凭证并将其附加到请求。对于双向 TLS,Istio 会自动将两个 PEPs 之间的所有流量升级为双向 TLS。如果认证策略禁用了双向 TLS 模式,则 Istio 将继续在 PEPs 之间使用纯文本。要覆盖此行为,请使用 destination rules 显式禁用双向 TLS 模式。您可以在双向 TLS 认证 中找到有关双向 TLS 如何工作的更多信息。

认证架构

Istio 将两种类型的身份验证以及凭证中的其他声明(如果适用)输出到下一层:授权。

认证策略

本节中提供了更多 Istio 认证策略方面的细节。正如认证架构中所说的,认证策略是对服务收到的请求生效的。要

DetinationRule

TLSSettings

在双向 TLS 中指定客户端认证策略,需要在多这方面的信息。

中设置

。TLS 设置参考文档中有更

和其他的 Istio 配置一样,可以用 .yaml 文件的形式来编写认证策略。部署策略使用

kubectl

中的认证策略要求:与带有 app:reviews 标签的工作负载的传输层认证,必须使用双向 TLS:

。 下面例子

- apiVersion: “security.istio.io/v1beta1”

- kind: “PeerAuthentication”

- metadata:

- name: “example-peer-policy”

- namespace: “foo”

- spec:

- selector:

- matchLabels:

- app: reviews

- mtls:

- mode: STRICT

策略存储

Istio 将网格范围的策略存储在根命名空间。这些策略使用一个空的 selector 适用于网格中的所有工作负载。具有名称空间范围的策略存储在相应的名称空间中。它们仅适用于其命名空间内的工作负载。如果你配置了

selector

字段,则认证策略仅适用于与您配置的条件匹配的工作负载。

Peer 和 request 认证策略用 kind 字段区分,分别是 和 。

PeerAuthentication

RequestAuthentication

Selector 字段

Peer 和 request 认证策略使用 字段来指定该策略适用的工作负载的标签。以下示例显示适用于带有

selector

标签的工作负载的策略的 selector 字段:

app:product-page

- selector:

- matchLabels:

- app: product-page

如果您没有为 selector 字段提供值,则 Istio 会将策略与策略存储范围内的所有工作负载进行匹配。因此, selector 字段可帮助您指定策略的范围:

网格范围策略:为根名称空间指定的策略,不带或带有空的 字段。

selector

命名空间范围的策略:为非root命名空间指定的策略,不带有或带有空的 selector 字段。特定于工作负载的策略:在常规名称空间中定义的策略,带有非空 selector 字段。

Peer 和 request 认证策略对和应用它们。

selector

字段遵循相同的层次结构原则,但是 Istio 以略有不同的方式组合

只能有一个网格范围的 Peer 认证策略,每个命名空间也只能有一个命名空间范围的 Peer 认证策略。当您为同一网格或命名空间配置多个网格范围或命名空间范围的 Peer 认证策略时,Istio 会忽略较新的策略。当多个特定于工作负载的 Peer 认证策略匹配时,Istio 将选择最旧的策略。

Istio 按照以下顺序为每个工作负载应用最窄的匹配策略:

- 特定于工作负载的

- 命名空间范围

- 网格范围

Istio 可以将所有匹配的 request 认证策略组合起来,就像它们来自单个 request 认证策略一样。因此,您可以在网格或名称空间中配置多个网格范围或命名空间范围的策略。但是,避免使用多个网格范围或命名空间范围的request 认证策略仍然是一个好的实践。

Peer authentication

Peer 认证策略指定 Istio 对目标工作负载实施的双向 TLS 模式。支持以下模式:

PERMISSIVE:工作负载接受双向 TLS 和纯文本流量。此模式在迁移因为没有 sidecar 而无法使用双向TLS 的工作负载的过程中非常有用。一旦工作负载完成 sidecar 注入的迁移,应将模式切换为 STRICT。STRICT: 工作负载仅接收双向 TLS 流量。

DISABLE:禁用双向 TLS。 从安全角度来看,除非您提供自己的安全解决方案,否则请勿使用此模式。

如果未设置模式,将继承父作用域的模式。未设置模式的网格范围的 peer 认证策略默认使用 模式。

PERMISSIVE

下面的 peer 认证策略要求命名空间 中的所有工作负载都使用双向 TLS:

foo

- apiVersion: “security.istio.io/v1beta1”

- kind: “PeerAuthentication”

- metadata:

- name: “example-policy”

- namespace: “foo”

- spec:

- mtls:

- mode: STRICT

对于特定于工作负载的 peer 认证策略,可以为不同的端口指定不同的双向 TLS 模式。您只能将工作负载声明过的

端口用于端口范围的双向 TLS 配置。以下示例为

app:example-app

有其他端口使用名称空间范围的 peer 认证策略的双向 TLS 设置:

工作负载禁用了端口80上的双向TLS,并对所

-

apiVersion: “security.istio.io/v1beta1”

-

kind: “PeerAuthentication”

-

metadata:

-

name: “example-workload-policy”

-

namespace: “foo”

-

spec:

-

selector:

-

matchLabels:

-

app: example-app

-

portLevelMtls: 11. 80:

-

mode: DISABLE

上面的 peer 认证策略仅在有如下 Service 定义时工作,将流向 服务的请求绑定到

example-service

工作负载的 端口

example-app

80

- apiVersion: v1

- kind: Service

- metadata:

- name: example-service

- namespace: foo

- spec:

- ports:

-

- name: http 9. port: 8000

- protocol: TCP

- targetPort: 80

- selector:

- app: example-app

Request authentication

Request 认证策略指定验证 JSON Web Token(JWT)所需的值。 这些值包括:

token 在请求中的位置请求的 issuer

公共 JSON Web Key Set(JWKS)

Istio 会根据 request 认证策略中的规则检查提供的令牌(如果已提供),并拒绝令牌无效的请求。当请求不带有令牌时,默认情况下将接受它们。要拒绝没有令牌的请求,请提供授权规则,该规则指定对特定操作(例如,路径或操作)的限制。

如果 Request 认证策略使用唯一的位置,则它们可以指定多个JWT。当多个策略与工作负载匹配时,Istio 会将所有规则组合起来,就好像它们被指定为单个策略一样。此行为对于开发接受来自不同 JWT 提供者的工作负载时很有用。但是,不支持具有多个有效 JWT 的请求,因为此类请求的输出主体未定义。

Principals

使用 peer 认证策略和双向 TLS 时,Istio 将身份从 peer 认证提取到 source.principal 中。同样,当您使用 request 认证策略时,Istio 会将 JWT 中的身份赋值给 request.auth.principal 。使用这些 principals 设置授权策略和作为遥测的输出。

更新认证策略

您可以随时更改认证策略,Istio 几乎实时将新策略推送到工作负载。但是,Istio 无法保证所有工作负载都同时收到新政策。以下建议有助于避免在更新认证策略时造成干扰:

将 peer 认证策略的模式从

更改为

时,请使用

模式来过渡,反之亦然。

当所有工作负载成功切换到所需模式时,您可以将策略应用于最终模式。您可以使用 Istio 遥测技术来验证工作负载已成功切换。

DISABLE

STRICT

PERMISSIVE

将 request 认证策略从一个 JWT 迁移到另一个 JWT 时,将新 JWT 的规则添加到该策略中,而不删除旧规则。这样,工作负载接受两种类型的 JWT,当所有流量都切换到新的 JWT 时,您可以删除旧规则。但是, 每个 JWT 必须使用不同的位置。

授权

Istio 的授权功能为网格中的工作负载提供网格、命名空间和工作负载级别的访问控制。这种控制层级提供了以下优点:

工作负载间和最终用户到工作负载的授权。

一个简单的 API:它包括一个单独的并且很容易使用和维护的

CRD。

灵活的语义:运维人员可以在 Istio 属性上定义自定义条件,并使用 DENY 和 ALLOW 动作。高性能:Istio 授权是在 Envoy 本地强制执行的。

AuthorizationPolicy

高兼容性:原生支持 HTTP、HTTPS 和 HTTP2,以及任意普通 TCP 协议。

授权架构

每个 Envoy 代理都运行一个授权引擎,该引擎在运行时授权请求。当请求到达代理时,授权引擎根据当前授权策略

ALLOW

DENY

.yaml

评估请求上下文,并返回授权结果

或 。 运维人员使用

文件指定 Istio 授权策略。

授权架构

隐式启用

您无需显式启用 Istio 的授权功能。只需将授权策略应用于工作负载即可实施访问控制。对于未应用授权策略的工作负载,Istio 不会执行访问控制,放行所有请求。

授权策略支持 和 动作。 拒绝策略优先于允许策略。如果将任何允许策略应用于工作负载,则默

ALLOW

DENY

认情况下将拒绝对该工作负载的访问,除非策略中的规则明确允许。当您将多个授权策略应用于相同的工作负载时,

Istio 会累加地应用它们。

授权策略

要配置授权策略,请创建一个

AuthorizationPolicy

(action) 和一个规则(rules)列表:

自定义资源。 一个授权策略包括选择器(selector),动作

selector 字段指定策略的目标action 字段指定允许还是拒绝请求rules 指定何时触发动作

rules 下的 from 字段指定请求的来源

rules 下的 to 字段指定请求的操作

rules 下的 when 字段指定应用规则所需的条件

以下示例显示了一个授权策略,该策略允许两个源(服务帐号 cluster.local/ns/default/sa/sleep 和命名空间dev ),在使用有效的 JWT 令牌发送请求时,可以访问命名空间 foo 中的带有标签 app: httpbin 和version: v1 的工作负载。

-

apiVersion: security.istio.io/v1beta1

-

kind: AuthorizationPolicy

-

metadata:

-

name: httpbin

-

namespace: foo

-

spec:

-

selector:

-

matchLabels:

-

app: httpbin

-

version: v1

-

action: ALLOW

-

rules:

-

- from:

-

- source:

-

principals: [“cluster.local/ns/default/sa/sleep”]

-

- source:

-

namespaces: [“dev”]

-

to:

-

- operation:

-

methods: [“GET”]

-

when:

-

- key: request.auth.claims[iss]

-

values: [“https://accounts.google.com”]

下例显示了一个授权策略,如果请求来源不是命名空间 ,请求将被拒绝。

foo

- apiVersion: security.istio.io/v1beta1

- kind: AuthorizationPolicy

- metadata:

- name: httpbin-deny

- namespace: foo

- spec:

- selector:

- matchLabels:

- app: httpbin

- version: v1

- action: DENY

- rules:

-

- from:

-

- source:

- notNamespaces: [“foo”]

拒绝策略优先于允许策略。如果请求同时匹配上允许策略和拒绝策略,请求将被拒绝。Istio 首先评估拒绝策略,以确保允许策略不能绕过拒绝策略

策略目标

您可以通过

字段和可选的

字段来指定策略的范围或目标。

告诉该策略适用于哪个命名空间。如果将其值设置为根名称空间,则该策略将应用于网格中的所有名称空间。根命名

metadata/namespace

selector

metadata/namespace

istio-system

空间的值是可配置的,默认值为间。

。如果设置为任何其他名称空间,则该策略仅适用于指定的名称空

您可以使用 selector 字段来进一步限制策略以应用于特定工作负载。 使用标签选择目标工作负

selector

载。 slector 包含 {key: value} 对的列表,其中 是标签的名称。如果未设置,则授权策略将应用于与

key

授权策略相同的命名空间中的所有工作负载。

default

app: products

“GET”

以下示例策略

allow-read

访问。

“HEAD”

允许对

命名空间中带有标签

的工作负载的 和

- apiVersion: security.istio.io/v1beta1

- kind: AuthorizationPolicy

- metadata:

- name: allow-read

- namespace: default

- spec:

- selector:

- matchLabels:

- app: products

- action: ALLOW

- rules:

-

- to:

-

- operation:

- methods: [“GET”, “HEAD”]

值匹配

授权策略中的大多数字段都支持以下所有匹配模式:

完全匹配:即完整的字符串匹配。

前缀匹配: “" 结尾的字符串。例如, "test.abc.” 匹配

“test.abc.com” 、 、 “test.abc.org” 等等。

“test.abc.com.cn”

后缀匹配: “" 开头的字符串。例如, ".abc.com” 匹配 “eng.abc.com” 、 “test.eng.abc.com” 等等。 存在匹配: * 用于指定非空的任意内容。您可以使用格式 fieldname: [“*”] 指定必须存在的字段。这意味着该字段可以匹配任意内容,但是不能为空。请注意这与不指定字段不同,后者意味着包括空的任意内容。

有一些例外。 例如,以下字段仅支持完全匹配:

when 部分下的 key 字段source 部分下 的 ipBlocks to 部分下的 ports 字段

*/info

以下示例策略允许访问前缀为

/test/*

或后缀为

的路径。

-

apiVersion: security.istio.io/v1beta1

-

kind: AuthorizationPolicy

-

metadata:

-

name: tester

-

namespace: default

-

spec:

-

selector:

-

matchLabels:

-

app: products

-

action: ALLOW

-

rules:

-

- to:

- operation:

paths: [“/test/", "/info”]

排除匹配

为了匹配诸如

字段中的

, 字段中的

, 字段中的

之类的否定条件,Istio 支持排除匹配。

when

notValues

source

notIpBlocks

to

notPorts

以下示例:如果请求路径不是 /healthz ,则要求从请求的 JWT 认证中导出的主体是有效的。 因此,该策略从

JWT 身份验证中排除对 /healthz 路径的请求:

- apiVersion: security.istio.io/v1beta1

- kind: AuthorizationPolicy

- metadata:

- name: disable-jwt-for-healthz

- namespace: default

- spec:

- selector:

- matchLabels:

- app: products

- action: ALLOW

- rules:

-

- to:

-

- operation:

- notPaths: [“/healthz”]

- from:

-

- source:

- requestPrincipals: [“*”]

下面的示例拒绝到 路径且不带请求主体的请求:

/admin

- apiVersion: security.istio.io/v1beta1

- kind: AuthorizationPolicy

- metadata:

- name: enable-jwt-for-admin

- namespace: default

- spec:

- selector:

- matchLabels:

- app: products

- action: DENY

- rules:

-

- to:

-

- operation:

- paths: [“/admin”]

- from:

-

- source:

- notRequestPrincipals: [“*”]

全部允许和默认全部拒绝授权策略

以下示例显示了一个简单的

allow-all

授权策略,该策略允许完全访问

命名空间中的所有工作负载。

default

-

apiVersion: security.istio.io/v1beta1

-

kind: AuthorizationPolicy

-

metadata:

-

name: allow-all

-

namespace: default

-

spec:

-

action: ALLOW

-

rules:

-

- {}

以下示例显示了一个策略,该策略不允许任何对 命名空间工作负载的访问。

admin

- apiVersion: security.istio.io/v1beta1

- kind: AuthorizationPolicy

- metadata:

- name: deny-all

- namespace: admin

- spec: 7. {}

自定义条件

您还可以使用 when 部分指定其他条件。 例如,下面的 定义包括以下条

AuthorizationPolicy

件: request.headers [version] 是 或 。 在这种情况下,key 是 ,它

v1

v2

request.headers [version]

是 Istio 属性 request.headers (是个字典)中的一项。

- apiVersion: security.istio.io/v1beta1

- kind: AuthorizationPolicy

- metadata:

- name: httpbin

- namespace: foo

- spec:

- selector:

- matchLabels:

- app: httpbin

- version: v1

- action: ALLOW

- rules:

-

- from:

-

- source:

- principals: [“cluster.local/ns/default/sa/sleep”]

- to:

-

- operation:

- methods: [“GET”]

- when:

-

- key: request.headers[version] 21. values: [“v1”, “v2”]

条件页面中列出了支持的条件 值。

key

认证与未认证身份

如果要使工作负载可公开访问,则需要将作负载的源,例如:

source

部分留空。这允许来自所有(经过认证和未经认证)的用户和工

- apiVersion: security.istio.io/v1beta1

- kind: AuthorizationPolicy

- metadata:

- name: httpbin

- namespace: foo

- spec:

- selector:

- matchLabels:

- app: httpbin

- version: v1

- action: ALLOW

- rules:

-

- to:

-

- operation:

- methods: [“GET”, “POST”]

要仅允许经过认证的用户,请将

principal

设置为

,例如:

“*”

- apiVersion: security.istio.io/v1beta1

- kind: AuthorizationPolicy

- metadata:

- name: httpbin

- namespace: foo

- spec:

- selector:

- matchLabels:

- app: httpbin

- version: v1

- action: ALLOW

- rules:

-

- from:

-

- source:

- principals: [“*”]

- to:

-

- operation:

- methods: [“GET”, “POST”]

在普通 TCP 协议上使用 Istio 授权

Istio 授权支持工作负载使用任意普通 TCP 协议,如 MongoDB。 在这种情况下,您可以按照与 HTTP 工作负载相同的方式配置授权策略。 不同之处在于某些字段和条件仅适用于 HTTP 工作负载。 这些字段包括:

授权策略对象 部分中的 字段

source

request_principals

授权策略对象

operation

部分中的 、

和 字段

条件页面中列出了支持的条件。

hosts

methods

paths

如果您在授权策略中对 TCP 工作负载使用了任何只适用于 HTTP 的字段,Istio 将会忽略它们。

假设您在端口 27017 上有一个 MongoDB 服务,下例配置了一个授权策略,只允许 Istio 网格中的

bookinfo-ratings-v2 服务访问该 MongoDB 工作负载。

-

apiVersion: “security.istio.io/v1beta1”

-

kind: AuthorizationPolicy

-

metadata:

-

name: mongodb-policy

-

namespace: default

-

spec:

-

selector:

-

matchLabels:

-

app: mongodb

-

action: ALLOW

-

rules:

-

- from:

-

- source:

-

principals: [“cluster.local/ns/default/sa/bookinfo-ratings-v2”]

-

to:

-

- operation:

-

ports: [“27017”]

对双向 TLS 的依赖

Istio 使用双向 TLS 将某些信息从客户端安全地传递到服务器。在使用授权策略中的以下任何字段之前,必须先启用双向 TLS:

source 部分下的 字段

principals

namespaces

source 部分下的 字段source.principal 自定义条件source.namespace 自定义条件connection.sni 自定义条件

如果您不使用授权策略中的上述任何字段,则双向 TLS 不是必须的。

相关内容

HTTP 流量授权

展示如何设置基于角色的 HTTP 流量访问控制。

TCP 流量的授权

展示如何设置 TCP 流量的访问控制。

授权策略信任域迁移

阐述如何在不更改授权策略的前提下从一个信任域迁移到另一个。基于 Istio 授权的 Micro-Segmentation

描述 Istio 的授权功能以及如何在各种用例中使用它。

Istio v1beta1 授权策略概述

Istio v1beta1 授权策略的设计原则、基本概述及迁移操作。

APP 身份和访问适配器

使用 Istio 实现零代码改动保护多云 Kubernetes 应用。

可观察性

Istio 为网格内所有的服务通信生成详细的遥测数据。这种遥测技术提供了服务行为的可观察性,使运维人员能够排查故障、维护和优化应用程序,而不会给服务的开发人员带来任何额外的负担。通过 Istio,运维人员可以全面了解到受监控的服务如何与其他服务以及 Istio 组件进行交互。

Istio 生成以下类型的遥测数据,以提供对整个服务网格的可观察性:

指标。Istio 基于 4 个监控的黄金标识(延迟、流量、错误、饱和)生成了一系列服务指标。Istio 还为网格控制平面提供了更详细的指标。除此以外还提供了一组默认的基于这些指标的网格监控仪表板。

分布式追踪。Istio 为每个服务生成分布式追踪 span,运维人员可以理解网格内服务的依赖和调用流程。访问日志。当流量流入网格中的服务时,Istio 可以生成每个请求的完整记录,包括源和目标的元数据。此信息使运维人员能够将服务行为的审查控制到单个工作负载实例的级别。

指标

指标(Metric)提供了一种以聚合的方式监控和理解行为的方法。

为了监控服务行为,Istio 为服务网格中所有出入的服务流量都生成了指标。这些指标提供了关于行为的信息,例如总流量数、错误率和请求响应时间。

除了监控网格中服务的行为外,监控网格本身的行为也很重要。Istio 组件可以导出自身内部行为的指标,以提供对网格控制平面的功能和健康情况的洞察能力。

Istio 指标收集由运维人员配置来驱动。运维人员决定如何以及何时收集指标,以及指标本身的详细程度。这使得它能够灵活地调整指标收集来满足个性化需求。

代理级别指标

Istio 指标收集从 sidecar 代理(Envoy)开始。每个代理为通过它的所有流量(入站和出站)生成一组丰富的指标。代理还提供关于它本身管理功能的详细统计信息,包括配置信息和健康信息。

Envoy 生成的指标提供了资源(例如监听器和集群)粒度上的网格监控。因此,为了监控 Envoy 指标,需要了解网格服务和 Envoy 资源之间的连接。

Istio 允许运维人员在每个工作负载实例上选择生成和收集哪个 Envoy 指标。默认情况下,Istio 只支持Envoy 生成的统计数据的一小部分,以避免依赖过多的后端服务,还可以减少与指标收集相关的 CPU 开销。然而, 运维人员可以在需要时轻松地扩展收集到的代理指标集。这支持有针对性地调试网络行为,同时降低了跨网格监控的 总体成本。

Envoy 文档包括了 Envoy 统计信息收集的详细说明。Envoy 统计里的操作手册提供了有关控制代理级别指标生成的更多信息。

代理级别指标的例子:

-

envoy_cluster_internal_upstream_rq{response_code_class=“2xx”,cluster_name=“xds-grpc”} 7163 2.

-

envoy_cluster_upstream_rq_completed{cluster_name=“xds-grpc”} 7164 4.

-

envoy_cluster_ssl_connection_error{cluster_name=“xds-grpc”} 0 6.

-

envoy_cluster_lb_subsets_removed{cluster_name=“xds-grpc”} 0 8.

-

envoy_cluster_internal_upstream_rq{response_code=“503”,cluster_name=“xds-grpc”} 1

服务级别指标

除了代理级别指标之外,Istio 还提供了一组用于监控服务通信的面向服务的指标。这些指标涵盖了四个基本的服务监控需求:延迟、流量、错误和饱和情况。Istio 带有一组默认的仪表板,用于监控基于这些指标的服务行为。

默认的 Istio 指标由 Istio 提供的配置集定义并默认导出到 Prometheus。运维人员可以自由地修改这些指标的形态和内容,更改它们的收集机制,以满足各自的监控需求。

收集指标任务为定制 Istio 指标生成提供了更详细的信息。

服务级别指标的使用完全是可选的。运维人员可以选择关闭指标的生成和收集来满足自身需要。服务级别指标的例子:

- istio_requests_total{

- connection_security_policy=“mutual_tls”,

- destination_app=“details”,

- destination_principal=“cluster.local/ns/default/sa/default”,

- destination_service=“details.default.svc.cluster.local”,

- destination_service_name=“details”,

- destination_service_namespace=“default”,

- destination_version=“v1”,

- destination_workload=“details-v1”,

- destination_workload_namespace=“default”,

- reporter=“destination”,

- request_protocol=“http”,

- response_code=“200”,

- response_flags=“-”,

- source_app=“productpage”,

- source_principal=“cluster.local/ns/default/sa/default”,

- source_version=“v1”,

- source_workload=“productpage-v1”,

- source_workload_namespace=“default” 20. } 214

控制平面指标

每一个 Istio 的组件(Pilot、Galley、Mixer)都提供了对自身监控指标的集合。这些指标容许监控 Istio

自己的行为(这与网格内的服务有所不同)。

有关这些被维护指标的更多信息,请查看每个组件的参考文档:

Pilot Galley Mixer Citadel

分布式追踪

分布式追踪通过监控流经网格的单个请求,提供了一种监控和理解行为的方法。追踪使网格的运维人员能够理解服务的依赖关系以及在服务网格中的延迟源。

Istio 支持通过 Envoy 代理进行分布式追踪。代理自动为其应用程序生成追踪 span,只需要应用程序转发适当的请求上下文即可。

Istio 支持很多追踪系统,包括 Zipkin、Jaeger、LightStep、Datadog。运维人员控制生成追踪的采样率

(每个请求生成跟踪数据的速率)。这允许运维人员控制网格生成追踪数据的数量和速率。更多关于 Istio 分布式追踪的信息可以在分布式追踪 FAQ 中找到。

Istio 为一个请求生成的分布式追踪数据:

Distributed Trace for a single request

访问日志

访问日志提供了一种从单个工作负载实例的角度监控和理解行为的方法。

Istio 可以以一组可配置的格式集生成服务流量的访问日志,为运维人员提供日志记录的方式、内容、时间和位置的完全控制。Istio 向访问日志机制暴露了完整的源和目标元数据,允许对网络通信进行详细的审查。

访问日志可以在本地生成,或者导出到自定义的后端基础设施,包括 Fluentd。更多关于访问日志的内容在收集日志和获取 Envoy 服务日志任务中提供。Istio 访问日志例子(JSON 格式):

{“level”:“info”,“time”:“2019-06-11T20:57:35.424310Z”,“instance”:“accesslog.instance.istio- control”,“connection_security_policy”:“mutual_tls”,“destinationApp”:“productpage”,“destinationIp”:“10.44.2.15”," pvsnd",“destinationNamespace”:“default”,“destinationOwner”:“kubernetes://apis/apps/v1/namespaces/default/deploym v1”,“destinationPrincipal”:“cluster.local/ns/default/sa/default”,“destinationServiceHost”:“productpage.default.s v1”,“httpAuthority”:“35.202.6.119”,“latency”:“35.076236ms”,“method”:“GET”,“protocol”:“http”,“receivedBytes”:917, 5642-434d-ae75-233a05b06158",“requestSize”:0,“requestedServerName”:"outbound_.9080_._.productpage.default.svc.cl ",“responseSize”:4183,“responseTimestamp”:“2019-06-11T20:57:35.459150Z”,“sentBytes”:4328,“sourceApp”:“istio- ingressgateway”,“sourceIp”:“10.44.0.8”,“sourceName”:“ingressgateway-7748774cbf-bvf4j”,“sourceNamespace”:“istio- control”,“sourceOwner”:“kubernetes://apis/apps/v1/namespaces/istio-control/deployments/ingressgateway”,"sourcePr

- control/sa/default",“sourceWorkload”:“ingressgateway”,“url”:“/productpage”,“userAgent”:“curl/7.54.0”,"xForwarded

相关内容

Mixer 配置模型

描述 Istio 策略执行和遥测机制的配置模型。

Mixer 和 SPOF 神话提高可用,降低延迟。Mixer 适配器模型

概要说明 Mixer 的插件架构。

TLS Egress 监控和策略配置

描述如何在 TLS Egress 上配置 SNI 监控和策略。

APP 身份和访问适配器

使用 Istio 实现零代码改动保护多云 Kubernetes 应用。

Denials 和黑白名单

描述如何使用简单的 denials 或黑白名单来控制对服务的访问。

安装

关于如何在 Kubernetes 集群中安装 Istio 控制平面和添加虚拟机到 mesh 中的说明。

开始

下载、安装并学习如何快速使用 Istio 的基本特性。

平台安装

在安装 Istio 之前如何准备各种 Kubernetes 平台。

安装指南

选择最适合您的需求和平台的指南。

升级

选择与您先前用于安装 Istio 的方法相对应的升级指南。

更多指南

有关其他设置任务的更多信息。

开始

本指南面向 Istio 的新用户,让您通过安装 配置文件快速评估 Istio。

demo

如果您已经熟悉 Istio 或对安装其他配置文件或更高级的部署模型感兴趣, 请遵循使用 istioctl 的安装说明文档。

此 demo 配置文件不适用于性能评估。它旨在展示 Istio 高水平跟踪和访问日志的功能。要开始使用 Istio,只需遵循以下三个步骤:

- 搭建平台

- 下载 Istio

- 安装 Istio

搭建平台

在安装 Istio 之前,需要一个运行着 Kubernetes 的兼容版本的 cluster。Istio 1.6 已经在 Kubernetes 版本 1.15, 1.16, 1.17, 1.18 中测试过。

通过选择合适的 platform-specific setup instructions 来创建一个集群。

有些平台提供了 managed control plane,您可以使用它来代替手动安装 Istio。如果您选择的平台支持这种方式,并且您选择使用它,那么,在创建完集群后,您将完成 Istio 的安装。因此,可以跳过以下说明。

下载 Istio

下载 Istio,下载内容将包含:安装文件、示例和 istioctl 命令行工具。

-

访问 Istio release 页面下载与您操作系统对应的安装文件。在 macOS 或 Linux 系统中,也可以通过以下命令下载最新版本的 Istio:

-

$ curl -L https://istio.io/downloadIstio | sh -

-

切换到 Istio 包所在目录下。例如:Istio 包名为 ,则:

istio-1.6.0

- $ cd istio-1.6.0

安装目录包含如下内容:

install/kubernetes 目录下,有 Kubernetes 相关的 YAML 安装文件

samples/ 目录下,有示例应用程序

istioctl

istioctl

bin/ 目录下,包含理。

的客户端文件。

工具用于手动注入 Envoy sidecar 代

- 将 客户端路径增加到 path 环境变量中,macOS 或 Linux 系统的增加方式如下:

istioctl

-

$ export PATH= P W D / b i n : PWD/bin: PWD/bin:PATH

-

在使用 bash 或 ZSH 控制台时,可以选择启动 auto-completion option。

安装 Istio

请按照以下步骤在您所选的平台上使用 配置文件安装 Istio。

demo

- 安装 配置

demo

-

$ istioctl manifest apply --set profile=demo

-

为了验证是否安装成功,需要先确保以下 Kubernetes 服务正确部署,然后验证除 服务外

jaeger-agent

的其他服务,是否均有正确的 :

-

$ kubectl get svc -n istio-system

15020:31831/TCP,80:31380/TCP,443:31390/TCP,31400:31400/TCP,15029:30318/TCP,15030:32645/TCP,15031:31933/TCP -

2m

istio-pilot ClusterIP 172.21.105.205 15010/TCP,15011/TCP,8080/TCP,15014/TCP

- 2m

istio-policy

- 2m

istio-sidecar-injector

- 2m

istio-telemetry

ClusterIP

172.21.14.236

9091/TCP,15004/TCP,15014/TCP

ClusterIP

172.21.155.47

443/TCP,15014/TCP

ClusterIP

172.21.196.79

9091/TCP,15004/TCP,15014/TCP,42422/TCP

11. 2m

CLUSTER-IP

| NAME

| 2. AGE | TYPE | CLUSTER-IP | EXTERNAL-IP | PORT(S) |

|---|---|---|---|---|

| grafana | ClusterIP | 172.21.211.123 | 3000/TCP | |

| 3. 2m | ||||

| istio-citadel | ClusterIP | 172.21.177.222 | 8060/TCP,15014/TCP | |

| 4. 2m | ||||

| istio-egressgateway | ClusterIP | 172.21.113.24 | 80/TCP,443/TCP,15443/TCP | |

| 5. 2m | ||||

| istio-galley | ClusterIP | 172.21.132.247 | 443/TCP,15014/TCP,9901/TCP | |

| 6. 2m | ||||

| istio-ingressgateway | LoadBalancer | 172.21.144.254 | 52.116.22.242 |

| jaeger-agent | ClusterIP | None | 5775/UDP,6831/UDP,6832/UDP | |

|---|---|---|---|---|

| 12. 2m | ||||

| jaeger-collector | ClusterIP | 172.21.135.51 | 14267/TCP,14268/TCP | |

| 13. 2m | ||||

| jaeger-query | ClusterIP | 172.21.26.187 | 16686/TCP | |

| 14. 2m | ||||

| kiali | ClusterIP | 172.21.155.201 | 20001/TCP | |

| 15. 2m | ||||

| prometheus | ClusterIP | 172.21.63.159 | 9090/TCP | |

| 16. 2m | ||||

| tracing | ClusterIP | 172.21.2.245 | 80/TCP | |

| 17. 2m | ||||

| zipkin | ClusterIP | 172.21.182.245 | 9411/TCP | |

| 18. 2m |

如果集群运行在一个不支持外部负载均衡器的环境中(例如:minikube), 的

istio-ingressgateway

NodePort

将显示为

EXTERNAL-IP

状态。请使用服务的

或 端口转发来访问网关。

请确保关联的 Kubernetes pod 已经部署,并且 为 :

STATUS

Running

| 1. $ kubectl get pods -n istio-system | ||||

|---|---|---|---|---|

| 2. NAME | READY | STATUS | RESTARTS | AGE |

| 3. grafana-f8467cc6-rbjlg | 1/1 | Running | 0 | 1m |

| 4. istio-citadel-78df5b548f-g5cpw | 1/1 | Running | 0 | 1m |

| 5. istio-egressgateway-78569df5c4-zwtb5 | 1/1 | Running | 0 | 1m |

| 6. istio-galley-74d5f764fc-q7nrk | 1/1 | Running | 0 | 1m |

| 7. istio-ingressgateway-7ddcfd665c-dmtqz | 1/1 | Running | 0 | 1m |

| 8. istio-pilot-f479bbf5c-qwr28 | 1/1 | Running | 0 | 1m |

| 9. istio-policy-6fccc5c868-xhblv | 1/1 | Running | 2 | 1m |

| 10. istio-sidecar-injector-78499d85b8-x44m6 | 1/1 | Running | 0 | 1m |

| 11. istio-telemetry-78b96c6cb6-ldm9q | 1/1 | Running | 2 | 1m |

| 12. istio-tracing-69b5f778b7-s2zvw | 1/1 | Running | 0 | 1m |

| 13. kiali-99f7467dc-6rvwp | 1/1 | Running | 0 | 1m |

| 14. prometheus-67cdb66cbb-9w2hm | 1/1 | Running | 0 | 1m |

后续步骤

安装 Istio 后,就可以部署您自己的服务,或部署安装程序中系统的任意一个示例应用。应用程序必须使用 HTTP/1.1 或 HTTP/2.0 协议用于 HTTP 通信;HTTP/1.0 不支持。

kubectl apply

istio-injection=enabled

当使用

来部署应用时,如果 pod 启动在标有

的命名空间中,那么,

Istio sidecar 注入器将自动注入 Envoy 容器到应用的 pod 中:

istioctl kube-inject

- $ kubectl label namespace istio-injection=enabled

- $ kubectl create -n -f .yaml

在没有

istio-injection

动注入到应用的 pod 中:

标记的命名空间中,在部署前可以使用

命令将 Envoy 容器手

- $ istioctl kube-inject -f .yaml | kubectl apply -f -

如果您不确定要从哪开始,可以先部署 Bookinfo 示例,它会让您体验到 Istio 的流量路由、故障注入、速率限制等功能。 然后您可以根据您的兴趣浏览各种各样的 Istio 任务。

下列任务都是初学者开始学习的好入口:

请求路由 故障注入 流量转移 查询指标 可视化指标

日志收集速率限制

Ingress 网关访问外部服务 可视化您的网格

下一步,可以定制 Istio 并部署您自己的应用。在您开始自定义 Istio 来适配您的平台或者其他用途之前,请查看以下资源:

部署模型

部署最佳实践

Pod 需求

常规安装说明

使用 Istio 过程中有任何问题,请来信告知我们,并欢迎您加入我们的社区。

卸载

卸载程序将删除 RBAC 权限、它们可能已经被删除掉了。

istio-system

命名空间和所有相关资源。可以忽略那些不存在的资源的报错,因为

- $ istioctl manifest generate --set profile=demo | kubectl delete -f -

相关内容

Helm 变更

关于 Istio 1.1 和 Istio 1.2 之间的 Helm chart 安装选项的变更。

Helm 安装参数变动表

本文详细介绍了 Istio 1.0 系列到 Istio 1.1 系列之间的安装参数变化详情。

Helm 安装参数变动表

本文详细介绍了 Istio 1.2 系列到 Istio 1.3 系列之间的安装参数变化详情。

DNS 证书管理

在 Istio 中配置和管理 DNS 证书。

Istio Operator 简介

关于 Istio 基于 operator 的安装和控制平面管理特性的介绍。安全管理 Webhook

一种更安全管理 Istio webhook 的方法。

平台安装

在安装 Istio 之前如何准备各种 Kubernetes 平台。

阿里云

对阿里云 Kubernetes 集群进行配置以便安装运行 Istio。

Azure

为 Istio 设置一个 Azure 集群的指令。

Docker Desktop

在 Docker Desktop 中运行 Istio 的设置说明。

使用 Google Kubernetes Engine 快速开始

在 Google Kubernetes Engine (GKE) 上快速搭建 Istio 服务。

IBM Cloud 快速开始

在 IBM 公有云或私有云上快速搭建 Istio 服务。

kind

为 Istio 设置 kind 的说明。

Kubernetes Gardener 快速开始

使用 Gardener 快速搭建 Istio 服务。

MicroK8s

配置 MicroK8s 以便使用 Istio。

Minikube

在 Minikube 上配置 Istio。

OpenShift

对 OpenShift 集群进行配置以便安装运行 Istio。

Oracle Cloud Infrastructure

为 Istio 配置 OKE 集群环境的说明。

Istio 1.6 已在以下 Kubernetes 发现版下测试:1.15, 1.16, 1.17, 1.18。

阿里云

按照以下说明配置 阿里云 Kubernetes 容器服务 集群以便安装运行 Istio。 你可以在阿里云的 容器服务管理控制台 中快速简单的部署一个完全支持 Istio 的 Kubernetes 集群。

你也可以按照 阿里云应用目录说明 在阿里云 Kubernetes 容器服务中使用 应用目录 服务来安装配置 Istio。

前置条件

- 按照阿里云说明启用以下服务:容器服务、资源编排服务(ROS)和 RAM。

步骤

- 登陆 容器服务管理控制台 ,点击左边导航栏中 **Kubernetes **下的 集群 进入到 集群列表 页面。

- 点击右上角的 创建 **Kubernetes **集群 按钮。

- 输入集群名称。集群名称可以是长度为 1–63 个字符,可以包含数字、中文字符、英文字母和连字符 (-) 。

- 选择集群所在到 **region **和 zone。

- 设置集群网络类型。Kubernetes 集群现在只支持 VPC 的网络类型。

- 配置节点类型。支持按量付费和包年包月。

- 配置主节点。为主节点选择实例规格。

- 配置工作节点。选择是否创建工作节点或添加现有 ECS 实例作为工作节点。

- 配置登录模式,配置 POD 网络 CIDR 和 Service CIDR 。下图显示了完成前面所有步骤的界面:

Console

Azure

跟随这些指令来为 Istio 准备一个 Azure 集群。

你可以通过完全支持 Istio 的 AKS 或者 AKS-Engine,部署一个 Kubernetes 集群到 Azure 上。

AKS

你可以通过 the az cli 或者 the Azure portal 创建一个 AKS 集群。

对于 cli 的选项,完成 认证或者使用 cloud shell,然后运行下面的命令。

az

az login

- 确定支持 AKS 的期望 region 名

$ az provider list --query "[?namespace==‘Microsoft.ContainerService’].resourceTypes[] | [?

-

resourceType==‘managedClusters’].locations[]" -o tsv

-

证实对于期望的 region 有支持的 Kubernetes 版本

使用从上面步骤中期望的 region 值替换 ,然后执行:

my location

- $ az aks get-versions --location “my location” --query “orchestrators[].orchestratorVersion”

确保最小值 被列出。

1.10.5

- 创建 resource group 和部署 AKS 集群

使用期望的名字替换

和 ,使用第一步中的名字替换

,替换

如果其在 region 中不被支持,然后执行:

myResourceGroup

myAKSCluster

mylocation

1.10.5

- $ az group create --name myResourceGroup --location “my location”

$ az aks create --resource-group myResourceGroup --name myAKSCluster --node-count 3 --kubernetes-version

-

1.10.5 --generate-ssh-keys

-

取得 AKS 证书

kubeconfig

使用从之前步骤中获得的名字替换 和 并且执行:

myResourceGroup

myAKSCluster

- $ az aks get-credentials --resource-group myResourceGroup --name myAKSCluster

AKS-Engine

- 跟随这些命令来获取和安装 的二进制版本。

aks-engine

- 下载支持部署 Istio 的 API 模型定义:

aks-engine

Docker Desktop

-

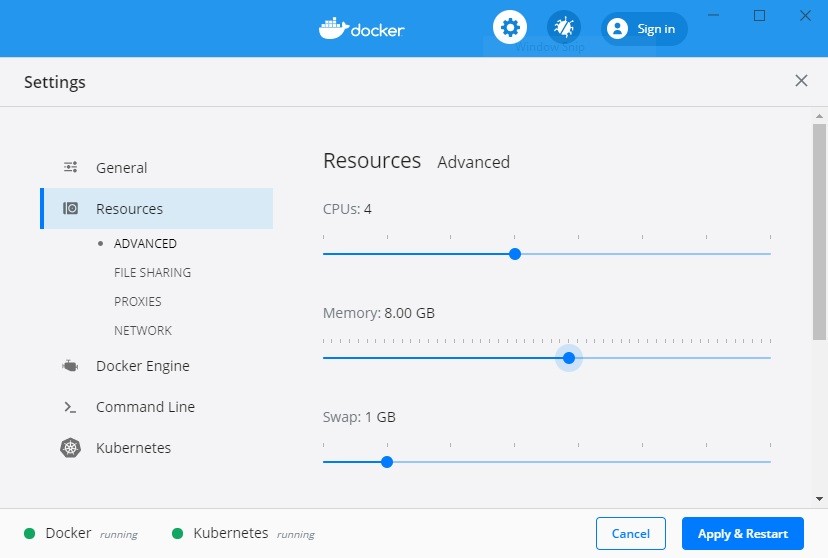

如果你想在 Docker Desktop 下运行 Istio,则需要安装受支持的 Kubernetes 版本 (1.15, 1.16, 1.17, 1.18)。

-

如果你想在 Docker Desktop 内置的 Kubernetes 下运行 Istio,你可能需要在 Docker 首选项的

Advanced 面板下增加 Docker 的内存限制。设置可用的内存资源为 8.0 以及 4 核心 .

GB

CPUs

Docker Preferences

最低内存的要求不尽相同。8 足以运行 Istio 和 Bookinfo 实例。如果你没有足够的内存用于

GB

Docker Desktop, 则可能发生以下错误:

镜像拉取失败

健康检查超时失败

宿主上 kubectl 运行失败虚拟机管理程序的网络不稳定

为 Docker Desktop 释放出更多可用资源:

- $ docker system prune

使用 Google Kubernetes Engine 快速开始

Google 为 GKE 提供了一个插件, 您可以使用它来代替手动安装 Istio。 要确定该插件是否适合您,请参阅

Istio on GKE 以获得更多信息。

依照以下操作指南为安装 Istio 准备一个 GKE 集群。

需要在 Istio 中启用秘钥发现服务(SDS),请使用 Kubernetes 1.13 或更高版本。

-

创建一个新集群。

-

$ gcloud container clusters create \

-

–cluster-version latest \

-

–machine-type=n1-standard-2 \

-

–num-nodes 4 \

-

–zone \

-

–project

默认安装 Mixer 要求节点的 vCPU 大于 1。 如果您要使用演示配置文件, 您可以删除

–machine-type

参数,以使用较小 机器配置代替。

n1-standard-1

–enable-

如果需要使用 Istio CNI 功能, 需要在

gcloud container clusters create

参数, 以启用 GKE 集群的 network-policy 功能。

network-policy

命令中加入

- 为 获取认证凭据。

kubectl

-

$ gcloud container clusters get-credentials \

-

–zone \

-

–project

-

为了给 Istio 创建 RBAC 规则,需要给当前用户赋予集群管理员(admin)权限,因此这里进行授权操作。

-

$ kubectl create clusterrolebinding cluster-admin-binding \

-

–clusterrole=cluster-admin \

-

–user=$(gcloud config get-value core/account)

IBM Cloud 快速开始

依照以下说明 在 IBM Cloud Kubernetes Service 公有云上搭建 Istio 服务集群。 在 Istio on IBM Cloud Private 私有云上搭建 Istio 服务集群。

IBM 为 IBM Cloud Kubernetes Service 提供了 managed control plane 插件, 您可以使用它代替手动安装 Istio。 请参阅 Istio on IBM Cloud Kubernetes Service 有关详细信息和说明。

要在手动安装 Istio 之前准备群集,请按照下列步骤操作:

- 安装 IBM Cloud CLI,IBM Cloud Kubernetes Service 插件和 Kubernetes CLI.

<zone-

- 使用以下命令创建标准的 Kubernetes 集群。 将替换为可用区。

您可以通过运行

ibmcloud ks zones

介绍可用区域以及如何指定它们。

来显示可用区。 IBM Cloud Kubernetes Service 位置参考指南

- $ ibmcloud ks cluster-create --zone --machine-type b3c.4x16 \

- –workers 3 --name

如果已经有专用和公用 VLAN,您可以在上面的命令中指定使用 --private-vlan 和 选项。 否则, 将自动为您创建。您可以通过运行 ibmcloud ks vlans --zone 来查看可用的 VLAN。

–public-vlan

KUBECONFIG

- 运行以下命令下载您的

kubectl

集群配置,然后按照命令输出的说明来设置

环境变量。

- $ ibmcloud ks cluster-config

确保使用与集群的 Kubernetes 版本匹配的 CLI 版本。

kubectl

kind

kind 是一种使用 Docker 容器 运行本地 Kubernetes 集群的工具。 kind 主要是为了测试

nodes

Kubernetes 自身而设计的,但它也可用于本地开发或 CI。 请按照以下说明为 Istio 安装准备好 kind 集群。

准备

请使用最新的 Go 版本,最好是 Go 1.13 或更新版本。为了使用 kind,还需要安装 docker。

安装最新版本的 kind。

安装步骤

-

使用下列命令创建一个集群:

-

$ kind create cluster --name istio-testing

用于为集群指定一个名字。默认情况下,该集群将会名为 。

–name

kind

-

使用下列命令查看 kind 集群列表:

-

$ kind get clusters

-

istio-testing

-

使用下列命令查看本地 Kubernetes 环境:

-

$ kubectl config get-contexts

-

CURRENT NAME CLUSTER

-

- kind-istio-testing kind-istio-testing

-

minikube minikube

AUTHINFO

kind-istio-testing minikube

NAMESPACE

会作为前缀加到环境和集群名上,如:

kind

kind-istio-testing

- 如果运行了多套集群,还需要选择 将要操作哪一套。 可以在 Kubernetes kubeconfig 文件

kubectl

中设置当前环境来指定一个默认集群。 另外,还可以运行下列命令来为 设置当前环境:

kubectl

- $ kubectl config use-context kind-istio-testing

- Switched to context “kind-istio-testing”.

kind 集群设置完成后,就可以开始在它上面安装 Istio 了。

-

当体验过后,想删除集群时,可以使用以下命令:

-

$ kind delete cluster --name istio-testing

-

Deleting cluster “istio-testing” …

为 kind 设置操作界面

kind 不像 minikube 一样内置了操作界面。但仍然可以设置一个基于网页的 Kubernetes 界面,以查看集群。参考以下说明来为 kind 设置操作界面。

- 运行以下命令以部署操作界面:

$ kubectl apply -f https://raw.githubusercontent.com/kubernetes/dashboard/v2.0.0-

-

beta8/aio/deploy/recommended.yaml

-

验证操作界面已经部署并且正在运行。

| 1. $ kubectl get pod -n kubernetes-dashboard | ||||

|---|---|---|---|---|

| 2. NAME | READY | STATUS | RESTARTS | AGE |

| 3. dashboard-metrics-scraper-76585494d8-zdb66 | 1/1 | Running | 0 | 39s |

| 4. kubernetes-dashboard-b7ffbc8cb-zl8zg | 1/1 | Running | 0 | 39s |

- 创建 以提供对新创建的集群的管理权限访问。

ClusterRoleBinding

$ kubectl create clusterrolebinding default-admin --clusterrole cluster-admin –

-

serviceaccount=default:default

-

需要用 Bearer Token 来登录到操作界面。使用以下命令将 token 保存到变量。

$ token=$(kubectl get secrets -o jsonpath="{.items[?(@.metadata.annotations['kubernetes.io/service-

- account.name’]==‘default’)].data.token}"|base64 -d)

使用 命令显示 token 并复制它,以用于登录到操作界面。

echo

-

$ echo $token

-

使用 kubectl 命令行工具运行以下命令以访问操作界面:

-

$ kubectl proxy

-

Starting to serve on 127.0.0.1:8001

点击 Kubernetes Dashboard 来查看部署和服务。

最好将 token 保存起来,不然每次登录到操作界面需要 token 时都得重新运行上述步骤 4.

Kubernetes Gardener 快速开始

Gardener 引导

使用 Gardener 建立自己的集群, 可以查看 文档, 也可以查看 landscape-setup-template 项目。 要了解

有关此开源项目的更多信息,请阅读 博客.

kubernetes.io

安装并且配置 kubectl

v1.10

- 如果您已经有本。 如果您的

CLI,请运行

较旧,请按照下一步安装新版本。

kubectl

kubectl

kubectl version --short

来检查版本。您需要

或更高版

- 安装 CLI.

kubectl

访问 Gardener

- 在 Gardener 仪表板中创建一个项目。这实际上将创建一个名为命名空间。

garden-

的 Kubernetes

- 配置对您的 Gardener 项目的访问权限 使用 kubeconfig,如果您还不是 Gardener 管理员,则可以在Gardener 仪表板中创建一个用户:转到 “Members” 部分并添加服务帐户。 然后,您可以为您的项目下载kubeconfig。如果使用用户界面创建集群,则可以跳过此步骤。 只有通过程序访问才需要它,请确保在您的

shell 中设置 。

export KUBECONFIG=garden-my-project.yaml

创建 Kubernetes 集群

您可以通过提供集群规范 yaml 文件,使用 cli 创建集群。您可以在这博客里找到关于 GCP 的示

kubectl

kubectl

例。 确保名称空间与您的项目名称空间匹配。然后只需将准备好的 “shoot” 群集 CRD 与用:

配合使

- $ kubectl apply --filename my-cluster.yaml

更简单的替代方法是按照 Gardener 仪表板中的集群创建向导来创建集群:

为集群配置 kubectl

现在,您可以在 Gardener 仪表板中或通过 cli 为新创建的集群下载 kubeconfig,如下所示:

$ kubectl --namespace shoot–my-project–my-cluster get secret kubecfg --output jsonpath={.data.kubeconfig} |

- base64 --decode > my-cluster.yaml

此 kubeconfig 文件具有管理员对您群集的完全访问权限。对于本指南的其余部分,请确保已设置

export

。

KUBECONFIG=my-cluster.yaml

删除

kubectl

使用 Gardener 仪表板删除集群,或者使用指向您的行以下操作:

garden-my-project.yaml

kubeconfig 的 执

$ kubectl --kubeconfig garden-my-project.yaml --namespace garden–my-project annotate shoot my-cluster

- confirmation.garden.sapcloud.io/deletion=true

- $ kubectl --kubeconfig garden-my-project.yaml --namespace garden–my-project delete shoot my-cluster

MicroK8s

请按照如下说明准备 MicroK8s 以便使用 Istio。运行 MicroK8s 需要管理员权限。

-

使用如下命令安装最新版本的 MicroK8s

-

$ sudo snap install microk8s --classic

-

使用如下命令启用 Istio。

-

$ microk8s.enable istio

-

当提示出现时,您需要选择是否在 sidecars 之间强制进行双向 TLS 认证。 如果您有不支持 Istio 和支持 Istio 服务的混合部署,或者您不确定,请选择 No。

请运行以下命令来检查部署进度:

- $ watch microk8s.kubectl get all --all-namespaces

Minikube

按照文档安装 minikube,为 Istio 与一些基础应用准备足够的系统资源。

前提条件

运行 minikube 需要管理员权限。

如果要启用秘钥发现服务(SDS),需要为 Kubernetes deployment 添加额外的配置。 访问参考文档查看最新的可选参数。

api-

server

安装步骤

- 安装最新的 minikube,版本 **1.1.1 **或更高,以及 minikube 虚拟机驱动。

- 如果你没有使用默认的驱动,需要配置 minikube 虚拟机驱动。

比如,如果你安装了 KVM 虚拟机,使用如下命令设置 minikube 的 配置:

vm-driver

-

$ minikube config set vm-driver kvm2

-

以 16384 MB 内存和 4 启动 minikube。这个例子使用了 Kubernetes 1.14.2。 你可以

CPUs

设置 --kubernetes-version 的值以指定任意 Istio 支持的 Kubernetes 版本:

- $ minikube start --memory=16384 --cpus=4 --kubernetes-version=v1.14.2

取决于你使用的虚拟机版本以及所运行的平台,最小内存要求也不同。16384 bookinfo。

MB

如果你没有足够的内存分配给 minikube 虚拟机,可能出现如下报错:

足够运行 Istio 和

image pull failures healthcheck timeout failures kubectl failures on the host

general network instability of the virtual machine and the host complete lock-up of the virtual machine

host NMI watchdog reboots

minikube 中有一个不错的方法查看内存占用:

-

$ minikube ssh

-

$ top

-

GiB Mem : 12.4/15.7

这里显示虚拟机内全部的 15.7G 内存已占用了 12.4G。这个数据是在一个 16G 内存的 Macbook Pro

13” 中运行着 Istio 1.2 和 bookinfo 的 VMWare Fusion 虚拟机中生成的。

-

(可选,推荐)如果你希望 minikube 提供一个负载均衡给 Istio,你可以使用 minikube tunnel。 在另一个终端运行这个命令,因为 minikube tunnel 会阻塞的你的终端用于显示网络诊断信息:

-

$ minikube tunnel

有时 minikube 不会正确清理 tunnel network。强制清理使用如下命令:

- $ minikube tunnel --cleanup

OpenShift

proxy-init

OpenShift 4.1 及以上版本使用的替。

nftables

与 Istio 的

容器不兼容。请使用 CNI 插件代

依照本指南对 OpenShift 集群进行配置以便安装运行 Istio。

默认情况下,OpenShift 不允许容器使用 User ID(UID)0 来运行。通过以下命令可以让 Istio 的服务账户

(Service Accounts)以 UID 0 来运行容器 (如果你将 Istio 部署到其它命名空间,请注意替换

istio-

):

system

- $ oc adm policy add-scc-to-group anyuid system:serviceaccounts -n istio-system

现在你可以按照 CNI 的操作来安装 Istio。

安装完成后,为 ingress 网关暴露一个 OpenShift 路由。

- $ oc -n istio-system expose svc/istio-ingressgateway --port=80

自动 sidecar 注入

如果你使用的是 OpenShift 4.1 或更高的版本,以下配置不是必须的,可以跳到下一章节。

要使自动注入能正常工作必须启用 Webhook 和证书签名请求(CSR)的支持。 请按以下说明在集群 master 节点修改 master 配置文件。

默认情况下,master 配置文件的路径是 。

/etc/origin/master/master-config.yaml

在 master 配置文件相同目录下创建文件 ,内容如下:

master-config.patch

- admissionConfig:

- pluginConfig:

- MutatingAdmissionWebhook:

- configuration:

- apiVersion: apiserver.config.k8s.io/v1alpha1

- kubeConfigFile: /dev/null

- kind: WebhookAdmission

- ValidatingAdmissionWebhook:

- configuration:

- apiVersion: apiserver.config.k8s.io/v1alpha1

- kubeConfigFile: /dev/null

- kind: WebhookAdmission

然后在该目录下执行:

-

$ cp -p master-config.yaml master-config.yaml.prepatch

-

$ oc ex config patch master-config.yaml.prepatch -p “$(cat master-config.patch)” > master-config.yaml

-

$ master-restart api

-

$ master-restart controllers

Sidecar 应用的专用安全上下文约束(SCC)

OpenShift 默认是不允许 Istio sidecar 注入到每个应用 Pod 中以 ID 为 1377 的用户运行的。要允许使

用该 UID 运行,需要执行以下命令(注意替换 为适当的命名空间):

- $ oc adm policy add-scc-to-group privileged system:serviceaccounts -n

- $ oc adm policy add-scc-to-group anyuid system:serviceaccounts -n

当需要移除应用时,请按以下操作移除权限:

- $ oc adm policy remove-scc-from-group privileged system:serviceaccounts -n

- $ oc adm policy remove-scc-from-group anyuid system:serviceaccounts -n

Oracle Cloud Infrastructure

根据如下介绍,为 Istio 配置 OKE 集群环境。

-

在您的 OCI 租户中,创建一个新的 OKE 集群。最简单的方式就是使用 web 控制台中的 ‘Quick Cluster’ 选项。您也可以使用下面的 OCI cli 命令:

-

$ oci ce cluster create --name oke-cluster1 \

-

–kubernetes-version \

-

–vcn-id \

-

–service-lb-subnet-ids [] \ 5. …

-

使用 OCI cli 为您的 获取凭据:

kubectl

-

$ oci ce cluster create-kubeconfig \

-

–file <path/to/config> \

-

–cluster-id

-

向当前用户授予集群管理员(admin)权限。要为 Istio 创建必要的 RBAC 规则,当前用户需要拥有管理员权限。

-

$ kubectl create clusterrolebinding cluster-admin-binding \

-

–clusterrole=cluster-admin \

-

–user=<user_ocid>

安装指南

选择最适合您的需求和平台的指南。

使用 Istioctl 安装

安装和自定义任何 Istio 配置文件以进行深入评估或用于生产。

使用 Helm 自定义安装

安装和配置 Istio 以进行深入评估或用于生产。

安装独立 Operator [实验]

使用 Istio operator 在 Kubernetes 集群中安装 Istio 指南。

多集群安装

配置跨越多个 Kubernetes 集群的 Istio 服务网格。

Istio 1.6 已通过这些 Kubernetes 发行版测试:1.15, 1.16, 1.17, 1.18.

使用 Istioctl 安装

请按照本指南安装和配置 Istio 网格,以进行深入评估或用于生产。 如果您刚接触 Istio 或者只是要简单试用,请参考开始文档进行操作。

本指南使用可以高度自定义 Istio 控制平面和数据平面的校验功能,可以防止错误的安装和自定义选项。

istioctl

命令行工具。 该命令行工具具有用户输入

使用这些命令说明,您可以选择 Istio 的任何内置配置文件然后 根据您的特定需求进一步自定义配置。

前提条件

开始之前,请检查以下前提条件:

- 下载 Istio 发行版本。

- 执行任何必要的特定于平台的设置。

- 检查 Pods 和 Services 的要求。

使用默认配置文件安装 Istio

最简单的选择是安装 Istio 配置文件使用以下命令:

default

- $ istioctl manifest apply

此命令将在您配置的 Kubernetes 集群上安装 default 配置文件。

default

起点,这与旨在评估广泛的 Istio 功能特性的较大的 demo 配置文件不同。

如果要在 default 配置文件之上启用 Grafana dashboard,用下面的命令设置

addonComponents.grafana.enabled 配置参数:

配置文件建立生产环境的良好

- $ istioctl manifest apply --set addonComponents.grafana.enabled=true

通常,您可以像使用 helm 一样在

中配置

标志。 唯一的区别是必须为配置路径增加

前缀,因为这是 Helm 透传 API 的路径,如下所述。

istioctl

–set

values.

从外部 Chart 安装

通常, istioctl 使用内置 Chart 生成安装清单。这些 Chart 与 一起发布,用于审核和自定义,

istioctl

它们 放置在 install/kubernetes/operator/charts 目录下。 除了使用内置 Chart 外, 还可以使用外

istioctl

部 Chart 生成安装清单。要选择外部 Chart ,请配置 参数(接收本地文件系统路径):

installPackagePath

$ istioctl manifest apply --set installPackagePath=< base directory where installed >/istio-releases/istio-

- 1.6.0/install/kubernetes/operator/charts

如果使用

1. 二进制文件,该命令执行结果与通过

安装相同,因为它指

向的 Chart 与内置 Chart 相同。 除了试验或测试新特性之外,我们建议使用内置 Chart 而不是外部提供,以

istioctl

istioctl manifest apply

确保 二进制文件与 Chart 的兼容性。

istioctl

安装其他配置文件

可以通过在命令行上设置配置文件名称安装其他 Istio 配置文件到群集中。 例如,可以使用以下命令,安装配置文件:

demo

- $ istioctl manifest apply --set profile=demo

显示可用配置文件的列表

您可以使用以下 命令来列出 Istio 配置文件名称:

istioctl

- $ istioctl profile list

- Istio configuration profiles:

- remote

- separate

- default

- demo

- empty

- minimal

显示配置文件的配置

您可以查看配置文件的配置设置。例如,通过以下命令查看 配置文件的设置:

default

-

$ istioctl profile dump demo

-

addonComponents:

-

grafana:

-

enabled: true

-

kiali:

-

enabled: true

-

prometheus:

-

enabled: true

-

tracing:

-

enabled: true

-

components:

-

egressGateways:

-

- enabled: true

-

k8s:

-

resources:

-

requests:

-

cpu: 10m

-

memory: 40Mi

-

name: istio-egressgateway

-

…

要查看整个配置的子集,可以使用 标志,该标志仅选择部分给定路径下的配置:

–config-path

-

$ istioctl profile dump --config-path components.pilot demo

-

enabled: true

-

k8s:

-

env:

-

- name: POD_NAME

-

valueFrom:

-

fieldRef:

-

apiVersion: v1

-

fieldPath: metadata.name

-

- name: POD_NAMESPACE

-

valueFrom:

-

fieldRef:

-

apiVersion: v1

-

fieldPath: metadata.namespace

-

- name: GODEBUG

-

value: gctrace=1

-

- name: PILOT_TRACE_SAMPLING

-

value: “100”

-

- name: CONFIG_NAMESPACE

-

value: istio-config 21. …

显示配置文件中的差异

子命令可用于显示配置文件之间的差异,在将更改应用于集群之前,这对于检查自定义的效果很有

profile diff

用。

您可以使用以下命令显示 default 和 demo 配置文件之间的差异:

-

$ istioctl profile diff default demo

-

gateways:

-

egressGateways:

-

-

- enabled: false

-

-

-

- enabled: true 6. …

-

-

k8s:

-

requests: 9. - cpu: 100m

-

- memory: 128Mi

-

- cpu: 10m

-

- memory: 40Mi

-

strategy: 14. …

安装前生成清单

您可以在安装 Istio 之前使用

子命令生成清单,而不是

。 例如,使用以

下命令为 配置文件生成清单:

manifest generate

manifest apply

default

- $ istioctl manifest generate > $HOME/generated-manifest.yaml

根据需要检查清单,然后使用以下命令应用清单:

- $ kubectl apply -f $HOME/generated-manifest.yaml

由于集群中的资源不可用,此命令可能显示暂时错误。

显示清单差异

您可以使用以下命令显示默认配置文件和自定义安装之间生成的清单中的差异:

-

$ istioctl manifest generate > 1.yaml

-

$ istioctl manifest generate -f samples/operator/pilot-k8s.yaml > 2.yaml

-

$ istioctl manifest diff 1.yam1 2.yaml

-

Differences of manifests are:

-

Object Deployment:istio-system:istio-pilot has diffs:

-

spec:

-

template:

-

spec:

-

containers:

-

‘[0]’:

-

resources:

-

requests:

-

cpu: 500m -> 1000m

-

memory: 2048Mi -> 4096Mi

-

nodeSelector: -> map[master:true]

-

tolerations: -> [map[effect:NoSchedule key:dedicated operator:Exists] map[key:CriticalAddonsOnly

-

operator:Exists]] 20.

-

Object HorizontalPodAutoscaler:istio-system:istio-pilot has diffs: 23.

-

spec:

-

maxReplicas: 5 -> 10

-

minReplicas: 1 -> 2

验证安装成功

您可以使用 命令检查 Istio 安装是否成功,它将集群上的安装与您指定的清单进行比较。

verify-install

如果未在部署之前生成清单,请运行以下命令以现在生成它:

- $ istioctl manifest generate > $HOME/generated-manifest.yaml

然后运行以下 命令以查看安装是否成功:

verify-install

- $ istioctl verify-install -f $HOME/generated-manifest.yaml

定制配置

除了安装 Istio 的任何内置组件配置文件, 提供了用于自定义配置的完整 API。

istioctl manifest

The API

IstioOperator

可以使用命令上的

选项分别设置此 API 中的配置参数。例如,要在

配置文件之上启用控制

面安全特性,请使用以下命令:

–set

default

- $ istioctl manifest apply --set values.global.controlPlaneSecurityEnabled=true

或者,可以在 YAML 文件中指定

IstioOperator

配置,并使用

选项将其传给 :

- $ istioctl manifest apply -f samples/operator/pilot-k8s.yaml

为了向后兼容,还完全支持 Helm 安装。 若要在命令行中设置它们,请在选项名称前面加上 “ “。 如下

-f

istioctl

values.

所示,下面命令就重写了 Helm 的 配置选项:

pilot.traceSampling

- $ istioctl manifest apply --set values.pilot.traceSampling=0.1

如 Customize Istio settings using the Helm API 所述,Helm 值也可以在置。

IstioOperator

定义中设

标识 Istio 功能或组件

API 定义的 components 如下表所示:

IstioOperator

| Components |

|---|

| base |

| pilot |

| proxy |

| sidecarInjector |

| telemetry |

| policy |

| citadel |

| nodeagent |

| galley |

|---|

| ingressGateways |

| egressGateways |

| cni |

除了核心的 Istio 组件之外,还提供了第三方附加功能和组件。它们可以通过配置

IstioOperator

spec,或者使用 Helm 透传 API 来启动。

addonComponents

API 的

-

apiVersion: install.istio.io/v1alpha1

-

kind: IstioOperator

-

spec:

-

addonComponents:

-

grafana:

-

enabled: true

-

apiVersion: install.istio.io/v1alpha1

-

kind: IstioOperator

-

spec:

-

values:

-

grafana:

-

enabled: true

配置功能或组件设置

从上表中识别功能部件或组件的名称后,可以使用 API 设置值 使用 标志,或创建一个覆盖文件并使用

–set

–filename

–set

置更改。

标志。

标志自定义一些参数的效果很好。 覆盖文件旨在进行更广泛的自定义,或者跟踪配

最简单的自定义是从配置配置文件默认值打开或关闭功能或组件。要在默认配置配置文件中禁用遥测功能,请使用以下命令:

- $ istioctl manifest apply --set components.telemetry.enabled=false

或者,您可以使用配置覆盖文件禁用遥测功能:

1. 创建一个文件 文件并且写入以下内容:

telemetry_off.yaml

-

apiVersion: install.istio.io/v1alpha1

-

kind: IstioOperator

-

spec:

-

components:

-

telemetry:

-

enabled: false

-

将

telemetry_off.yaml

manifest apply

覆盖文件与

命令一起使用: -

$ istioctl manifest apply -f telemetry_off.yaml

另一个定制是为功能部件和组件选择不同的命名空间。 以下是一个定制命名空间的例子:

- apiVersion: install.istio.io/v1alpha1

- kind: IstioOperator

- metadata:

- namespace: istio-system

- spec:

- components:

- citadel:

- namespace: istio-citadel

安装此文件将应用默认配置文件,并将组件安装到以下命名空间中:

Citadel 组件 将被安装到 命名空间

istio-citadel

剩余的 Istio 组件安装到 istio-system 命名空间

自定义 Kubernetes 设置

API 允许以一致的方式自定义每个组件的 Kubernetes 设置。

IstioOperator

每一个组件都有一个允许修改配置的 ,使用此列表来标识要自定义的设置:

KubernetesResourceSpec

- Resources

- Readiness probes

- Replica count 4.

HorizontalPodAutoscaler

PodDisruptionBudget

5.

- Pod annotations

- Service annotations 8.

ImagePullPolicy

- Priority class name

- Node selector

- Affinity and anti-affinity

- Service

- Toleration

- Strategy

- Env

所有这些 Kubernetes 设置都使用 Kubernetes API 定义,因此 Kubernetes 文档可以用作参考。以下示例覆盖文件调整了 Pilot 的 resource 和 pod 水平自动伸缩的设置:

-

apiVersion: install.istio.io/v1alpha1

-

kind: IstioOperator

-

spec:

-

components:

pilot: k8s:

resources: requests:

cpu: 1000m # override from default 500m memory: 4096Mi # … default 2048Mi

hpaSpec:

maxReplicas: 10 # … default 5

minReplicas: 2 # … default 1 nodeSelector:

master: “true” tolerations:

- key: dedicated operator: Exists effect: NoSchedule

- key: CriticalAddonsOnly

operator: Exists

使用 将修改后的设置应用于集群:

manifest apply

- $ istioctl manifest apply -f samples/operator/pilot-k8s.yaml

使用 Helm API 自定义 Istio 设置

API 使用 字段直接调用 Helm API 的接口对字段进行设值。

IstioOperator

values

下面的 YAML 文件可以通过 Helm API 配置全局和 Pilot 配置:

- apiVersion: install.istio.io/v1alpha1

- kind: IstioOperator

- spec:

- values:

- pilot:

- traceSampling: 0.1 # override from 1.0

- global:

- monitoringPort: 15050

一些参数将在 Helm 和 IstioOperator API 中暂时存在,包括 Kubernetes 资源, 命名空间和启用设置。

Istio 社区建议使用 IstioOperator API,因为它更专一,经过验证并遵循社区毕业流程。

卸载 Istio

可以使用以下命令来卸载 Istio:

- $ istioctl manifest generate | kubectl delete -f -

相关内容

使用 Istioctl Analyze 诊断配置

演示如何使用 istioctl analyze 来识别配置中的潜在问题。通过 Istioctl Describe 理解您的网格

向您展示如何使用 istioctl describe 来验证您的网格中的 pod 的配置。

DNS 证书管理

在 Istio 中配置和管理 DNS 证书。

Istio Operator 简介

关于 Istio 基于 operator 的安装和控制平面管理特性的介绍。

istioctl analyze 介绍

通过分析 Istio 配置来发现潜在问题和一般问题。安全管理 Webhook

一种更安全管理 Istio webhook 的方法。

使用 Helm 自定义安装

Helm 的安装方法已被弃用。 请改用使用 istioctl 安装。

请按照本指南安装和配置 Istio 网格,以进行深入评估或用于生产。

这种安装方式使用 Helm charts 自定义 Istio 控制平面和 Istio 数据平面的 sidecar。 你只需使用

helm

kubectl apply