nfs介绍与配置

NFS

1. nfs简介

nfs特点

- NFS(Network File System)即网络文件系统,是FreeBSD支持的文件系统中的一种,它允许网络中的计算机之间通过TCP/IP网络共享资源

- 在NFS的应用中,本地NFS的客户端应用可以透明地读写位于远端NFS服务器上的文件,就像访问本地文件一样

- nfs适用于Linux与Unix之间实现文件共享,不能实现Linux与Windows间的文件共享功能

- nfs是运行在应用层的协议,其监听于2049/tcp和2049/udp套接字上

- nfs服务只能基于IP进行认证

nfs的应用场景

nfs有很多实际应用场景,以下是一些常用的场景:

- 多个机器共享一台CDROM或其他设备。这对于在多台机器中安装软件来说更加便宜与方便

- 在大型网络中,配置一台中心NFS服务器用来放置所有用户的home目录可能会带来便利。这些目录能被输出到网络以便用户不管在哪台工作站上登录,总能得到相同的home目录

- 不同客户端可在NFS上观看影视文件,节省本地空间

- 在客户端完成的工作数据,可以备份保存到NFS服务器上用户自己的路径下

nfs的体系组成

nfs体系至少有两个主要部分:

- 一台nfs服务器

- 若干台客户机

客户机通过TCP/IP网络远程访问存放在NFS服务器上的数据

在NFS服务器正式启用前,需要根据实际环境和需求,配置一些NFS参数

2. nfs工作机制

nfs是基于rpc来实现网络文件系统共享的。

RPC

RPC(Remote Procedure Call Protocol),远程过程调用协议,它是一种通过网络从远程计算机程序上请求服务,而不需要了解底层网络技术的协议。

RPC协议假定某些传输协议的存在,如TCP或UDP,为通信程序之间携带信息数据。在OSI网络通信模型中,RPC跨越了传输层和应用层。

RPC采用客户机/服务器模式。请求程序就是一个客户机,而服务提供程序就是一个服务器。

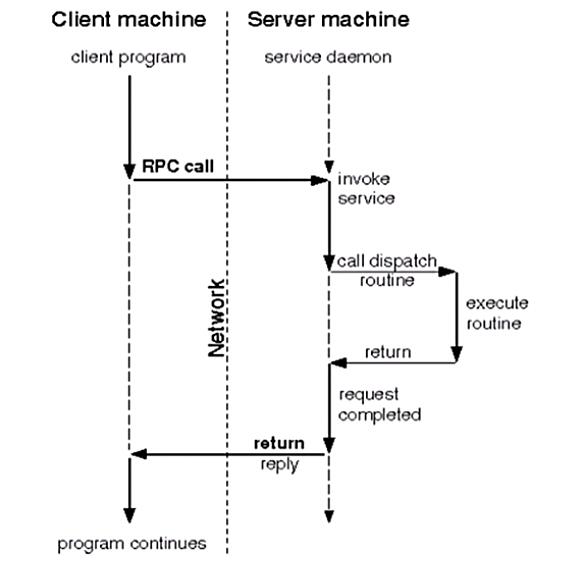

rpc工作机制如上图所示,下面来描述一下它:

- 客户端程序发起一个RPC系统调用基于TCP协议发送给另一台主机(服务端)

- 服务端监听在某个套接字上,当收到客户端的系统调用请求以后,将收到的请求和其所传递的参数通过本地的系统调用执行一遍,并将结果返回给本地的服务进程

- 服务端的服务进程收到返回的执行结果后将其封装成响应报文,再通过rpc协议返回给客户端

- 客户端调用进程接收答复信息,获得进程结果,然后调用执行继续进行

nfs工作机制

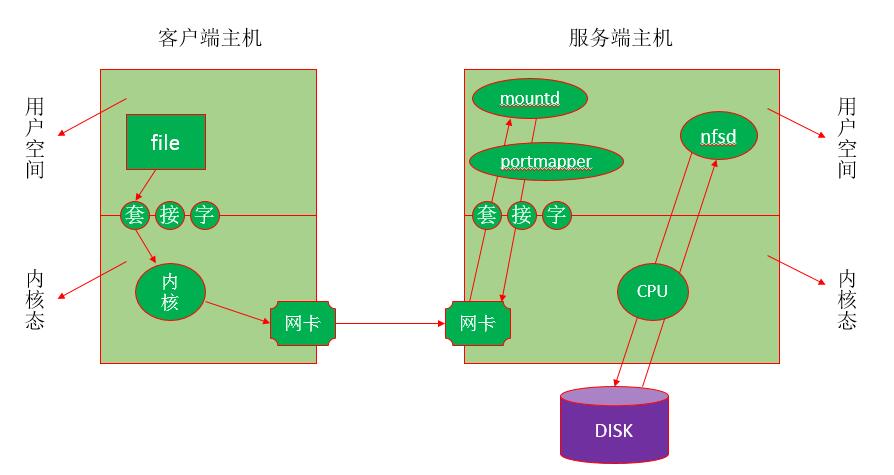

NFS服务器端运行着四个进程:

nfsd

mountd

idmapd

portmapper

idmapd //实现用户帐号的集中映射,把所有的帐号都映射为NFSNOBODY,但是在访问时却能以本地用户的身份去访问

mountd //用于验证客户端是否在允许访问此NFS文件系统的客户端列表中,在则允许访问(发放一个令牌,持令牌去找nfsd),否则拒绝访问

//mountd的服务端口是随机的,由rpc服务(portmapper)提供随机端口号

nfsd //nfs的守护进程,监听在2049/tcp和2049/udp端口上

//不负责文件存储(由NFS服务器本地内核负责调度存储),用于理解客户端发起的rpc请求,并将其转交给本地内核,而后存储在指定的文件系统上

portmapper //NFS服务器的rpc服务,其监听于111/TCP和111/UDP套接字上,用于管理远程过程调用(RPC)

下面通过一个例子来说明NFS的简单工作流程:

需求:查看file文件的信息,此file存储在远程NFS服务端主机上(挂载在本地目录/shared/nfs中)

- 客户端发起查看file信息的指令(ls file)给内核,内核通过NFS模块得知此文件并不是本地文件系统中的文件,而是在远程NFS主机上的一个文件

- 客户端主机的内核通过RPC协议把查看file信息的指令(系统调用)封装成rpc请求通过TCP的111端口发送给NFS服务端主机的portmapper

- NFS服务端主机的portmapper(RPC服务进程)告诉客户端说NFS服务端的mountd服务在某某端口上,你去找它验证

因为mountd在提供服务时必须要向portmapper注册一个端口号,所以portmapper是知道其工作于哪个端口的

- 客户端得知服务端的mountd进程端口号后,通过已知的服务端mountd端口号请求验证

- mountd收到验证请求后验证发起请求的客户端是否在允许访问此NFS文件系统的客户端列表中,在则允许访问(发放一个令牌,持令牌去找nfsd),否则拒绝访问

- 验证通过后客户端持mountd发放的令牌去找服务端的nfsd进程,请求查看某文件

- 服务端的nfsd进程发起本地系统调用,向内核请求查看客户端要查看的文件的信息

- 服务端的内核执行nfsd请求的系统调用,并将结果返回给nfsd服务

- nfsd进程收到内核返回的结果后将其封装成rpc请求报文并通过tcp/ip协议返回给客户端

3. exports文件的格式

nfs的主配置文件是/etc/exports,在此文件中,可以定义NFS系统的输出目录(即共享目录)、访问权限和允许访问的主机等参数。该文件默认为空,没有配置输出任何共享目录,这是基于安全性的考虑,如此即使系统启动了NFS服务也不会输出任何共享资源。

exports文件中每一行提供了一个共享目录的设置,其命令格式为:

<输出目录> [客户端1(选项1,选项2,...)] [客户端2(选项1,选项2,...)]

其中,除输出目录是必选参数外,其他参数均是可选项。另外,格式中的输出目录和客户端之间、客户端与客户端之间都使用空格分隔,但客户端与选项之间不能有空格。

客户端是指网络中可以访问这个NFS共享目录的计算机。客户端的指定非常灵活,可为单个主机的IP或域名,亦可为某个子网或域中的主机等。

客户端常用的指定方式:

| 客户端 | 说明 |

|---|---|

| 192.168.159.130 | 指定IP地址的主机 |

| 192.168.159.0/24(或192.168.159.*) | 指定子网中的所有主机 |

| www.shuijiao.com | 指定域名的主机 |

| *.shuijiao.com | 指定shuijiao.com域中的所有主机 |

| *(或缺省) | 所有主机 |

选项用来设置共享目录的访问权限、用户映射等。exports文件中的选项比较多,一般可分为三类:

- 访问权限选项(用于控制共享目录的访问权限)

- 用户映射选项

- 默认情况下,当客户端访问NFS服务器时,若远程访问的用户是root用户,则NFS服务器会将其映射成一个本地的匿名用户(该用户为nfsnobody),并将其所属的用户组也映射成匿名用户组(该用户组也为nfsnobody),如此有助于提高系统的安全性。

- 其他选项

访问权限选项:

| 访问权限选项 | 说明 |

|---|---|

| ro | 设置输出目录只读 |

| rw | 设置输出目录可读写 |

用户映射选项:

| 用户映射选项 | 说明 |

|---|---|

| all_squash | 将远程访问的所有普通用户及所属组都映射为匿名用户或用户组(nfsnobody) |

| no_all_squash | 不将远程访问的所有普通用户及所属用户组都映射为匿名用户或用户组(默认设置) |

| root_squash | 将root用户及所属用户组都映射为匿名用户或用户组(默认设置) |

| no_root_squash | 不将root用户及所属用户组都映射为匿名用户或用户组 |

| anonuid=xxx | 将远程访问的所有用户都映射为匿名用户,并指定该匿名用户为本地用户帐户(UID=xxx) |

| anongid=xxx | 将远程访问的所有用户组都映射为匿名用户组,并指定该匿名用户组为本地用户组(GID=xxx) |

常用的其他选项:

| 其他选项 | 说明 |

|---|---|

| secure | 限制客户端只能从小于1024的TCP/IP端口连接NFS服务器(默认设置) |

| insecure | 允许客户端从大于1024的TCP/IP端口连接NFS服务器 |

| sync | 将数据同步写入内存缓冲区或磁盘中,效率较低,但可保证数据一致性 |

| async | 将数据先保存在内存缓冲区中,必要时才写入磁盘 |

| wdelay | 检查是否有相关的写操作,如果有则这些写操作一起执行,可提高效率(默认设置) |

| no_wdelay | 若有写操作则立即执行,应与sync配置使用 |

| subtree_check | 若输出目录是一个子目录,则NFS服务器将检查其父目录的权限(默认设置) |

| no_subtree_check | 即使输出目录是一个子目录,NFS服务亦不检查其父目录的权限,可提高效率 |

| nohide | 若将一个目录挂载到另一个目录之上,则原来的目录通常就被隐藏起来或看起来像空的一样。要禁用这种行为,需启用hide选项 |

4. nfs管理

nfs安装:

准备两台虚拟机

服务的和客户端都需要关闭防火墙并且安装nfs-utils

服务端:

[root@localhost ~]# hostnamectl set-hostname server

[root@localhost ~]# bash

[root@server ~]# systemctl disable --now firewalld

Removed "/etc/systemd/system/multi-user.target.wants/firewalld.service".

Removed "/etc/systemd/system/dbus-org.fedoraproject.FirewallD1.service".

[root@server ~]# vi /etc/selinux/config

[root@server ~]# setenforce 0

[root@server ~]# yum -y install nfs-utils

客户端:

[root@localhost ~]# hostnamectl set-hostname client

[root@localhost ~]# bash

[root@client ~]# systemctl disable --now firewalld

Removed /etc/systemd/system/multi-user.target.wants/firewalld.service.

Removed /etc/systemd/system/dbus-org.fedoraproject.FirewallD1.service.

[root@client ~]# vi /etc/selinux/config

[root@client ~]# setenforce 0

[root@client ~]# yum -y install nfs-utils

服务端上应启动服务,客户端不需要启动

[root@server ~]# systemctl status nfs-server

○ nfs-server.service - NFS server and services

Loaded: loaded (/usr/lib/systemd/system/nfs-server.service; disabled; preset: disable>

Active: inactive (dead)

[root@server ~]# systemctl enable --now nfs-server

Created symlink /etc/systemd/system/multi-user.target.wants/nfs-server.service → /usr/lib/systemd/system/nfs-server.service.

[root@server ~]# systemctl status nfs-server

● nfs-server.service - NFS server and services

Loaded: loaded (/usr/lib/systemd/system/nfs-server.service; enabled; preset: disabled)

Active: active (exited) since Tue 2023-12-12 15:04:09 CST; 15s ago

Process: 15135 ExecStartPre=/usr/sbin/exportfs -r (code=exited, status=0/SUCCESS)

Process: 15136 ExecStart=/usr/sbin/rpc.nfsd (code=exited, status=0/SUCCESS)

Process: 15157 ExecStart=/bin/sh -c if systemctl -q is-active gssproxy; then systemctl>

Main PID: 15157 (code=exited, status=0/SUCCESS)

CPU: 23ms

Dec 12 15:04:09 server systemd[1]: Starting NFS server and services...

Dec 12 15:04:09 server systemd[1]: Finished NFS server and services.

使用shoumount命令测试NFS服务器的输出目录状态:

语法:showmount [选项] [NFS服务器名称或地址]

常用的选项有:

-a //显示指定NFS服务器的所有客户端主机及其所连接的目录

-d //显示指定的NFS服务器中已被客户端连接的所有输出目录

-e //显示指定的NFS服务器上所有输出的共享目录

[root@client ~]# yum provides showmount

查看我服务端上有没有可以挂载的资源

[root@client ~]# showmount -e 192.168.159.141

Export list for 192.168.159.141:

在客户端添加内容

[root@server ~]# cat /etc/exports

[root@server ~]# vi /etc/exports

[root@server ~]# cat /etc/exports

/data

配置文件发生了修改必须重启服务

[root@server ~]# systemctl restart nfs-server

再去服务端查看

[root@client ~]# showmount -e 192.168.159.141

Export list for 192.168.159.141:

/data *

在客户端创建目录

[root@server ~]# mkdir /data

在服务端挂载

[root@client ~]# mount -t nfs 192.168.159.141:/data /mnt

[root@client ~]# df -h

Filesystem Size Used Avail Use% Mounted on

devtmpfs 883M 0 883M 0% /dev

tmpfs 901M 0 901M 0% /dev/shm

tmpfs 901M 17M 884M 2% /run

tmpfs 901M 0 901M 0% /sys/fs/cgroup

/dev/mapper/rhel-root 17G 1.5G 16G 9% /

/dev/sda1 1014M 179M 836M 18% /boot

tmpfs 181M 0 181M 0% /run/user/0

192.168.159.141:/data 17G 1.3G 16G 8% /mnt

进入mnt目录创建文件发现没有权限

[root@client ~]# cd /mnt

[root@client mnt]# ls

[root@client mnt]# touch 123

touch: cannot touch '123': Read-only file system

再去客户端修改配置文件加上读写权限

[root@server ~]# cat /etc/exports

/data

[root@server ~]# vi /etc/exports

[root@server ~]# cat /etc/exports

/data 192.168.159.130(rw)

[root@server ~]# systemctl restart nfs-server

因为nobody没有读写权限所以要加上

[root@server ~]# setfacl -m u:nobody:rwx /data

再去服务端创建文件发现可以创建

[root@client mnt]# touch 123

[root@client mnt]# ll

total 0

-rw-r--r--. 1 nobody nobody 0 Dec 12 02:25 123

客户端上同样也可以看到

[root@server ~]# ll /data

total 0

-rw-r--r--. 1 nobody nobody 0 Dec 12 15:25 123

在服务端设置开机自动挂载nfs:编辑/etc/fstab文件,添加如下格式的内容

SERVER:/PATH/TO/EXPORTED_FS /mnt_point nfs defaults,_netdev 0 0

[root@client ~]# umount /mnt

[root@client ~]# df -h

Filesystem Size Used Avail Use% Mounted on

devtmpfs 883M 0 883M 0% /dev

tmpfs 901M 0 901M 0% /dev/shm

tmpfs 901M 17M 884M 2% /run

tmpfs 901M 0 901M 0% /sys/fs/cgroup

/dev/mapper/rhel-root 17G 1.5G 16G 9% /

/dev/sda1 1014M 179M 836M 18% /boot

tmpfs 181M 0 181M 0% /run/user/0

[root@client ~]# vi /etc/fstab

[root@client ~]# cat /etc/fstab

#

# /etc/fstab

# Created by anaconda on Sun Aug 6 23:24:20 2023

#

# Accessible filesystems, by reference, are maintained under '/dev/disk/'.

# See man pages fstab(5), findfs(8), mount(8) and/or blkid(8) for more info.

#

# After editing this file, run 'systemctl daemon-reload' to update systemd

# units generated from this file.

#

/dev/mapper/rhel-root / xfs defaults 0 0

UUID=f1d4acd1-8138-4c3b-83bf-0b6f137bd39b /boot xfs defaults 0 0

/dev/mapper/rhel-swap swap swap defaults 0 0

192.168.159.141:/data /nfs nfs defaults,_netdev 0 0

在客户端创建

[root@client ~]# cd /nfs/

[root@client nfs]# ls

123

[root@client nfs]# cat 123

[root@client nfs]# echo '666666' > 123

[root@client nfs]# cat 123

666666

发现在服务端可以查看到

[root@server ~]# cd /data/

[root@server data]# ls

123

[root@server data]# cat 123

666666

客户端挂载时可以使用的特殊选项:

- rsize:其值是从服务器读取的字节数(缓冲)。默认为1024。若使用比较高的值,如8192,可以提高传输速度

- wsize:其值是写入到服务器的字节数(缓冲)。默认为1024。若使用比较高的值,如8192,可以提高传输速度

exportfs //维护exports文件导出的文件系统表的专用工具

-a //输出在/etc/exports文件中所设置的所有目录

-r //重新读取/etc/exports文件中的设置,并使其立即生效,无需重启服务

-u //停止输出某一目录

-v //在输出目录时将目录显示到屏幕上

检查输出目录所使用的选项:

在配置文件/etc/exports中,即使在命令行中只设置了一两个选项,但在真正输出目录时,实际上还带有很多默认的选项。通过查看/var/lib/nfs/etab文件,可以看到具体使用了何选项

[root@server data]# cat /var/lib/nfs/etab

/data 192.168.159.130(rw,sync,wdelay,hide,nocrossmnt,secure,root_squash,no_all_squash,no_subtree_check,secure_locks,acl,no_pnfs,anonuid=65534,anongid=65534,sec=sys,rw,secure,root_squash,no_all_squash)