spark通过connector的方式读写starrocks

1,添加maven依赖

<!--starrocks的包-->

<dependency>

<groupId>com.starrocks.connector</groupId>

<artifactId>spark</artifactId>

<version>1.0.0</version>

<scope>system</scope>

<systemPath>${project.basedir}/src/main/resources/starrocks-spark2_2.11-1.0.0.jar</systemPath>

</dependency>

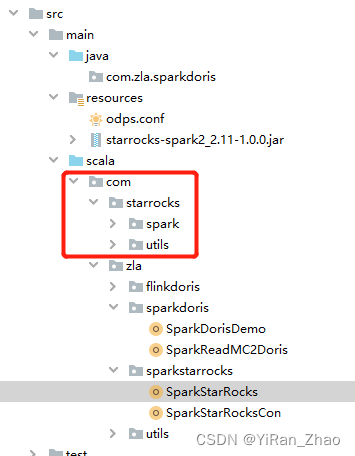

然后在resources下面加上这个包

上面的包可以在下面git里的resource里下载

参考官方github demo/SparkDemo/src/main/resources at master · StarRocks/demo · GitHub

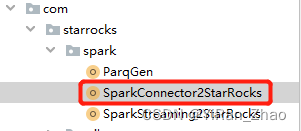

2,导入官方github里的sparkdemo下的文件到自己的目录下,如下

代码链接demo/SparkDemo/src/main/scala/com/starrocks at master · StarRocks/demo · GitHub

3,spark写数据到starrocks样例代码可以根据官方demo改

参考文档

GitHub - StarRocks/demo

spark/Flink 导入导出starrocks-阿里云开发者社区